Meta AI a présenté un LLM qui se rapproche de la technologie actuelle de l’IA en annonçant le modèle Llama 3 le 18 avril 2024. Bien que le modèle LLama 3 soit plus avancé que son prédécesseur, le modèle LLama 2, il est globalement un concurrent des grands modèles de langage de niveau intermédiaire tels que GPT-3.5 et Claude 3 Sonnet. Le modèle LLama 3 de Meta AI promet un meilleur raisonnement, des données plus entraînées et une meilleure compréhension du langage par rapport à son prédécesseur. Si vous vous posez des questions sur le modèle Llama 3, vous êtes au bon endroit !

Dans cet article, nous allons explorer ensemble le modèle Llama 3 et ses fonctionnalités.

Si tu es prêt, commençons !

TL ; DR

- Le modèle Llama 3 est un grand modèle de langage développé par Meta AI et annoncé le 18 avril 2024.

- Llama 3 est disponible en deux tailles de modèle adaptées à différents cas d’utilisation : 8B et 70B.

- Vous pouvez visiter le site officiel de Meta AI pour accéder au modèle Llama 3, mais Llama 3 n’est actuellement pas disponible dans tous les pays.

- Si vous souhaitez accéder au modèle Llama 3 dans le monde entier, ZenoChat par TextCortex est votre sauveur.

- Le modèle Llama 3 a réussi à surpasser ses rivaux, les modèles Gemini Pro 1.5 et Claude 3 Sonnet, dans les benchmarks.

- Le modèle Llama 3 est entraîné à l’aide de données de haute qualité spécialement filtrées et accessibles au public.

- Si vous êtes à la recherche d’une meilleure IA conversationnelle que Llama 3, ZenoChat par TextCortex est conçu pour vous avec ses options de personnalisation et ses capacités de sortie de texte et d’image.

Examen de Llama 3 de Meta AI

Le modèle Llama 3 est un grand modèle de langage introduit par Meta AI le 18 avril 2024. Le modèle Llama 3 offre des fonctionnalités et des capacités de génération de sortie améliorées par rapport à son prédécesseur. Le modèle Llama 3 vise à offrir des performances de pointe dans un large éventail d’industries grâce à son raisonnement amélioré, à sa compréhension fine du langage et à ses nouvelles capacités.

Un autre objectif de Meta AI lors du développement du modèle Llama 3 est d’améliorer son utilité. Meta AI visait à améliorer l’efficacité du modèle Llama 3 en le faisant connaître à la communauté et aux développeurs d’IA pendant son développement. Les plans futurs de Meta AI pour le modèle Llama 3 comprennent le rendre multilingue et multimodal, l’augmentation de la fenêtre contextuelle et l’amélioration de ses performances.

Llama 3 tailles de modèles

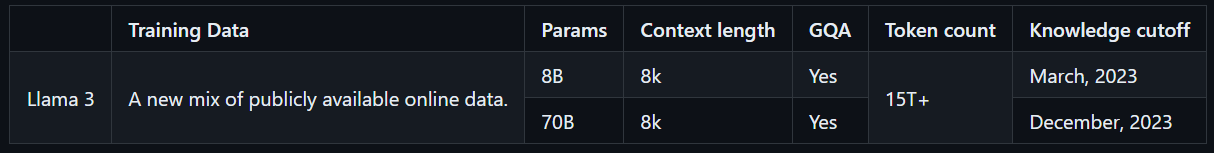

Llama 3 est disponible en deux tailles de modèle adaptées à différents cas d’utilisation : 8B et 70B. Le modèle Llama 3 8B est plus compact, avec un total de 8 milliards de paramètres, et peut générer des sorties plus rapidement. D’autre part, le modèle Llama 3 70B a un total de 70 milliards de paramètres et convient aux tâches complexes. De plus, le modèle Llama 3 8B est entraîné avec des données en ligne accessibles au public jusqu’en mars 2023, tandis que le modèle Llama 3 70B est entraîné avec des données en ligne accessibles au public jusqu’en décembre 2023.

Comment accéder à Llama 3 ?

Pour accéder au modèle Llama 3, vous pouvez visiter le site officiel de Meta AI, cliquer sur le bouton « Commencer » et suivre les étapes. Cependant, comme le modèle Llama 3 n’est pas accessible dans le monde entier, il a un faible score de disponibilité, contrairement aux autres LLM. Cependant, il existe des moyens de découvrir le modèle Llama 3 dans le monde entier.

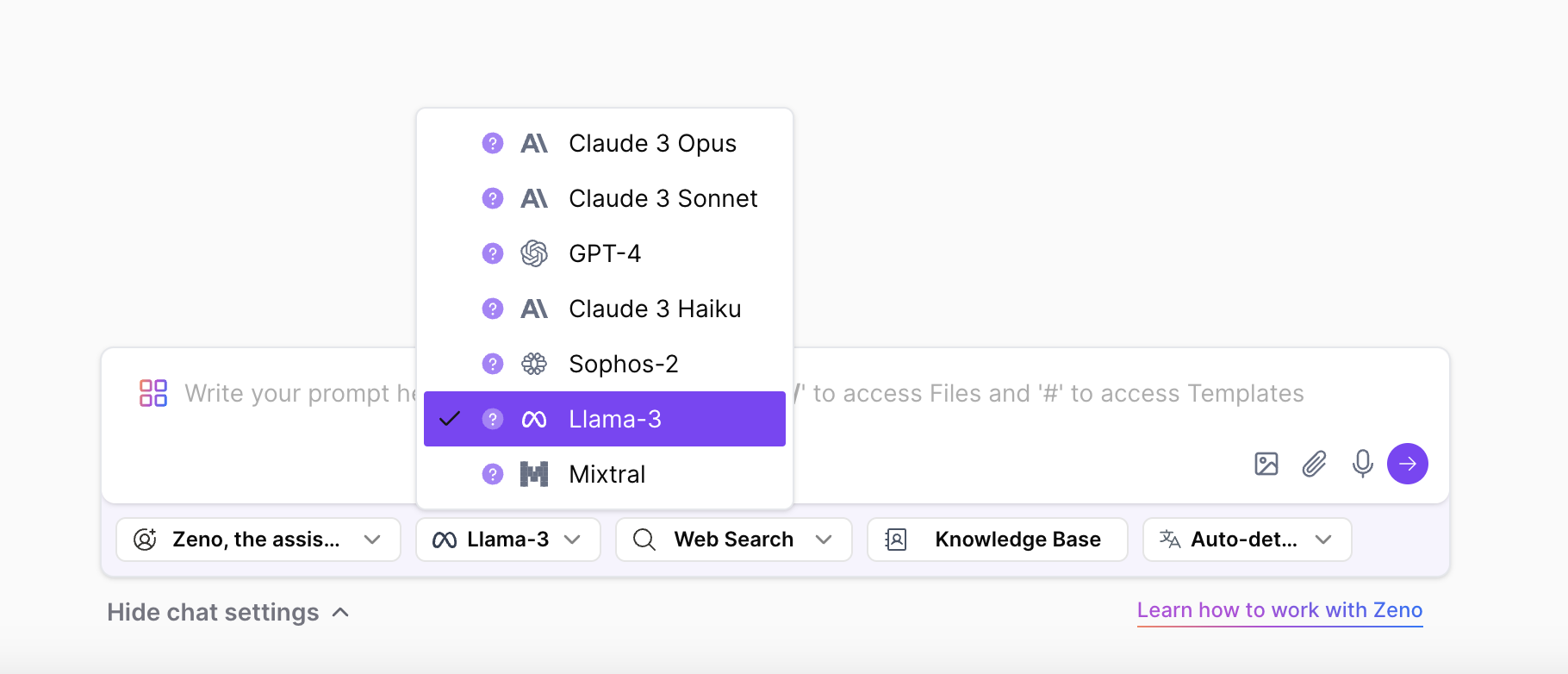

Avec ZenoChat par TextCortex, vous pouvez accéder et expérimenter les deux tailles du modèle Llama 3 sans aucune limite. ZenoChat prendra en charge les LLM Llama 3 8B et 70B en plus des LLM GPT-4, Sophos 2, Mixtral, Claude 3 Opus et Sonnet. Cela dit, vous pouvez librement faire l’expérience du modèle Llama 3 sans les restrictions de pays de Meta AI.

Caractéristiques principales de Llama 3 de Meta AI

Llama 3, le modèle le plus récent et le plus avancé de Meta AI, offre des performances supérieures et de nouvelles fonctionnalités que son prédécesseur. Le modèle Llama 3 a été introduit en tant que concurrent non pas des LLM haut de gamme tels que GPT-4 et Gemini Ultra, mais de modèles plus fréquemment utilisés tels que GPT-3.5 et Gemini Pro. Regardons de plus près les principales fonctionnalités de Llama 3.

Performances du modèle

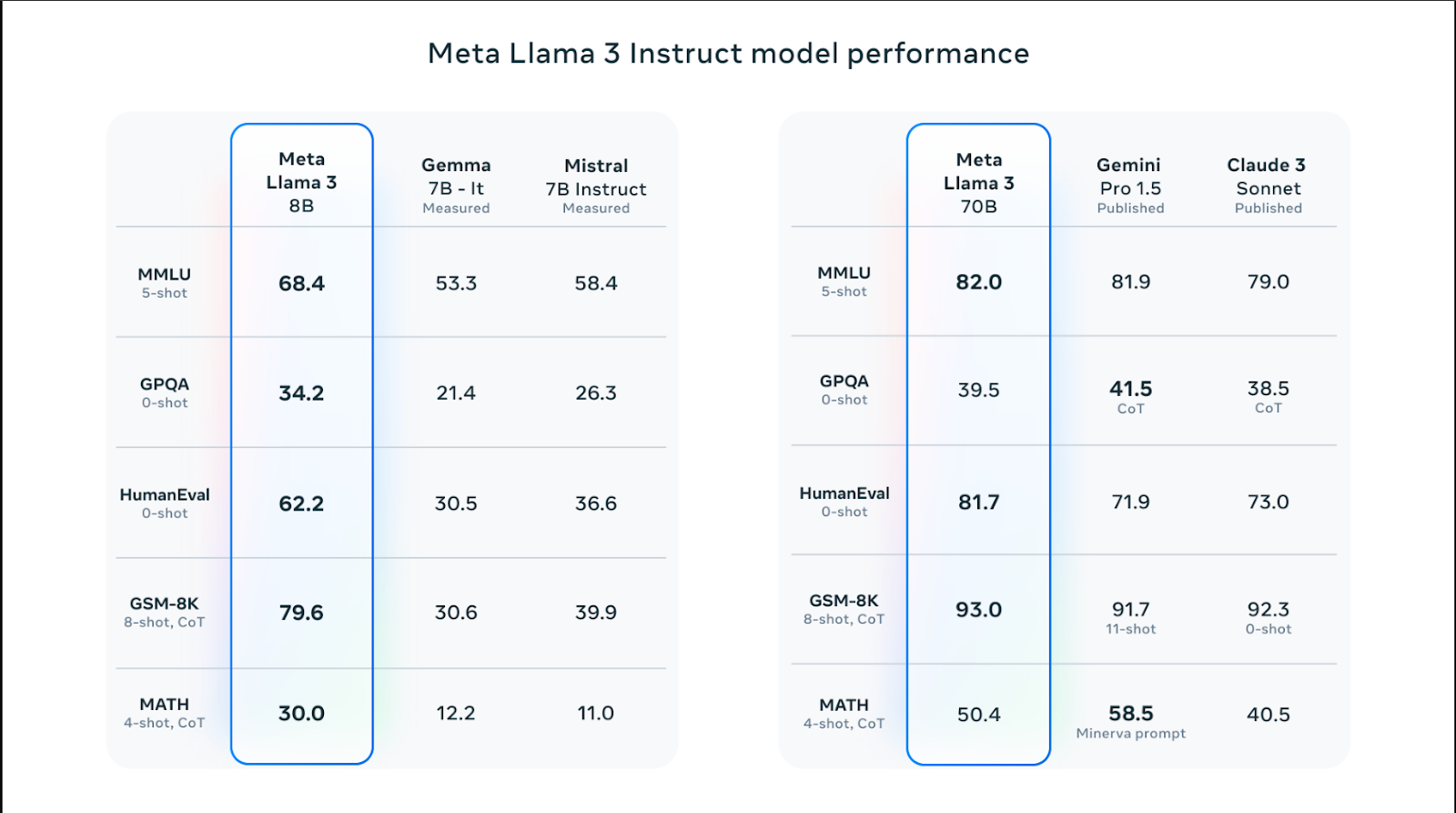

Les modèles Llama 3 sont disponibles en différentes tailles et ont de meilleures performances que les modèles Llama 2 dans des compétences telles que le raisonnement, la génération de code, les mathématiques et le suivi d’instructions. Parmi les modèles Llama 3, le modèle 70B a surpassé des modèles populaires comme Claude 3 Sonnet et Gemini Pro 1.5 en obtenant un score de 82,0 dans le benchmark MMLU. Cependant, les modèles Llama 3 obtiennent de meilleurs résultats que les modèles Claude 3 Sonnet et Gemini Pro 1.5 dans tous les benchmarks, à l’exception du benchmark MATH, qui mesure les compétences en mathématiques, et du GPQA, qui mesure les scores de questions-réponses au niveau des diplômés.

Le modèle Llama 3 8B a réussi à surpasser ses rivaux Gemma 7B et Mistral 7B dans les benchmarks Humaneval, MMLU, GPQA, GSM-8K et MATH. En d’autres termes, les tailles de modèle Llama 3 ont des performances supérieures à celles de ses modèles rivaux.

Données d’entraînement

Le modèle Llama 3 a été entraîné avec une grande quantité de données, ce qui est essentiel à la construction d’un grand modèle de langage haute performance. Plus précisément, il a été entraîné avec des jetons 15T provenant de sources accessibles au public, soit 7 fois plus que la quantité de données utilisée pour entraîner le modèle Llama 2.

De plus, le modèle Llama 3 a été entraîné avec un ensemble de données de haute qualité composé de 30 langues différentes autres que l’anglais. Cela s’est traduit par une augmentation significative de la compréhension du langage, de la créativité et des compétences de suivi rapide du modèle.

L’équipe Meta AI a développé une série de pipelines de filtrage de données pour entraîner le modèle Llama 3 avec des données fiables et de haute qualité. Ces filtres incluent des paramètres tels que le filtre NSFW, le filtre heuristique, l’approche de déduplication sémantique et le classificateur de texte. De plus, étant donné que le modèle Llama 2 est bon pour identifier des données de haute qualité, il a été utilisé pour filtrer les données entraînées du modèle Llama 3.

Optimisation

Les modèles Llama 3 sont spécialement optimisés pour les modèles et les marques de GPU et de CPU fréquemment utilisés. Plus le logiciel est optimisé pour un matériel spécifique, plus les performances sont élevées et plus il s’exécutera rapidement. Le modèle Llama 3 est optimisé pour le matériel Intel, AMD et Nvidia. De plus, Intel a publié un guide détaillé sur les performances du modèle Llama 3.

Sécurité

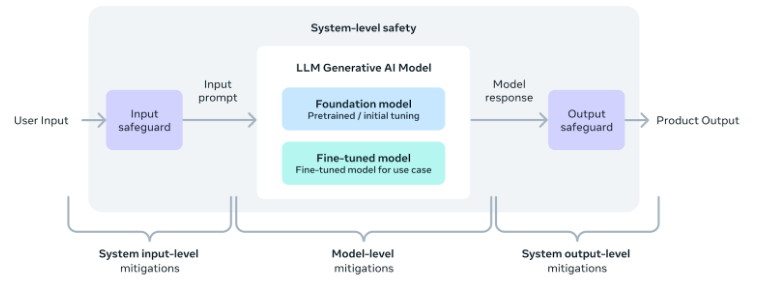

L’équipe d’IA de Meta reconnaît l’importance d’une utilisation sûre des outils et logiciels d’IA, y compris le modèle Llama 3. En conséquence, des paramètres de sécurité ont été ajoutés au cours du développement du modèle pour s’assurer que sa sortie est sûre, inoffensive et éthique.

En outre, l’équipe a également fourni un guide de mise en œuvre de la sécurité au niveau du système pour ceux qui souhaitent développer des applications utilisant le modèle Llama 3. Avec ces mesures en place, les utilisateurs peuvent profiter de la commodité et des avantages des outils d’IA tout en les utilisant de manière sûre et responsable.

Une meilleure alternative : ZenoChat par TextCortex

Si vous êtes à la recherche d’un assistant IA personnalisable avec accès à divers LLM, y compris le modèle Llama 3, ZenoChat by TextCortex est conçu pour vous. ZenoChat est un outil d’IA qui offre à ses utilisateurs les avantages de différents LLM et ne les limite pas à un seul LLM. ZenoChat a pour objectif d’aider ses utilisateurs dans des tâches professionnelles et quotidiennes telles que la génération de textes, la paraphrase et la recherche. Avec ZenoChat, vous pouvez multiplier par 12 n’importe quelle tâche, réduire votre charge de travail et faire monter en flèche votre productivité.

ZenoChat est disponible sous forme d’application web et de navigateurextension. Le navigateur ZenoChat extension est intégré à + de 30 000 sites Web et applications. Ainsi, il peut continuer à vous aider n’importe où et n’importe quand.

Travaillez avec vos propres connaissances et données

ZenoChat offre une expérience d’IA entièrement personnalisable grâce à nos fonctionnalités « Bases de connaissances » et « Personas individuels ». Notre fonction « Personas individuels » vous permet d’ajuster le style de sortie de ZenoChat, la longueur des phrases, l’émotion dominante dans les phrases et la personnalité comme vous le souhaitez. En d’autres termes, vous pouvez utiliser cette fonctionnalité pour transformer ZenoChat en votre assistant personnel ou votre jumeau numérique.

Notre fonctionnalité « Bases de connaissances » vous permet de télécharger ou de connecter des sources de données que ZenoChat utilisera pour générer des sorties. En utilisant cette fonctionnalité, vous pouvez entraîner ZenoChat avec vos propres données et l’adapter à des cas d’utilisation spécifiques. De plus, grâce à cette fonctionnalité, vous pouvez résumer des centaines de pages de documents avec une seule invite ou discuter avec vos PDF. Notre fonctionnalité « Bases de connaissances » dispose également d’un bouton qui vous permet d’intégrer votre Google Drive ou Microsoft OneDrive en quelques secondes.

%20(8).png)