Claude 3, le modèle de langage le plus récent et le plus avancé d'Anthropic, rivalise avec les modèles d'IA avancés et populaires sur le marché, tant en termes de performances que de capacités, et Llama 2 ne fait pas exception à la règle. Le modèle Claude 3 d'Anthropic a réussi à surpasser le modèle Llama 2, ainsi que d'autres LLM populaires et avancés.

Dans cet article, nous allons explorer les modèles Claude 3 et Llama 2 et les différences entre eux.

Tu es prêt ? Plongeons dans l'aventure !

TL ; DR

- Claude 3 est le modèle de grande langue le plus récent et le plus avancé développé par Anthropic et introduit le 4 mars 2024.

- Claude est livré avec 3 tailles différentes conçues pour 3 tâches différentes ; Haiku, Sonnet, et Opus.

- Pour accéder aux modèles Claude 3, tu peux utiliser le site officiel d'Anthropic ou te rendre sur TextCortex, qui l'associe à des fonctionnalités avancées.

- Llama 2 est un grand modèle linguistique développé par Meta AI qui se décline en trois tailles de modèles différentes : 7B, 13B et 70B.

- Bien que le modèle Claude 3 soit supérieur au modèle Llama 2 en termes de performance et de fenêtre contextuelle, Llama 2 est gratuit pour la recherche et l'utilisation commerciale.

- Si tu cherches une meilleure expérience d'IA conversationnelle que Claude 3 et Llama 2, ZenoChat par TextCortex est la voie à suivre.

Revue de Claude 3

Claude 3 est un modèle développé par Anthropic qui parvient à surpasser les grands modèles de langage les plus avancés. Avec Claude 3, tu peux générer des textes nouveaux et uniques ou des sorties basées sur des codes, faire l'expérience d'une conversation de type humain ou automatiser tes tâches banales répétitives.

Claude 3 tailles de modèles

Claude 3 Grand modèle de langue est livré avec trois tailles de modèle différentes conçues pour des tâches et des cas d'utilisation différents :

- Haiku : Haiku, le plus petit membre de la famille Claude 3, est conçu pour automatiser les tâches de base.

- Sonnet : Le modèle Sonnet, le milieu de la famille Claude 3, est conçu pour accomplir des tâches de niveau moyen et a des performances plus élevées que le modèle GPT-3.5.

- Opus : Le modèle Opus, le plus grand membre de la famille Claude 3, est conçu pour accomplir des tâches très complexes et est plus efficace que le GPT-4.

Prix de Claude 3

Alors que tu n'as pas besoin de payer de frais pour utiliser le modèle Claude 3 Sonnet, tu dois avoir un abonnement Claude Pro de 20 $ pour utiliser le modèle Claude 3 Opus en tant que chatbot IA. Si tu veux utiliser les modèles Claude 3 en tant que API, les prix sont les suivants :

- Claude 3 Haiku : 0,25 $ par million de jetons en entrée, 1,25 $ par million de jetons en sortie.

- Claude 3 Sonnet : 3 $ par million de jetons en entrée, 15 $ par million de jetons en sortie.

- Claude 3 Opus : 15 dollars par million de jetons, 75 dollars par million de jetons.

Comment accéder à Claude 3 ?

Pour accéder au modèle Claude 3, il te suffit de créer un compte Anthropic. Ensuite, tu peux commencer à expérimenter les modèles Claude 3 en te rendant sur l'interface web claude.ai.

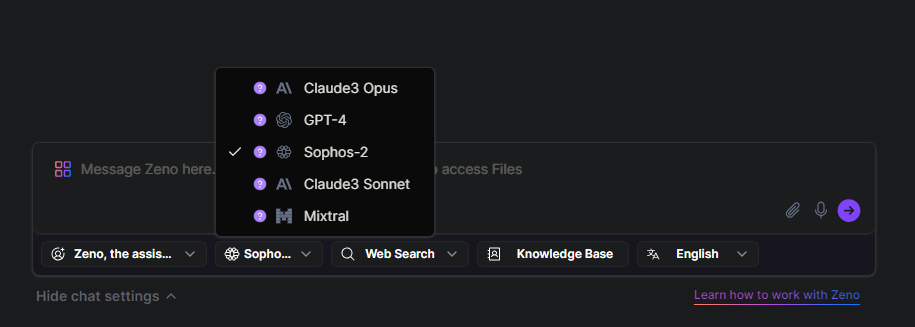

Une autre façon d'expérimenter les modèles Claude 3 est ZenoChat par TextCortex. Avec ZenoChat, tu peux expérimenter tous les modèles de Claude 3, y compris Opus, Sonnet et Haiku.

Qu'est-ce que le lama 2 ?

Llama 2 est l'un des grands modèles de langage populaires développés et introduits par Meta AI. Le modèle Llama 2 est conçu pour répondre aux sorties inoffensives et utiles en analysant les entrées des utilisateurs. En outre, le modèle Llama 2 est également un LLM utile pour les tâches de génération de code. De plus, Llama 2 est gratuit pour la recherche et l'utilisation commerciale.

Taille du modèle Llama 2

Le modèle Llama 2 se décline en trois modèles dont les paramètres sont de tailles différentes : 7B, 13B et 70B. Ces modèles ont été formés à l'aide de techniques telles que le traitement du langage naturel, l'apprentissage par renforcement à partir de commentaires humains, les modèles de récompense et l'apprentissage automatique. Bien que ces modèles puissent rivaliser avec le modèle GPT-3.5, les modèles Claude 3 sont plus performants.

Que peut générer le Llama 2 ?

Avec le modèle Llama 2, tu peux générer des sorties textuelles telles que des histoires, des poèmes, des articles, des messages sur blog , des essais et des courriels. De plus, tu peux l'utiliser pour réécrire tes textes existants ou les traduire dans une autre langue.

De plus, le modèle Llama 2 offre à ses utilisateurs la possibilité de générer des sorties dans des langages de codage. En utilisant Llama 2, tu peux générer des sorties pour n'importe quel langage de codage ou accomplir tes tâches d'ingénierie rapide.

Comment accéder à Llama 2 ?

Tu peux accéder au modèle Llama 2 et à ses 3 tailles différentes via le site officiel de Meta AI. De plus, tu peux télécharger ces modèles et les utiliser pour tes recherches ou à des fins commerciales.

Comparaison entre Claude 3 d'Anthropic et le lama 2 de Meta AI

Nous disposons maintenant d'informations de base sur le modèle Claude 3 d'Anthropic et le modèle Llama 2 de Meta AI. Ensuite, nous allons pouvoir comparer ces deux grands modèles de langage sous différents aspects et découvrir lequel est idéal pour toi !

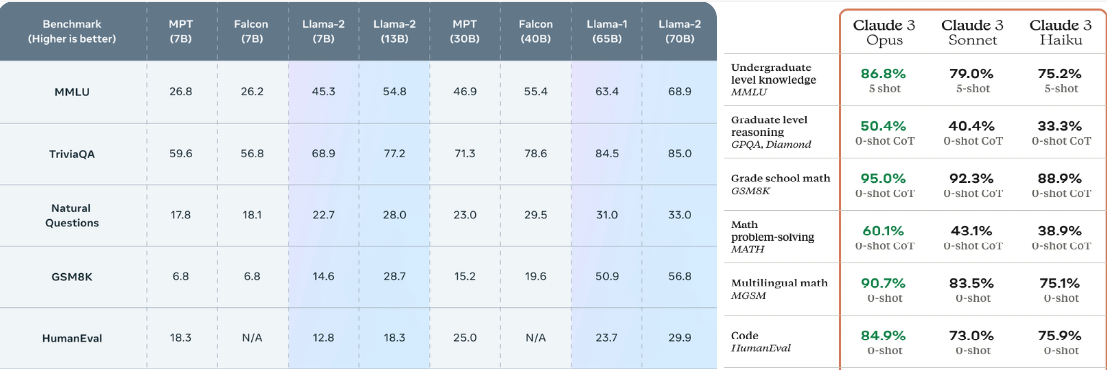

Différence de performance

Toutes les tailles du modèle Claude 3 obtiennent des scores plus élevés dans les tests de référence que le modèle Llama 2. Par exemple, alors que le 70B, qui est la taille la plus avancée du modèle Llama 2, a un score de 68,9 % dans le benchmark MMLU, Haiku, la plus petite taille du modèle Claude 3, a un score de 75,2 % dans le même benchmark. Nous pouvons constater la même différence de score dans d'autres tests de performance tels que GSM8K et HumanEval. En d'autres termes, le modèle Claude 3 surpasse le modèle Llama 2 en termes de performances.

Fenêtre contextuelle

Alors que les modèles Llama 2 offrent aux utilisateurs une fenêtre de contexte de 4096 jetons, les modèles Claude 3 offrent une fenêtre de contexte de 200K jetons. Dans cette comparaison, Anthropic offre une fenêtre de contexte plus grande que les modèles Llama 2, même avec le modèle Claude 2. Cependant, il élargit considérablement cette différence avec le modèle Claude 3. En d'autres termes, si tu as des tâches qui t'obligent à travailler avec de grandes quantités de données, Claude 3 est un meilleur choix.

Fixation des prix

Alors que tu dois payer une redevance pour utiliser le modèle Claude 3 en tant que API, tu peux utiliser et intégrer le modèle Llama 2 gratuitement. En revanche, tu peux chatter gratuitement via claude.ai avec le modèle Claude 3 Sonnet, qui offre des performances plus élevées que toutes les tailles du modèle Llama 2. Cependant, si tu veux discuter avec un chatbot IA en utilisant le modèle Claude 3 Opus, tu dois avoir un abonnement Claude Pro de 20 dollars.

Une meilleure alternative pour les deux : ZenoChat

Si tu cherches un assistant IA conversationnel qui offre plus de fonctionnalités et de capacités avancées que Claude 3 et Llama 2, ZenoChat est conçu pour toi. ZenoChat est une IA conversationnelle conçue pour aider les utilisateurs à accomplir leurs tâches quotidiennes et professionnelles, en réduisant leur charge de travail et en stimulant leur productivité. ZenoChat est disponible sous forme d'application web et de navigateur extension. Le navigateur ZenoChat extension est intégré à plus de 30 000 sites web et applis, il peut donc t'accompagner partout et à tout moment.

ZenoChat offre une expérience d'IA entièrement personnalisable grâce à nos fonctions "Individual Personas" et "Knowledge Bases". Notre fonction "Individual Personas" te permet d'ajuster le style de sortie de ZenoChat, le ton de la voix, la personnalité, l'attitude et l'émotion dominante dans ses réponses comme tu le souhaites. En d'autres termes, avec cette fonction, tu peux construire ZenoChat comme tu le souhaites.

Notre fonction "Bases de connaissances" te permet de télécharger ou de connecter les ensembles de données que ZenoChat utilisera lors de la production des résultats. Grâce à cette fonction, tu peux former ZenoChat à tes taxis spécifiques, discuter avec tes PDF ou résumer de grandes quantités de données à l'aide d'une seule invite.

%20(1).png)

%20(13).png)

%20(12).png)

%20(11).png)