Alors que l'IA continue de se développer à toute vitesse, Apple s'est lancé dans ce secteur et a découvert des approches différentes et nouvelles pour former un MLLM (Multimodal Large Language Model). Lors de la formation du modèle MM1, Apple a proposé une méthode plus efficace en personnalisant le processus de formation traditionnel du Multimodal Large Language Model. Cette méthode implique l'utilisation efficace de grandes quantités d'ensembles de données avec des paramètres et des hyperparamètres appropriés. Si tu te demandes comment fonctionne le modèle MM1, tu es au bon endroit !

Dans cet article, nous allons explorer ce qu'est le modèle MM1 et comment il fonctionne.

Tu es prêt ? Plongeons dans l'aventure !

TL ; DR

- Le MM1 d'Apple est un grand modèle linguistique multimodal développé avec une approche unique de pré-entraînement et de réglage fin.

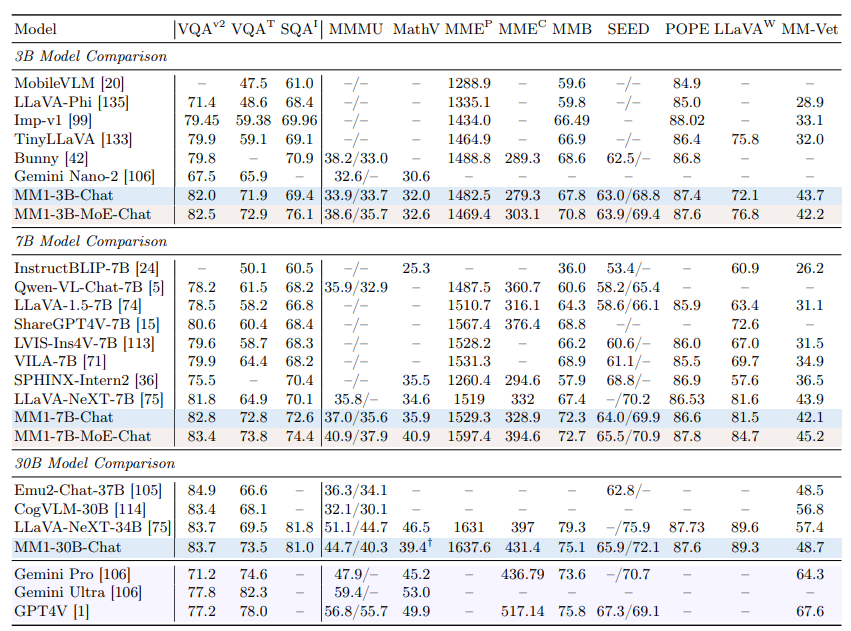

- Le modèle Apple MM1 a été publié avec trois tailles de paramètres différentes : 3B, 7B et 30B.

- Alors que le modèle Apple MM1 surpasse les modèles GPT-4 et Gemini Ultra dans certains points de référence, il est à la traîne avec une petite marge dans d'autres.

- Au cours de la formation du modèle Apple MM1, les encodeurs d'images, les connecteurs vision-langage et les phases de données formées ont été remaniés.

- Si tu as besoin d'un assistant IA pour te soutenir dans ta vie quotidienne et professionnelle, ne cherche pas plus loin que TextCortex.

- TextCortex vise à automatiser ta charge de travail et à stimuler ta productivité grâce à ses fonctionnalités uniques et à ses capacités d'IA avancées.

Qu'est-ce que Apple MM1 ?

Le modèle MM1 d'Apple est un modèle de langage large multimodal (MLLM) conçu pour accomplir des tâches basées sur l'image avec des performances élevées et une configuration minimale. Ce modèle a été développé avec une approche unique et nouvelle du processus de formation du MLLM. Cette approche vise une efficacité maximale avec un minimum de paramètres.

Taille des modèles MM1 d'Apple

Le modèle de langage large multimodal Apple MM1 a été mis à l'échelle en trois tailles différentes, chacune avec des quantités variables de paramètres : 3B, 7B et 30B. De plus, ces modèles ont été mis à l'échelle en utilisant une approche de mélange d'experts (MoE). Cette mise à l'échelle est le facteur crucial qui explique les performances inégalées de MM1 lors des étapes de pré-entraînement et de réglage fin.

MM1 est-il meilleur que ChatGPT ?

Grâce à ses performances élevées dans les phases de pré-entraînement et de réglage fin, le modèle Apple MM1 peut rivaliser avec des modèles tels que GPT-4V et Gemini Ultra et même les surpasser dans certains benchmarks. Par exemple, le modèle MM1 30B a réussi à surpasser à la fois le modèle GPT-4 Vision et le modèle Gemini Ultra dans le benchmark VQAv2. En ce qui concerne les autres tests de référence, il est possible de constater que le modèle MM1 a des performances légèrement inférieures à celles des modèles Gemini Ultra et GPT-4.

Comment puis-je accéder à MM1 ?

Étant donné qu'Apple n'a pas encore mis le modèle MM1 à la disposition du public, il ne nous est pas possible d'en faire l'expérience de quelque manière que ce soit. Cependant, le laboratoire de recherche d'Apple a déclaré que toutes les tailles de MM1 seront bientôt disponibles.

Comment fonctionne le MM1 d'Apple ?

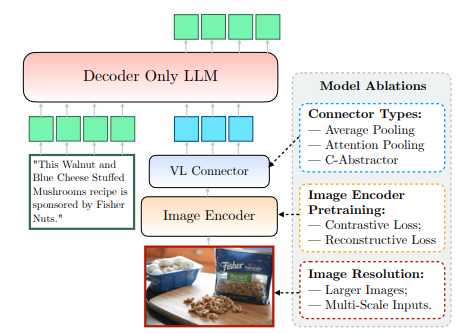

Le modèle MM1 d'Apple, qui n'est pas encore accessible au public, a été formé d'une manière nouvelle et unique, allant au-delà des méthodes traditionnelles. Selon le laboratoire de recherche d'Apple, pour former un modèle avec une efficacité maximale, il est nécessaire d'examiner la relation complexe entre la conception architecturale de MLLM et l'intégration de divers ensembles de données. Cette méthode vise à obtenir une efficacité maximale avec un minimum de paramètres. Nous pouvons clairement accéder à ces informations à partir du document partagé par Apple. Examinons de plus près le fonctionnement du MM1 d'Apple.

Encodeur d'images

Lors de l'entraînement du modèle MM1, le laboratoire de recherche d'Apple a découvert que la résolution de l'image avait le plus grand impact sur le processus d'entraînement. Le modèle MM1 a été entraîné avec des images ayant une résolution de 378x378 pixels. Ce processus de formation a été réalisé à l'aide des modèles d'apprentissage profond ViT-H (Vision Transformer - Huge) et CLIP (Contrastive Language-Image Pretraining). Alors que le modèle ViT-H est conçu par Google pour la classification d'images, CLIP est utile pour l'intégration d'images conçues par OpenAI.

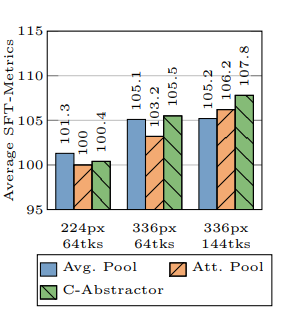

Connecteur vision-langage

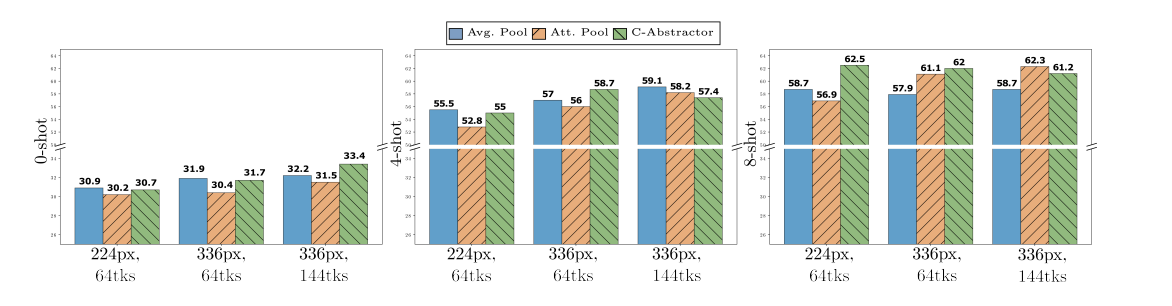

Selon le laboratoire de recherche d'Apple, lors du développement d'un MLLM, si tu veux qu'il soit très performant dans les tâches visuelles, la résolution d'une image et le nombre de jetons visuels sont essentiels pour faire passer le processus de formation au niveau supérieur. Le laboratoire de recherche d'Apple a utilisé un connecteur VL avec 144 jetons lors du développement du modèle MM1.

Sur quelles données Apple MM1 a-t-il été formé ?

Les données entraînées d'un modèle multimodal à langage étendu (MLLM) servent à la fois de mémoire et de connaissances pour générer des résultats. Par conséquent, plus les données formées d'un MLLM sont diversifiées et étendues, plus les résultats qu'il peut produire sont concis.

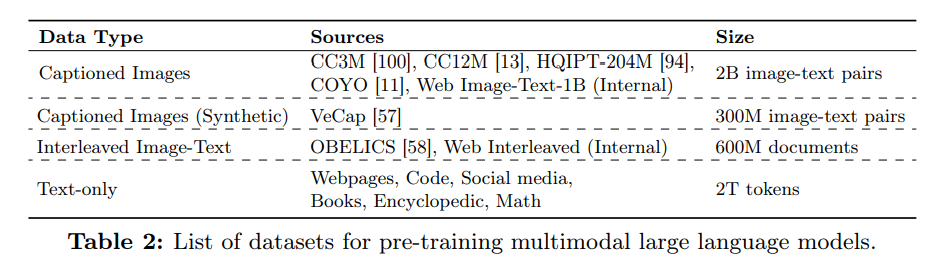

Le laboratoire de recherche d'Apple a utilisé une quantité importante de données composées de texte et d'images pour améliorer les performances du modèle MM1. Selon l'article d'Apple, le modèle MM1 est entraîné à l'aide d'une variété de données comprenant 45 % de documents image-texte entrelacés, 45 % de documents de paires image-texte et 10 % de documents texte seul.

%20(6).png)

%20(13).png)

%20(12).png)

%20(11).png)