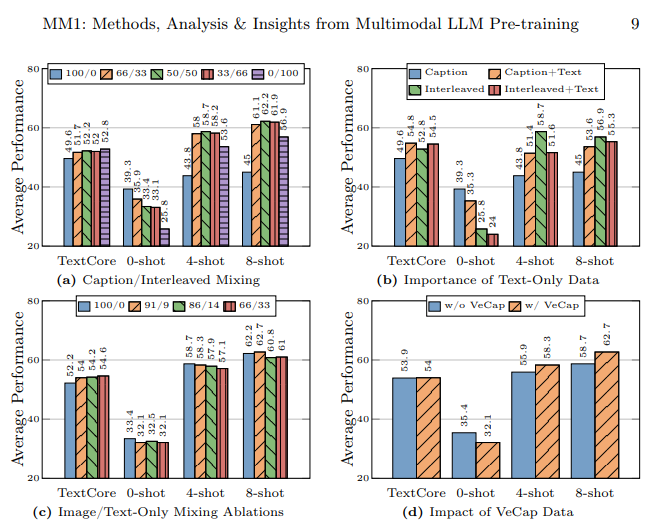

Alors que toutes les grandes entreprises telles que Google, Microsoft et Meta ont commencé à travailler dans le domaine de l'IA et produisent des modèles d'IA avancés les uns après les autres, Apple, qui est l'entreprise qui reste, a participé à cette course à l'IA avec son modèle de grand langage multimodal appelé MM1. Ce modèle a été entraîné avec des données textuelles et des données visuelles. Le modèle de langage multimodal MM1 a été entraîné avec un mélange d'images légendées (45 %), de documents image-texte entrelacés (45 %) et de données textuelles uniquement (10 %).

Dans cet article, nous allons découvrir ce qu'est le modèle de grand langage multimodal MM1 d'Apple.

Si tu es prêt, commençons !

TL ; DR

- MM1 est une famille de grands modèles linguistiques multimodaux développée et annoncée par Apple.

- Le modèle MM1 a été développé avec une méthode de formation et de construction différente, contrairement aux MLLM traditionnels.

- Lors de la construction du modèle MM1, l'architecture, les données entraînées, le codeur d'image, les paramètres, les hyperparamètres et la procédure d'entraînement ont été recréés pour être efficaces.

- Le modèle MM1 a un nombre de paramètres et une taille inférieurs à ceux de ses concurrents, ce qui lui permet de fonctionner sans problème sur les appareils mobiles.

- Si tu cherches un assistant IA qui sera toujours avec toi, comme les appareils mobiles, TextCortex est la voie à suivre, avec son intégration de plus de 30 000 sites Web et applis.

- TextCortex offre une variété de solutions d'IA personnalisables et interactives, de l'écriture à tes tâches professionnelles.

Qu'est-ce que Apple MM1 ?

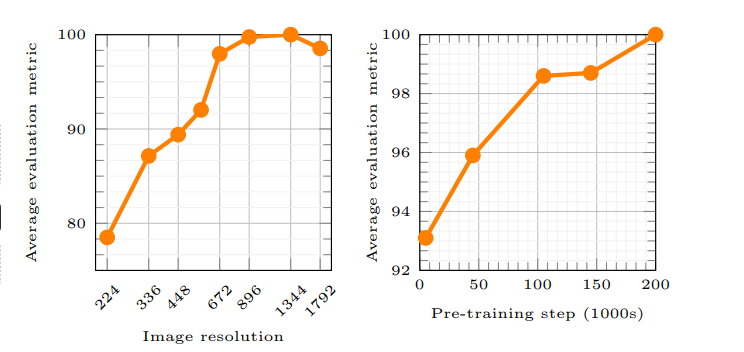

Le MM1 d'Apple est une famille de modèles de grands langages multimodaux (MLLM) qui peut gérer et générer à la fois des processus textuels et visuels. Selon l'article d'Apple, le principe de fonctionnement du modèle MM1 permet à l'IA de mieux comprendre les invites de l'utilisateur et de générer le résultat souhaité. De nouvelles méthodes ont été utilisées lors de l'entraînement du modèle MM1, et ces méthodes affirment que la résolution de l'image et la capacité de l'encodeur visuel ont eu le plus grand impact sur les performances du modèle.

Apple est-il en train de prendre du retard dans la course à l'IA ?

Le laboratoire de recherche d'Apple a cherché à construire un modèle de langage multimodal à grande échelle (MLLM) très performant en examinant attentivement des tonnes de méthodes de formation et de construction d'IA. Selon l'article d'Apple, l'utilisation de différents types de données lors de la formation d'un modèle d'IA, l'utilisation de documents image-texte dans l'apprentissage à quelques coups, l'utilisation d'images légendées pour augmenter les performances à zéro coup, et les données textuelles uniquement soulignent qu'une forte compréhension du langage est importante pour améliorer les performances.

Comment le modèle MM1 a-t-il été construit ?

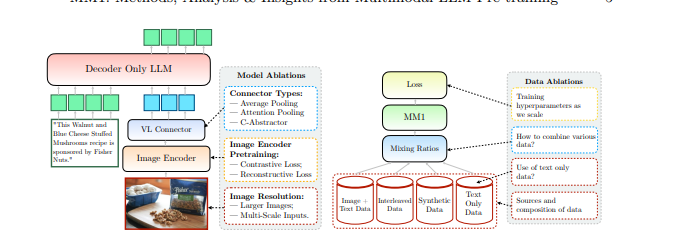

Apple a mentionné qu'elle est allée au-delà des méthodes traditionnelles pour construire le modèle MM1 et que ces méthodes étaient nécessaires pour construire un modèle multimodal de grande langue (MLLM) très performant. Apple considère trois étapes de base lors de la construction du modèle MM1 :

- Architecture : L'équipe du laboratoire de recherche d'Apple a examiné les méthodes permettant de connecter différents encodeurs d'images pré-entraînés et des LLM avec ces encodeurs pour construire une architecture unique.

- Données entraînées : Le modèle MM1 est entraîné avec des ensembles de données contenant différents types de données, comme des données visuelles et textuelles, et des combinaisons de ces données.

- Procédure de formation : Au lieu d'être formé avec un grand nombre de paramètres, le modèle MM1 a été formé en se concentrant sur les hyperparamètres et sur l'étape à laquelle ils seront utilisés.

Capacités du MM1 d'Apple

Le modèle multimodal à langage étendu (MLLM) MM1 d'Apple a des méthodes d'entraînement différentes, moins de paramètres et des approches différentes du processus d'entraînement par rapport aux MLLM traditionnels. Apple affirme que le modèle MM1 a été construit en découvrant les méthodes les plus efficaces et en essayant des innovations pour former un MLLM. Examinons de plus près les capacités et les différences de formation du modèle MM1.

L'architecture

Le modèle MM1 a une architecture différente de celle des autres MLLM (Multimodal Large Language Models). Cette architecture comprend des encodeurs à plus haute résolution d'image, une approche différente du processus de pré-entraînement et le mélange de données étiquetées pour stimuler la performance globale d'une seule invite. Le laboratoire de recherche d'Apple se concentre sur l'importance des différents choix de données pour entraîner le modèle MM1. En d'autres termes, le modèle MM1 a une architecture qui vise à fournir des performances plus élevées en utilisant moins de ressources que les MLLM traditionnels.

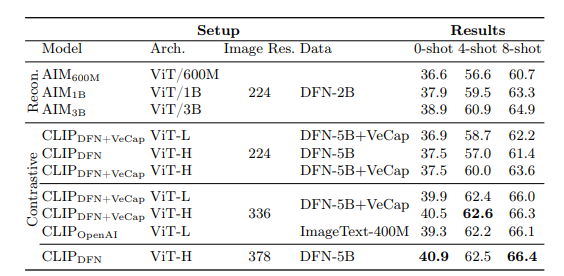

Encodeur d'images

La plupart des modèles multimodaux à langage étendu utilisent un encodeur d'images pré-entraîné CLIP (Contrastive Language-Image Pretraining) pour traiter les données visuelles. En outre, des études récentes montrent que les modèles auto-supervisés uniquement basés sur la vision fonctionnent plus efficacement. En analysant ces encodeurs, l'équipe de recherche d'Apple a découvert que la méthode la plus efficace pour entraîner un MLLM avec des données visuelles passe par les images sélectionnées pour les encodeurs. Selon le laboratoire de recherche d' Apple , les données utilisées dans le processus de traitement d'un encodeur d'images affecteront directement les performances de l'encodeur. Le résultat de toutes ces recherches est le suivant : la résolution de l'image a l'impact le plus important, suivie de la taille du modèle et de la composition des données d'entraînement.

Paramètres MM1

Selon le laboratoire de recherche d'Apple, ce qui est plus important que la taille des paramètres d'un modèle de langage large multimodal (MLLM), c'est le réglage fin, la mise à l'échelle et les hyperparamètres de ces paramètres.

Les paramètres du modèle MM1 ont été utilisés avec une efficacité maximale pour analyser et traiter différentes entrées de données. Le modèle MM1 est une famille de modèles d'IA comprenant trois tailles de paramètres différentes : 3B, 7B et 30B. En outre, plus la taille des paramètres d'un MLLM est petite, plus il fonctionnera efficacement sur les appareils mobiles.

Si tu es à la recherche d'un assistant IA qui te soutiendra toujours sur les appareils mobiles et les ordinateurs de bureau pour t'aider à accomplir tes tâches quotidiennes ou professionnelles, tu devrais garder TextCortex sur ton radar.

%20(5).png)

%20(13).png)

%20(12).png)

%20(11).png)