Meta AI introducerade en LLM som närmar sig nuvarande AI-teknik genom att tillkännage Llama 3-modellen den 18 april 2024. Även om LLama 3-modellen är mer avancerad än sin föregångare, LLama 2-modellen, är den på det hela taget en konkurrent till stora språkmodeller på mellannivå som GPT-3.5 och Claude 3 Sonnet. Meta AI:s LLama 3-modell lovar förbättrat resonemang, mer tränad data och språkförståelse jämfört med sin föregångare. Om du undrar över Llama 3-modellen är du på rätt plats!

I den här artikeln kommer vi att utforska Llama 3-modellen och dess funktioner tillsammans.

Om du är redo, låt oss börja!

TL; DR

- Llama 3-modellen är en stor språkmodell utvecklad av Meta AI och tillkännagavs den 18 april 2024.

- Llama 3 finns i två modellstorlekar som lämpar sig för olika användningsfall: 8B och 70B.

- Du kan besöka Meta AI:s officiella webbplats för att komma åt Llama 3-modellen, men Llama 3 är för närvarande inte tillgängligt i alla länder.

- Om du vill komma åt Llama 3-modellen över hela världen, ZenoChat by TextCortex är din frälsare.

- Llama 3-modellen lyckades överträffa sina rivaler, Gemini Pro 1.5 och Claude 3 Sonnet-modellerna, i benchmarks.

- Llama 3-modellen tränas med särskilt filtrerade offentligt tillgängliga data av hög kvalitet.

- Om du letar efter en bättre konversations-AI än Llama 3, ZenoChat by TextCortex är designad för dig med sina anpassningsalternativ och text- och bildutmatningsmöjligheter.

Meta AI:s recension av Llama 3

Llama 3-modellen är en stor språkmodell som introducerades av Meta AI den 18 april 2024. Llama 3-modellen erbjuder förbättrade funktioner och utgångsgenereringsmöjligheter jämfört med sin föregångare. Llama 3-modellen syftar till att erbjuda toppmodern prestanda inom ett brett spektrum av branscher med sitt förbättrade resonemang, finjusterade språkförståelse och nya funktioner.

Ett annat mål för Meta AI när man utvecklar Llama 3-modellen är att förbättra dess användbarhet. Meta AI syftade till att öka effektiviteten i Llama 3-modellen genom att publicera den för communityn och AI-utvecklare medan den var under utveckling. Meta AI:s framtidsplaner för Llama 3-modellen inkluderar att göra den flerspråkig och multimodal, öka kontextfönstret och förbättra dess prestanda.

Lama 3 Modellstorlekar

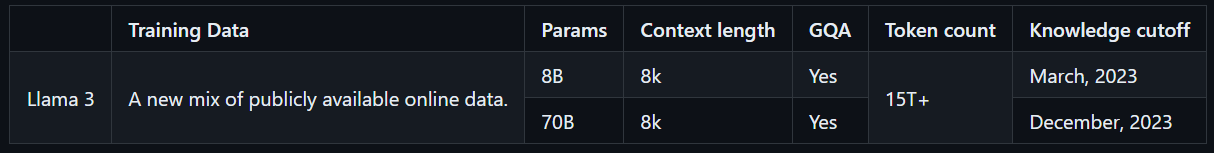

Llama 3 finns i två modellstorlekar som är lämpliga för olika användningsfall: 8B och 70B. Llama 3 8B-modellen är mer kompakt, med totalt 8 miljarder parametrar, och kan generera utdata snabbare. Å andra sidan har Llama 3 70B-modellen totalt 70 miljarder parametrar och är lämplig för komplexa uppgifter. Dessutom tränas Llama 3 8B-modellen med offentligt tillgängliga onlinedata fram till mars 2023, medan Llama 3 70B-modellen tränas med offentligt tillgängliga onlinedata fram till december 2023.

Hur får man tillgång till Llama 3?

För att komma åt Llama 3-modellen kan du besöka Meta AI:s officiella webbplats, klicka på knappen "Kom igång" och följa stegen. Men eftersom Llama 3-modellen inte är tillgänglig över hela världen har den en låg tillgänglighetspoäng, till skillnad från andra LLM:er. Det finns dock sätt för dig att uppleva Llama 3-modellen över hela världen.

Med ZenoChat by TextCortex, kan du komma åt och uppleva båda storlekarna av Llama 3-modellen utan några begränsningar. ZenoChat kommer att stödja Llama 3, 8B och 70B LLM:er utöver GPT-4, Sophos 2, Mixtral, Claude 3 Opus och Sonnet LLM:er. Som sagt, du kan fritt uppleva Llama 3-modellen utan Meta AI:s landsbegränsningar.

Meta AI:s Llama 3-kärnfunktioner

Llama 3, Meta AI:s nyaste och mest avancerade modell, har högre prestanda och nya funktioner än sin föregångare. Llama 3-modellen introducerades som en konkurrent, inte till avancerade LLM:er som GPT-4 och Gemini Ultra utan till mer frekvent använda modeller som GPT-3.5 och Gemini Pro. Låt oss ta en närmare titt på kärnfunktionerna i Llama 3.

Modellens prestanda

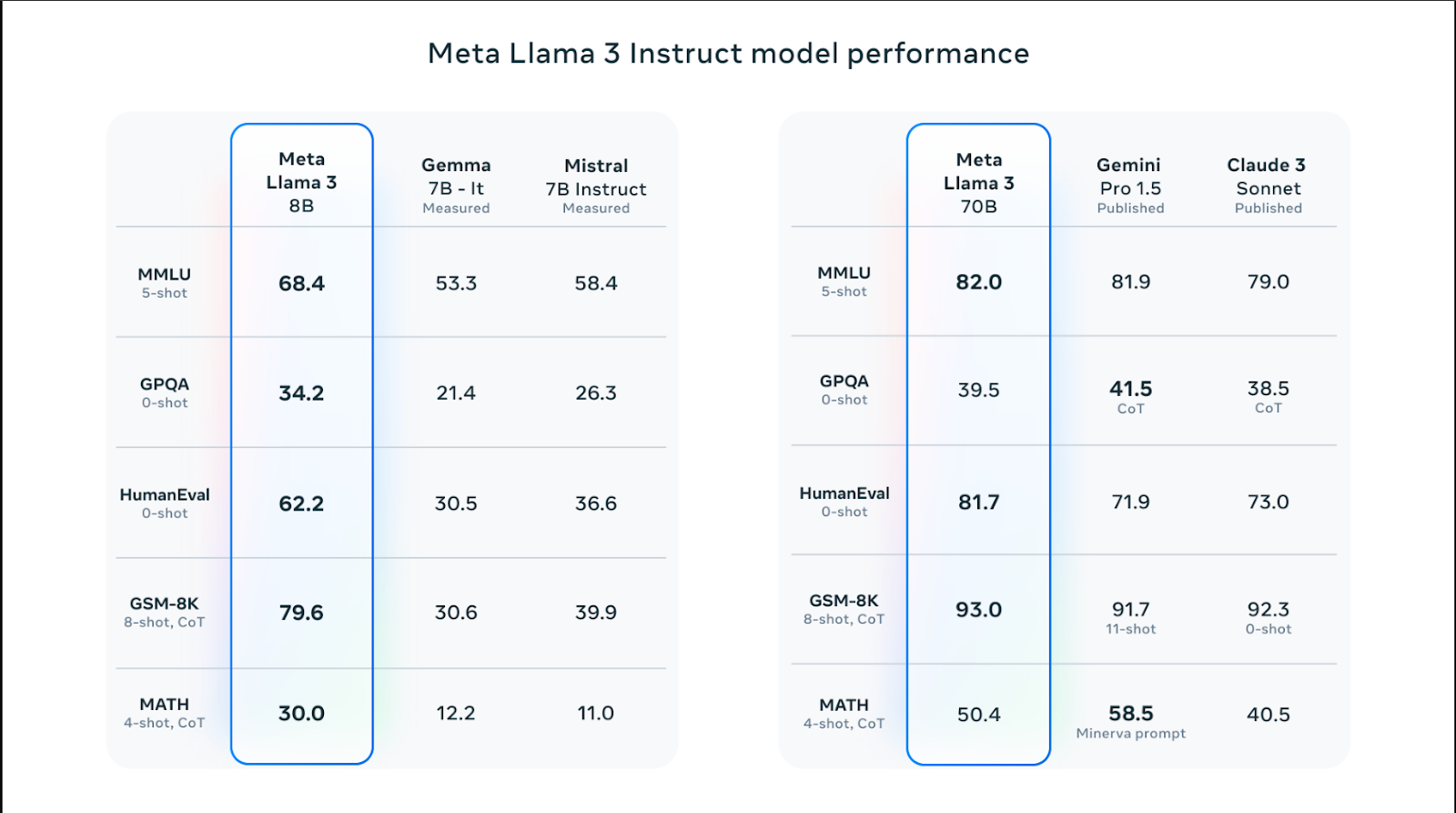

Llama 3-modeller finns i olika storlekar och har bättre prestanda än Llama 2-modeller i färdigheter som resonemang, kodgenerering, matematik och instruktionsföljning. Bland Llama 3-modellerna överträffade 70B-modellen populära modeller som Claude 3 Sonnet och Gemini Pro 1.5 genom att få 82,0 poäng i MMLU-riktmärket. Llama 3-modellerna presterar dock bättre än Claude 3 Sonnet- och Gemini Pro 1.5-modellerna i alla riktmärken utom MATH-riktmärket, som mäter matematiska färdigheter, och GPQA, som mäter frågor och svar på forskarnivå.

Llama 3 8B-modellen lyckades överträffa sina rivaliserande Gemma 7B- och Mistral 7B-modeller i Humaneval-, MMLU-, GPQA-, GSM-8K- och MATH-riktmärken. Med andra ord har Llama 3-modellstorlekar högre prestanda än sina rivaliserande modeller.

Träningsdata

Llama 3-modellen tränades med en stor mängd data, vilket är avgörande för att skapa en högpresterande stor språkmodell. Specifikt tränades den med 15T-tokens från offentligt tillgängliga källor – 7 gånger mer än mängden data som används för att träna Llama 2-modellen.

Dessutom tränades Llama 3-modellen med en högkvalitativ datauppsättning bestående av 30 andra språk än engelska. Detta har resulterat i en betydande ökning av modellens språkförståelse, kreativitet och förmåga att följa uppmaningar.

Meta AI-teamet har utvecklat en serie datafiltreringspipelines för att träna Llama 3-modellen med högkvalitativa och tillförlitliga data. Dessa filter innehåller parametrar som NSFW-filter, heuristiskt filter, semantisk dedupliceringsmetod och textklassificerare. Dessutom, eftersom Llama 2-modellen är bra på att identifiera data av hög kvalitet, användes den för att filtrera den tränade datan i Llama 3-modellen.

Optimering

Llama 3-modeller är speciellt optimerade för ofta använda GPU- och CPU-modeller och märken. Ju mer programvara som är optimerad för specifik hårdvara, desto högre prestanda och snabbare kommer den att köras. Llama 3-modellen är optimerad för Intel-, AMD- och Nvidia-hårdvara. Dessutom har Intel publicerat en detaljerad guide om prestandan hos Llama 3-modellen.

Säkerhet

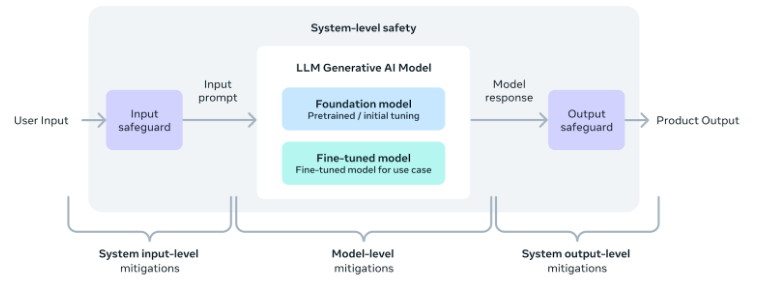

Meta AI-teamet inser vikten av säker användning av AI-verktyg och programvara, inklusive Llama 3-modellen. Följaktligen lades säkerhetsparametrar till under modellens utveckling för att säkerställa att dess resultat är säkert, oskadligt och etiskt.

Dessutom har teamet också tillhandahållit en säkerhetsimplementeringsguide på systemnivå för dem som vill utveckla applikationer med hjälp av Llama 3-modellen. Med dessa åtgärder på plats kan användarna njuta av bekvämligheten och fördelarna med AI-verktyg samtidigt som de använder dem på ett säkert och ansvarsfullt sätt.

Ett bättre alternativ: ZenoChat by TextCortex

Om du letar efter en anpassningsbar AI-assistent med tillgång till olika LLM:er, inklusive Llama 3-modellen, ZenoChat by TextCortex är designad för dig. ZenoChat är ett AI-verktyg som erbjuder sina användare fördelarna med olika LLM:er och inte begränsar dem till en enda LLM. ZenoChat syftar till att hjälpa sina användare med professionella och dagliga uppgifter som textgenerering, parafrasering och forskning. Med ZenoChat kan du snabba upp vilken uppgift som helst med 12 gånger, minska din arbetsbelastning och skjuta i höjden din produktivitet.

ZenoChat finns som webbapplikation och webbläsareextension. Webbläsaren ZenoChat extension är integrerad med 30 000+ webbplatser och appar. Så den kan fortsätta att stödja dig var som helst och när som helst.

Arbeta med din egen kunskap och data

ZenoChat erbjuder en helt anpassningsbar AI-upplevelse tack vare våra funktioner "Kunskapsbaser" och "Individuella Personas". Med vår funktion "Individuella Personas" kan du justera ZenoChats utdatastil, meningslängd, dominanta känslor i meningar och personlighet som du vill. Med andra ord kan du använda den här funktionen för att göra ZenoChat till din personliga assistent eller din digitala tvilling.

Med vår funktion "Kunskapsbaser" kan du ladda upp eller ansluta datakällor som ZenoChat kommer att använda för att generera resultat. Genom att använda den här funktionen kan du träna ZenoChat med dina egna data och göra den lämplig för specifika användningsfall. Dessutom, tack vare den här funktionen, kan du sammanfatta hundratals sidor med dokument med en enda uppmaning eller chatta med dina PDF-filer. Vår funktion "Kunskapsbaser" har också en knapp som gör att du kan integrera din Google Drive eller Microsoft OneDrive på några sekunder.

%20(8).png)

%20(20).png)