Meta AI släppte Llama 3, den mest avancerade versionen av den stora språkmodellen de utvecklade, den 18 april 2024. Llama 3 är en stor språkmodell som har hög prestanda jämfört med sina konkurrenter och är utbildad med en dataset som valts med speciella filtreringsmetoder. Llama 3-modellen finns i två olika storlekar: 8B och 70B. Båda Llama 3-modellerna är lämpliga för olika användningsområden. Om du är nyfiken på Llama 3-modellen och undrar hur du kan få tillgång till den, så har vi lösningen för dig!

I den här artikeln kommer vi att undersöka vad Llama 3-modellen är och hur du kan få tillgång till den.

Är ni redo? Låt oss dyka in!

TL; DR

- Llama 3 är en stor språkmodell som utvecklats av Meta AI och tillkännagavs den 18 april 2024.

- Llama finns i två olika storlekar som är anpassade till tre olika användningsområden: 8B och 70B.

- Llama 3 använder tekniker som naturlig språkbehandling (NLP), maskininlärning och djupinlärning för att generera utdata.

- Eftersom Llama 3-modellen är öppen källkod är den fri att använda.

- Llama 3-modellen har högre prestanda i de flesta benchmarks än sina rivaliserande modeller som GPT-3.5 och Claude 3 Sonnet.

- Llama 3-modellen har tränats med hjälp av högkvalitativa data från över 30 språk.

- För att få tillgång till Llama 3-modellen måste du logga in på ditt Meta AI-konto från det land där det är tillgängligt.

Vad är Llama 3?

Llama 3 är en Large Language Model (LLM) som utvecklats av Meta AI med högre prestanda än sin föregångare. När Meta AI tillkännagav Llama 3 uppgav Meta AI att den tränades med finjusterade parametrar. Llama 3-modellen har förbättrat resonemang, språkförståelse, snabb läsning och kodningsförmåga jämfört med sin föregångare. Meta AI strävar efter att kickstarta nästa våg av innovation inom artificiell intelligens med Llama 3-modellen.

Hur får man tillgång till Llama 3?

Modellen Llama 3 är en effektiv lösning för att utföra småskaliga uppgifter. Dess stora fördelar är att den överträffar Claude Sonnet- och GPT-3.5-modellerna och att den är öppen källkod. Låt oss ta en närmare titt på hur du får tillgång till Llama 3.

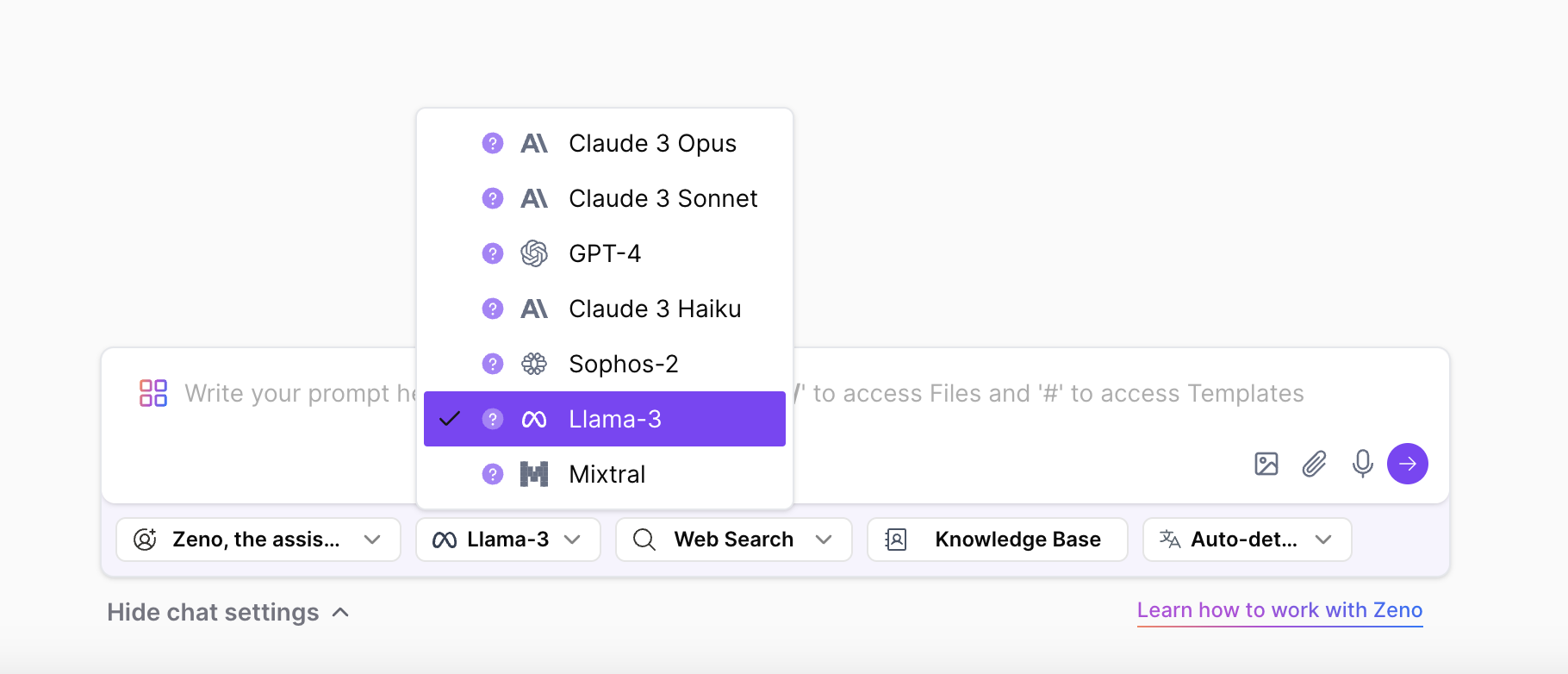

Få tillgång till Llama 3 på ZenoChat

Om du vill uppleva Llama 3-modellen och alla dess storlekar från vilket land som helst, är ZenoChat från TextCortex utformad för dig. ZenoChat är en AI-assistent som erbjuder olika LLM:er till sina användare och syftar till att minska arbetsbelastningen för sina användare. Välj helt enkelt den LLM som du vill använda för att generera utdata från chattinställningarna i ZenoChat.

Med ZenoChat kan du slutföra dina textbaserade uppgifter som textgenerering, parafrasering, översättning, sammanfattning, meningsutvidgning, tonförändring, grammatik- och stavningskorrigeringar, eller så kan du använda hela internet som datakälla med hjälp av dess webbsökningsfunktion. Dessutom erbjuder ZenoChat också DALL-E 3-driven AI-bildgenerering till sina användare. ZenoChat finns som webbapplikation och webbläsare på extension. ZenoChats webbläsare extension är integrerad med över 30 000 webbplatser och appar. Så den kan följa med dig var som helst och när som helst.

Låter det spännande? Klicka här för att skapa ditt kostnadsfria TextCortex -konto och upplev den ultimata AI-assistenten.

Upplev Llama 3 på Meta AI

Du kan komma åt Llama 3-modellen via Meta AI. Allt du behöver göra är att gå till Meta AI: s officiella webbplats, skapa ett konto och begära åtkomsttillstånd. Llama 3-modellen är dock endast tillgänglig utanför USA i Australien, Kanada, Ghana, Jamaica, Malawi, Nya Zeeland, Nigeria, Pakistan, Singapore, Sydafrika, Uganda, Zambia och Zimbabwe. Om du inte är ett av de nämnda länderna kommer du att se meddelandet "Meta AI är ännu inte tillgängligt i ditt land".

Lama 3 Modellstorlekar

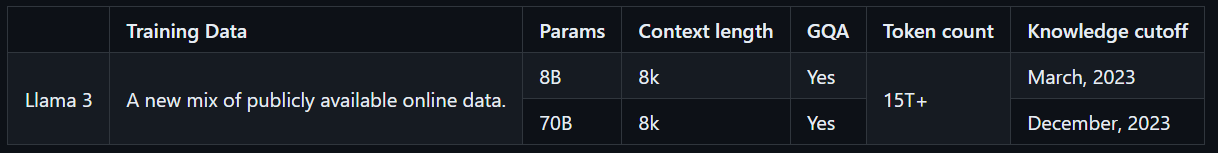

Llama 3-modellen finns i två storlekar, anpassade för olika användningsområden. 8B-modellen är idealisk för att utföra enkla uppgifter snabbt och exakt, medan 70B-modellen är utformad för att hantera större, mer komplexa uppgifter med högkvalitativa resultat. Båda modellerna har tränats med över 15T tokens, vilket är 7 gånger mer än de tokens som användes för att träna Llama 2-modellen. Dessutom har Llama 3-modellerna flerspråkiga funktioner tack vare att de har tränats med högkvalitativa icke-engelska data.

Hur fungerar Llama 3?

Llama 3-modellen genererar utdata med hjälp av AI-teknik som Natural Language Processing (NLP), djupinlärning och maskininlärning. LLama 3-modellen analyserar de indata som användaren matar in med sina utbildade data och parametrar, förstår användarens avsikt och genererar de utdata som behövs.

Llama 3-modellen har tränats med hjälp av data som har passerat genom särskilda filtreringssystem för att säkerställa säker och lämplig utdata. Detta inkluderar användning av ett NFSW-filter, heuristiskt filter, semantisk deduplicerad metod och textklassificerare. Dessutom användes Llama 2-modellen, som föregick Llama 3-modellen, för att välja ut de data som användes för att träna Llama 3-modellen, eftersom den lyckades identifiera data av hög kvalitet.

Är Llama 3 gratis att använda?

Meta AI har alltid marknadsfört sin Llama-modellserie som öppen källkod och fri att använda, och Llama 3 är inget undantag. Eftersom de för närvarande släppta modellerna Llama 3 8B och 70B är öppen källkod kan vem som helst uppleva dessa modeller. Det är dock ännu inte klart om Llama 3 400B, som fortfarande befinner sig i utbildningsprocessen och är den mest avancerade medlemmen i Llama 3-serien, är fri att använda.

Llama 3 Funktioner

Llama 3 släpptes med två olika modeller som har högre prestanda än sina konkurrenter. Anledningen till att dessa två modeller har högre prestanda än sina konkurrenter är att de har tränats med data som identifierats genom speciell filtrering. Llama 3-modellen har unika egenskaper jämfört med andra LLM:er på marknaden. Låt oss ta en närmare titt på funktionerna i Llama 3.

Prestanda och riktmärken

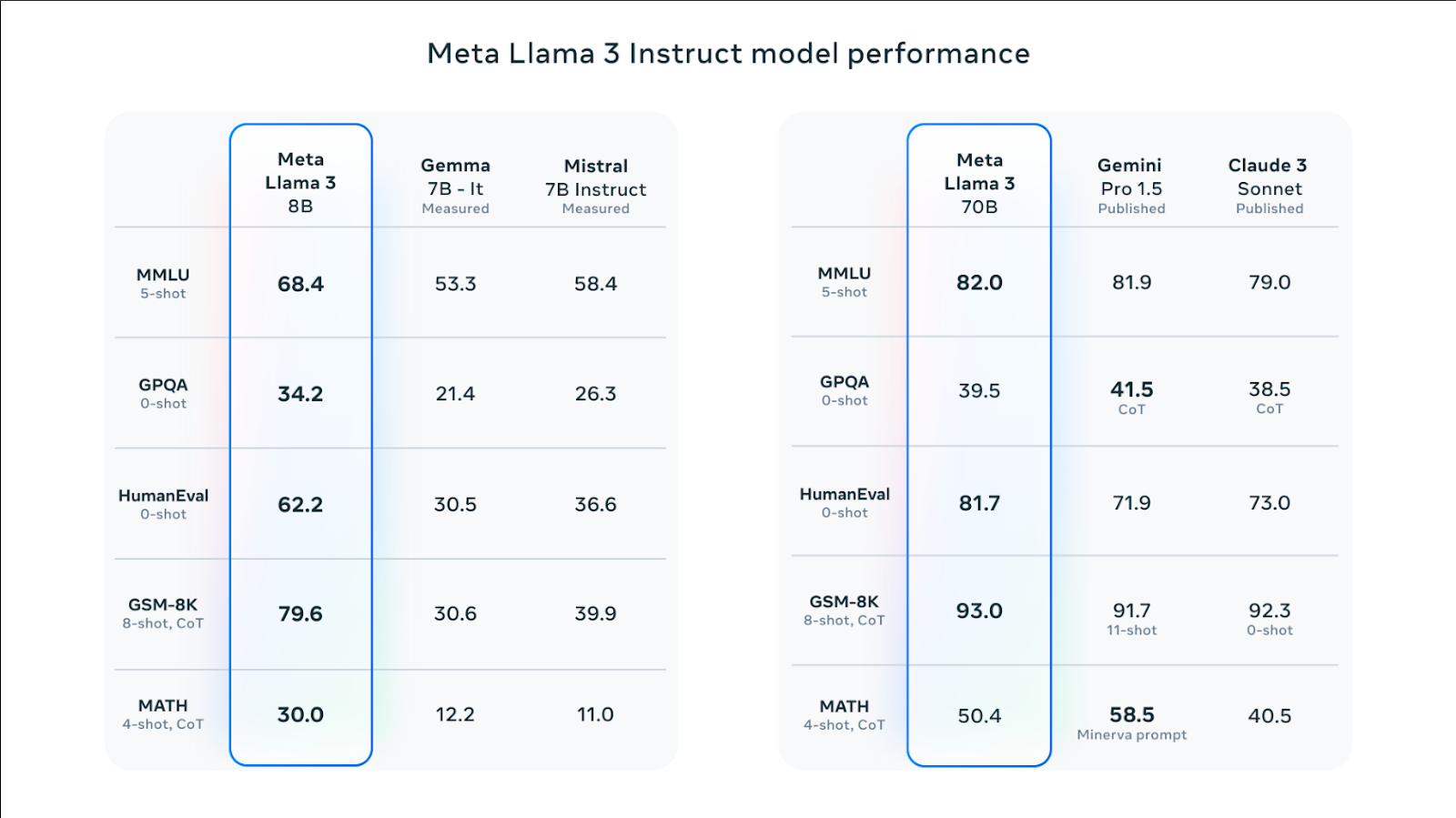

Både modellerna Llama 3 8B och Llama 3 70B har högre poäng i benchmarks som HumanEval, MMLU och DROP jämfört med sina konkurrenter. Till exempel har modellen Llama 3 70B något högre prestanda i MMLU-riktmärket jämfört med sina motsvarande modeller Gemini Pro 1.5 och Claude 3 Sonnet. Modellen Llama 3 8B har en högre total prestanda än sina konkurrenter, modellerna Gemma 7B och Mistral 7B.

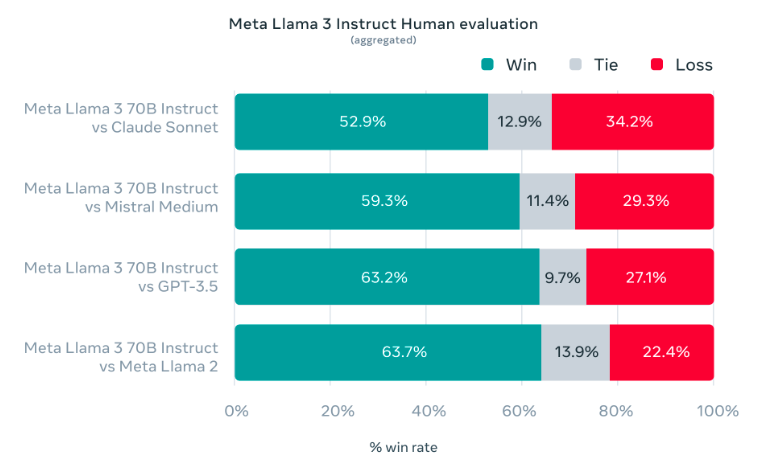

Under utvecklingen av Llama 3-modellen syftade den till att visa hög prestanda i verkliga användningsfall snarare än laboratoriemiljötester. Av denna anledning har Meta AI-teamet utvecklat en ny, högkvalitativ mänsklig utvärderingsuppsättning. Denna utvärderingsuppsättning består av 1800 uppmaningar som täcker 12 viktiga användningsfall. Uppmaningarna inkluderar uppgifter som att be om råd, kodning, brainstorming, kreativt skrivande, frågor och svar, resonemang, omskrivning och sammanfattning. Meta AI: s LLama 3-modell visade högre prestanda i dessa tester jämfört med sina rivaler Claude Sonnet, GPT-3.5 och Mistral Medium.

Fråga Förståelse

Eftersom Llama 3-modellen är utbildad med hjälp av övervakad finjustering (SFT) och förstärkningsinlärning med mänsklig feedback (RLHF) är den en mer framgångsrik modell när det gäller att följa uppmaningar än sin föregångare. Under träningen av Llama 3-modellen prioriterades att den skulle generera hjälpsamma och säkra utdata.

5% av Llama 3-modellens tränade data täcker högkvalitativ grammatik, meningsstruktur och kreativt skrivande på 30+ språk. Av denna anledning kan Llama 3-modellen analysera de uppmaningar som användaren ger på andra språk och förstå användarnas uppmaningar på andra språk.

Modellarkitektur

Decoder-only transformatorarkitektur användes vid träning av Llama 3-modellen. Enligt Meta AI: s artikel använder Llama 3 en tokenizer med ett ordförråd på 128K tokens som kodar språk mycket mer effektivt, vilket leder till väsentligt förbättrad modellprestanda. Både 8B- och 70B-storlekarna i Llama 3-modellen tränades i sekvenser på 8 192 tokens.

Meta AI använde en kombination av dataparallellisering, modellparallellisering och pipelineparallellisering för att träna Llama 3-modellen. Därför syftar det till att minska arbetsbelastningen samtidigt som bearbetningshastigheten för Llama 3-modellen på GPU: er ökar. Det system som Llama 3-modellen fungerar mest effektivt på är 400 TFLOPS per GPU. Llama 3-modellen använder system för feldetektering, hantering och underhåll för att maximera GPU-hastigheten under körning.

%20(11).png)

%20(20).png)