Medan AI fortsätter att utvecklas i full fart har Apple gett sig in i sektorn och upptäckt olika och nya sätt att träna en MLLM (Multimodal Large Language Model). När Apple tränade MM1-modellen erbjöd man en mer effektiv metod genom att anpassa den traditionella träningsprocessen för multimodala storspråksmodeller. Denna metod innebär effektiv användning av stora mängder datauppsättningar med lämpliga parametrar och hyperparametrar. Om du undrar hur MM1-modellen fungerar har du kommit helt rätt!

I den här artikeln kommer vi att förklara vad MM1-modellen är och hur den fungerar.

Är ni redo? Låt oss dyka in!

TL; DR

- Apples MM1 är en multimodal stor språkmodell som utvecklats med en unik metod för förträning och finjustering.

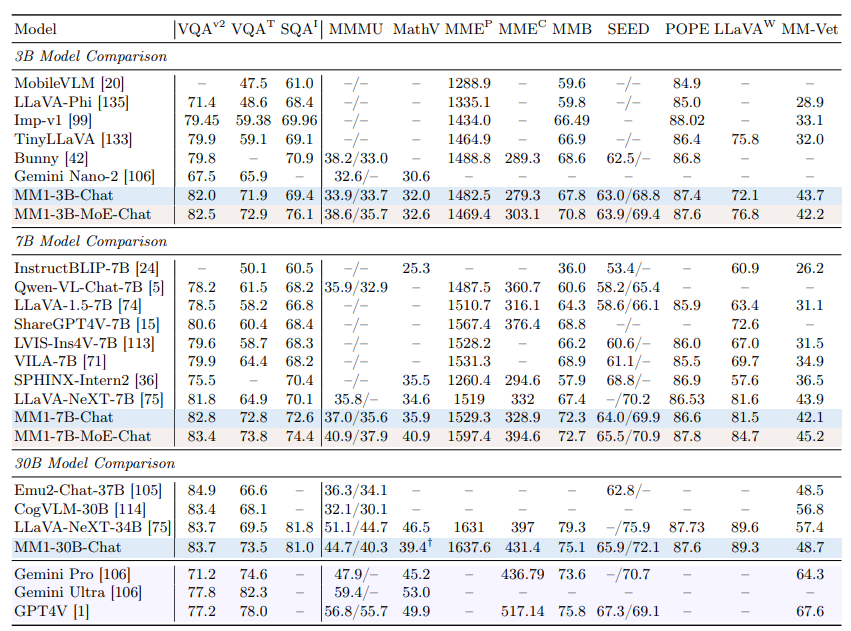

- Apple MM1-modellen lanserades med tre olika parameterstorlekar: 3B, 7B och 30B.

- Medan Apple MM1-modellen överträffar GPT-4- och Gemini Ultra-modellerna i vissa benchmarks, släpar den efter med en liten marginal i andra.

- Under utbildningen av Apple MM1-modellen gjordes bildkodare, synspråksanslutningar och utbildade datafaser om.

- Om du behöver en AI-assistent som kan hjälpa dig både i vardagen och i yrkeslivet är TextCortex ett bra alternativ.

- TextCortex syftar till att automatisera din arbetsbelastning och öka din produktivitet med sina unika funktioner och avancerade AI-funktioner.

Vad är Apple MM1?

Apples MM1-modell är en multimodal storspråksmodell (MLLM) som är utformad för att utföra visuellt baserade uppgifter med hög prestanda och minimala systemkrav. Denna modell har utvecklats med en unik och ny metod för MLLM-utbildningsprocessen. Detta tillvägagångssätt syftar till maximal effektivitet med minimala parametrar.

Apples MM1-modell Storlekar

Apples multimodala stora språkmodell MM1 har skalats upp till tre olika storlekar, var och en med varierande antal parametrar: 3B, 7B och 30B. Dessutom har dessa modeller skalats upp med hjälp av en MoE-metod (mixture-of-experts). Denna skalning är den avgörande faktorn bakom MM1:s enastående prestanda under både förträningen och finjusteringen.

Är MM1 bättre än ChatGPT?

Tack vare sin höga prestanda i förtränings- och finjusteringsfaserna kan Apple MM1-modellen konkurrera med modeller som GPT-4V och Gemini Ultra och till och med överträffa dem i vissa benchmarks. MM1 30B-modellen lyckades till exempel överträffa både GPT-4 Vision-modellen och Gemini Ultra-modellen i VQAv2-benchmarken. När det gäller andra benchmarks kan man se att MM1-modellen har något lägre prestanda än Gemini Ultra- och GPT-4-modellerna.

Hur får jag tillgång till MM1?

Eftersom Apple ännu inte har gjort MM1-modellen allmänt tillgänglig är det inte möjligt för oss att uppleva den på något sätt. Apples forskningslaboratorium har dock uppgett att alla MM1-storlekar kommer att finnas tillgängliga inom kort.

Hur fungerar Apples MM1?

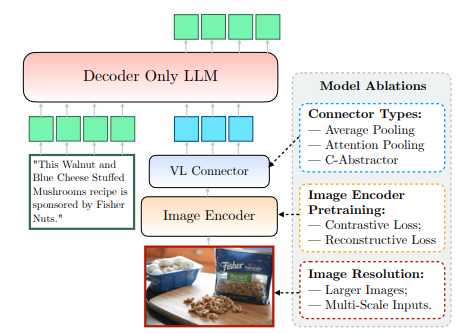

Apples MM1-modell, som ännu inte är offentligt tillgänglig, har tränats på ett nytt och unikt sätt som går längre än traditionella metoder. Enligt Apples forskningslabb är det nödvändigt att undersöka det komplexa förhållandet mellan MLLM:s arkitektoniska design och integreringen av olika dataset för att kunna träna en modell med maximal effektivitet. Denna metod syftar till att uppnå maximal effektivitet med minimala parametrar. Vi kan tydligt få tillgång till denna information från det papper som Apple delar. Låt oss ta en närmare titt på hur Apples MM1 fungerar.

Bildkodare

Under träningen av MM1-modellen upptäckte Apple Research Lab att bildupplösningen har störst inverkan på träningsprocessen. MM1-modellen tränades med bilder som hade en upplösning på 378x378 pixlar. Denna träningsprocess slutfördes med hjälp av djupinlärningsmodellerna ViT-H (Vision Transformer - Huge) och CLIP (Contrastive Language-Image Pretraining). Medan ViT-H-modellen är utformad av Google för bildklassificering, är CLIP användbar för inbäddning av bilder utformade av OpenAI.

Koppling mellan syn och språk

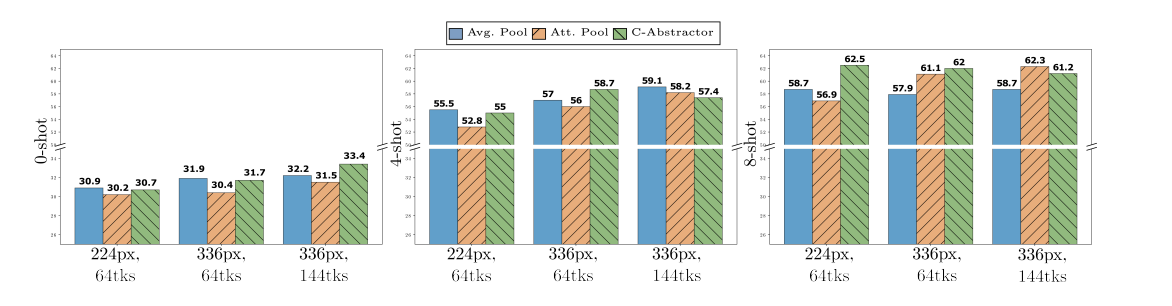

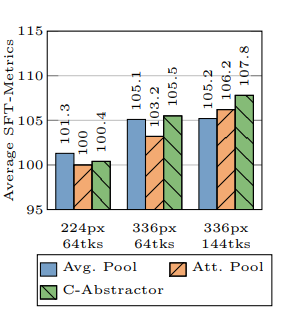

Enligt Apple Research Lab är bildens upplösning och antalet visuella symboler avgörande för att ta träningsprocessen till nästa nivå när man utvecklar en MLLM, om man vill att den ska ge hög prestanda i visuellt baserade uppgifter. Apple Research Lab använde en VL-kontakt med 144 symboler när de utvecklade MM1-modellen.

Vilka data utbildades Apple MM1 på?

De tränade data i en multimodal storspråksmodell (MLLM) fungerar både som dess minne och som den kunskap den använder för att generera utdata. Ju mer varierad och omfattande en MLLM:s tränade data är, desto mer koncisa resultat kan den generera.

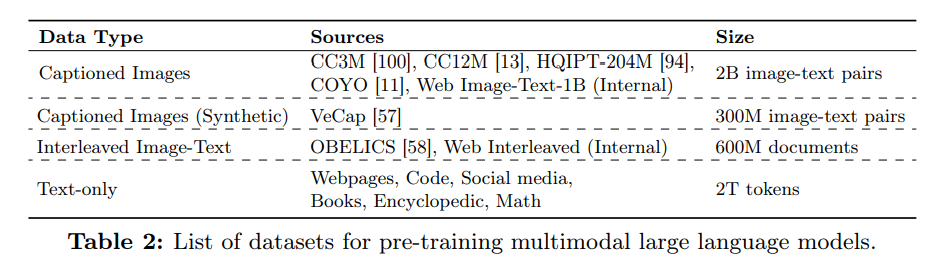

Apples forskningslaboratorium använde en betydande mängd data bestående av text och bilder för att förbättra MM1-modellens prestanda för nollskott och fåskott. Enligt Apples artikel tränas MM1-modellen med hjälp av en datavariant som innehåller 45% interfolierade bild-textdokument, 45% bild-textpardokument och 10% rena textdokument.

%20(6).png)

%20(20).png)