Medan alla större företag som Google, Microsoft och Meta har börjat arbeta inom AI-området och producerar avancerade AI-modeller efter varandra, deltog Apple, som är det företag som finns kvar, i detta AI-lopp med sin multimodala stora språkmodell som kallas MM1. Denna modell tränades med både textdata och visuella data. Den multimodala stora språkmodellen MM1 tränades med en blandning av textade bilder (45 %), interfolierade bild- och textdokument (45 %) och data med enbart text (10 %).

I den här artikeln ska vi ta reda på vad Apples multimodala stora språkmodell MM1 är.

Om du är redo, låt oss börja!

TL; DR

- MM1 är en multimodal modellfamilj för stora språk som utvecklats och tillkännagivits av Apple.

- MM1-modellen utvecklades med en annan utbildnings- och byggmetod, till skillnad från traditionella MLLM-modeller.

- När MM1-modellen byggdes om skapades arkitektur, tränade data, bildkodare, parametrar, hyperparametrar och träningsprocedur på nytt för att vara effektiva.

- MM1-modellen har färre parametrar och mindre storlek än sina konkurrenter, vilket gör att den fungerar smidigt på mobila enheter.

- Om du letar efter en AI-assistent som alltid är med dig, t.ex. för mobila enheter, är TextCortex rätt väg att gå, med sin integration av över 30 000 webbplatser och appar.

- TextCortex erbjuder en mängd olika anpassningsbara och interaktiva AI-lösningar, från skrivande till dina yrkesuppgifter.

Vad är Apple MM1?

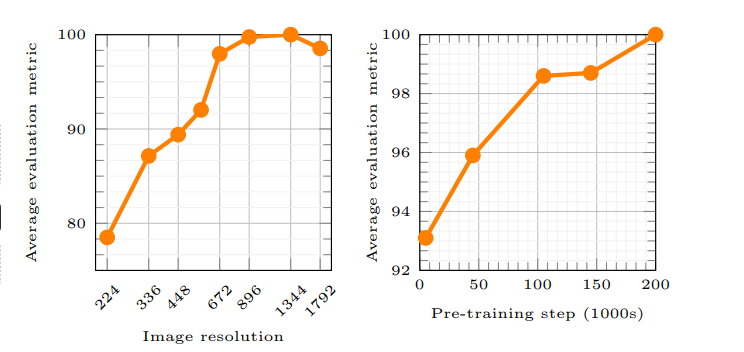

Apples MM1 är en Multimodal Large Language Model (MLLM)-familj som kan hantera och generera både text och visuella processer. Enligt Apples artikel gör MM1-modellens arbetsprincip det möjligt för AI att bättre förstå användarens uppmaningar och generera önskad output. Nya metoder användes för att träna MM1-modellen, och dessa metoder hävdar att bildupplösningen och kapaciteten hos den visuella kodaren hade störst inverkan på modellens prestanda.

Håller Apple på att hamna på efterkälken i AI-racet?

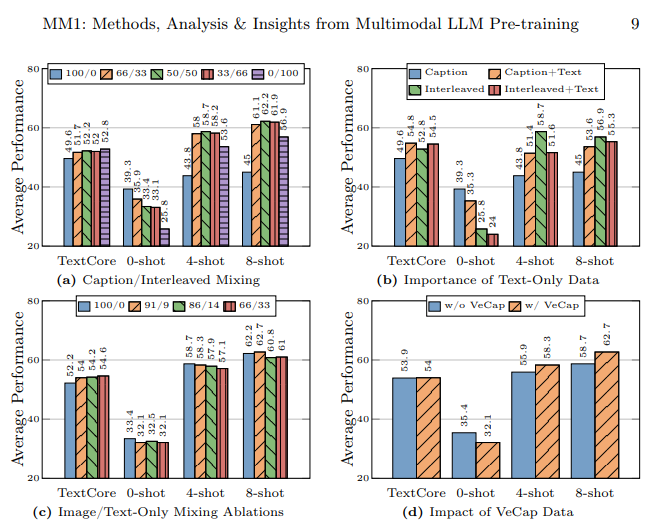

Apples forskningslabb hade som mål att bygga en högpresterande multimodal stor språkmodell (MLLM) genom att noggrant undersöka massor av AI-tränings- och byggmetoder. Enligt Apples artikel understryker användningen av olika typer av data när man tränar en AI-modell, användning av bild-textdokument i few-shot-inlärning, användning av textade bilder för att öka zero-shot-prestandan och enbart textdata att stark språkförståelse är viktigt för att förbättra prestandan.

Hur byggdes MM1-modellen?

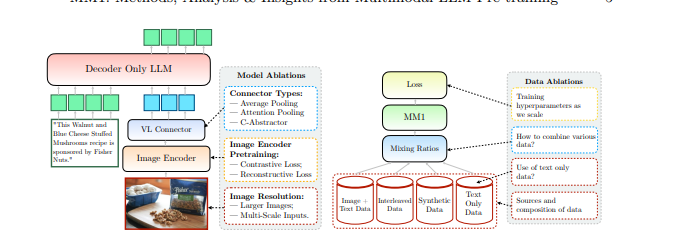

Apple nämnde att man gick längre än traditionella metoder för att bygga MM1-modellen och att dessa metoder var nödvändiga för att bygga en högpresterande multimodal storspråksmodell (MLLM). Apple tar hänsyn till tre grundläggande steg när MM1-modellen byggs:

- Arkitektur: Apples forskningslaboratorium undersökte metoder för att koppla samman olika förutbildade bildkodare och LLM med dessa kodare för att bygga en unik arkitektur.

- Tränad data: MM1-modellen tränas med dataset som innehåller olika typer av data, t.ex. visuella data och textdata, samt kombinationer av dessa data.

- Träningsförfarande: Istället för att tränas med ett stort antal parametrar tränades MM1-modellen genom att fokusera på hyperparametrar och i vilket skede de kommer att användas.

Apples MM1-kapacitet

Apples MM1 Multimodal Large Language Model (MLLM) har andra träningsmetoder, färre parametrar och andra tillvägagångssätt för träningsprocessen jämfört med traditionella MLLM. Apple säger att MM1-modellen byggdes genom att upptäcka de mest effektiva metoderna och pröva innovationer för att träna en MLLM. Låt oss ta en närmare titt på MM1-modellens kapacitet och träningsskillnader.

Arkitektur

MM1-modellen har en annorlunda arkitektur jämfört med andra MLLM-modeller (Multimodal Large Language Models). Denna arkitektur omfattar kodare med högre bildupplösning, ett annorlunda tillvägagångssätt för förträningsprocessen och blandning av märkta data för att öka den totala prestandan för en enskild prompt. Apples forskningslabb fokuserar på vikten av olika dataval för att träna MM1-modellen. MM1-modellen har med andra ord en arkitektur som syftar till att ge högre prestanda genom att använda färre resurser än traditionella MLLM.

Bildkodare

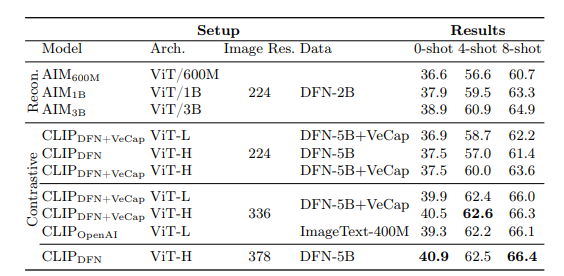

De flesta multimodala stora språkmodeller använder CLIP (Contrastive Language-Image Pretraining) förutbildad bildkodare för att bearbeta visuella data. Nya studier visar dessutom att självövervakade modeller som endast använder syn fungerar mer effektivt. Genom att analysera dessa kodare upptäckte Apples forskargrupp att den mest effektiva metoden för att träna en MLLM med visuella data är genom de bilder som valts för kodarna. Enligt Apples forskningslabb kommer de data som används i bearbetningsprocessen för en bildkodare att direkt påverka kodarens prestanda. Resultatet av all denna forskning är följande: bildupplösningen har störst inverkan, följt av modellstorleken och sammansättningen av träningsdata.

MM1 Parametrar

Enligt Apples forskningslabb är det finjusteringen, skalningen och hyperparametrarna för dessa parametrar som är viktigare än storleken på parametrarna i en multimodal storspråksmodell (MLLM).

Parametrarna i MM1-modellen användes med maximal effektivitet för att analysera och bearbeta olika indata. MM1-modellen är en familj av AI-modeller som består av tre olika parameterstorlekar: 3B, 7B och 30B. Ju mindre parameterstorleken är för en MLLM, desto effektivare fungerar den på mobila enheter.

Om du letar efter en AI-assistent som alltid kan hjälpa dig på både mobila enheter och stationära datorer att slutföra dina dagliga eller professionella uppgifter bör du hålla TextCortex på din radar.

%20(5).png)

%20(20).png)