GPT-4V est un modèle multimodal conçu par OpenAI pour analyser les entrées visuelles et générer des sorties à partir de celles-ci. GPT-4V permet aux utilisateurs de saisir des données visuelles et de générer des réponses à des questions sur ces données. En d'autres termes, en utilisant le modèle GPT-4V, tu peux analyser n'importe quel type d'image et obtenir des informations sur cette image.

Dans cet article, nous allons examiner les caractéristiques du GPT-4V et ce qu'il peut faire pour toi.

TL;DR

- Le GPT-4V est un grand modèle multimodal conçu pour générer des résultats pour des requêtes données avec des entrées visuelles.

- GPT-4V peut analyser à l'aide de l'image donnée, répondre à tes questions et résoudre des problèmes mathématiques dans l'image.

- Tu peux obtenir des résultats plus efficaces en ajoutant des pointeurs visuels à l'image que tu donneras en entrée à GPT-4V.

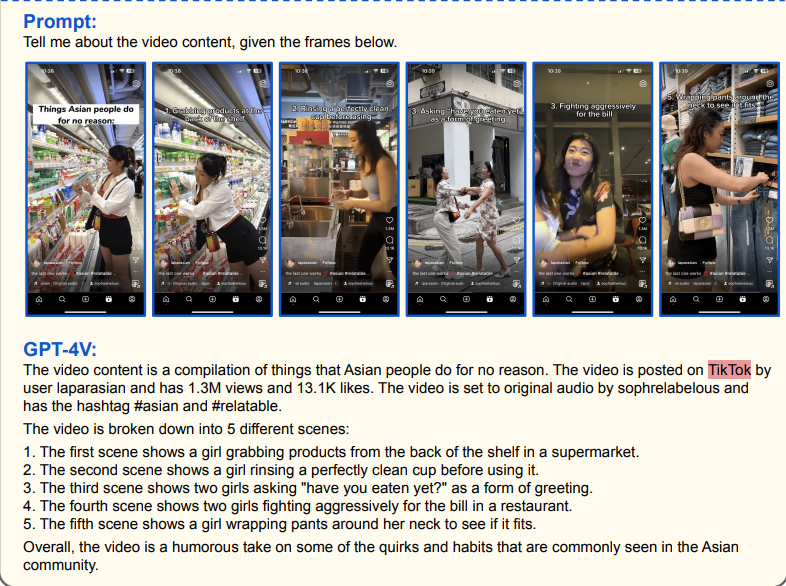

- Le GPT-4V peut effectuer des tâches d'analyse vidéo avec une grande précision en utilisant les images vidéo fournies.

- Si tu cherches un assistant d'IA alternatif où tu peux expérimenter des interactions d'IA entièrement personnalisables avec tes connaissances et ton style uniques, TextCortex est la voie à suivre.

Caractéristiques du GPT-4V

Le modèle GPT-4V est doté de fonctions conçues pour aider les utilisateurs dans divers aspects de la vie professionnelle et quotidienne. Examinons ensemble ces fonctions de plus près.

Sécurité et confidentialité

Dans son rapport sur GPT-4V, Microsoft a déclaré que lors de l'élaboration du modèle, l'équipe de développeurs a utilisé des images qui n'étaient pas accessibles en ligne ou au-delà d'avril 2023. En outre, cette méthode a permis d'améliorer la capacité de GPT-4V à mieux analyser les entrées et à générer des sorties correctes et sûres. Ainsi, le modèle GPT-4V n'utilise pas de données en ligne lorsqu'il génère des résultats, mais fait appel à de véritables compétences d'analyse et de réaction au niveau humain.

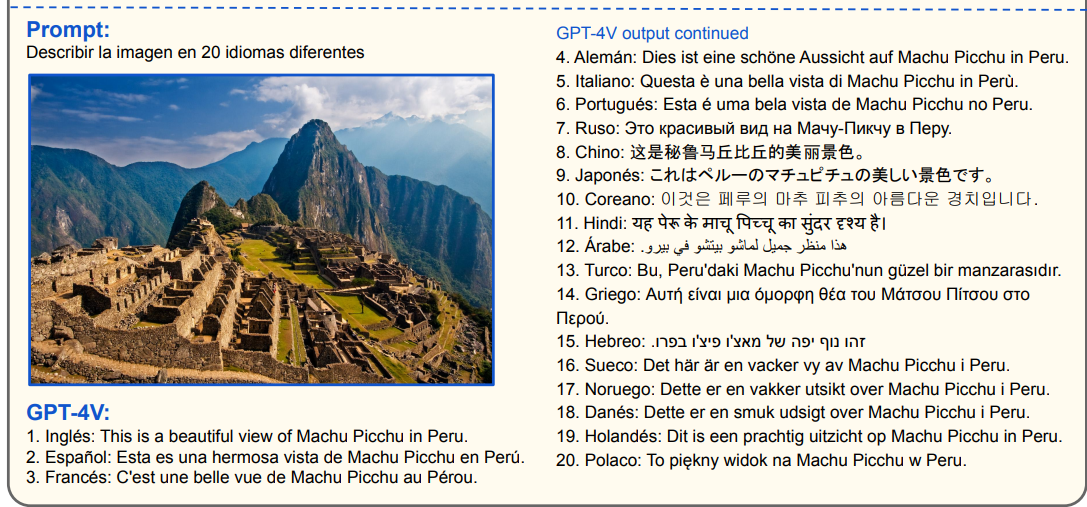

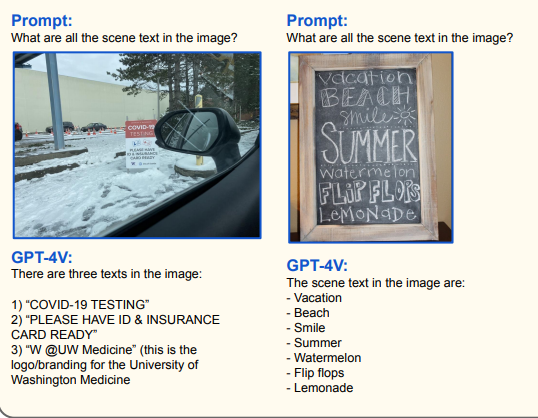

Le multilinguisme

Selon un document de Microsoft, le modèle GPT-4V peut analyser les entrées et générer des sorties dans 20 langues telles que le chinois, le français et le tchèque. En outre, le modèle GPT-4V peut générer des réponses en lisant les textes des entrées visuelles dans ces 20 langues. De plus, tu peux traduire ou résumer ces données dans différentes langues. Cette fonction peut être utile si tu dois lire des panneaux dans des langues que tu ne connais pas.

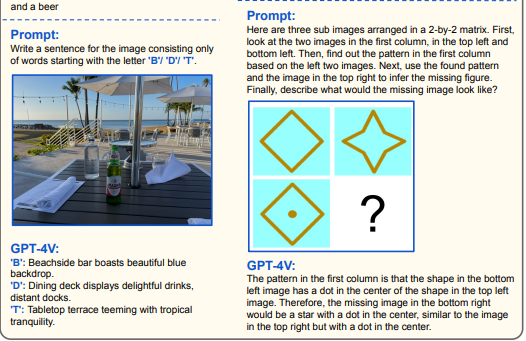

Référence visuelle Promptesse

Pour utiliser efficacement GPT-4V, il est nécessaire d'utiliser la toute nouvelle méthode d'invite que Microsoft appelle Visual Referring Prompting. Cette méthode d'invite te demande de saisir une requête liée à l'image que tu utilises comme entrée.

Tu peux aussi utiliser le modèle GPT-4V avec des questions simples telles que "Décris l'image...". Mais si tu veux repousser ses limites, tu peux aussi lui demander des problèmes mathématiques complexes ou des tâches de codage.

Pointeurs visuels

GPT-4V vise à donner aux utilisateurs la réponse la plus utile en analysant les invites liées au visuel donné. Selon le document de Microsoft, GPT-4V génère des résultats plus efficaces avec des pointeurs visuels dessinés sur des images. Si tu veux analyser des informations dans une zone spécifique de l'image, tu peux obtenir des sorties plus cohérentes en saisissant une invite à l'aide de pointeurs visuels.

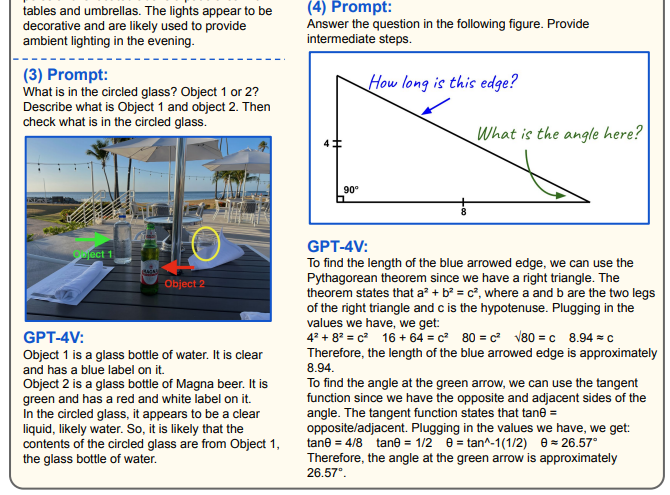

Raisonnement à partir du texte de la scène et du tableau

GPT-4V réussit à reconnaître le texte, les chiffres et les données dans chaque image et à générer une sortie basée sur ces informations. Le modèle GPT-4V analyse l'entrée donnée en la reliant au visuel et répond à la commande ou à la question sur l'invite. Le GPT-4V te permet d'effectuer les tâches suivantes avec une grande précision :

- Mathématiques visuelles

- Compréhension des graphiques et raisonnement

- Reconnaissance des tables

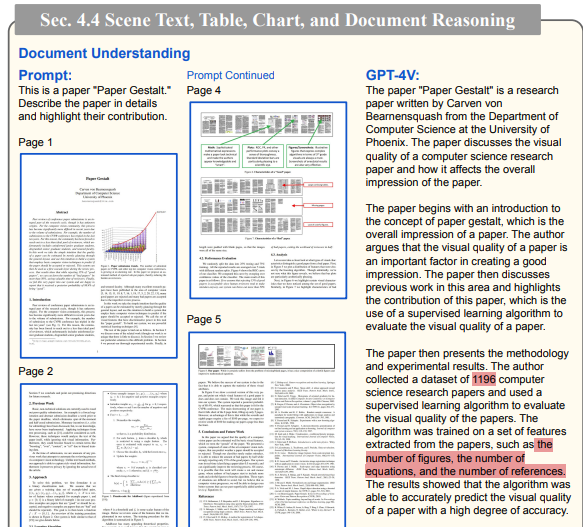

- Compréhension du document

Les chercheurs ont donné au GPT-4V des pages modèles du "Paper Gestalt" en guise d'entrée et lui ont demandé d'analyser toutes les données. GPT-4V a réussi à analyser le papier en grande partie correctement, ne commettant que quelques erreurs.

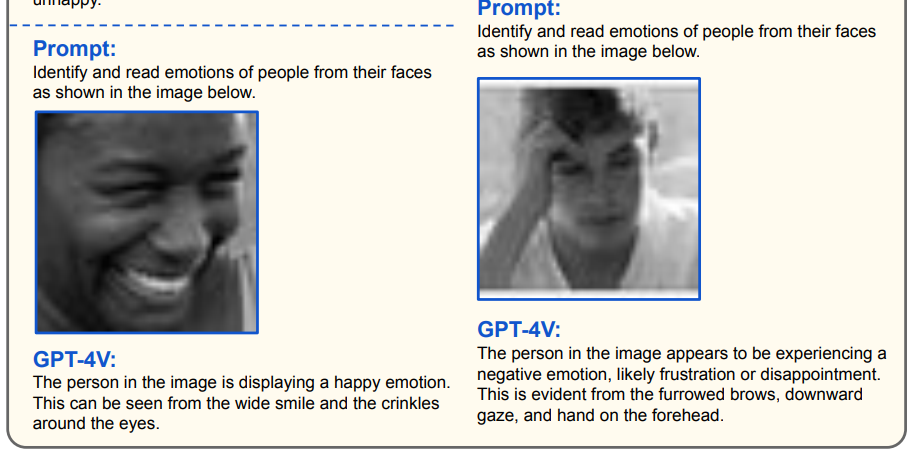

Détection des émotions

Le modèle GPT-4V peut analyser les visages des personnes dans des portraits ou des entrées faciales données et générer des jugements sur leurs émotions. Si tu n'as pas de poker face, on peut dire que l'IA peut t'analyser en comprenant tes émotions. Le modèle GPT-4V réussit particulièrement bien à comprendre sept expressions faciales universelles : le bonheur, la surprise, le mépris, la tristesse, la peur, le dégoût et la colère.

Que peut faire le GPT-4V pour toi ?

Le modèle GPT-4V est accompagné d'améliorations et de caractéristiques impressionnantes qui offrent divers avantages aux utilisateurs. Si tu te demandes ce que le modèle GPT-4V peut faire pour toi, examinons-le ensemble.

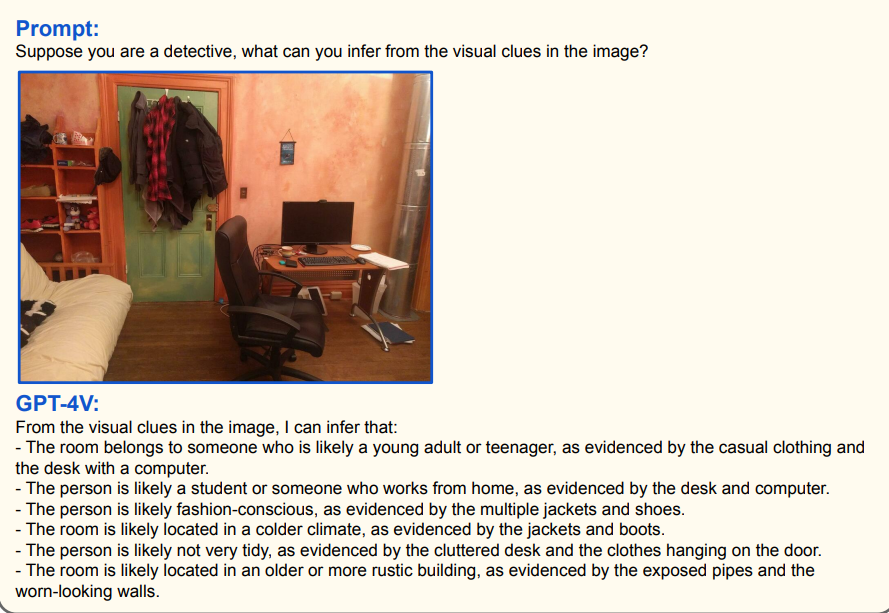

Analyser les images

Le modèle GPT-4V est une IA performante qui analyse les visuels donnés et génère une sortie en fonction de l'invite de l'utilisateur. C'est pourquoi tu peux utiliser le modèle GPT-4V pour résoudre tes problèmes de mathématiques, traduire des livres ou analyser des images pour différents scénarios. Par exemple, en fournissant une image de pièce à GPT-4V, tu peux produire une analyse de détective à propos de cette image.

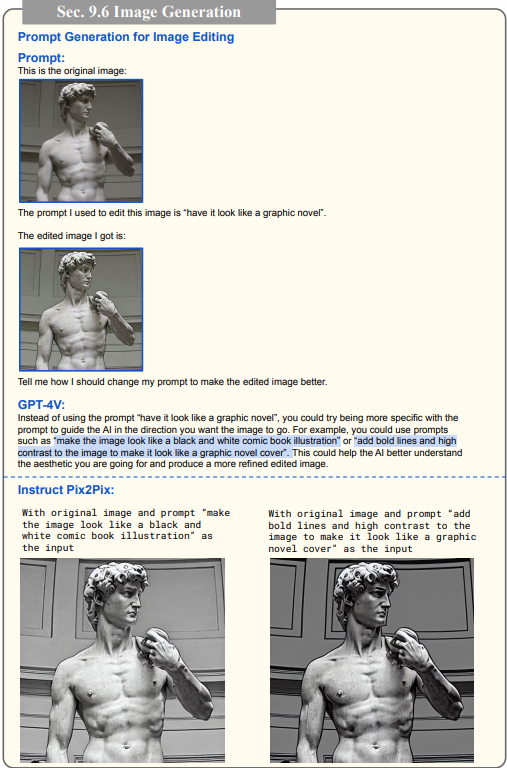

Génération/édition d'invites d'images

En fournissant une image et une exigence textuelle au modèle GPT-4V, tu peux obtenir un message-guide qui te permettra de modifier ton image comme tu le souhaites. Si tu veux passer à la vitesse supérieure et obtenir de l'aide pour rédiger des messages-guides, le modèle GPT-4V est fait pour toi.

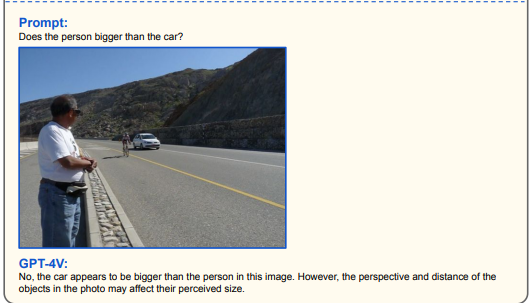

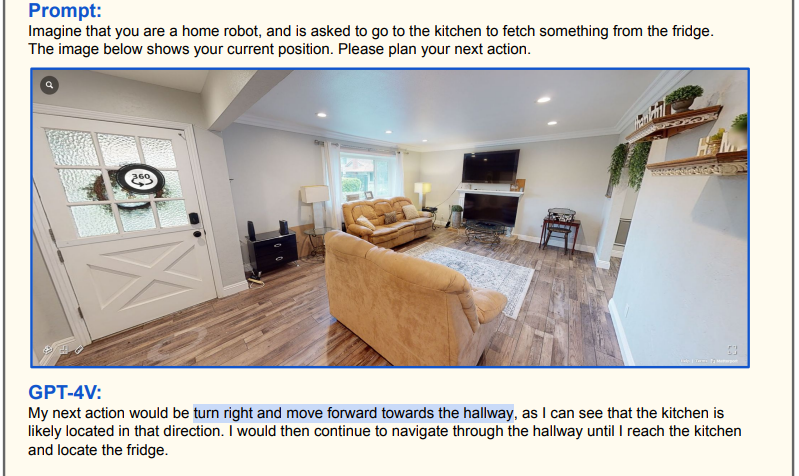

Navigation

Tu peux obtenir un résultat de navigation en donnant une image de pièce, de rue ou d'autoroute au modèle GPT-4V. Par exemple, tu peux donner à GPT-4V l'image d'une pièce et l'inviter à se rendre à n'importe quel point de l'image, de façon à ce qu'il puisse dessiner un itinéraire et produire une sortie au format texte.

Si tu développes un robot et que tu participes à des concours ou des festivals de technologie, tu peux rendre ton robot plus intelligent en utilisant le GPT-4V.

Analyse vidéo

Dans le monde d'aujourd'hui, l'une des méthodes les plus efficaces pour apprendre un nouveau sujet ou obtenir des informations sur un sujet est de regarder des vidéos informatives. Cependant, si tu ne veux pas regarder des vidéos pendant des heures pour obtenir des informations, tu peux analyser la vidéo à l'aide du modèle GPT-4V. GPT-4V peut analyser des images données et générer des descriptions détaillées et cohérentes.

TextCortex AI - Ton assistant interactif

TextCortex est un assistant IA qui offre diverses fonctionnalités telles que la génération de texte, la réécriture de texte à la voix et la recherche sur le web. Il est disponible sous forme d'application web et de navigateur extension. Le navigateur TextCortex extension est intégré à plus de 20 000 sites web et applis, il peut donc continuer à t'assister partout et à tout moment sur internet.

En plus de ses fonctionnalités d'écriture, TextCortex propose également ZenoChat, l'alternative européenne de ChatGPT. De plus, notre équipe travaille à ajouter des technologies d'IA émergentes à TextCortex et à mettre les capacités des grands modèles multimodaux (LMM) à la disposition de nos utilisateurs. Clique ici pour créer ton compte freemium TextCortex et découvrir les dernières fonctionnalités de l'IA !

%20(11).png)

%20(21).png)