Meta AI hat mit der Ankündigung des Modells Llama 3 am 18. April 2024 ein LLM vorgestellt, das sich der aktuellen KI-Technologie annähert. Obwohl das LLama 3-Modell fortschrittlicher ist als sein Vorgänger, das LLama 2-Modell, ist es insgesamt ein Konkurrent für mittlere große Sprachmodelle wie GPT-3.5 und Claude 3 Sonnet. Das LLama 3-Modell von Meta AI verspricht im Vergleich zu seinem Vorgänger ein verbessertes Denken, trainiertere Daten und ein besseres Sprachverständnis. Wenn Sie sich über das Modell Llama 3 wundern, sind Sie hier genau richtig!

In diesem Artikel werden wir das Modell Llama 3 und seine Funktionen gemeinsam untersuchen.

Wenn Sie bereit sind, lassen Sie uns beginnen!

TL; DR

- Das Llama 3-Modell ist ein großes Sprachmodell, das von Meta AI entwickelt und am 18. April 2024 angekündigt wurde.

- Llama 3 ist in zwei Modellgrößen erhältlich, die für unterschiedliche Anwendungsfälle geeignet sind: 8B und 70B.

- Sie können die offizielle Website von Meta AI besuchen, um auf das Modell Llama 3 zuzugreifen, aber Llama 3 ist derzeit nicht in allen Ländern verfügbar.

- Wenn Sie weltweit auf das Modell Llama 3 zugreifen möchten, können Sie ZenoChat von TextCortex ist dein Retter.

- Das Modell Llama 3 hat es geschafft, seine Konkurrenten Gemini Pro 1.5 und Claude 3 Sonnet in Benchmarks zu übertreffen.

- Das Lama-3-Modell wird mit speziell gefilterten, qualitativ hochwertigen, öffentlich zugänglichen Daten trainiert.

- Wenn Sie auf der Suche nach einer besseren Konversations-KI als Llama 3 sind, ist ZenoChat von TextCortex ist mit seinen Anpassungsoptionen und Text- und Bildausgabemöglichkeiten für Sie konzipiert.

Meta AI's Llama 3 Test

Das Llama 3-Modell ist ein großes Sprachmodell, das von Meta AI am 18. April 2024 eingeführt wurde. Das Modell Llama 3 bietet im Vergleich zu seinem Vorgänger verbesserte Funktionen und Leistungserzeugungsmöglichkeiten. Das Modell Llama 3 zielt darauf ab, mit verbessertem logischem Denken, fein abgestimmtem Sprachverständnis und neuen Funktionen modernste Leistung in einer Vielzahl von Branchen zu bieten.

Ein weiteres Ziel von Meta AI bei der Entwicklung des Lama-3-Modells ist es, seine Hilfsbereitschaft zu verbessern. Meta AI zielte darauf ab, die Effizienz des Llama 3-Modells zu steigern, indem es der Community und den KI-Entwicklern während der Entwicklung vorgestellt wurde. Zu den Zukunftsplänen von Meta AI für das Llama 3-Modell gehören die Mehrsprachigkeit und Multimodalität, die Vergrößerung des Kontextfensters und die Verbesserung der Leistung.

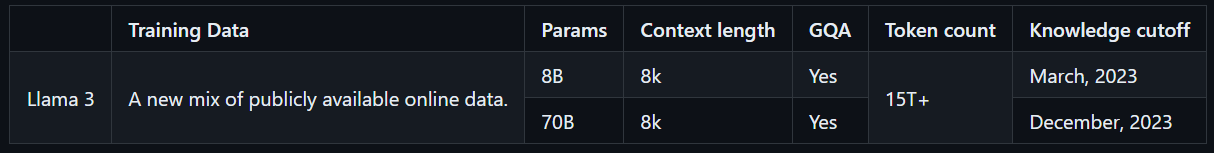

Lama 3 Modellgrößen

Llama 3 ist in zwei Modellgrößen erhältlich, die für unterschiedliche Anwendungsfälle geeignet sind: 8B und 70B. Das Modell Llama 3 8B ist mit insgesamt 8 Milliarden Parametern kompakter und kann schneller Leistung erzeugen. Das Modell Llama 3 70B hingegen verfügt über insgesamt 70 Milliarden Parameter und eignet sich für komplexe Aufgabenstellungen. Darüber hinaus wird das Lama-3-8B-Modell bis März 2023 mit öffentlich zugänglichen Online-Daten trainiert, während das Lama-3-70B-Modell bis Dezember 2023 mit öffentlich zugänglichen Online-Daten trainiert wird.

Wie greife ich auf Llama 3 zu?

Um auf das Llama 3-Modell zuzugreifen, können Sie die offizielle Website von Meta AI besuchen, auf die Schaltfläche "Erste Schritte" klicken und den Schritten folgen. Da das Llama 3-Modell jedoch nicht weltweit zugänglich ist, hat es im Gegensatz zu anderen LLMs einen niedrigen Verfügbarkeitswert. Es gibt jedoch Möglichkeiten, das Modell Llama 3 weltweit zu erleben.

Mit ZenoChat von TextCortexkönnen Sie auf beide Größen des Modells Llama 3 zugreifen und diese ohne Einschränkungen erleben. ZenoChat wird neben GPT-4, Sophos 2, Mixtral, Claude 3 Opus und Sonnet LLMs auch Llama 3, 8B und 70B LLMs unterstützen. Das heißt, Sie können das Llama 3-Modell ohne die Länderbeschränkungen von Meta AI frei erleben.

Die Kernfunktionen von Lama 3 von Meta AI

Llama 3, das neueste und fortschrittlichste Modell von Meta AI, verfügt über eine höhere Leistung und neue Funktionen als sein Vorgänger. Das Modell Llama 3 wurde nicht als Konkurrent zu High-End-LLMs wie GPT-4 und Gemini Ultra eingeführt, sondern zu häufiger verwendeten Modellen wie GPT-3.5 und Gemini Pro. Werfen wir einen genaueren Blick auf die Kernfunktionen von Llama 3.

Leistung des Modells

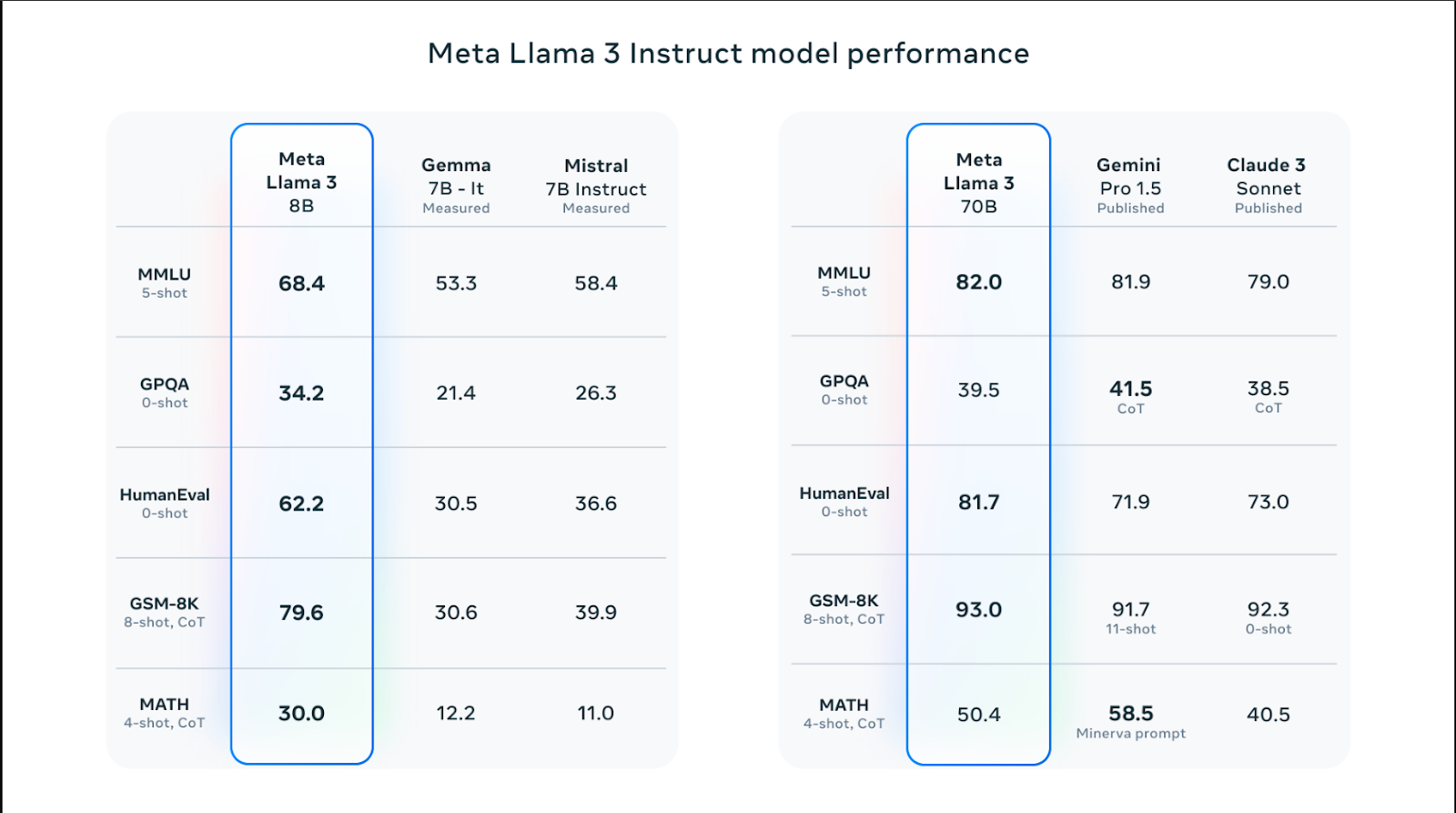

Lama 3-Modelle gibt es in verschiedenen Größen und haben eine bessere Leistung als Lama 2-Modelle in Bezug auf Fähigkeiten wie logisches Denken, Codegenerierung, Mathematik und Befolgen von Anweisungen. Unter den Lama-3-Modellen übertraf das 70B-Modell beliebte Modelle wie Claude 3 Sonnet und Gemini Pro 1.5 mit einem Wert von 82,0 im MMLU-Benchmark. Die Llama 3-Modelle schneiden jedoch in allen Benchmarks besser ab als die Modelle Claude 3 Sonnet und Gemini Pro 1.5, mit Ausnahme des MATH-Benchmarks, der mathematische Fähigkeiten misst, und des GPQA, der die Q&A-Ergebnisse auf Hochschulebene misst.

Das Modell Llama 3 8B hat es geschafft, seine Konkurrenten Gemma 7B und Mistral 7B in den Benchmarks Humaneval, MMLU, GPQA, GSM-8K und MATH zu übertreffen. Mit anderen Worten, die Modellgrößen von Llama 3 haben eine höhere Leistung als ihre Konkurrenzmodelle.

Trainingsdaten

Das Llama 3-Modell wurde mit einer großen Datenmenge trainiert, die für die Erstellung eines leistungsstarken Large Language Model von entscheidender Bedeutung ist. Konkret wurde es mit 15 Billionen Token aus öffentlich zugänglichen Quellen trainiert - 7-mal mehr als die Datenmenge, die zum Trainieren des Lama-2-Modells verwendet wurde.

Darüber hinaus wurde das Lama-3-Modell mit einem qualitativ hochwertigen Datensatz trainiert, der aus 30 verschiedenen Sprachen außer Englisch besteht. Dies hat zu einer deutlichen Steigerung des Sprachverständnisses, der Kreativität und der Fähigkeiten des Modells geführt, der Aufforderung zu folgen.

Das Meta AI-Team hat eine Reihe von Datenfilter-Pipelines entwickelt, um das Lama-3-Modell mit qualitativ hochwertigen und zuverlässigen Daten zu trainieren. Zu diesen Filtern gehören Parameter wie der NSFW-Filter, der heuristische Filter, der semantische Deduplizierungsansatz und der Textklassifikator. Da das Lama-2-Modell außerdem gut darin ist, qualitativ hochwertige Daten zu identifizieren, wurde es verwendet, um die trainierten Daten des Lama-3-Modells zu filtern.

Optimierung

Die Llama 3-Modelle sind speziell für häufig verwendete GPU- und CPU-Modelle und -Marken optimiert. Je mehr Software für bestimmte Hardware optimiert ist, desto höher ist die Leistung und desto schneller wird sie ausgeführt. Das Modell Llama 3 ist für Intel-, AMD- und Nvidia-Hardware optimiert. Darüber hinaus hat Intel einen ausführlichen Leitfaden zur Leistung des Lama-3-Modells veröffentlicht.

Sicherheit

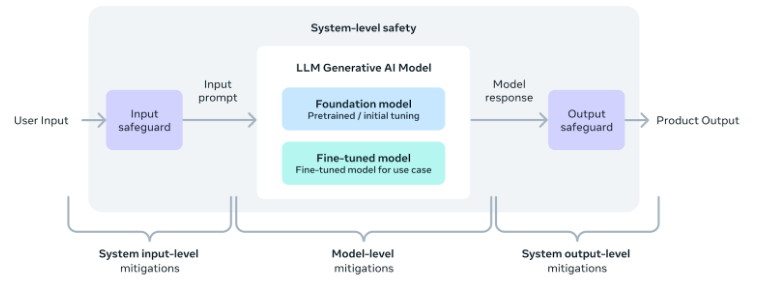

Das KI-Team von Meta ist sich der Bedeutung der sicheren Nutzung von KI-Tools und -Software bewusst, einschließlich des Modells Llama 3. Dementsprechend wurden während der Entwicklung des Modells Sicherheitsparameter hinzugefügt, um sicherzustellen, dass seine Ausgabe sicher, unschädlich und ethisch einwandfrei ist.

Darüber hinaus hat das Team auch einen Leitfaden zur Implementierung der Sicherheit auf Systemebene für diejenigen bereitgestellt, die Anwendungen mit dem Llama 3-Modell entwickeln möchten. Mit diesen Maßnahmen können Benutzer den Komfort und die Vorteile von KI-Tools genießen und sie gleichzeitig sicher und verantwortungsbewusst nutzen.

Eine bessere Alternative: ZenoChat von TextCortex

Wenn Sie auf der Suche nach einem anpassbaren KI-Assistenten mit Zugriff auf verschiedene LLMs sind, einschließlich des Modells Llama 3, ist ZenoChat von TextCortex ist für Sie konzipiert. ZenoChat ist ein KI-Tool, das seinen Nutzern die Vorteile verschiedener LLMs bietet und diese nicht auf einen einzigen LLM beschränkt. ZenoChat zielt darauf ab, seine Nutzer bei professionellen und täglichen Aufgaben wie Texterstellung, Paraphrasierung und Recherche zu unterstützen. Mit ZenoChat können Sie jede Aufgabe um das 12-fache beschleunigen, Ihre Arbeitsbelastung reduzieren und Ihre Produktivität in die Höhe treiben.

ZenoChat ist als Webanwendung und Browser verfügbarextension. Der ZenoChat-Browser extension ist in 30.000+ Websites und Apps integriert. So kann es Sie weiterhin überall und jederzeit unterstützen.

Arbeiten Sie mit Ihrem eigenen Wissen und Ihren eigenen Daten

ZenoChat bietet dank unserer Funktionen "Wissensdatenbanken" und "Individuelle Personas" ein vollständig anpassbares KI-Erlebnis. Mit unserer Funktion "Individuelle Personas" können Sie den Ausgabestil, die Satzlänge, die dominante Emotion in Sätzen und die Persönlichkeit von ZenoChat nach Belieben anpassen. Mit anderen Worten, Sie können diese Funktion nutzen, um ZenoChat zu Ihrem persönlichen Assistenten oder Ihrem digitalen Zwilling zu machen.

Unsere Funktion "Wissensdatenbanken" ermöglicht es Ihnen, Datenquellen hochzuladen oder zu verbinden , die ZenoChat zum Generieren von Ausgaben verwendet. Mit dieser Funktion können Sie ZenoChat mit Ihren eigenen Daten trainieren und für bestimmte Anwendungsfälle geeignet machen. Darüber hinaus können Sie dank dieser Funktion Hunderte von Seiten an Dokumenten mit einer einzigen Eingabeaufforderung zusammenfassen oder mit Ihren PDFs chatten. Unsere Funktion "Wissensdatenbanken" verfügt auch über eine Schaltfläche, mit der Sie Ihr Google Drive oder Microsoft OneDrive in Sekundenschnelle integrieren können.

%20(8).png)

%20(15).png)

%20(14).png)