Meta AI introduziu um LLM que se aproxima da tecnologia de IA atual ao anunciar o modelo Llama 3 em 18 de abril de 2024. Embora o modelo LLama 3 seja mais avançado do que seu antecessor, o modelo LLama 2, é geral um concorrente do Large Language de nível médio Modelos como GPT-3.5 e Claude 3 Sonnet. O modelo LLama 3 da Meta AI promete raciocínio aprimorado, dados mais treinados e compreensão da linguagem em comparação com seu antecessor. Se você está se perguntando sobre o modelo Llama 3, você está no lugar certo!

Neste artigo, exploraremos juntos o modelo Llama 3 e seus recursos.

Se estás pronto, vamos começar!

TL; DR

- O modelo Llama 3 é um modelo de linguagem grande desenvolvido pela Meta AI e anunciado em 18 de abril de 2024.

- O Llama 3 vem em dois tamanhos de modelo adequados para diferentes casos de uso: 8B e 70B.

- Você pode visitar o site oficial da Meta AI para acessar o modelo Llama 3, mas o Llama 3 não está disponível atualmente em todos os países.

- Se você deseja acessar o modelo Llama 3 em todo o mundo, ZenoChat por TextCortex é o seu salvador.

- O modelo Llama 3 conseguiu superar seus rivais, os modelos Gemini Pro 1.5 e Claude 3 Sonnet, em benchmarks.

- O modelo Llama 3 é treinado com dados publicamente disponíveis, especialmente filtrados e de alta qualidade.

- Se você está procurando uma IA de conversação melhor do que o Llama 3, o ZenoChat da TextCortex foi projetado para você com suas opções de personalização e recursos de saída de texto e imagem.

Revisão do Lhama 3 da Meta AI

O modelo Llama 3 é um modelo de linguagem grande introduzido pela Meta AI em 18 de abril de 2024. O modelo Llama 3 oferece recursos aprimorados e capacidades de geração de saída em comparação com seu antecessor. O modelo Llama 3 visa oferecer desempenho de última geração em uma ampla gama de setores com raciocínio aprimorado, compreensão de linguagem aprimorada e novos recursos.

Outro objetivo da Meta AI ao desenvolver o modelo Llama 3 é melhorar sua utilidade. A Meta AI teve como objetivo aumentar a eficiência do modelo Llama 3, divulgando-o para a comunidade e desenvolvedores de IA enquanto estava em desenvolvimento. Os planos futuros da Meta AI para o modelo Llama 3 incluem torná-lo multilíngue e multimodal, aumentando a janela de contexto e melhorando seu desempenho.

Tamanhos de modelo de lhama 3

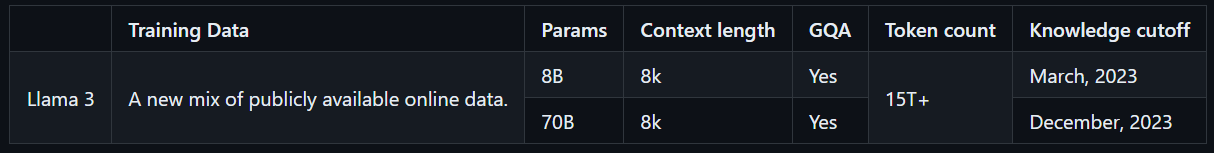

O Llama 3 vem em dois tamanhos de modelo adequados para diferentes casos de uso: 8B e 70B. O modelo Llama 3 8B é mais compacto, com um total de 8 bilhões de parâmetros, e pode gerar resultados mais rapidamente. Por outro lado, o modelo Llama 3 70B possui um total de 70 bilhões de parâmetros e é adequado para tarefas complexas. Além disso, o modelo Llama 3 8B é treinado com dados online disponíveis publicamente até março de 2023, enquanto o modelo Llama 3 70B é treinado com dados online disponíveis publicamente até dezembro de 2023.

Como acessar o Lhama 3?

Para acessar o modelo Llama 3, você pode visitar o site oficial da Meta AI , clicar no botão “Começar” e seguir os passos. Porém, como o modelo Llama 3 não é acessível em todo o mundo, ele apresenta uma baixa pontuação de disponibilidade, diferentemente de outros LLMs. No entanto, existem maneiras de experimentar o modelo Llama 3 em todo o mundo.

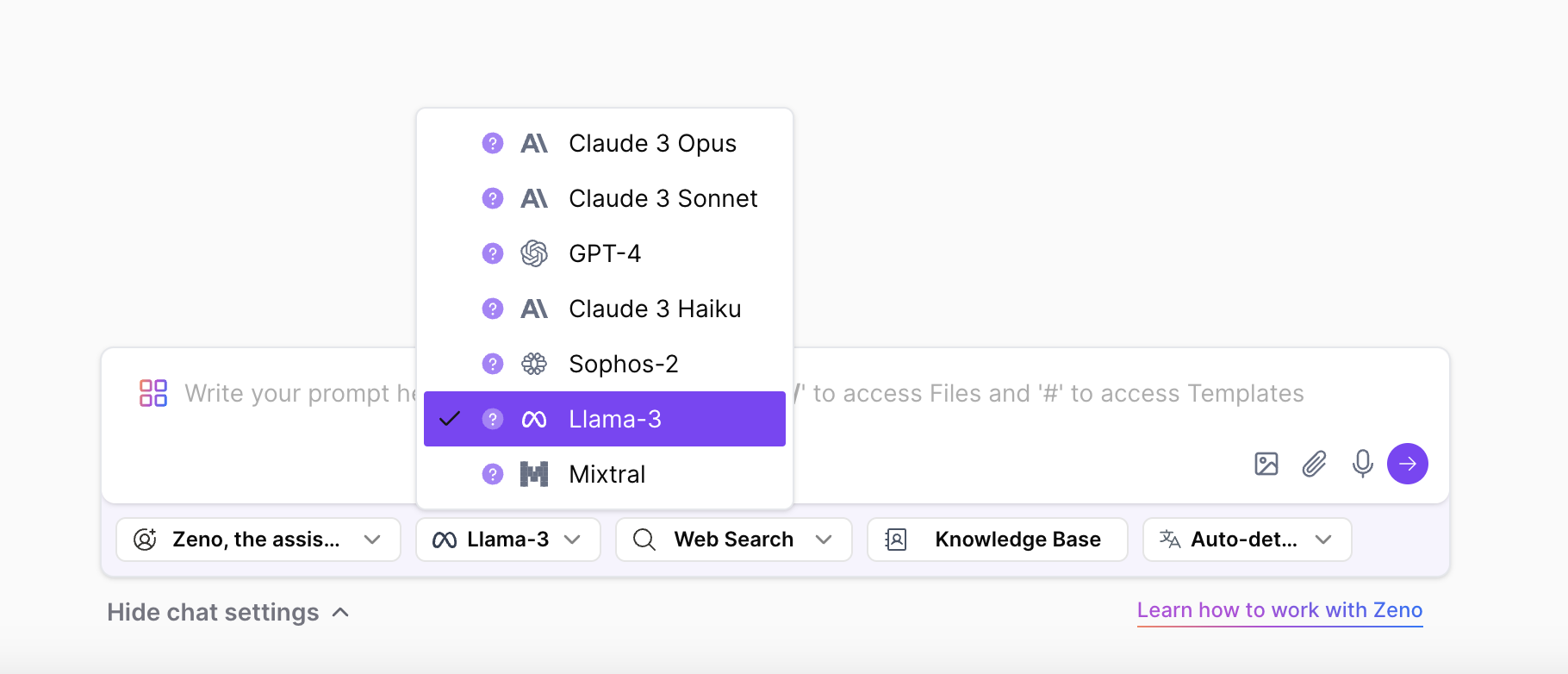

Com ZenoChat por TextCortex , você pode acessar e experimentar os dois tamanhos do modelo Llama 3 sem limites. ZenoChat suportará LLMs Llama 3 8B e 70B, além de LLMs GPT-4, Sophos 2, Mixtral, Claude 3 Opus e Sonnet. Dito isso, você pode experimentar livremente o modelo Llama 3 sem as restrições de país da Meta AI.

Recursos principais do Llama 3 do Meta AI

O Llama 3, o modelo mais novo e avançado da Meta AI, possui desempenho superior e novos recursos que seu antecessor. O modelo Llama 3 foi apresentado como um concorrente não de LLMs de última geração, como GPT-4 e Gemini Ultra, mas de modelos usados com mais frequência, como GPT-3.5 e Gemini Pro. Vamos dar uma olhada mais de perto nos principais recursos do Llama 3.

Desempenho do modelo

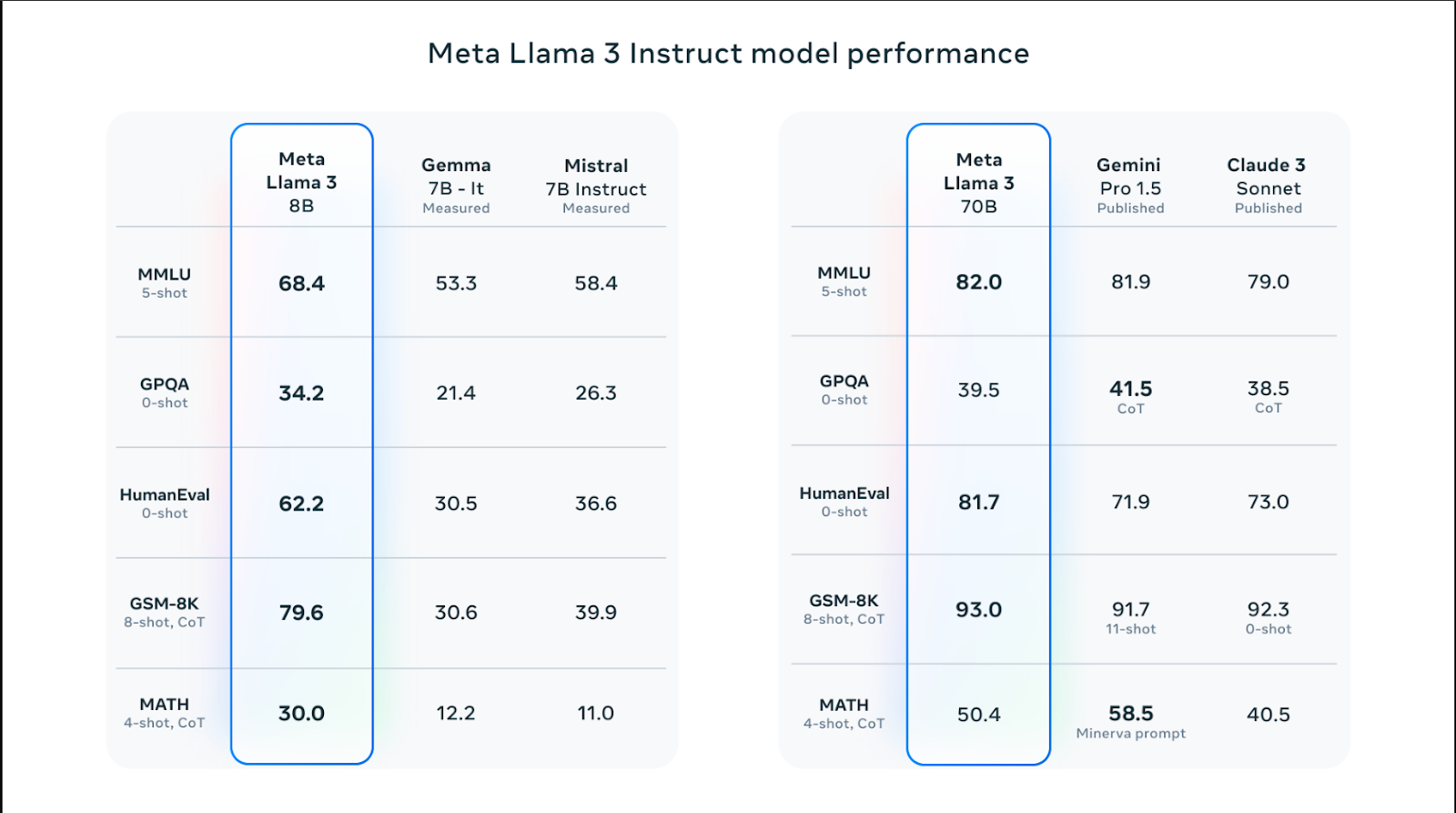

Os modelos Llama 3 vêm em tamanhos diferentes e têm melhor desempenho do que os modelos Llama 2 em habilidades como raciocínio, geração de código, matemática e acompanhamento de instruções. Entre os modelos Llama 3, o modelo 70B superou modelos populares como Claude 3 Sonnet e Gemini Pro 1.5 com pontuação de 82,0 no benchmark MMLU. No entanto, os modelos Llama 3 apresentam desempenho melhor do que os modelos Claude 3 Sonnet e Gemini Pro 1.5 em todos os benchmarks, exceto no benchmark MATH, que mede habilidades matemáticas, e no GPQA, que mede pontuações de perguntas e respostas em nível de pós-graduação.

O modelo Llama 3 8B conseguiu superar seus modelos rivais Gemma 7B e Mistral 7B nos benchmarks Humaneval, MMLU, GPQA, GSM-8K e MATH. Em outras palavras, os tamanhos dos modelos Llama 3 têm desempenho superior aos modelos rivais.

Dados de treinamento

O modelo Llama 3 foi treinado com uma grande quantidade de dados, o que é fundamental para a construção de um modelo de linguagem grande de alto desempenho. Especificamente, ele foi treinado com tokens de 15T de fontes disponíveis publicamente – 7 vezes mais do que a quantidade de dados usada para treinar o modelo Llama 2.

Além disso, o modelo Llama 3 foi treinado com um conjunto de dados de alta qualidade composto por 30 idiomas diferentes além do inglês. Isso resultou em um aumento significativo na compreensão da linguagem, na criatividade e nas habilidades de acompanhamento imediato do modelo.

A equipe Meta AI desenvolveu uma série de pipelines de filtragem de dados para treinar o modelo Llama 3 com dados confiáveis e de alta qualidade. Esses filtros incluem parâmetros como filtro NSFW, filtro heurístico, abordagem de desduplicação semântica e classificador de texto. Além disso, como o modelo Llama 2 é bom na identificação de dados de alta qualidade, ele foi utilizado para filtrar os dados treinados do modelo Llama 3.

Otimização

Os modelos Llama 3 são especialmente otimizados para modelos e marcas de GPU e CPU usados com frequência. Quanto mais o software for otimizado para hardware específico, maior será o desempenho e mais rápido ele será executado. O modelo Llama 3 é otimizado para hardware Intel, AMD e Nvidia. Além disso, a Intel publicou um guia detalhado sobre o desempenho do modelo Llama 3.

Segurança

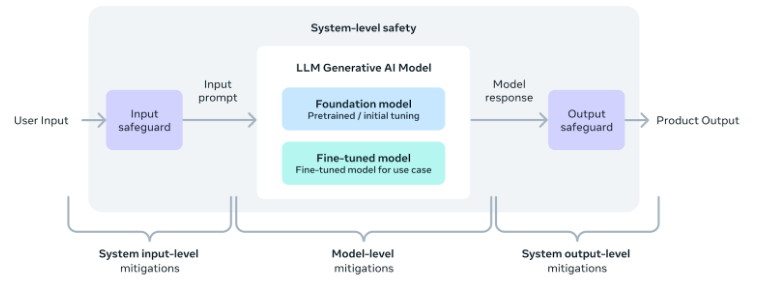

A equipe Meta AI reconhece a importância do uso seguro de ferramentas e software de IA, incluindo o modelo Llama 3. Conseqüentemente, parâmetros de segurança foram adicionados durante o desenvolvimento do modelo para garantir que seu resultado seja seguro, inofensivo e ético.

Além disso, a equipe também forneceu um guia de implementação de segurança em nível de sistema para aqueles que desejam desenvolver aplicações usando o modelo Llama 3. Com estas medidas em vigor, os utilizadores podem desfrutar da conveniência e dos benefícios das ferramentas de IA, ao mesmo tempo que as utilizam de forma segura e responsável.

Uma alternativa melhor: ZenoChat por TextCortex

Se você está procurando um assistente de IA personalizável com acesso a vários LLMs, incluindo o modelo Llama 3, o ZenoChat da TextCortex foi projetado para você. ZenoChat é uma ferramenta de IA que oferece aos seus usuários as vantagens de diferentes LLMs e não os limita a um único LLM. ZenoChat tem como objetivo auxiliar seus usuários em tarefas profissionais e cotidianas como geração de texto, paráfrase e pesquisa. Com o ZenoChat, você pode acelerar qualquer tarefa em 12x, reduzir sua carga de trabalho e aumentar sua produtividade.

ZenoChat está disponível como aplicativo da web e navegador extension . O navegador ZenoChat extension está integrado a mais de 30.000 sites e aplicativos. Assim, ele pode continuar a apoiá-lo em qualquer lugar e a qualquer hora.

Trabalhe com seu próprio conhecimento e dados

ZenoChat oferece uma experiência de IA totalmente personalizável graças aos nossos recursos "Bases de Conhecimento" e "Personas Individuais". Nosso recurso "Personas Individuais" permite que você ajuste o estilo de saída do ZenoChat, o comprimento das frases, a emoção dominante nas frases e a personalidade conforme desejar. Em outras palavras, você pode usar esse recurso para transformar o ZenoChat em seu assistente pessoal ou gêmeo digital.

Nosso recurso "Bases de Conhecimento" permite que você carregue ou conecte fontes de dados que o ZenoChat usará para gerar resultados. Ao usar esse recurso, você pode treinar o ZenoChat com seus próprios dados e torná-lo adequado para casos de uso específicos. Além disso, graças a esse recurso, você pode resumir centenas de páginas de documentos com um único prompt ou conversar com seus PDFs. Nosso recurso "Bases de Conhecimento" também possui um botão que permite integrar seu Google Drive ou Microsoft OneDrive em segundos.

%20(8).png)