Creatieve inhoud API van het web

Of u nu een softwarebedrijf bent dat een echte toegevoegde waarde wil voor zijn eindgebruikers, of tekstclassificatie en -generatie op grote schaal nodig heeft.

Bent u klaar om uw workflowproductiviteit te 4x verhogen met de kracht van grote taalmodellen? Zonder alle pijn van de infrastructuur?

Maak uw workflow slim met natuurlijke taalverwerking, generatie en machinale creativiteit.

Geen omgevingsproblemen, geen GPU tekorten, geen prompting problemen, geen overbelaste servers, geen parameter optimalisatie.

Alleen pure NLP kracht voor uw workflows en producten. Zodat u zich kunt concentreren op het product dat u naar buiten wilt brengen.

Elke oplossing is een eenvoudige integratie van een API eindpunt in uw codebase.

Wij helpen je het juiste prijsmodel voor je taak te vinden

KIES UW MODEL

Zoveel modellen en ze hebben allemaal hun eigen karakter. Wij helpen u bij het kiezen van de beste werkmodellen voor uw workflow. Binnen het NeoCortex systeem zijn er 4 categorieën.

Waarbij Velox de snelste modellen zijn en Alta de krachtigste. Sophos modellen zijn onze verfijnde NeoCortex expert modellen voor zeer gespecialiseerde workflows.

Deze modellen kunnen worden gebruikt voor verschillende doeleinden, waaronder classificatie, entiteit extractie, samenvatten, inhoud genereren, code generatie, parafraseren, en nog veel meer.

Velox

Aecus

Alta

Sophos

Korte beschrijving

de snelle

de evenwichtige

de sterke

de expert

Prijs per 1K Tokens

$0.01

$0.02

$0.04

$0.12

Meertalige Toeslag

(Prijs per 1K Tokens)

+$0.12

+$0.12

+$0.12

+$0.12

Fijnafstemming

op verzoek

op verzoek

op verzoek

op verzoek

Specifieke GPU's

op verzoek

op verzoek

op verzoek

op verzoek

Parameter Grootte

Tot 5 miljard

Tot 19 miljard

Meer dan 20 miljard

-

Got data? Let’s bring your models to the next level

FINE-TUNING - IMPROVE PERFORMANCE AND EFFICIENCY

Out of the box models are not made for your specific pain points?

That’s why we help you nail them down to what you need. With fine-tuned models on your data and workflow we can achieve better results while reducing overall costs in a number of tasks.

A small set of 100 examples can:

- improve task performance by 10x

- lead to 28% cost reduction

.png)

Breng uw eigen model mee

Aan het eind van de weg geraakt met je optimalisatie?

Het lukt je niet om een groter model op je infrastructuur te zetten. Wij helpen je om je eigen model te hosten en de lopende optimalisatie aan te pakken.

- Neemt 70% van het werk van tekstcreatie weg

- Tekstgeneratie aanpassen aan uw gebruikers, industrie en niche

- Voeg een onverslaanbare tijdsbesparing toe aan uw waardevoorstel

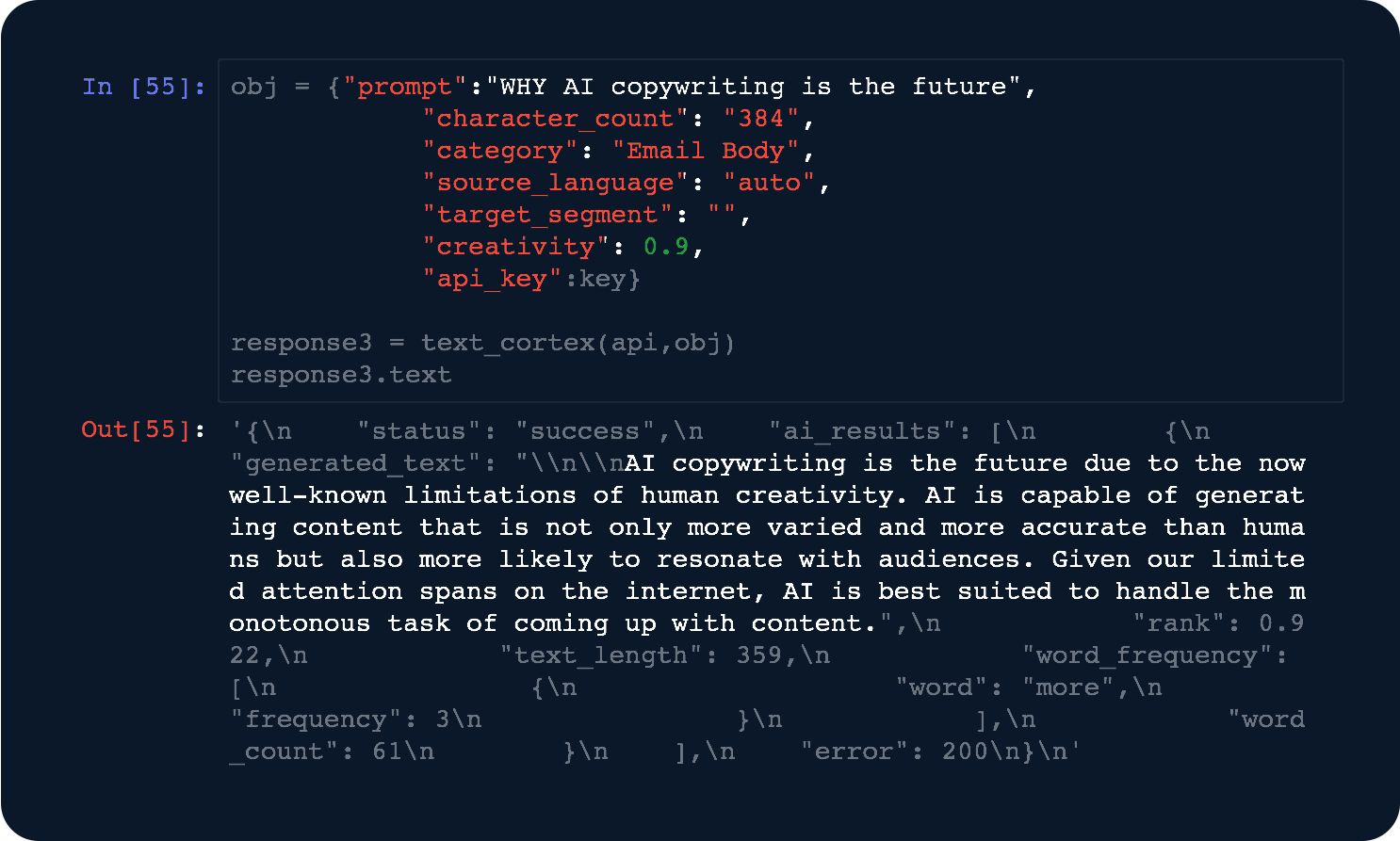

Krachtige en gebruiksvriendelijke API's

DEVELOPERS AT HEART

Van ontwikkelaars voor ontwikkelaars. Word geïntegreerd in onze API in minder dan 3 regels code.

- Geavanceerde optimalisaties - Wij passen de modellen voortdurend aan om de beste reactiesnelheden te bereiken.

- Speciale berekeningen - Profiteer van hogere prestaties met speciale rekenkracht.

Maak uw workflow slim

Op zoek naar een dienst om je grote taalmodel te hosten als API? Worstel je om een groter model op je infrastructuur te maken?

Wij helpen je om je eigen model te hosten en de lopende optimalisatie af te handelen.

Tekst herschrijven API

Geef uw workflow of uw gebruikers de macht om eindeloos alles te herschrijven.

Tekstsamenvatting API

Vat alles in uw workflow samen om het gemakkelijker te kunnen verwerken.

Visuele generatie API

Gebruik Stable Diffusion om visuele concepten te maken in uw workflow.

Enkele van de meest gestelde vragen

Een token is de industrieterm voor het volume waarmee onze modellen werken. Van de input die u hen geeft om mee te werken tot de output die zij voor u genereren.

Zie ze als betalen voor de liters water die u verbruikt uit uw stadssysteem en er weer in afvoert.

Tokens zijn een vorm van meting die kan worden uitgedrukt in verschillende eenheden, zoals 1 liter water hetzelfde is als 1000 milliliter water. Evenzo bestaat 1 token uit 4 karakters.

BTW wist je dat het gemiddelde woord uit 4,5 tekens bestaat? Dus 1 token is bijna een woord!

Om dit alles nog eens in perspectief te plaatsen. De tekst tot hier heeft ongeveer 670 karakters, 124 woorden en maakt ruwweg 169 tokens.

Als Alta dit blok gemaakt zou hebben, zou het gekost hebben:

[# totale tokens] x [per token prijs van Alta] = kosten

169 x 0,00002 = 0,0038 USD

Wij werken meestal met onze eigen NeoCortex modellen.

Andere modellen die wij voor u kunnen hosten, optimaliseren en bedienen zijn:

- GPT Neo 2.7 bn.

- GPT-J 6 bn.

- GPT NeoX 20 bn.

- OPT: Open Pre-trained Transformer Language Models (125M tot 66 bn.)

- FairSeq (13 bn.)

- CodeGen (16 bn.)

- Bloom 560m

- Bloom 1.1 bn.

- Bloom 1.7 bn.

- Bloom 3 bn.

- Bloom 7,1 bn.

- Bloom 176 bn. (binnenkort beschikbaar)

- t5 Small

- t5 Base

- t5 Large

- t5 3b

- t5 11b

- Stable Diffusion hosted API

Mocht u meer vragen hebben neem dan contact op met ons integratie team.

Wij berekenen uw kosten aan de hand van het aantal input en output tokens waarmee u werkt.

Een generatie taak met ons "Aecus" model voor LongForm is meestal zeer output zwaar.

Denk aan de volgende input prompt:

"De NeoCortex tekst generatie API helpt u in uw workflow" (60 karakter = 15 tokens)

Hier is de eigenlijke output:

"Wat is de NeoCortex?

NeoCortex is een deep learning tekst generatie API, die alleen natuurlijke taal gebruikt om teksten te genereren. De gegenereerde tekst is ontworpen om menselijk leesbaar en begrijpelijk te zijn, wat u helpt in uw workflow. De API is gemakkelijk te leren, met een eenvoudige interface. Dit maakt het perfect voor gebruik door ontwikkelaars die hun eigen applicaties willen maken." (360 tekens = 90 Tokens)

Maakt een totale token count van 15 + 90 = 105 Tokens.

0.02$ gedeeld door 1000 maal 105 = 0.0021 $ zou in rekening worden gebracht voor uw aanvraag.

Ja.

Wanneer u aanmeldt op ons platform en een API key genereert, krijgt u automatisch $5 om onze API's 30 dagen uit te proberen.

Voor hulp rond uw integratie kunt u contact opnemen met ons integratieteam.

Wanneer wij uw modellen verfijnen, nemen wij uw gegevens en leren wij een model hoe het zich moet gedragen en wat er wordt verwacht.

Net als een mooi pak maken wij een tekstgeneratie-, classificatie- en extractiemodel op maat van uw behoeften.

Alles wat wij van u nodig hebben is een dataset met hoogwaardige gegevens uit uw workflow.

Wij zien de eerste verbeteringen bij datasets van slechts 500 waarnemingen.

Mocht u meer vragen hebben, neem dan contact op met ons integratieteam.

Ja.

Basisfuncties vereisen minder dan 3 regels code. Daarom hebben we ook meerdere OSS-pakketten voor eenvoudige integratie(PyPi, NPM-JS).

Bovendien bieden wij u een toegewijde integratieondersteuning voor uw inwerktijd.

Terwijl nieuwkomers ongeveer 4 tot 6 weken nodig hebben om de eerste resultaten te zien. Iemand die op onze infrastructuur overschakelt, vindt zijn weg in minder dan 2 weken tijd.

Wij proberen onze API eindpunten zo vanzelfsprekend mogelijk te houden. We helpen u graag bij het vinden van het beste model.

Als u directe begeleiding zoekt, neem dan contact op met ons integratieteam.

Voor het uitvoeren van grote taalmodellen (LLM) zijn krachtige rekenmachines in de vorm van GPU's nodig.

Het bouwen van de infrastructuur en het onderhouden en optimaliseren ervan brengt hoge kosten met zich mee. Wij zijn er experts in en hebben onze modellen verkleind voor onze producten voor gebruikers waar reactietijden in "ms" belangrijk zijn en kostenoptimalisatie onze margedrijfveer is.

Met TextCortex heeft u het voordeel om te profiteren van ons NeoCortex systeem op twee kostenbesparende manieren:

1) Pay-per-token

Ideaal voor kleinere schaal operaties. Bijvoorbeeld minder dan 100k aanvragen per maand of kleinere modellen met minder dan 10 bn. parameters.

U draait in een gedeelde omgeving met andere klanten.

2) Pay-per-GPU-hour

Ideaal voor grootschalige processen. Bijvoorbeeld miljoenen aanvragen of modellen met meer dan 20 miljard parameters.

U betaalt ons voor het beheer en de hosting van modellen afhankelijk van het vaste actieve GPU-uurtarief dat uw modellen draaien.

Dit is een prioritaire optie waarbij u dedicated resources gebruikt, enkel voor uw geval.

Indien u meer begeleiding wenst, neem dan contact op met ons integratieteam.