Meta AI introduceerde een LLM die de huidige AI-technologie benadert door het Llama 3-model op 18 april 2024 aan te kondigen. Hoewel het LLama 3-model geavanceerder is dan zijn voorganger, het LLama 2-model, is het over het algemeen een concurrent van middelgrote Large Language Models zoals GPT-3.5 en Claude 3 Sonnet. Het LLama 3-model van Meta AI belooft verbeterd redeneren, meer getrainde gegevens en taalbegrip in vergelijking met zijn voorganger. Als je je afvraagt wat het Llama 3-model is, ben je hier aan het juiste adres!

In dit artikel zullen we samen het Llama 3-model en zijn functies verkennen.

Als je er klaar voor bent, laten we dan beginnen!

TL; DR

- Het Llama 3-model is een groot taalmodel ontwikkeld door Meta AI en aangekondigd op 18 april 2024.

- Llama 3 wordt geleverd in twee modelmaten die geschikt zijn voor verschillende gebruiksscenario's: 8B en 70B.

- Je kunt de officiële website van Meta AI bezoeken om toegang te krijgen tot het Llama 3-model, maar Llama 3 is momenteel niet in alle landen beschikbaar.

- Als u wereldwijd toegang wilt tot het Llama 3-model, ZenoChat door TextCortex is uw redder.

- Het Llama 3-model slaagde erin om beter te presteren dan zijn rivalen, Gemini Pro 1.5 en Claude 3 Sonnet-modellen, in benchmarks.

- Het Llama 3-model is getraind met speciaal gefilterde, openbaar beschikbare gegevens van hoge kwaliteit.

- Als u op zoek bent naar een betere conversationele AI dan Llama 3, ZenoChat van TextCortex is voor u ontworpen met zijn aanpassingsopties en tekst- en beelduitvoermogelijkheden.

Meta AI's Llama 3 recensie

Het Llama 3-model is een groot taalmodel dat op 18 april 2024 door Meta AI is geïntroduceerd. Het Llama 3-model biedt verbeterde functies en mogelijkheden voor het genereren van output in vergelijking met zijn voorganger. Het Llama 3-model is bedoeld om state-of-the-art prestaties te bieden in een breed scala van industrieën met zijn verbeterde redenering, verfijnd taalbegrip en nieuwe mogelijkheden.

Een ander doel van Meta AI bij het ontwikkelen van het Llama 3-model is om de behulpzaamheid ervan te verbeteren. Meta AI had tot doel de efficiëntie van het Llama 3-model te vergroten door het tijdens de ontwikkeling bekend te maken aan de gemeenschap en AI-ontwikkelaars. De toekomstplannen van Meta AI voor het Llama 3-model omvatten het meertalig en multimodaal maken, het contextvenster vergroten en de prestaties verbeteren.

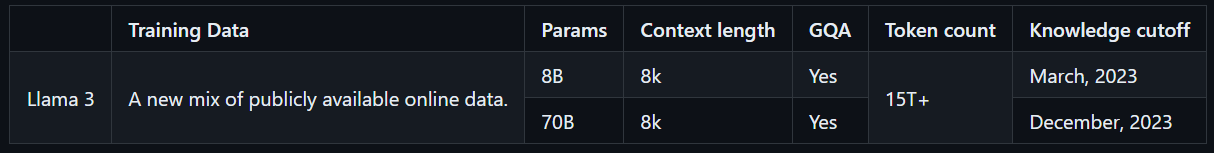

Lama 3 Model Maten

Llama 3 wordt geleverd in twee modelmaten die geschikt zijn voor verschillende gebruiksscenario's: 8B en 70B. Het Llama 3 8B-model is compacter, met in totaal 8 miljard parameters, en kan sneller output genereren. Aan de andere kant heeft het Llama 3 70B-model in totaal 70 miljard parameters en is het geschikt voor complexe taken. Bovendien wordt het Llama 3 8B-model tot maart 2023 getraind met openbaar beschikbare online gegevens, terwijl het Lama 3 70B-model tot december 2023 wordt getraind met openbaar beschikbare online gegevens.

Hoe krijg ik toegang tot Llama 3?

Om toegang te krijgen tot het Llama 3-model, kunt u de officiële website van Meta AI bezoeken, op de knop "Aan de slag" klikken en de stappen volgen. Omdat het Llama 3-model echter niet wereldwijd toegankelijk is, heeft het een lage beschikbaarheidsscore, in tegenstelling tot andere LLM's. Er zijn echter manieren om het Llama 3-model wereldwijd te ervaren.

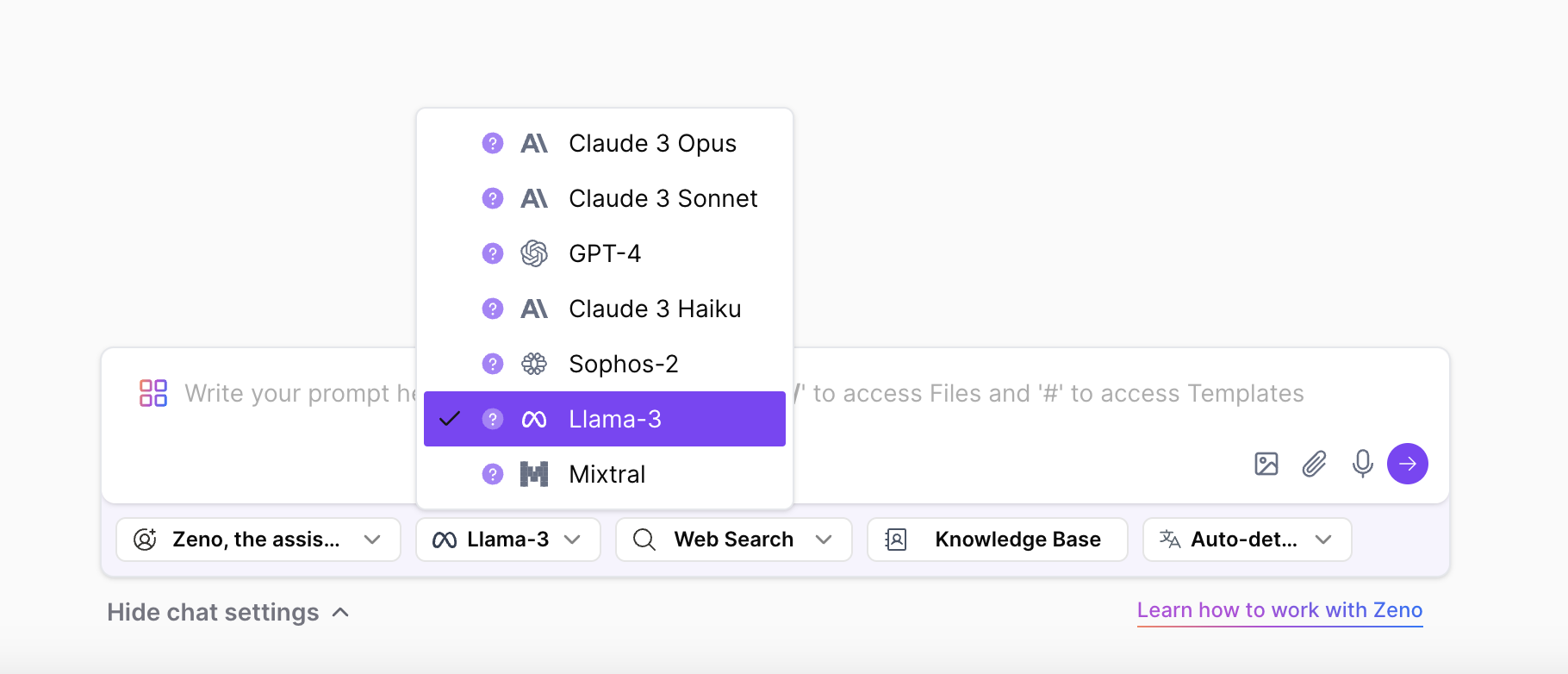

Met ZenoChat van TextCortex, kunt u beide maten van het Llama 3-model onbeperkt openen en ervaren. ZenoChat ondersteunt Llama 3, 8B en 70B LLM's, naast GPT-4, Sophos 2, Mixtral, Claude 3 Opus en Sonnet LLM's. Dat gezegd hebbende, kun je het Llama 3-model vrij ervaren zonder de landbeperkingen van Meta AI.

Meta AI's Llama 3 kernfuncties

Llama 3, het nieuwste en meest geavanceerde model van Meta AI, heeft hogere prestaties en nieuwe functies dan zijn voorganger. Het Llama 3-model werd geïntroduceerd als concurrent, niet van high-end LLM's zoals GPT-4 en Gemini Ultra, maar van vaker gebruikte modellen zoals GPT-3.5 en Gemini Pro. Laten we de kernfuncties van Llama 3 eens nader bekijken.

Prestaties van het model

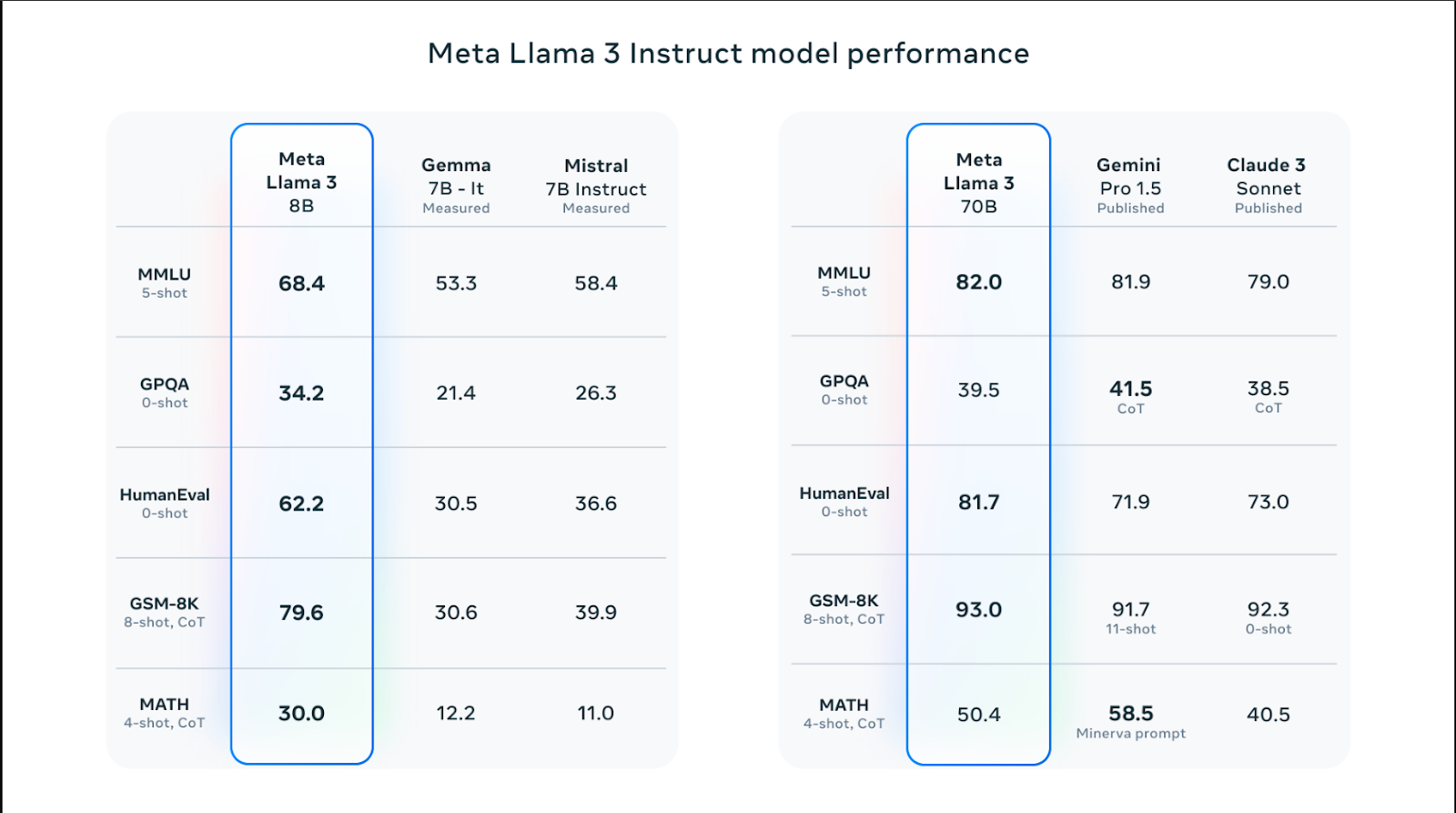

Llama 3-modellen zijn er in verschillende maten en presteren beter dan Llama 2-modellen op het gebied van vaardigheden zoals redeneren, codegeneratie, wiskunde en het volgen van instructies. Van de Llama 3-modellen presteerde het 70B-model beter dan populaire modellen zoals Claude 3 Sonnet en Gemini Pro 1.5 door 82,0 te scoren in de MMLU-benchmark. De Llama 3-modellen presteren echter beter dan de Claude 3 Sonnet- en Gemini Pro 1.5-modellen in alle benchmarks, behalve de MATH-benchmark, die wiskundige vaardigheden meet, en de GPQA, die Q&A-scores op graduaatniveau meet.

Het Llama 3 8B-model slaagde erin om beter te presteren dan zijn rivaliserende Gemma 7B- en Mistral 7B-modellen in Humaneval-, MMLU-, GPQA-, GSM-8K- en MATH-benchmarks. Met andere woorden, de modelmaten van Llama 3 presteren beter dan die van zijn rivaliserende modellen.

Trainingsgegevens

Het Llama 3-model is getraind met een grote hoeveelheid gegevens, wat van cruciaal belang is voor het bouwen van een krachtig Large Language Model. In het bijzonder werd het getraind met 15T-tokens uit openbaar beschikbare bronnen - 7 keer meer dan de hoeveelheid gegevens die werd gebruikt om het Llama 2-model te trainen.

Daarnaast is het Llama 3 model getraind met een hoogwaardige dataset bestaande uit 30 verschillende talen anders dan Engels. Dit heeft geresulteerd in een aanzienlijke toename van het taalbegrip, de creativiteit en de vaardigheden van het model om snel te volgen.

Het Meta AI-team heeft een reeks pijplijnen voor het filteren van gegevens ontwikkeld om het Llama 3-model te trainen met hoogwaardige en betrouwbare gegevens. Deze filters bevatten parameters zoals NSFW-filter, heuristisch filter, semantische deduplicatiebenadering en tekstclassificatie. Bovendien, omdat het Llama 2-model goed is in het identificeren van gegevens van hoge kwaliteit, werd het gebruikt om de getrainde gegevens van het Llama 3-model te filteren.

Optimalisering

Llama 3 modellen zijn speciaal geoptimaliseerd voor veelgebruikte GPU en CPU modellen en merken. Hoe meer software is geoptimaliseerd voor specifieke hardware, hoe hoger de prestaties en hoe sneller deze zal werken. Het Llama 3-model is geoptimaliseerd voor Intel-, AMD- en Nvidia-hardware. Bovendien heeft Intel een gedetailleerde gids gepubliceerd over de prestaties van het Llama 3-model.

Veiligheid

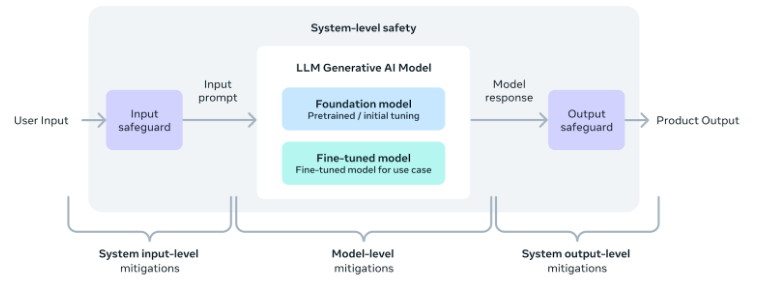

Het Meta AI-team erkent het belang van veilig gebruik van AI-tools en -software, waaronder het Llama 3-model. Dienovereenkomstig werden tijdens de ontwikkeling van het model veiligheidsparameters toegevoegd om ervoor te zorgen dat de output veilig, onschadelijk en ethisch is.

Daarnaast heeft het team ook een veiligheidsimplementatiegids op systeemniveau opgesteld voor degenen die applicaties willen ontwikkelen met behulp van het Llama 3-model. Met deze maatregelen kunnen gebruikers genieten van het gemak en de voordelen van AI-tools terwijl ze deze op een veilige en verantwoorde manier gebruiken.

Een beter alternatief: ZenoChat by TextCortex

Als u op zoek bent naar een aanpasbare AI-assistent met toegang tot verschillende LLM's, waaronder het Llama 3-model, ZenoChat by TextCortex is voor u ontworpen. ZenoChat is een AI-tool die zijn gebruikers de voordelen van verschillende LLM's biedt en deze niet beperkt tot een enkele LLM. ZenoChat heeft tot doel zijn gebruikers te helpen bij professionele en dagelijkse taken zoals het genereren van tekst, parafraseren en onderzoek. Met ZenoChat kunt u elke taak 12x versnellen, uw werklast verminderen en uw productiviteit omhoogschieten.

ZenoChat is beschikbaar als webapplicatie en browserextension. De ZenoChat-browser extension is geïntegreerd met 30.000+ websites en apps. Het kan u dus altijd en overal blijven ondersteunen.

Werk met je eigen kennis en data

ZenoChat biedt een volledig aanpasbare AI-ervaring dankzij onze functies "Knowledge Bases" en "Individual Personas". Met onze functie "Individuele persona's" kunt u de uitvoerstijl, zinslengte, dominante emotie in zinnen en persoonlijkheid van ZenoChat naar wens aanpassen. Met andere woorden, u kunt deze functie gebruiken om van ZenoChat uw persoonlijke assistent of uw digitale tweeling te maken.

Met onze "Knowledge Bases"-functie kunt u gegevensbronnen uploaden of verbinden die ZenoChat zal gebruiken om output te genereren. Door deze functie te gebruiken, kunt u ZenoChat trainen met uw eigen gegevens en deze geschikt maken voor specifieke gebruiksscenario's. Bovendien kunt u dankzij deze functie honderden pagina's met documenten samenvatten met een enkele prompt of chatten met uw PDF's. Onze functie "Knowledge Bases" heeft ook een knop waarmee u uw Google Drive of Microsoft OneDrive binnen enkele seconden kunt integreren.

%20(8).png)

%20(20).png)