Sinds de opkomst van GPT-3 is er een stroom van startups die strijden om de aandacht van gebruikers die AI copywriting diensten verkopen voor verschillende formaten.

E-mails, blog posts, landing pages, ad copy, verkoopcommunicatie...

Weet je nog dat het meeste vertaal- en proefleeswerk nog door mensen werd gedaan?

Toen kwamen DeepL, Google Translate en Grammarly.

Democratisering en versnelling van geletterdheid en taal voor iedereen.

Raad eens?

Wat daar gebeurde, gebeurt nu met tekstcreatie.

De bronlaag van de hele waardeketen.

Laten we bespreken wat er gebeurt met AI copywriting, waarom GPT-3 nog maar het begin is, en hoe de meeste van deze AI copywriting tools niet veel meer doen dan een mooi gezicht bouwen bovenop dezelfde kern.

Jarvis, Copy AI , CopySmith, CopyShark, Writesonic, Anyword...

Ze kwamen, zagen GPT-3, en proberen nu jou als toekomstige gebruiker te winnen.

Sommige AI copywriting tools zijn ongelooflijk snel gegroeid, hebben sterke inkomstenbanen opgebouwd, en zijn opgehaald bij sjieke investeerders.

Vaak overbeloven ze met honderden templates die niet echt leveren wat ze zeggen te zijn en als het erop aankomt zijn ze allemaal hetzelfde en hebben ze geen macht om hun eigenlijke tekstkwaliteit te beïnvloeden en te verbeteren.

Ze zijn allemaal afhankelijk van...

GPT-3 van OpenAI.

Tot veel in staat, een echte generalistische krachtpatser van de kunstmatige intelligentie en een vuurtoren voor vele nieuwsgierige geesten die zich nu op het gebied van natuurlijke taalgeneratie hebben gestort.

Maar GPT-3 is slechts het begin van een ongelooflijk snel ontwikkelende technologietak.

Plotseling was daar GPT-3 en werd het gevaar een kans. De geschiedenis van OpenAI

Een korte technische inleiding. Laat me je meer vertellen over de betekenis van die schijnbaar geheime letters.

G P T - 3 staat voor Generative Pre-trained Transformer v3.

Laat me je er doorheen leiden - woord voor woord.

Eenvoudig beginnen met "generatief" betekent dat het model AI bedoeld is om te creëren.

Met "transformer" hebben we het niet over Autobots ter grootte van een gebouw van 3 verdiepingen zoals we ze kennen uit de films.

Transformers zijn een relatief nieuwe ontwikkeling op het gebied van deep learning en kunstmatige intelligentie.

Een techniek die een machine in staat stelt de patronen van de menselijke taal te leren en deze voort te zetten door woord voor woord zinnen te maken.

Een transformator model alleen is als een pasgeborene die niet veel kan totdat hij van zijn ouders leert.

Transformers leren door miljarden voorbeelden te lezen om creatief te worden.

Daarom wordt het "voorgetraind" genoemd op een grote hoeveelheid menselijke taal.

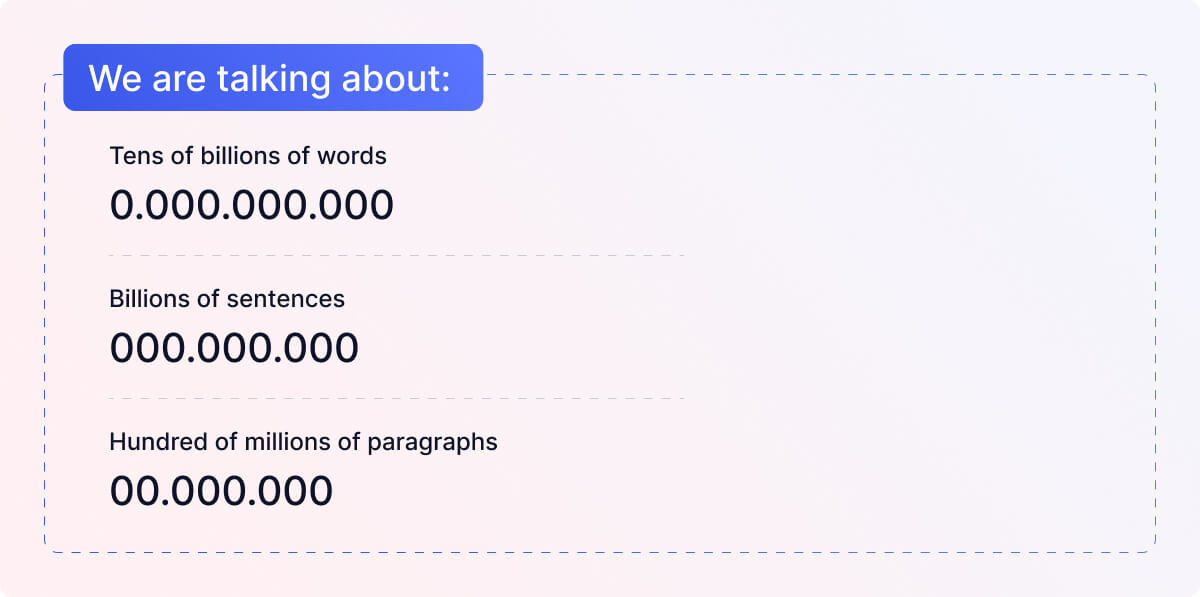

We praten over triljoenen woorden.

Ik zal het hier en daar ook over modellen hebben.

We doen hier niet aan high fashion, dus probeer een model te zien als een momentopname van iets.

Inclusief alle ervaringen, learnings, en ontwikkelingen die het doormaakte.

Denk aan hoe je vanmorgen wakker werd, dit ene moment dat je hele leven vol ervaringen en leerervaringen weerspiegelt en omvat die je hebben gemaakt tot de persoon die je nu bent.

Stel je voor dat je een momentopname maakt van dit moment met alle eerder beïnvloede gebeurtenissen. Dit is een model dat is voorgetraind op uw ervaringen.

Laat me in de reacties of in een DM weten of dit het GPT-3 model voor jou wat begrijpelijker heeft gemaakt.

We zijn TextCortex een AI startup die 80% van je schrijfwerk wegneemt.

De geschiedenis van OpenAI

Waarom is OpenAI belangrijk in deze context?

Zij waren de vuurtoren die de cruciale belangstelling op dit gebied kon wekken.

Mensen van alle achtergronden worden naar de ruimte getrokken, van nieuwsgierige academici, serieuze bedrijven, creatieve ondernemers tot individuele personen die allemaal deel willen uitmaken van het moment waarop transformatortechnologie geschiedenis maakt.

Laten we deze verhaallijn beginnen met degenen die GPT-3 hebben gemaakt.

Eind 2015 - Het verhaal begint zoals bij zoveel innovatieve ontwikkelingen die we vandaag de dag zien met de technoking himself, Elon Musk.

Samen met Sam Altman en een paar andere investeringsvrienden hebben zij maar liefst 1 miljard dollar toegezegd om een non-profit organisatie op te zetten die vrijelijk zou samenwerken met de onderzoeksgemeenschap en het voortouw zou nemen bij de ethische ontwikkeling van AI.

2019 was een bewogen jaar voor OpenAI.

Nadat Elon Musk de organisatie had verlaten, kwam Microsoft met nog eens een miljard USD om het bedrijf om te vormen tot een commercieel gedreven organisatie met winstoogmerk.

Terwijl OpenAI klaar was voor de markt, begon een van hun modellen golven te maken - - toen nog uitgeroepen tot te gevaarlijk om op de wereld los te laten.

Sidenote: De bovengenoemde gevaren waren voor mij een van de redenen om naar de ruimte te verhuizen toen ik nog machine learning studeerde aan de universiteit.

In 2020 hebben ze GPT-3 op de wereld losgelaten.

Een AI model dat bijna 116 keer groter is dan zijn voorganger met 175 bn. parameters*.

Aanvankelijk konden alleen een paar geselecteerde instellingen ermee experimenteren, totdat GPT-3 onlangs werd opengesteld voor iedereen die bereid was de dure prijs te betalen voor de mogelijkheden ervan.

- denk aan parameters als de grootte van de AI hersenen die je aanvullen en helpen.

De opkomst van AI copywriting

GPT-3 heeft veel productbouwers gemotiveerd om een prettig ogende gebruikersinterface bovenop GPT-3 te maken. Ik heb er in het begin een paar genoemd.

Wij zien echter wekelijks nieuwe lanceringen van het steeds identieke product.

Na het zien van het 40ste werktuig, ben ik gestopt met het verzamelen van informatie over hen...

Ik zag een aantal van hen beweren dat zij zich onderscheiden door de betere "communicator naar de API van GPT-3" te zijn.

Wat betekent dat? Is het een echt punt van differentiatie?

API is een afkorting voor application programming interface.

Klinkt ingewikkeld, maar weet je nog hoe de grote orakels in films altijd een poortwachter hadden die voor hen sprak?

De API is zo'n ding voor computers.

Al deze AI copywriting bedrijven maken een bedevaart naar de poortwachter van GPT-3 om de wens van hun gebruiker te sturen en daarop een antwoord te krijgen.

Terug naar het punt van de beste communicatie naar de poortwachter API van GPT-3.

Hoewel communicatie cruciaal is, heeft het geen invloed op het proces van het orakel bij het creëren.

Alleen OpenAI kan de kunstmatige intelligentie voor u verbeteren.

GPT-3 is echter niet meer het enige orakel op het blok.

Met de toegenomen belangstelling is er een verscheidenheid aan verschillende orakels beschikbaar en op TextCortex is het ons dagelijks brood om ze te trainen op onze eigen gegevens om het beste te bereiken voor hun respectieve doel.

4 dingen om op te letten bij het gebruik van GPT-3 schrijfgereedschap

Zoals gezegd hebben we die AI copywriting tools zien opduiken als paddenstoelen op een regenachtige bosgrond.

De meeste van hen met de enige motivatie - snel geld verdienen.

Dat wordt een probleem als het gaat om de stabiliteit van het bedrijf achter de software.

We hebben een aantal schattingen gemaakt en als we een voorbeeld nemen aan onze krachtige gebruikers, zouden hun activiteiten ongeveer 100 USD per maand kosten voor één gebruiker.

Mijn medeleven gaat uit naar degenen die begonnen zijn met lifetime deals om zich vervolgens te realiseren dat GPT-3 niet gratis is.

Triest voor de klanten die die gekocht hebben om nu voor de gesloten deur te staan met software die niet terug antwoordt.

Ook grote AI bedrijven zoals Replika AI met hun 7 miljoen gebruikers zijn van GPT-3 afgestapt vanwege de beperking dat zij de kwaliteit niet kunnen beïnvloeden en tegelijkertijd hoge operationele kosten betalen omdat zij vastzitten aan afhankelijkheden.

1. Spring niet op de goedkoopste (levenslange) deal

Zoals met veel dingen in het leven is goedkoop kopen duurkoop.

Zo zijn levenslange aanbiedingen.

Ik heb gezien dat veel gebruikers ons benaderen omdat de software waarmee zij werkten op een gegeven moment de klantenondersteuning stopzette of op zich niet meer werkte omdat er een fundamentele operationele fout in zat.

Wees voorzichtig... met het betalen van de snelle dollar aan iemand met dollartekens in hun ogen.

2. Trap niet in de # van templates truc.

Veel geadverteerde templates zijn slechts placeholders om een idee te krijgen van wat u zou kunnen interesseren.

Dit is een veel voorkomende klacht die wij waarnemen. Een slechte "instructie tot scheppingsrelevantie" of een zich steeds herhalend scheppingspatroon.

Wij vragen onze gebruikers actief in nauwe gesprekken binnen onze communities wat zij willen.

Als we genoeg belangstelling voor een format zien, graven we diep, verzamelen we gegevens, trainen we onze eigen AI transformator modellen en bieden we onze gemeenschappen iets duurzaams.

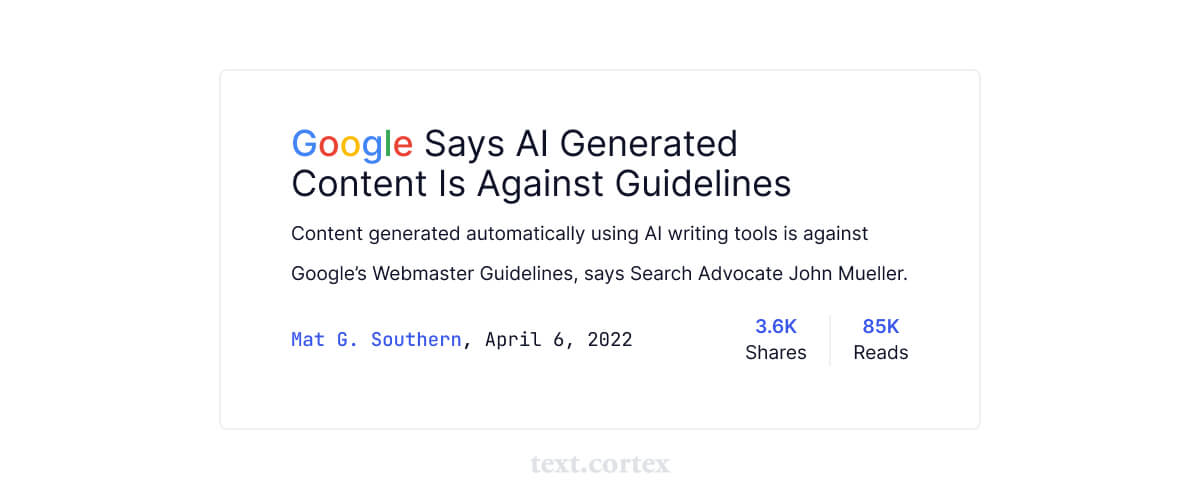

3. Als iedereen hetzelfde gebruikt, kan het je rankings schaden.

Op dit moment worden al deze op regels gebaseerde software, die beweert AI te zijn, maar uiteindelijk gewoon uw input door een cookie-cutter proces duwt en draait, getroffen.

Hoewel moderne AI technologieën zoals GPT-3 ongelooflijk creatief en natuurlijk aanvoelen, geeft het je een gevoel van veiligheid in de veronderstelling dat het opsporen van hun creaties een uitdaging zou zijn.

Maar als te veel mensen een enkel patroon gebruiken, kan het worden omgekeerd.

We zien aanbieders die GPT-3 aanbieden om 10.000 Blog artikelen per maand te schrijven.

Die slechte actoren zullen alleen maar meer spinnen om met een oplossing te komen.

Momenteel denken wij dat een relevantie door inhoud (RTC) metriek kan worden gebruikt om het gebruik van AI gegenereerde inhoud te detecteren.

Ik geef u een vergelijkbare situatie op de markt voor mobiele telefoons.

Als u een dienst zou aanbieden, een app zou bouwen of een systeem zou aanvallen, voor welke zou u dan gaan?

Apple's iOS met ongeveer 27,5% of Androids 71% aandeel in het wereldwijde mobiele besturingssysteem?

Bedenk dus wat Google's eerste doel zal zijn bij het aanpakken van AI-gegenereerde inhoud.

Het is in uw voordeel om doelgerichte modellen te gebruiken die deskundig zijn op hun gebied.

Daarnaast moet u zoveel mogelijk maatwerk zoeken. Wij bieden u bijvoorbeeld de mogelijkheid om gebruik te maken van verschillende creativiteitsmachines.

4. Instabiliteit wanneer de infrastructuur wordt bijgewerkt

Die grote taalmodellen ontwikkelen zich voortdurend.

Elke update en training van de onderliggende infrastructuur heeft gevolgen voor de output van de tekstkwaliteit.

Aangezien de meeste AI copywriting tools afhankelijk zijn van de vele variaties van GPT-3 verstoort een verandering in hun infrastructuur de kwaliteit.

Het duurt even tot ze "hun communicatie met het orakel weer hebben gevonden". ;)

Waarom GPT-3 nog maar het begin is van natuurlijke taalgeneratie en hoe wij het anders doen bij TextCortex

Ik heb het nu al een paar keer verpest en je kunt mijn antwoord wel raden op de vraag of we met GPT-3 de Olymp van natuurlijke taalgeneratie hebben bereikt?

Nee, dat hebben we niet.

Zonder aarzeling zeg ik het nogmaals GPT-3 was de gedurfde stap die individuen, academici, bedrijven en regeringen tot het veld riep.

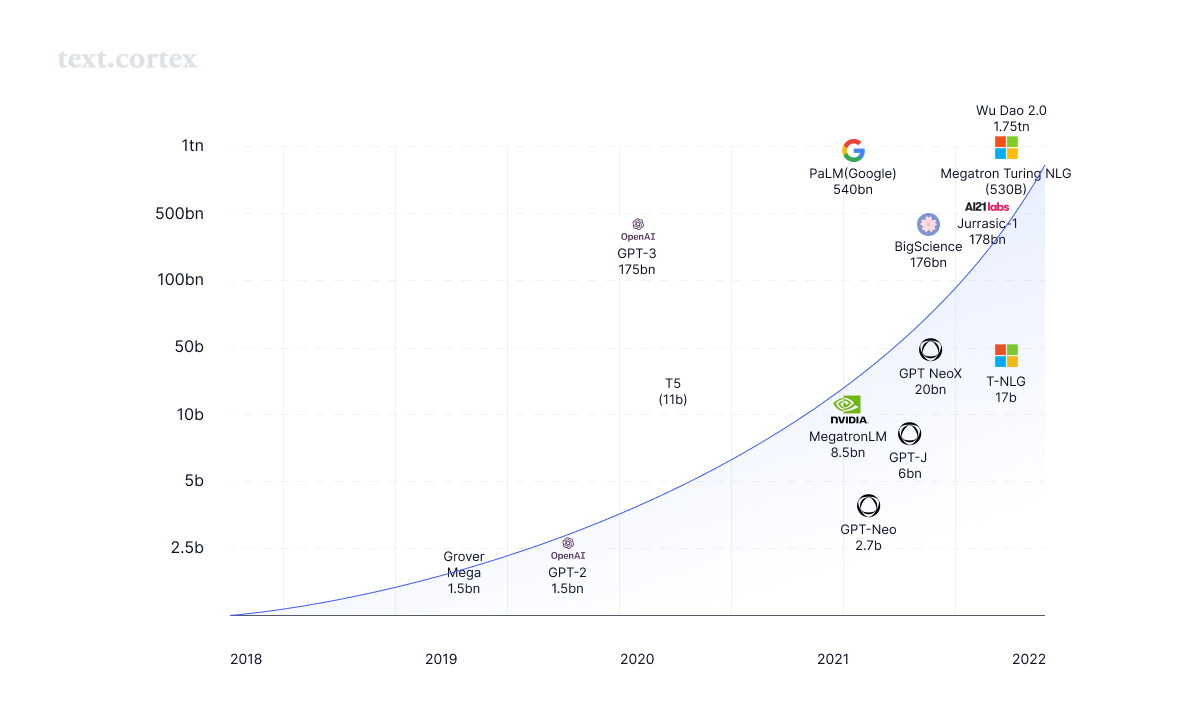

Toch is het het begin van een nieuw tijdperk. Momenteel zien we een wapenwedloop in het creëren van AI's met steeds meer parameters, steeds grotere hersenen.

Terugkomend op mijn Transformers (de film) verhalend Microsofts Megatron-Turing model.

Een model met hersenen 3x zo groot als GPT-3.

Zijn 530 bn. parameters gebruiken om een beschrijving te schrijven voor uw product of uw blog artikel is als het bouwen van een kolencentrale met als enig doel het opladen van uw smartphone.

Daar blijft het niet bij.

Er zijn geruchten dat GPT-4 in de biljoen parameters zal zitten.

Google kondigde aan al een model in de triljoenen te hebben bereikt.

Het Chinese Wu Dao model is er ook.

Betekent dit dat ze 10x beter zijn dan GPT-3?

Gaat een grotere parametergrootte gepaard met een betere creatie?

Komt grote macht met grote verantwoordelijkheden?

Eén ding is zeker: met grote parameters komt zeker een groot energieverbruik.

Het bouwen, trainen en gebruiken van dergelijke grote taalmodellen is een ramp voor het milieu.

Weet je nog hoe ik eerder sprak over "voorgetrainde" modellen? Het helpt niet om een brein te creëren dat de hoeveelheid waarvan het kan leren overdrijft. De slimste kleuter is beperkt tot het leren van wat hij kan waarnemen uit zijn omgeving.

Wij hebben groot respect voor de OG's van de NLG-ruimte, van OpenAI tot DeepMind tot EleutherAI tot AI21 Labs.

Allemaal steken ze enorme inspanningen en middelen in het vooruitbrengen van de mensheid.

Wij willen ons bij hen aansluiten en verachten degenen die uit zijn op het snelle geld.

Op TextCortex doen we graag het zware werk.

Want geen duurzame en concurrerende waarde wordt opgebouwd door een kortere weg te nemen als het gaat om uw kern.

De kwaliteit van de schepping.

En hoewel GPT-3 een generalist is, een echte duizendpoot, is hij al immens groot voor het gebruik van AI copywriting.

Zoals de mensheid van generalisatie naar specialisatie is gegaan om zich te ontwikkelen en te komen waar we nu zijn.

Dit zal ook gelden voor het genereren van natuurlijke taal.

Daarom ontwikkelen wij op TextCortex geen standaardmodel. Wij bouwen kleine doelgerichte modellen die een netwerk opzetten en orkestreren.

Want een "one size fits all", past gewoon niet iedereen.

In plaats van één massief triljoen parameter AI model bouwen wij een netwerk van 100 en 1000 modellen die u dienen als een deskundige AI schrijfgenoot.

Wij trainen, bouwen, testen, ontwikkelen, experimenteren en zetten onze eigen AI modellen in op onze eigen zorgvuldig geselecteerde kennis en gegevens.

Hen leren specialisten te worden in een wereld van generalisten.

In plaats van honderden vooraf geschreven templates aan te bieden die vaak de relevantie voor uw behoeften missen, brengen wij templates uit die wij specifiek hebben onderzocht, kennis hebben verzameld en onze AI's hebben getraind om te beheersen.

Kies het juiste AI schrijfgereedschap voor jezelf

Het is een simpele vraag wat je liever hebt?

Een professional met één jaar ervaring of één met 10 jaar diepgaande kennis op het gebied dat u nodig hebt?

Moet een advocaat die betrouwbare contracten moet schrijven ook weten hoe hij de meest boeiende blogs over chocolate chip muffin recepten moet schrijven?

Met onze methode van kleinere doelgerichte AI modellen kunnen we hen leren waarom, hoe en hoe bepaalde formats en schrijfstijlen eruit zien.

Ons long-form model werd bijvoorbeeld getraind op meer dan 10 miljoen zeer boeiende blogs.

Zij begrijpen dat long-form content bestaat uit een boeiend intro tot een informatief hoofdgedeelte met een conclusie die alles tot een punt brengt.

Het aanpassen van AI modellen aan onze gebruikersbehoeften is ons dagelijks brood.

Elke dag streven wij ernaar dit netwerk van AI deskundigen uit te breiden en brengen wij ze in elk tekstvak waar u ze nodig heeft.

Je bent een fervent schrijver?

Bekijk onze chrome extension hyper opladen van uw creatie in elk tekstvak dat er is.

U bent een ontwikkelaar op zoek naar een NLG AI oplossing? Benader ons om onze API.

Wil je gegevens bijdragen aan onze zaak? Wees onze gast.

Laten we creatieve AI's bouwen met een doel!

.jpg)