Terwijl AI zich op volle snelheid blijft ontwikkelen, heeft Apple deze sector betreden en verschillende en nieuwe benaderingen ontdekt voor het trainen van een MLLM (Multimodal Large Language Model). Tijdens het trainen van het MM1 model bood Apple een effectievere methode door het traditionele Multimodal Large Language Model trainingsproces aan te passen. Deze methode maakt effectief gebruik van grote hoeveelheden datasets met de juiste parameters en hyperparameters. Als je je afvraagt hoe het MM1 model werkt, dan zit je hier goed!

In dit artikel zullen we onderzoeken wat het MM1 model is en hoe het werkt.

Klaar? Laten we erin duiken!

TL; DR

- Apple's MM1 is een multimodaal groot taalmodel dat is ontwikkeld met een unieke voortrainings- en fijnafstemmingsaanpak.

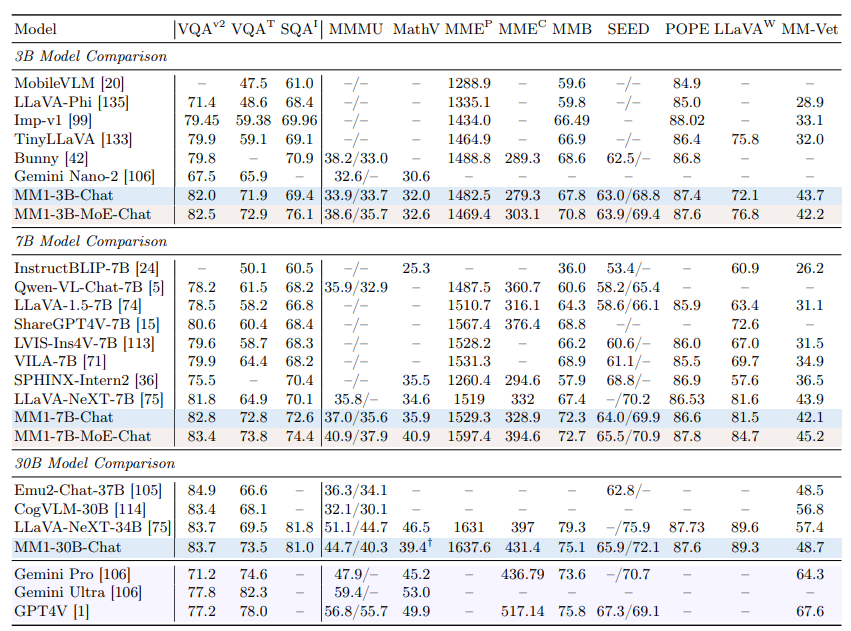

- Het Apple MM1 model werd uitgebracht met drie verschillende parameter groottes: 3B, 7B en 30B.

- Terwijl het Apple MM1 model in sommige benchmarks beter presteert dan de GPT-4 en Gemini Ultra modellen, blijft het in andere met een kleine marge achter.

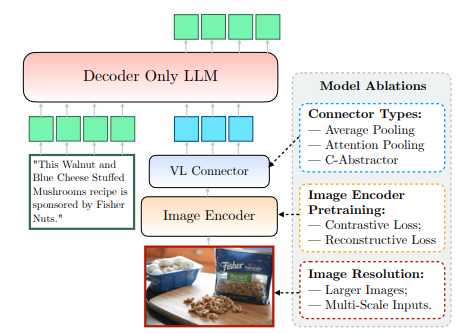

- Tijdens de training van het Apple MM1-model werden de beeldcoders, de vision-taalverbindingen en de getrainde gegevensfasen opnieuw ontworpen.

- Als je een AI-assistent nodig hebt om je te ondersteunen in je dagelijkse en professionele leven, kijk dan niet verder dan TextCortex.

- TextCortex is erop gericht om je werklast te automatiseren en je productiviteit te verhogen met zijn unieke functies en geavanceerde AI-mogelijkheden.

Wat is Apple MM1?

Het MM1 model van Apple is een Multimodaal Groot Taalmodel (MLLM) dat is ontworpen om visuele taken uit te voeren met hoge prestaties en minimale systeemeisen. Dit model is ontwikkeld met een unieke en nieuwe benadering van het MLLM-trainingsproces. Deze aanpak is gericht op maximale efficiëntie met minimale parameters.

Apple MM1 modelmaten

Het Apple MM1 multimodale grote taalmodel is opgeschaald naar drie verschillende groottes, elk met verschillende hoeveelheden parameters: 3B, 7B en 30B. Bovendien zijn deze modellen geschaald met behulp van een mixture-of-experts (MoE) benadering. Deze schaling is de cruciale factor achter de ongeëvenaarde prestaties van MM1 tijdens zowel de pre-training als de fine-tuning fase.

Is MM1 beter dan ChatGPT?

Dankzij de hoge prestaties in de pre-training en fine-tuning fases kan het Apple MM1 model concurreren met modellen als GPT-4V en Gemini Ultra en ze zelfs overtreffen in sommige benchmarks. Het MM1 30B model presteerde bijvoorbeeld beter dan zowel het GPT-4 Vision model als het Gemini Ultra model in de VQAv2 benchmark. Bij andere benchmarks is te zien dat het MM1 model iets minder goed presteert dan de Gemini Ultra en GPT-4 modellen.

Hoe krijg ik toegang tot MM1?

Omdat Apple het MM1 model nog niet publiekelijk beschikbaar heeft gemaakt, is het voor ons op geen enkele manier mogelijk om het te ervaren. Het onderzoekslaboratorium van Apple heeft echter verklaard dat alle MM1 formaten binnenkort beschikbaar zullen zijn.

Hoe werkt Apple's MM1?

Het MM1 model van Apple, dat nog niet openbaar beschikbaar is, is getraind op een nieuwe en unieke manier, die verder gaat dan traditionele methoden. Volgens het onderzoekslab van Apple is het voor het trainen van een model met maximale efficiëntie nodig om de complexe relatie tussen het architectonische ontwerp van MLLM en de integratie van verschillende datasets te onderzoeken. Deze methode is gericht op maximale efficiëntie met minimale parameters. We kunnen deze informatie duidelijk vinden in het artikel dat Apple heeft gedeeld. Laten we eens kijken hoe Apple's MM1 werkt.

Afbeeldingencoder

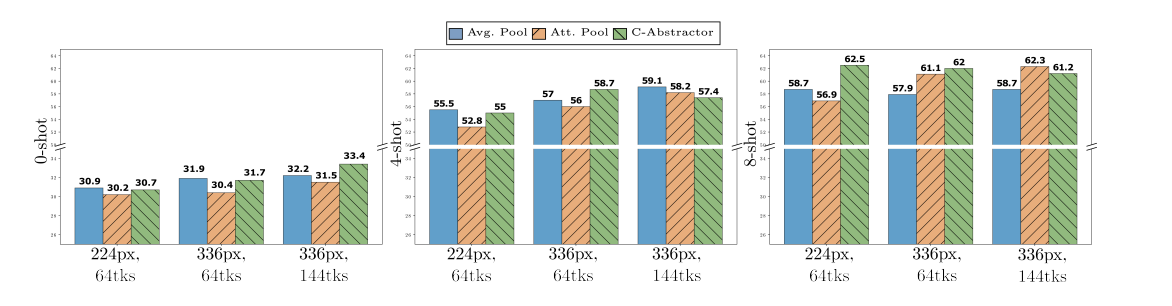

Tijdens het trainen van het MM1 model ontdekte het Apple Research Lab dat de resolutie van afbeeldingen de grootste invloed heeft op het trainingsproces. Het MM1-model werd getraind met afbeeldingen met een resolutie van 378x378 pixels. Dit trainingsproces werd voltooid met behulp van de deep learning modellen ViT-H (Vision Transformer - Huge) en CLIP (Contrastive Language-Image Pretraining). Terwijl het ViT-H model is ontworpen door Google voor beeldclassificatie, is CLIP handig voor het insluiten van afbeeldingen die zijn ontworpen door OpenAI.

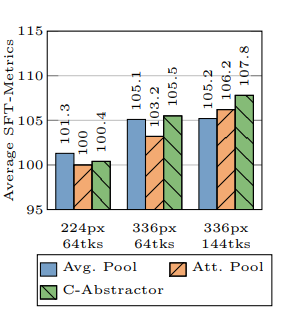

Aansluiting visie-taal

Volgens het Apple Research Lab zijn bij het ontwikkelen van een MLLM, als je wilt dat deze hoge prestaties levert bij visuele taken, de resolutie van een afbeelding en het aantal visuele tokens essentieel om het trainingsproces naar een hoger niveau te tillen. Het onderzoekslaboratorium van Apple gebruikte een VL-connector met 144 tokens bij de ontwikkeling van het MM1-model.

Op welke gegevens is Apple MM1 getraind?

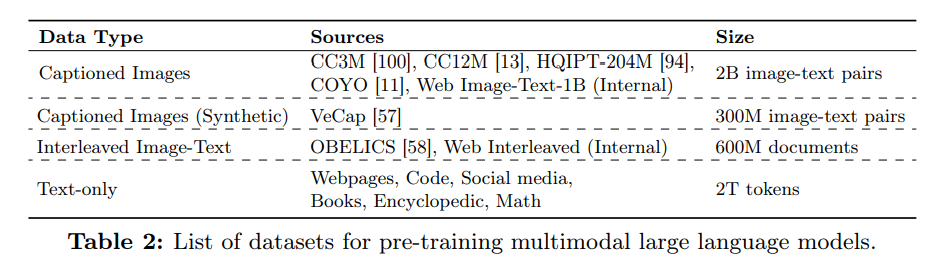

De getrainde gegevens van een Multimodaal Groot Taalmodel (MLLM) dienen als geheugen en als kennis om uitvoer te genereren. Daarom geldt: hoe diverser en uitgebreider de getrainde gegevens van een MLLM, hoe beknopter de uitvoer.

Het onderzoekslaboratorium van Apple gebruikte een aanzienlijke hoeveelheid gegevens bestaande uit tekst en afbeeldingen om de zero-shot en few-shot prestaties van het MM1 model te verbeteren. Volgens het artikel van Apple is het MM1-model getraind met behulp van een gegevensvariatie die bestaat uit 45% interleaved beeld-tekst documenten, 45% beeld-tekst paar documenten en 10% alleen tekst documenten.

%20(6).png)

%20(20).png)

%20(19).png)