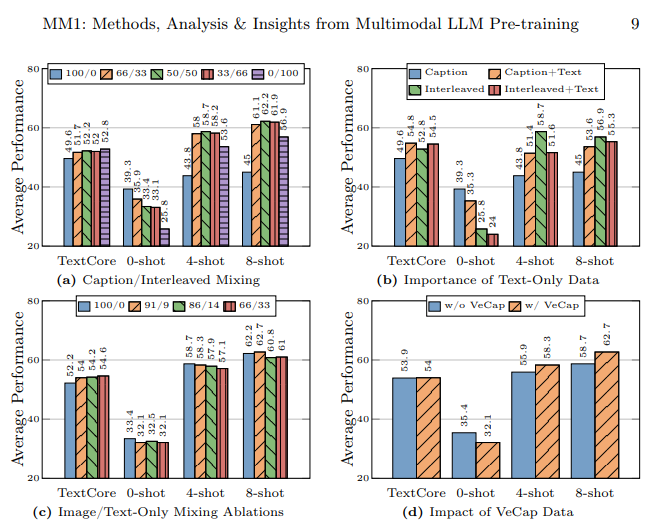

Terwijl alle grote bedrijven zoals Google, Microsoft en Meta aan de slag zijn gegaan op het gebied van AI en de ene na de andere geavanceerde AI-modellen produceren, deed Apple, het bedrijf dat overblijft, mee aan deze AI-race met zijn multimodale grote taalmodel MM1 genaamd. Dit model werd getraind met zowel tekstuele gegevens als visuele gegevens. Het MM1 multimodale grote taalmodel werd getraind met een mix van afbeeldingen met bijschriften (45%), interleaved beeld-tekst documenten (45%) en alleen tekst (10%) gegevens.

In dit artikel ontdekken we wat het multimodale grote taalmodel MM1 van Apple is.

Als je er klaar voor bent, laten we dan beginnen!

TL; DR

- MM1 is een multimodale grote taalmodel familie ontwikkeld en aangekondigd door Apple.

- Het MM1-model is ontwikkeld met een andere trainings- en opbouwmethode, in tegenstelling tot traditionele MLLM's.

- Tijdens het bouwen van het MM1-model werden de architectuur, getrainde gegevens, beeldcoder, parameters, hyperparameters en trainingsprocedure opnieuw gemaakt om effectief te zijn.

- Het MM1 model heeft een lager aantal parameters en kleinere afmetingen dan zijn concurrenten, waardoor het soepel werkt op mobiele apparaten.

- Als je op zoek bent naar een AI-assistent die altijd bij je is, zoals op mobiele apparaten, dan is TextCortex de manier om te gaan, met zijn integratie van 30.000+ websites en apps.

- TextCortex biedt een verscheidenheid aan aanpasbare en interactieve AI-oplossingen, van schrijven tot je professionele taken.

Wat is Apple MM1?

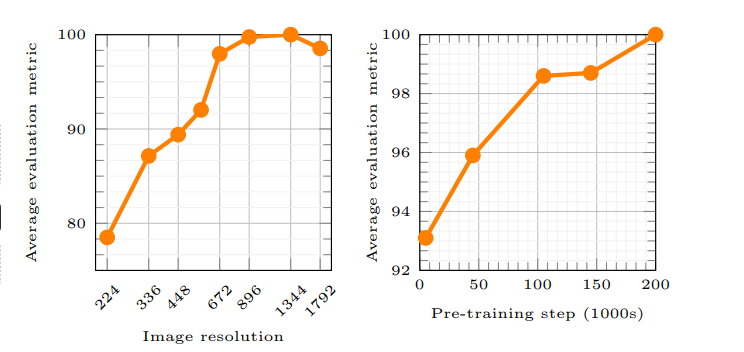

Apple's MM1 is een Multimodal Large Language Model (MLLM) familie die zowel tekst als visuele processen kan verwerken en genereren. Volgens het artikel van Apple stelt het werkingsprincipe van het MM1 model AI in staat om gebruikersprompts beter te begrijpen en de gewenste output te genereren. Er zijn nieuwe methoden gebruikt tijdens het trainen van het MM1 model en deze methoden beweren dat de beeldresolutie en de capaciteit van de visuele encoder de grootste invloed hadden op de prestaties van het model.

Loopt Apple achter de AI-race aan?

Het onderzoekslab van Apple wilde een krachtig multimodaal groot taalmodel (MLLM) bouwen door tonnen AI-trainings- en bouwmethoden zorgvuldig te onderzoeken. Volgens het artikel van Apple benadrukt het gebruik van verschillende soorten gegevens bij het trainen van een AI-model, het gebruik van beeld-tekstdocumenten bij het leren van 'few-shot', het gebruik van afbeeldingen met bijschriften om de 'zero-shot'-prestaties te verbeteren en gegevens met alleen tekst dat een sterk taalbegrip belangrijk is om de prestaties te verbeteren.

Hoe is het MM1 model gebouwd?

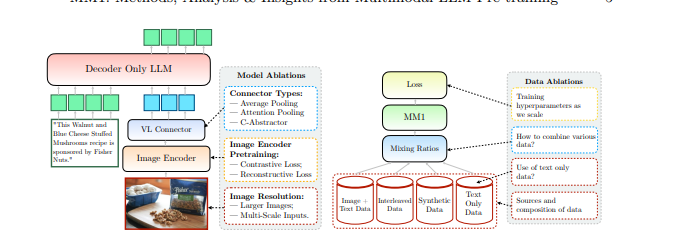

Apple gaf aan dat het verder ging dan traditionele methoden om het MM1 model te bouwen en dat deze methoden nodig waren om een goed presterend Multimodal Large Language Model (MLLM) te bouwen. Apple neemt drie basisstappen in overweging bij het bouwen van het MM1 model:

- Architectuur: Het team van het onderzoekslaboratorium van Apple onderzocht methoden om verschillende voorgetrainde beeldcoders en LLM's met deze encoders te verbinden om zo een unieke architectuur te bouwen.

- Getrainde gegevens: Het MM1-model wordt getraind met datasets die verschillende soorten gegevens bevatten, zoals visuele gegevens en tekst, en combinaties van deze gegevens.

- Trainingsprocedure: In plaats van getraind te worden met een groot aantal parameters, werd het MM1 model getraind door te focussen op hyperparameters en in welke fase ze gebruikt zullen worden.

Apple MM1-mogelijkheden

Het MM1 Multimodal Large Language Model (MLLM) van Apple heeft andere trainingsmethoden, minder parameters en een andere benadering van het trainingsproces in vergelijking met traditionele MLLM's. Apple stelt dat het MM1 model is gebouwd door de meest efficiënte methoden te ontdekken en innovaties uit te proberen om een MLLM te trainen. Laten we de mogelijkheden en trainingsverschillen van het MM1 model eens nader bekijken.

Architectuur

Het MM1-model heeft een andere architectuur dan andere MLLM's (Multimodal Large Language Models). Deze architectuur omvat encoders met een hogere beeldresolutie, een andere benadering van het pre-trainingproces en het mengen van gelabelde gegevens om de algehele prestaties van een enkele prompt te verbeteren. Het onderzoekslab van Apple richt zich op het belang van verschillende gegevenskeuzes om het MM1 model te trainen. Met andere woorden, het MM1 model heeft een architectuur die gericht is op het leveren van hogere prestaties door minder bronnen te gebruiken dan traditionele MLLMs.

Afbeeldingencoder

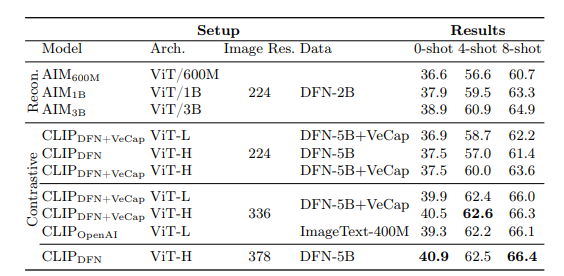

De meeste Multimodale Grote Taal Modellen gebruiken CLIP (Contrastive Language-Image Pretraining) voorgetrainde beeld-encoder om visuele gegevens te verwerken. Daarnaast tonen recente onderzoeken aan dat vision-only self-supervised modellen effectiever werken. Door deze encoders te analyseren, ontdekte het onderzoeksteam van Apple dat de meest effectieve methode om een MLLM met visuele gegevens te trainen, de voor de encoders geselecteerde afbeeldingen zijn. Volgens het onderzoekslab van Apple hebben de gegevens die gebruikt worden in het verwerkingsproces van een afbeeldingsencoder direct invloed op de prestaties van de encoder. Het resultaat van al dit onderzoek is als volgt: de beeldresolutie heeft de grootste invloed, gevolgd door de grootte van het model en de samenstelling van de trainingsgegevens.

MM1 Parameters

Volgens het onderzoekslaboratorium van Apple is wat belangrijker is dan de grootte van de parameters in een Multimodaal Groot Taalmodel (MLLM) de fijnafstemming, schaling en hyperparameters van die parameters.

De parameters van het MM1-model werden met maximale efficiëntie gebruikt om verschillende gegevensinvoer te analyseren en te verwerken. Het MM1-model is een familie van AI-modellen die bestaan uit drie verschillende parametergroottes: 3B, 7B en 30B. Bovendien geldt: hoe kleiner de parametergrootte van een MLLM, hoe efficiënter deze zal werken op mobiele apparaten.

Als je op zoek bent naar een AI-assistent die je altijd ondersteunt op zowel mobiele apparaten als desktops om je te helpen bij het voltooien van je dagelijkse of professionele taken, dan moet je TextCortex op je radar houden.

%20(5).png)

%20(20).png)

%20(19).png)