GPT-4V는 시각적 입력을 분석하고 이를 사용하여 출력을 생성하기 위해 OpenAI가 설계한 멀티모달 모델입니다. GPT-4V를 통해 사용자는 시각적 입력을 입력하고 이러한 입력에 대한 질문에 대한 답변을 생성할 수 있습니다. 즉, GPT-4V 모델을 사용하면 원하는 모든 유형의 이미지를 분석하고 해당 이미지에 대한 정보를 얻을 수 있습니다.

이 글에서는 GPT-4V의 특징과 이를 통해 얻을 수 있는 이점을 살펴봅니다.

TL;DR

- GPT-4V는 시각적 입력으로 주어진 쿼리에 대한 출력을 생성하도록 설계된 대형 멀티모달 모델입니다.

- GPT-4V는 주어진 이미지를 사용하여 분석하고 질문에 답하고 이미지의 수학적 문제를 해결할 수 있습니다.

- GPT-4V에 입력으로 제공할 이미지에 시각적 포인터를 추가하면 보다 효율적인 출력을 얻을 수 있습니다.

- GPT-4V는 제공된 비디오 프레임을 사용하여 높은 정확도로 비디오 분석 작업을 완료할 수 있습니다.

- 나만의 지식과 스타일로 완전히 맞춤 설정할 수 있는 AI 어시스턴트를 찾고 있다면 TextCortex 을 추천합니다.

GPT-4V 특징

GPT-4V 모델에는 업무 및 일상 생활의 다양한 측면에서 사용자를 지원하도록 설계된 기능이 포함되어 있습니다. 이러한 기능을 함께 자세히 살펴보겠습니다.

안전 및 개인정보 보호

GPT-4V에 대한 보고서에서 Microsoft는 이 모델을 개발하는 동안 개발자 팀이 온라인이나 2023년 4월 이후에는 액세스할 수 없는 이미지를 사용했다고 밝혔습니다. 또한 이 방법을 통해 입력을 더 잘 분석하고 정확하고 안전한 출력을 생성하는 GPT-4V의 기능이 향상되었습니다. 따라서 GPT-4V 모델은 출력을 생성할 때 온라인 데이터를 사용하지 않고 실제 인간 수준의 분석 및 대응 기술을 사용합니다.

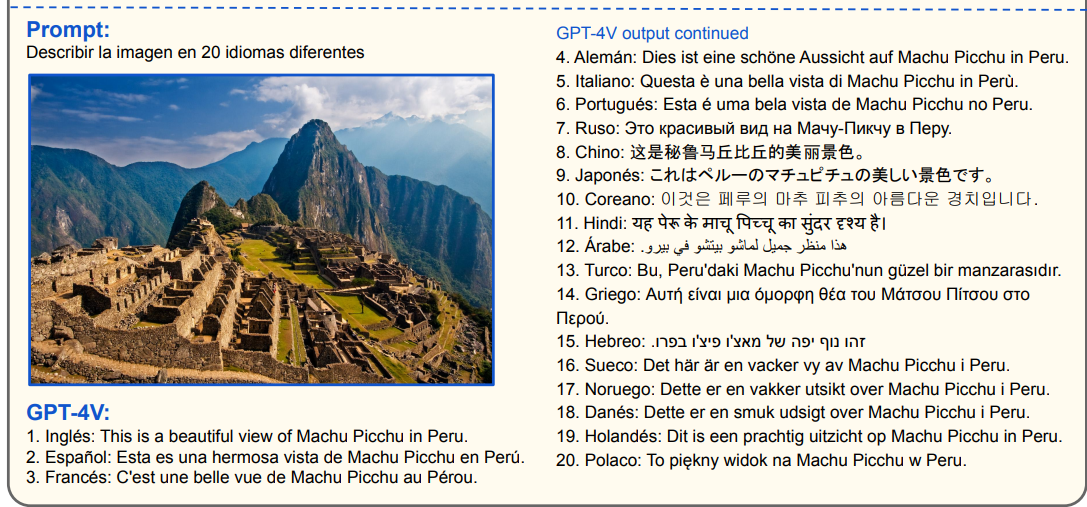

다국어 지원

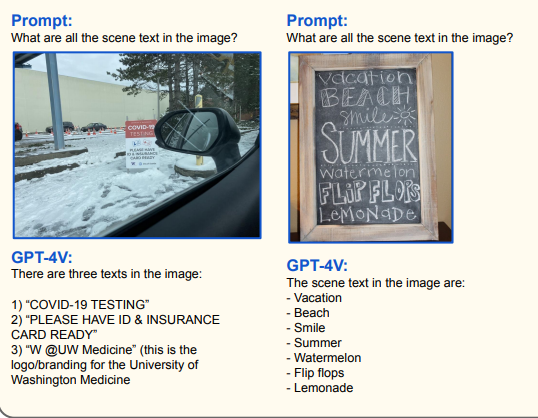

Microsoft 문서에 따르면 GPT-4V 모델은 중국어, 프랑스어, 체코어 등 20개 언어로 입력을 분석하고 출력을 생성할 수 있다고 합니다. 또한 GPT-4V 모델은 이 20개 언어의 시각적 입력 텍스트를 읽어서 응답을 생성할 수 있습니다. 또한 이러한 입력을 다른 언어로 번역하거나 요약할 수 있습니다. 이 기능은 모르는 언어로 된 표지판을 읽어야 할 때 유용할 수 있습니다.

시각적 참조 프롬프트

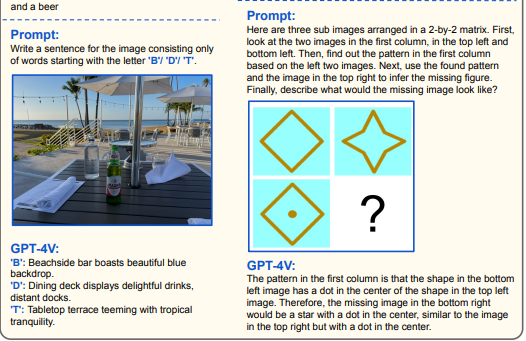

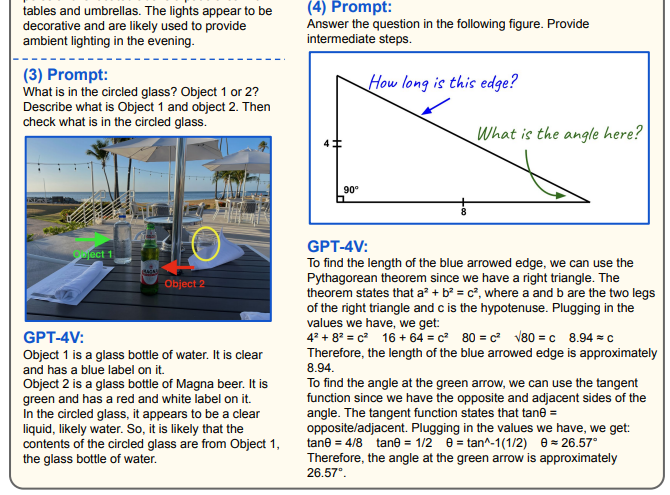

GPT-4V를 효과적으로 사용하려면 Microsoft에서 시각적 참조 프롬프트라고 부르는 완전히 새로운 프롬프트 방법을 사용해야 합니다. 이 프롬프트 방법을 사용하려면 입력으로 사용하는 이미지와 관련된 쿼리를 입력해야 합니다.

"이미지 설명..."과 같은 간단한 프롬프트와 함께 GPT-4V 모델을 사용할 수도 있습니다. 그러나 한계를 뛰어넘고 싶다면 복잡한 수학 문제나 코딩 작업을 요청할 수도 있습니다.

시각적 포인터

GPT-4V는 주어진 비주얼과 관련된 프롬프트를 분석하여 사용자에게 가장 유용한 답변을 제공하는 것을 목표로 합니다. Microsoft의 문서에 따르면 GPT-4V는 이미지에 그려진 시각적 포인터를 통해 보다 효과적인 출력을 생성합니다. 이미지의 특정 영역에 대한 정보를 분석하려는 경우 시각적 포인터를 사용하여 프롬프트를 입력하면 보다 일관된 출력을 얻을 수 있습니다.

장면 텍스트 및 차트 추론

GPT-4V는 각 이미지의 텍스트, 숫자, 데이터를 인식하고 이 정보를 기반으로 출력을 생성하는 데 성공했습니다. GPT-4V 모델은 주어진 입력을 시각과 연결하여 분석하고 프롬프트의 명령이나 질문에 응답합니다. GPT-4V를 사용하면 다음과 같은 작업을 높은 정확도로 완료할 수 있습니다:

- 시각 수학

- 차트 이해 및 추론

- 테이블 인식

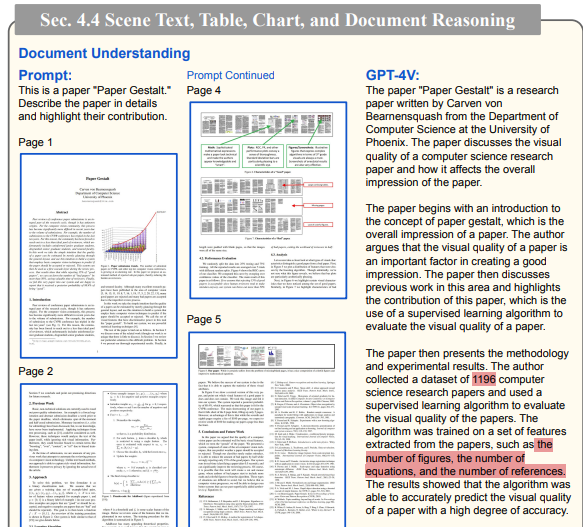

- 문서 이해

연구원들은 '논문 게슈탈트'의 모델 페이지를 GPT-4V에 입력으로 제공하고 모든 데이터를 분석하도록 요청했습니다. GPT-4V는 몇 가지 실수만 범했을 뿐 대체로 정확하게 논문을 분석했습니다.

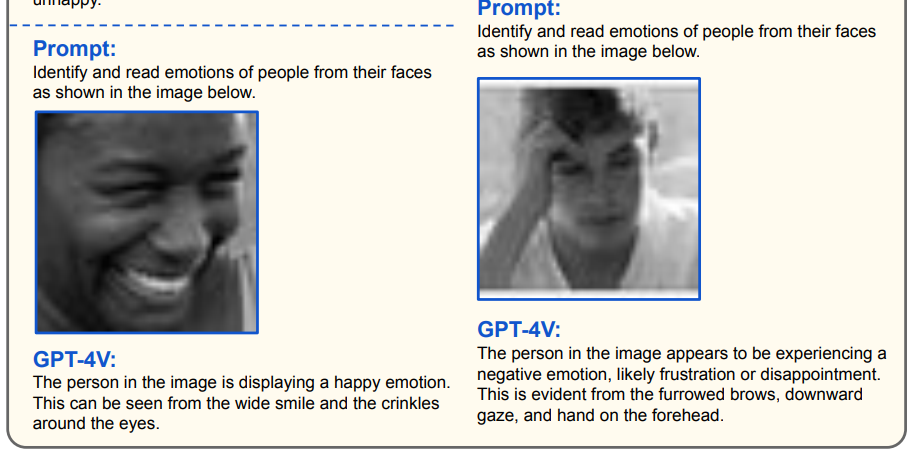

감정 감지

GPT-4V 모델은 주어진 인물 사진이나 얼굴 입력에서 사람의 얼굴을 분석하고 감정에 대한 판단을 내릴 수 있습니다. 포커페이스가 없다면 인공지능이 사람의 감정을 이해하여 사람을 분석할 수 있다고 말할 수 있습니다. GPT-4V 모델은 특히 행복, 놀람, 경멸, 슬픔, 두려움, 혐오, 분노 등 7가지 보편적인 얼굴 표정을 이해하는 데 성공했습니다.

GPT-4V는 어떤 기능을 제공하나요?

GPT-4V 모델에는 사용자에게 다양한 혜택을 제공하는 인상적인 개선 사항과 기능이 포함되어 있습니다. GPT-4V 모델이 어떤 기능을 제공하는지 궁금하신 분들을 위해 함께 살펴보겠습니다.

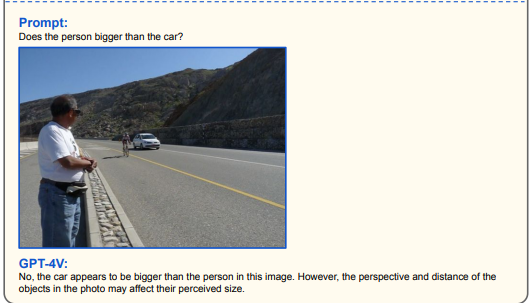

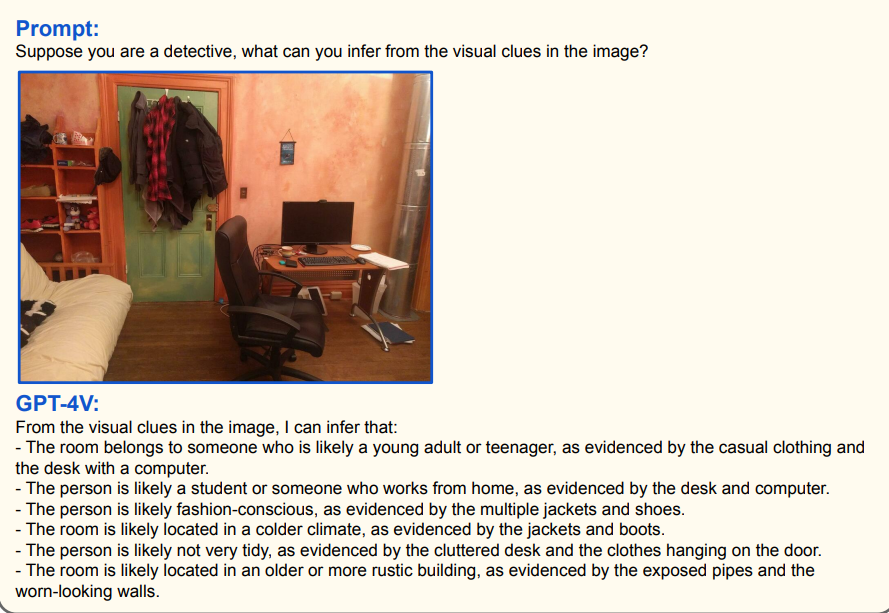

이미지 분석

GPT-4V 모델은 주어진 비주얼을 분석하고 사용자의 프롬프트에 따라 출력을 생성하는 성공적인 AI입니다. 따라서 GPT-4V 모델을 사용하여 수학 문제를 풀거나 책을 번역하거나 다양한 시나리오에 대한 시각적 분석을 수행할 수 있습니다. 예를 들어, 방 이미지를 GPT-4V에 제공하면 해당 이미지에 대한 탐정 분석을 출력할 수 있습니다.

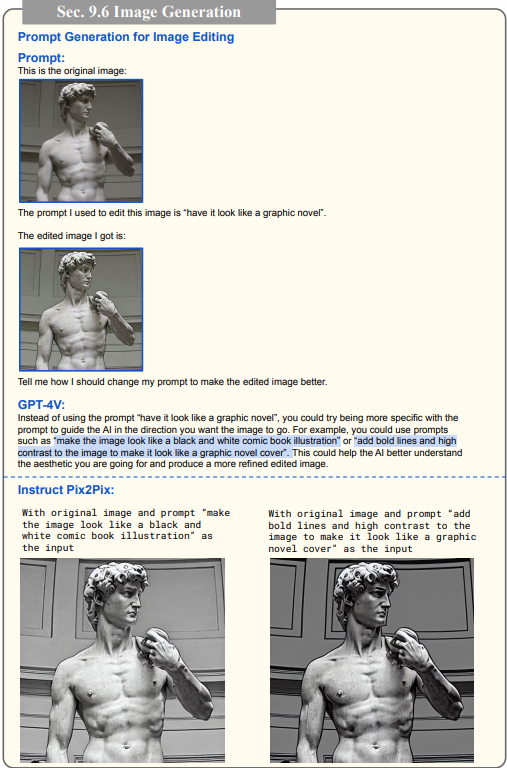

이미지 프롬프트 생성/편집

GPT-4V 모델에 이미지와 텍스트 요구 사항을 제공하면 원하는 대로 이미지를 편집할 수 있는 프롬프트를 얻을 수 있습니다. 프롬프트 엔지니어링 기술을 한 단계 더 발전시키고 프롬프트 작성에 대한 도움을 받고 싶다면 GPT-4V 모델이 적합합니다.

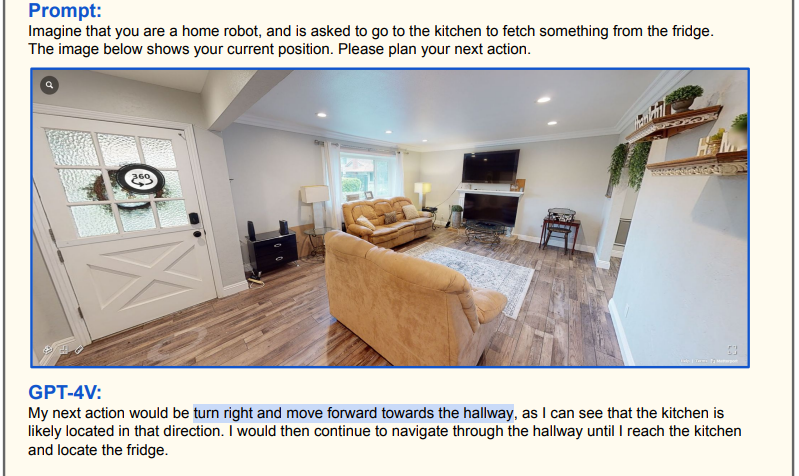

탐색

GPT-4V 모델에 방, 거리 또는 고속도로 이미지를 지정하여 내비게이션 출력을 얻을 수 있습니다. 예를 들어, GPT-4V에 방 이미지와 이미지의 특정 지점으로 이동하라는 메시지를 지정하면 경로를 그려서 텍스트 형식으로 출력할 수 있습니다.

로봇을 개발하여 기술 경진대회나 페스티벌에 참가하는 경우 GPT-4V를 사용하여 로봇을 더 스마트하게 만들 수 있습니다.

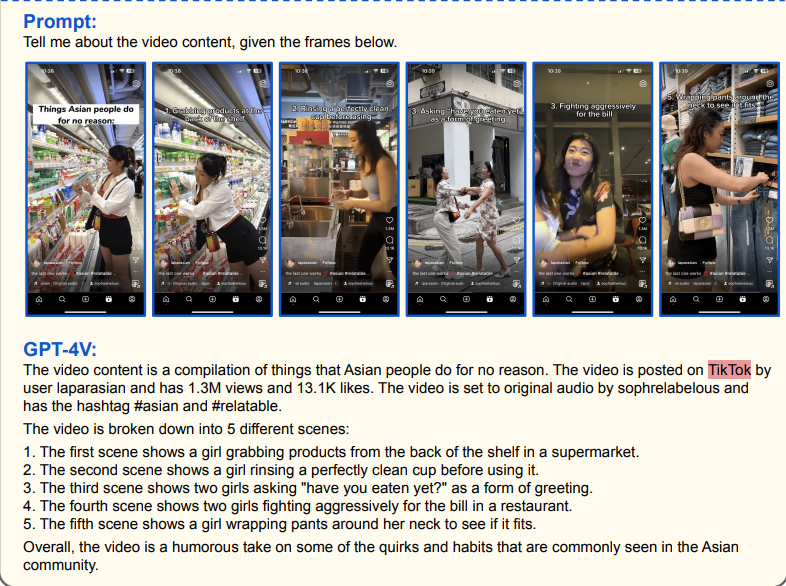

비디오 분석

오늘날 세계에서 새로운 주제를 배우거나 주제에 대한 정보를 얻는 가장 효과적인 방법 중 하나는 유익한 비디오를 시청하는 것입니다. 그러나 정보를 얻기 위해 몇 시간 동안 동영상을 시청하고 싶지 않다면 GPT-4V 모델을 사용하여 동영상을 분석할 수 있습니다. GPT-4V는 주어진 프레임을 분석하여 상세하고 일관된 설명을 생성할 수 있습니다.

TextCortex AI - 대화형 AI 비서

TextCortex 는 텍스트 생성, 음성-텍스트 재작성, 웹 검색 등 다양한 기능을 제공하는 AI 비서입니다. 웹 애플리케이션과 브라우저( extension), TextCortex 브라우저( extension )로 사용할 수 있으며, 20,000개 이상의 웹사이트 및 앱과 통합되어 인터넷에서 언제 어디서나 계속 사용할 수 있습니다.

TextCortex 에서는 글쓰기 기능 외에도 유럽의 ChatGPT 대안인 제노챗도 제공합니다. 또한, 저희 팀은 TextCortex 에 새로운 AI 기술을 추가하고 사용자에게 대규모 멀티모달 모델(LMM)의 기능을 제공하기 위해 노력하고 있습니다. 여기를 클릭하여 프리미엄 TextCortex 계정을 만들고 최신 AI 기능을 경험하세요!

%20(11).png)

%20(24).png)

%20(21).png)