Meta AI는 2024년 4월 18일 라마 3 모델을 발표하며 현재 AI 기술에 접근하는 LLM을 선보였습니다. LLama 3 모델은 이전 모델인 LLama 2 모델보다 더 발전되었지만 전반적으로 GPT-3.5 및 Claude 3 Sonnet과 같은 중급 대규모 언어 모델의 경쟁자입니다. Meta AI의 LLama 3 모델은 이전 모델에 비해 향상된 추론, 더 훈련된 데이터 및 언어 이해를 약속합니다. 라마 3 모델이 궁금하시다면 잘 찾아오셨습니다!

이 기사에서는 Llama 3 모델과 그 기능을 함께 살펴보겠습니다.

준비가 되셨다면 시작하세요!

TL; DR

- 라마 3 모델은 메타AI가 개발한 대규모 언어 모델로, 2024년 4월 18일 발표됐다.

- Llama 3는 다양한 사용 사례에 적합한 두 가지 모델 크기(8B 및 70B)로 제공됩니다.

- Meta AI의 공식 웹사이트를 방문하여 라마 3 모델에 액세스할 수 있지만 현재 일부 국가에서는 라마 3를 사용할 수 없습니다.

- 전 세계적으로 라마 3 모델에 액세스하려면 제노챗 TextCortex 당신의 구세주이십니다.

- Llama 3 모델은 벤치마크에서 라이벌인 Gemini Pro 1.5 및 Claude 3 Sonnet 모델을 능가했습니다.

- Llama 3 모델은 특별히 필터링된 공개적으로 사용 가능한 고품질 데이터로 학습됩니다.

- 라마 3보다 더 나은 대화형 AI를 찾고 있다면 제노챗 TextCortex 사용자 지정 옵션과 텍스트 및 이미지 출력 기능으로 설계되었습니다.

Meta AI의 라마 3 리뷰

라마 3 모델은 2024년 4월 18일 Meta AI에서 도입한 대규모 언어 모델입니다. Llama 3 모델은 이전 모델에 비해 향상된 기능과 출력 생성 기능을 제공합니다. 라마 3 모델은 향상된 추론, 미세 조정된 언어 이해 및 새로운 기능을 통해 다양한 산업 분야에서 최첨단 성능을 제공하는 것을 목표로 합니다.

라마 3 모델을 개발할 때 Meta AI의 또 다른 목표는 유용성을 개선하는 것입니다. Meta AI는 라마 3 모델이 개발 중인 동안 커뮤니티와 AI 개발자에게 공개하여 효율성을 높이는 것을 목표로 했습니다. 라마 3 모델에 대한 Meta AI의 향후 계획에는 다국어 및 다중 모드 만들기, 컨텍스트 창 증가, 성능 개선이 포함됩니다.

라마 3 모델 크기

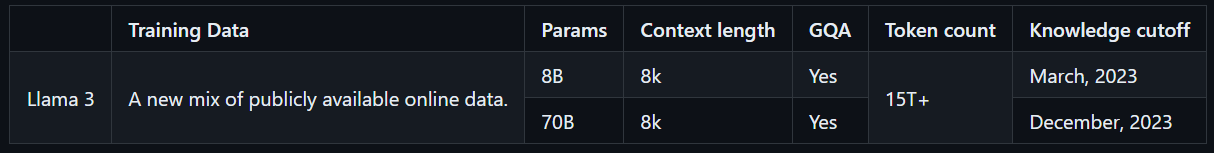

Llama 3는 다양한 사용 사례에 적합한 두 가지 모델 크기(8B 및 70B)로 제공됩니다. Llama 3 8B 모델은 총 80억 개의 매개변수로 더 컴팩트하며 더 빠르게 출력을 생성할 수 있습니다. 반면 라마 3 70B 모델은 총 700억 개의 매개변수를 가지며 복잡한 작업에 적합합니다. 또한 Llama 3 8B 모델은 2023년 3월까지 공개적으로 사용 가능한 온라인 데이터로 학습되며, Llama 3 70B 모델은 2023년 12월까지 공개적으로 사용 가능한 온라인 데이터로 학습됩니다.

라마 3에 액세스하는 방법?

라마 3 모델에 액세스하려면 Meta AI의 공식 웹사이트를 방문하여 "시작하기" 버튼을 클릭하고 단계를 따르세요. 그러나 라마 3 모델은 전 세계적으로 액세스할 수 없기 때문에 다른 LLM과 달리 가용성 점수가 낮습니다. 그러나 전 세계적으로 라마 3 모델을 경험할 수 있는 방법이 있습니다.

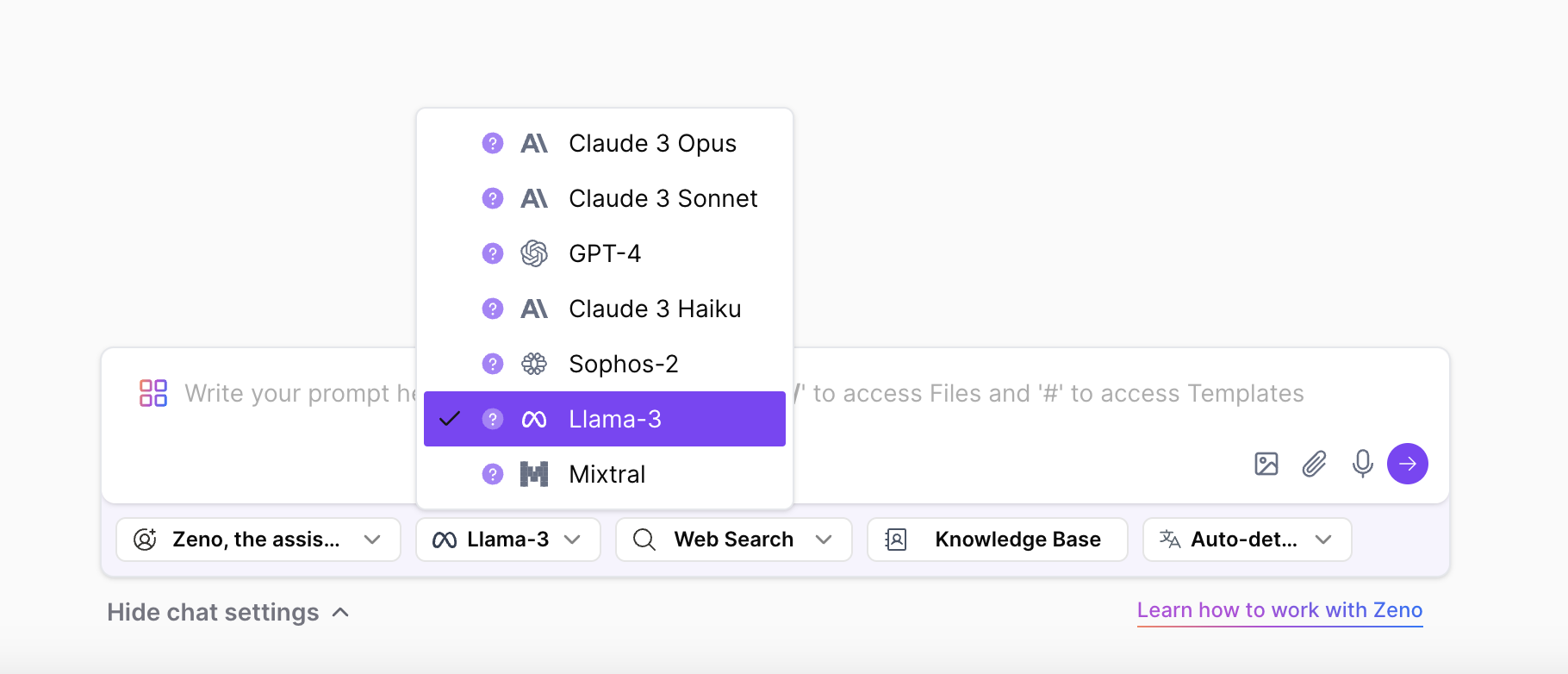

제노챗 사용 TextCortex, 제한 없이 Llama 3 모델의 두 가지 크기에 액세스하고 경험할 수 있습니다. ZenoChat은 GPT-4, Sophos 2, Mixtral, Claude 3 Opus 및 Sonnet LLM 외에도 Llama 3 8B 및 70B LLM을 지원합니다. 즉, Meta AI의 국가 제한 없이 라마 3 모델을 자유롭게 경험할 수 있습니다.

Meta AI의 라마 3 핵심 기능

Meta AI의 가장 최신의 가장 진보된 모델인 라마 3는 이전 모델보다 더 높은 성능과 새로운 기능을 제공합니다. 라마 3 모델은 GPT-4 및 Gemini Ultra와 같은 고급 LLM이 아니라 GPT-3.5 및 Gemini Pro와 같이 더 자주 사용되는 모델의 경쟁자로 도입되었습니다. 라마 3의 핵심 기능을 자세히 살펴보겠습니다.

모델 성능

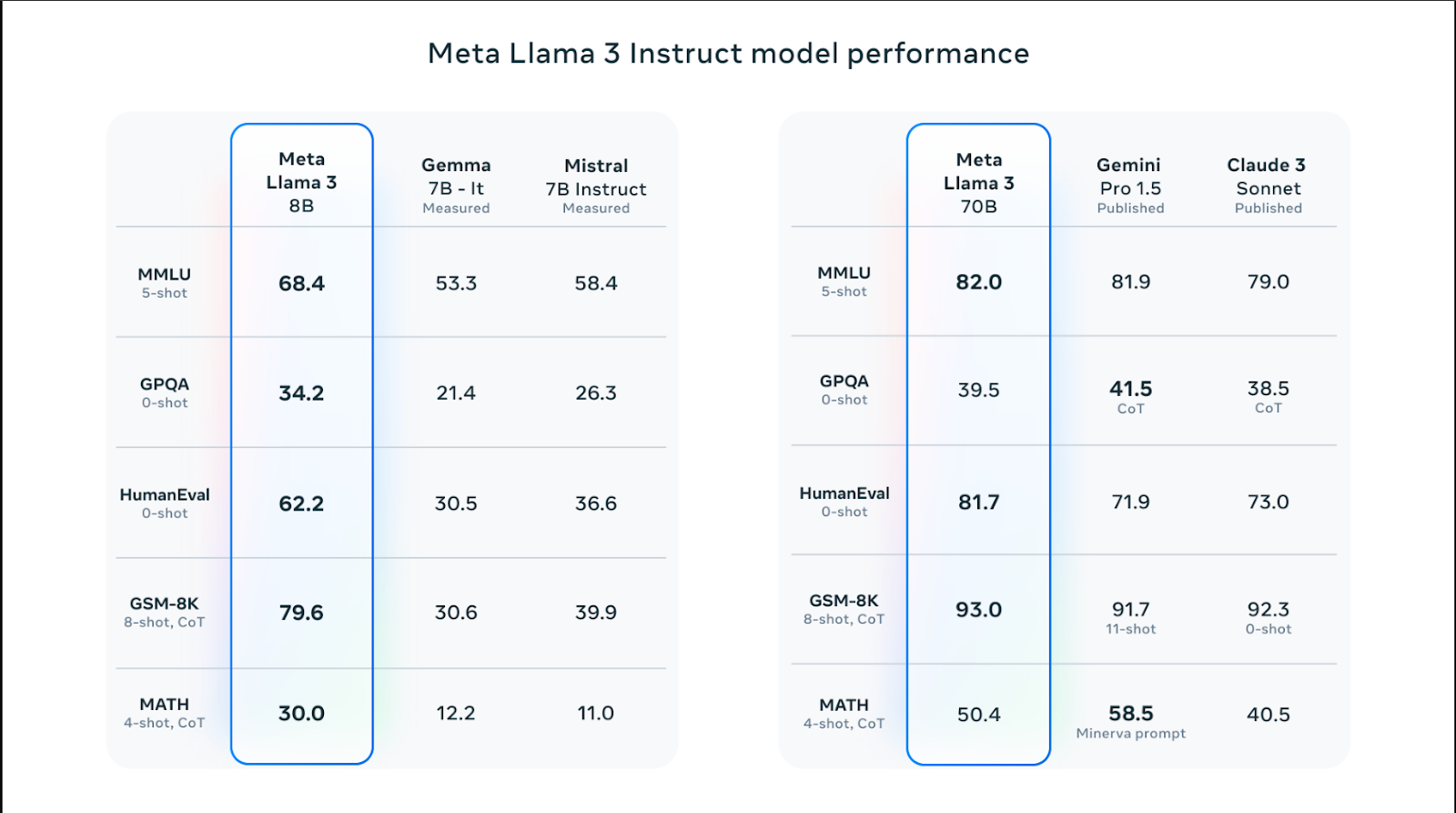

라마 3 모델은 다양한 크기로 제공되며 추론, 코드 생성, 수학 및 지시 따르기와 같은 기술에서 라마 2 모델보다 더 나은 성능을 제공합니다. Llama 3 모델 중 70B 모델은 MMLU 벤치마크에서 82.0점을 획득하여 Claude 3 Sonnet 및 Gemini Pro 1.5와 같은 인기 모델을 능가했습니다. 그러나 Llama 3 모델은 수학 능력을 측정하는 MATH 벤치마크와 대학원 수준의 Q&A 점수를 측정하는 GPQA를 제외한 모든 벤치마크에서 Claude 3 Sonnet 및 Gemini Pro 1.5 모델보다 더 나은 성능을 보입니다.

Llama 3 8B 모델은 Humaneval, MMLU, GPQA, GSM-8K 및 MATH 벤치마크에서 라이벌 Gemma 7B 및 Mistral 7B 모델을 능가했습니다. 즉, 라마 3 모델 크기는 경쟁 모델보다 성능이 높습니다.

학습 데이터

Llama 3 모델은 고성능 대규모 언어 모델을 구축하는 데 중요한 많은 양의 데이터로 학습되었습니다. 특히, 공개적으로 사용 가능한 소스의 15T 토큰으로 훈련되었으며, 이는 Llama 2 모델을 훈련하는 데 사용된 데이터 양보다 7배 더 많은 양입니다.

또한 라마 3 모델은 영어 이외의 30개 언어로 구성된 고품질 데이터 세트로 학습되었습니다. 그 결과 모델의 언어 이해도, 창의성 및 프롬프트 팔로우 기술이 크게 향상되었습니다.

Meta AI 팀은 신뢰할 수 있는 고품질 데이터로 라마 3 모델을 학습시키기 위해 일련의 데이터 필터링 파이프라인을 개발했습니다. 이러한 필터에는 NSFW 필터, 휴리스틱 필터, 의미 체계 중복 제거 접근 방식 및 텍스트 분류자와 같은 매개 변수가 포함됩니다. 또한, 라마 2 모델은 고품질 데이터를 식별하는 데 능숙하기 때문에 라마 3 모델의 학습된 데이터를 필터링하는 데 사용되었습니다.

최적화

라마 3 모델은 자주 사용되는 GPU 및 CPU 모델과 브랜드에 특별히 최적화되어 있습니다. 특정 하드웨어에 최적화된 소프트웨어가 많을수록 성능이 향상되고 실행 속도가 빨라집니다. Llama 3 모델은 Intel, AMD 및 Nvidia 하드웨어에 최적화되어 있습니다. 또한 Intel은 Llama 3 모델의 성능에 대한 자세한 가이드를 게시했습니다.

안전

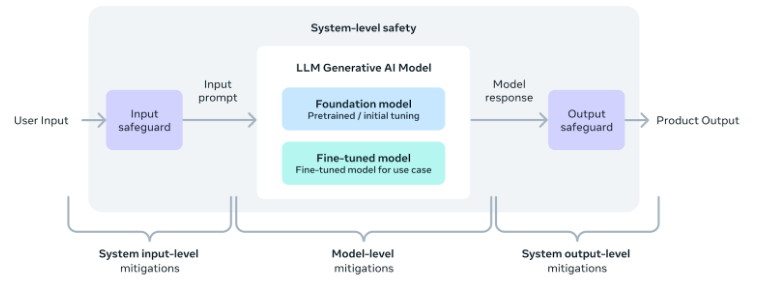

Meta AI 팀은 라마 3 모델을 포함한 AI 도구 및 소프트웨어의 안전한 사용의 중요성을 잘 알고 있습니다. 따라서 모델 개발 중에 안전 매개변수가 추가되어 결과물이 안전하고 무해하며 윤리적임을 보장합니다.

또한 팀은 Llama 3 모델을 사용하여 애플리케이션을 개발하려는 사람들을 위해 시스템 수준의 안전 구현 가이드 도 제공했습니다. 이러한 조치를 통해 사용자는 AI 도구를 안전하고 책임감 있는 방식으로 사용하면서 AI 도구의 편리함과 이점을 누릴 수 있습니다.

더 나은 대안: ZenoChat by TextCortex

Llama 3 모델을 포함한 다양한 LLM에 액세스할 수 있는 맞춤형 AI 비서를 찾고 있다면 ZenoChat by TextCortex 당신을 위해 설계되었습니다. ZenoChat은 사용자에게 다양한 LLM의 이점을 제공하고 단일 LLM으로 제한하지 않는 AI 도구입니다. ZenoChat은 텍스트 생성, 의역 및 연구와 같은 전문적이고 일상적인 작업에서 사용자를 지원하는 것을 목표로 합니다. ZenoChat을 사용하면 모든 작업의 속도를 12배 높이고 작업량을 줄이며 생산성을 높일 수 있습니다.

ZenoChat은 웹 애플리케이션 및 브라우저로 사용할 수 있습니다.extension. ZenoChat 브라우저 extension 30,000 + 웹 사이트 및 앱과 통합됩니다. 따라서 언제 어디서나 계속 지원할 수 있습니다.

자신의 지식과 데이터로 작업하기

ZenoChat은 "지식 기반" 및 "개별 페르소나" 기능 덕분에 완전히 사용자 정의 가능한 AI 경험을 제공합니다. "개별 페르소나" 기능을 사용하면 ZenoChat의 출력 스타일, 문장 길이, 문장의 지배적인 감정 및 성격을 원하는 대로 조정할 수 있습니다. 즉, 이 기능을 사용하여 ZenoChat을 개인 비서 또는 디지털 트윈으로 전환할 수 있습니다.

"지식 기반" 기능을 사용하면 ZenoChat이 출력을 생성하는 데 사용할 데이터 소스를 업로드하거나 연결할 수 있습니다. 이 기능을 사용하면 자신의 데이터로 ZenoChat을 훈련하고 특정 사용 사례에 적합하게 만들 수 있습니다. 더욱이, 이 기능 덕분에, 단 한 번의 프롬프트로 수백 페이지의 문서를 요약하거나, PDF와 채팅을 할 수 있습니다. "기술 자료" 기능에는 Google 드라이브 또는 Microsoft OneDrive를 몇 초 만에 통합할 수 있는 버튼도 있습니다.

%20(8).png)

%20(20).png)