AI가 계속해서 빠른 속도로 발전하는 가운데, Apple은 이 분야에 진출하여 MLLM(다중 모드 대규모 언어 모델)을 훈련하는 다양하고 새로운 접근 방식을 발견했습니다. MM1 모델을 훈련하는 동안 Apple은 기존의 다중모달 대규모 언어 모델 훈련 프로세스를 맞춤화하여 보다 효과적인 방법을 제시했습니다. 이 방법에는 적절한 매개변수와 하이퍼파라미터를 사용하여 대량의 데이터 세트를 효과적으로 사용하는 것이 포함됩니다. MM1 모델이 어떻게 작동하는지 궁금하다면 잘 찾아오셨습니다!

이 글에서는 MM1 모델이 무엇이며 어떻게 작동하는지 살펴봅니다.

준비되셨나요? 시작하죠!

TL; DR

- Apple의 MM1은 고유한 사전 교육 및 미세 조정 방식을 통해 개발된 다중 모드 대규모 언어 모델입니다.

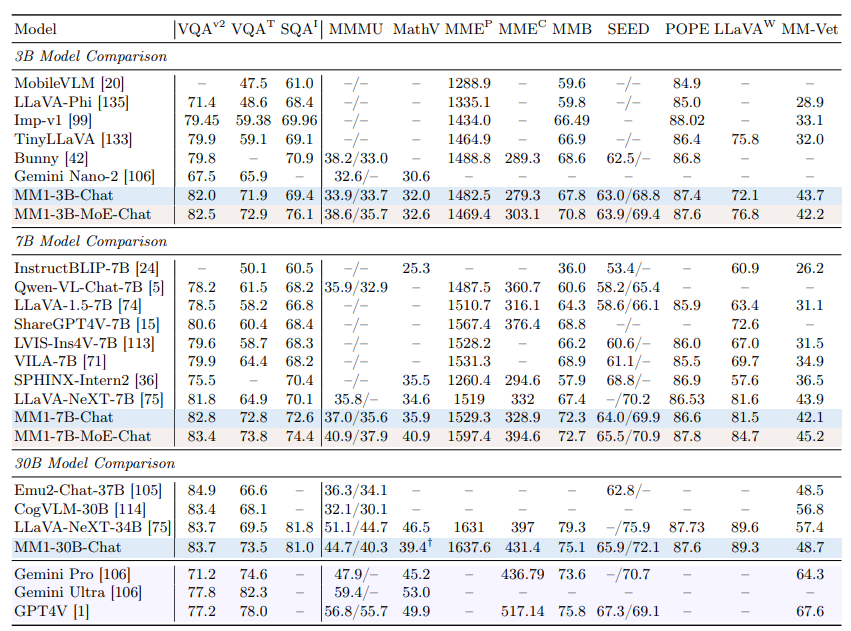

- Apple MM1 모델은 세 가지 매개변수 크기로 출시되었습니다: 3B, 7B, 30B.

- Apple MM1 모델은 일부 벤치마크에서는 GPT-4 및 Gemini Ultra 모델보다 성능이 뛰어나지만, 다른 벤치마크에서는 근소한 차이로 뒤처집니다.

- Apple MM1 모델을 훈련하는 동안 이미지 인코더, 비전 언어 커넥터, 훈련된 데이터 단계가 재설계되었습니다.

- 일상과 업무 모두에서 도움을 줄 AI 비서가 필요하다면 TextCortex 을 살펴보세요.

- TextCortex 는 고유한 기능과 고급 AI 기능으로 워크로드를 자동화하고 생산성을 높이는 것을 목표로 합니다.

Apple MM1이란 무엇인가요?

Apple의 MM1 모델은 고성능과 최소한의 시스템 요구 사항으로 시각 기반 작업을 완료하도록 설계된 다중 모드 대규모 언어 모델(MLLM)입니다. 이 모델은 MLLM 학습 프로세스에 대한 독특하고 새로운 접근 방식으로 개발되었습니다. 이 접근 방식은 최소한의 매개변수로 최대의 효율성을 목표로 합니다.

Apple의 MM1 모델 크기

Apple MM1 멀티모달 대형 언어 모델은 세 가지 크기로 확장되었으며, 각 크기마다 매개변수의 양이 다릅니다: 3B, 7B, 30B입니다. 또한 이러한 모델은 전문가 혼합(MoE) 접근 방식을 사용하여 확장되었습니다. 이러한 스케일링은 사전 훈련과 미세 조정 단계에서 MM1의 탁월한 성능을 뒷받침하는 중요한 요소입니다.

MM1이 ChatGPT보다 낫나요?

사전 트레이닝 및 미세 조정 단계에서의 높은 성능 덕분에 Apple MM1 모델은 GPT-4V 및 Gemini Ultra와 같은 모델과 경쟁할 수 있으며 일부 벤치마크에서는 더 나은 성능을 발휘할 수도 있습니다. 예를 들어, MM1 30B 모델은 VQAv2 벤치마크에서 GPT-4 Vision 모델과 Gemini Ultra 모델 모두에서 더 나은 성능을 보였습니다. 다른 벤치마크에서는 MM1 모델이 Gemini Ultra 및 GPT-4 모델보다 약간 낮은 성능을 보이는 것을 확인할 수 있습니다.

MM1에 액세스하려면 어떻게 해야 하나요?

Apple은 아직 MM1 모델을 공개하지 않았기 때문에 어떤 방식으로도 체험할 수 없습니다. 하지만 Apple 연구소는 모든 MM1 크기를 곧 출시할 예정이라고 밝혔습니다.

Apple의 MM1은 어떻게 작동하나요?

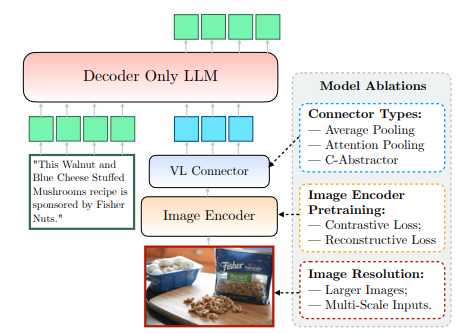

아직 공개되지 않은 Apple의 MM1 모델은 기존 방식을 뛰어넘는 새롭고 독특한 방식으로 훈련되었습니다. Apple의 연구소에 따르면 최대 효율로 모델을 훈련하기 위해서는 MLLM의 아키텍처 설계와 다양한 데이터 세트의 통합 사이의 복잡한 관계를 조사해야 한다고 합니다. 이 방법은 최소한의 파라미터로 최대의 효율성을 얻는 것을 목표로 합니다. Apple이 공유한 논문에서 이 정보를 명확하게 확인할 수 있습니다. Apple의 MM1이 어떻게 작동하는지 자세히 살펴봅시다.

이미지 인코더

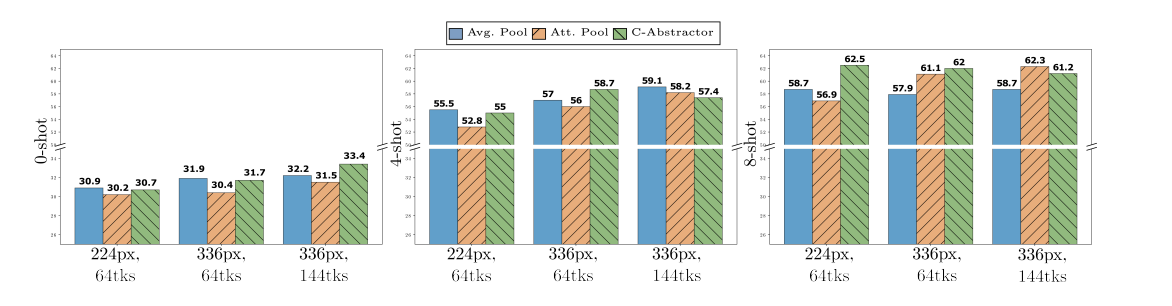

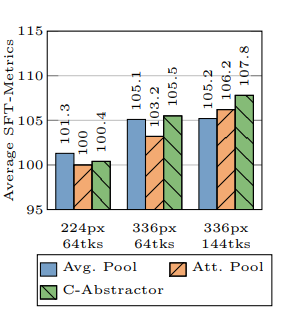

Apple 연구소는 MM1 모델을 훈련하는 과정에서 이미지 해상도가 훈련 과정에 가장 큰 영향을 미친다는 사실을 발견했습니다. MM1 모델은 378x378픽셀 해상도의 이미지로 훈련되었습니다. 이 훈련 과정은 ViT-H(Vision Transformer - Huge) 및 CLIP(Contrastive Language-Image Pretraining) 딥 러닝 모델을 사용하여 완료되었습니다. ViT-H 모델은 이미지 분류를 위해 Google에서 설계한 반면, CLIP은 OpenAI에서 설계한 이미지를 임베딩하는 데 유용합니다.

비전-언어 커넥터

Apple 연구소에 따르면 MLLM을 개발할 때 시각 기반 작업에서 높은 성능을 제공하려면 이미지의 해상도와 시각 토큰의 수가 학습 과정을 한 단계 더 발전시키는 데 필수적이라고 합니다. Apple 연구소는 MM1 모델을 개발할 때 144개의 토큰이 있는 VL 커넥터를 사용했습니다.

Apple MM1은 어떤 데이터를 기반으로 학습했나요?

다중 모드 대규모 언어 모델(MLLM)의 학습된 데이터는 메모리이자 출력을 생성하는 데 사용하는 지식의 역할을 합니다. 따라서 MLLM의 학습된 데이터가 다양하고 광범위할수록 더 간결한 결과물을 생성할 수 있습니다.

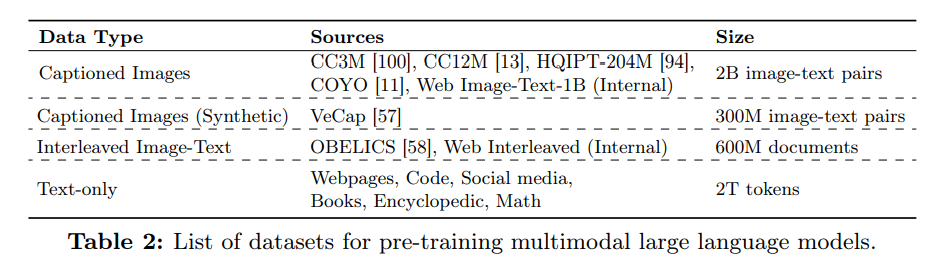

Apple의 연구소는 MM1 모델의 제로 샷 및 소수 샷 성능을 향상시키기 위해 텍스트와 이미지로 구성된 상당한 양의 데이터를 활용했습니다. Apple의 문서에 따르면 MM1 모델은 45%의 이미지-텍스트 인터리브 문서, 45%의 이미지-텍스트 쌍 문서, 10%의 텍스트 전용 문서를 포함하는 다양한 데이터를 사용하여 학습되었습니다.

%20(6).png)

%20(20).png)