구글, 마이크로소프트, 메타 등 주요 기업들이 모두 인공지능 분야에 뛰어들어 고급 인공지능 모델을 속속 내놓고 있는 가운데, 유일하게 남은 기업 중 하나인 애플은 MM1이라는 멀티모달 대용량 언어 모델을 통해 인공지능 경쟁에 뛰어들었습니다. 이 모델은 텍스트 데이터와 시각적 데이터로 모두 학습되었습니다. MM1 멀티모달 대용량 언어 모델은 캡션이 있는 이미지(45%), 이미지-텍스트 문서(45%), 텍스트만 있는 데이터(10%)를 혼합하여 학습했습니다.

이 문서에서는 Apple의 MM1 멀티모달 대형 언어 모델이 무엇인지 알아보세요.

준비가 되셨다면 시작하세요!

TL; DR

- MM1은 Apple에서 개발 및 발표한 멀티모달 대형 언어 모델 제품군입니다.

- MM1 모델은 기존의 다단계판매와는 다른 교육 및 구축 방식으로 개발되었습니다.

- MM1 모델을 구축하는 동안 아키텍처, 학습된 데이터, 이미지 인코더, 파라미터, 하이퍼파라미터, 학습 절차가 효과적으로 재구성되었습니다.

- MM1 모델은 경쟁사 제품보다 매개변수 수와 크기가 적어 모바일 기기에서 원활하게 작동합니다.

- 모바일 기기 등 항상 함께할 수 있는 AI 비서를 찾고 있다면 3만 개 이상의 웹사이트와 앱이 통합된 TextCortex 을 추천합니다.

- TextCortex 는 글쓰기부터 전문적인 업무에 이르기까지 다양한 맞춤형 대화형 AI 솔루션을 제공합니다.

Apple MM1이란 무엇인가요?

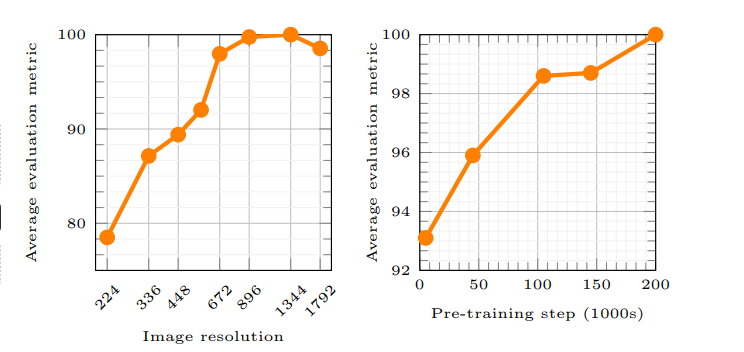

Apple의 MM1은 텍스트와 시각적 프로세스를 모두 처리하고 생성할 수 있는 다중 모드 대규모 언어 모델(MLLM) 제품군입니다. Apple의 문서에 따르면 MM1 모델의 작동 원리를 통해 AI는 사용자 프롬프트를 더 잘 이해하고 원하는 결과물을 생성할 수 있습니다. MM1 모델을 훈련하는 동안 새로운 방법이 사용되었으며, 이러한 방법은 이미지 해상도와 시각 인코더의 용량이 모델 성능에 가장 큰 영향을 미친다고 주장합니다.

애플은 AI 경쟁에서 뒤처지고 있을까요?

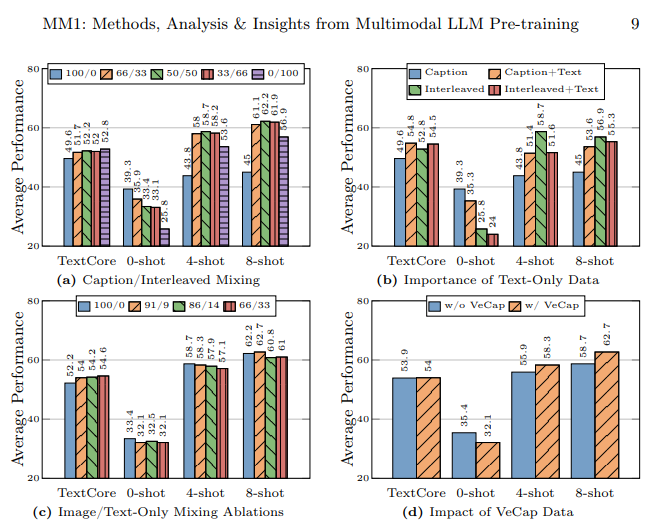

Apple의 연구소는 수많은 AI 학습 및 구축 방법을 면밀히 검토하여 고성능 MLLM(다중 모드 대규모 언어 모델)을 구축하는 것을 목표로 삼았습니다. Apple의 글에 따르면 AI 모델을 학습할 때 다양한 유형의 데이터를 사용하고, 이미지-텍스트 문서를 적은 샷 학습에 사용하고, 캡션이 있는 이미지를 사용하여 제로 샷 성능을 높이고, 텍스트 전용 데이터를 사용하여 성능을 향상시키기 위해서는 강력한 언어 이해가 중요하다고 강조합니다.

MM1 모델은 어떻게 제작되었나요?

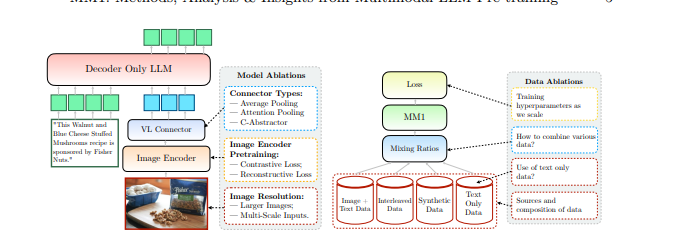

Apple은 MM1 모델을 구축하기 위해 기존의 방법을 뛰어넘었으며, 이러한 방법은 고성능 MLLM(다중모달 대규모 언어 모델)을 구축하는 데 필요하다고 언급했습니다. Apple은 MM1 모델을 구축할 때 세 가지 기본 단계를 고려합니다:

- 아키텍처: Apple의 연구실 팀은 사전 학습된 다양한 이미지 인코더와 LLM을 이러한 인코더와 연결하여 고유한 아키텍처를 구축하는 방법을 검토했습니다.

- 학습된 데이터: MM1 모델은 시각적, 텍스트 등 다양한 유형의 데이터와 이러한 데이터의 조합을 포함하는 데이터 세트로 학습됩니다.

- 훈련 절차: MM1 모델은 많은 수의 파라미터로 학습하는 대신 하이퍼파라미터와 해당 파라미터가 사용될 단계에 집중하여 학습했습니다.

Apple의 MM1 기능

Apple의 MM1 다중 모드 대규모 언어 모델(MLLM)은 기존 MLLM에 비해 훈련 방법이 다르고, 매개변수 수가 적으며, 훈련 과정에 대한 접근 방식이 다릅니다. Apple은 가장 효율적인 방법을 발견하고 MLLM을 훈련하기 위한 혁신을 시도하여 MM1 모델을 구축했다고 말합니다. MM1 모델의 기능과 훈련의 차이점에 대해 자세히 살펴보겠습니다.

아키텍처

MM1 모델은 다른 MLLM(다중 모드 대규모 언어 모델)과는 다른 아키텍처를 가지고 있습니다. 이 아키텍처에는 더 높은 이미지 해상도 인코더, 사전 학습 프로세스에 대한 다른 접근 방식, 단일 프롬프트의 전반적인 성능을 향상시키기 위한 레이블 데이터 혼합 등이 포함됩니다. Apple의 연구소는 MM1 모델을 훈련하기 위해 다양한 데이터 선택의 중요성에 초점을 맞추고 있습니다. 즉, MM1 모델은 기존 MLLM보다 더 적은 리소스를 사용하여 더 높은 성능을 제공하는 것을 목표로 하는 아키텍처를 가지고 있습니다.

이미지 인코더

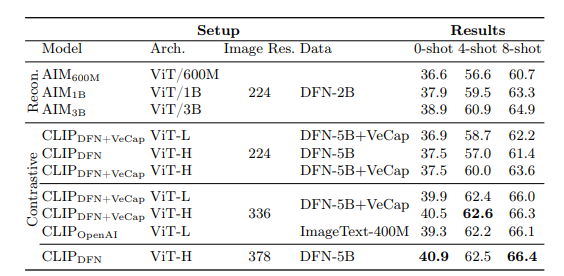

대부분의 멀티모달 대규모 언어 모델은 시각 데이터를 처리하기 위해 CLIP(대조 언어-이미지 사전 훈련) 사전 훈련 이미지 인코더를 사용합니다. 또한 최근 연구에 따르면 시각 전용 자가 지도 모델이 더 효과적으로 작동하는 것으로 나타났습니다. Apple의 연구팀은 이러한 인코더를 분석하여 시각 데이터로 MLLM을 훈련하는 가장 효과적인 방법은 인코더에 선택된 이미지를 사용하는 것임을 발견했습니다. Apple 연구팀에 따르면 이미지 인코더의 처리 과정에 사용되는 데이터는 인코더의 성능에 직접적인 영향을 미칩니다. 이 모든 연구 결과는 다음과 같습니다. 이미지 해상도가 가장 큰 영향을 미치고, 모델 크기와 학습 데이터 구성이 그 뒤를 잇습니다.

MM1 매개변수

Apple의 연구소에 따르면 다중모달 대규모 언어 모델(MLLM)에서 매개변수의 크기보다 더 중요한 것은 해당 매개변수의 미세 조정, 확장 및 하이퍼파라미터입니다.

MM1 모델의 파라미터는 다양한 데이터 입력을 분석하고 처리하는 데 최대한 효율적으로 사용되었습니다. MM1 모델은 세 가지 파라미터 크기로 구성된 AI 모델 제품군입니다: 3B, 7B, 30B. 또한 MLLM의 파라미터 크기가 작을수록 모바일 기기에서 더 효율적으로 작동합니다.

모바일 기기와 데스크톱 모두에서 일상 업무나 전문적인 작업을 완료할 수 있도록 항상 지원하는 AI 비서를 찾고 있다면 TextCortex 을 주목하세요.

%20(5).png)

%20(20).png)