Meta AIは、2024年4月18日にLlama 3モデルを発表し、現在のAI技術にアプローチするLLMを導入しました。LLama 3 モデルは、その前身である LLama 2 モデルよりも進化していますが、全体としては GPT-3.5 や Claude 3 Sonnet などの中レベルの大規模言語モデルの競合相手です。Meta AIのLLama 3モデルは、前モデルと比較して、推論の改善、より多くのトレーニングされたデータ、言語理解を約束します。ラマ3モデルについて疑問に思っているなら、あなたは正しい場所にいます!

この記事では、Llama 3 モデルとその機能を一緒に探ります。

準備ができたら始めよう!

TL; DR

- Llama 3モデルは、Meta AIによって開発され、2024年4月18日に発表された大規模言語モデルです。

- Llama 3には、8Bと70Bの2つのモデルサイズがあります。

- Meta AI の公式 Web サイトにアクセスして Llama 3 モデルにアクセスできますが、Llama 3 は現在、すべての国で利用できるわけではありません。

- 世界中のラマ3モデルにアクセスしたい場合は、ZenoChatで TextCortex あなたの救世主です。

- Llama 3モデルは、ベンチマークでライバルのGemini Pro 1.5およびClaude 3 Sonnetモデルを上回った。

- Llama 3 モデルは、特別にフィルター処理された高品質の公開データでトレーニングされています。

- Llama 3 よりも優れた会話型 AI を探しているなら、ZenoChat TextCortex カスタマイズオプションとテキストおよび画像出力機能を備えたように設計されています。

Meta AIのラマ3レビュー

Llama 3モデルは、Meta AIが2024年4月18日に導入した大規模言語モデルです。Llama 3モデルは、前モデルと比較して機能と出力生成機能が向上しています。Llama 3モデルは、改善された推論、きめ細かな言語理解、および新機能により、幅広い業界で最先端のパフォーマンスを提供することを目的としています。

Llama 3モデルを開発する際のMeta AIのもう一つの目標は、その有用性を向上させることです。Meta AIは、開発中のラマ3モデルをコミュニティやAI開発者に公開することで、効率を高めることを目指しました。Meta AIのLlama 3モデルの今後の計画には、多言語およびマルチモーダル化、コンテキストウィンドウの増加、パフォーマンスの向上が含まれます。

ラマ3モデルサイズ

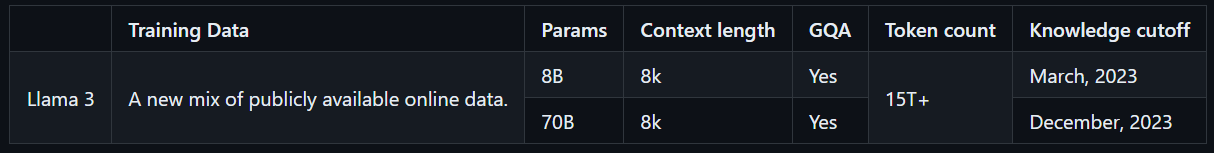

Llama 3には、さまざまなユースケースに適した8Bと70Bの2つのモデルサイズがあります。Llama 3 8Bモデルは、合計80億個のパラメータを持つよりコンパクトで、より高速に出力を生成できます。一方、Llama 3 70Bモデルは合計700億個のパラメータを持ち、複雑なタスクに適しています。さらに、Llama 3 8B モデルは 2023 年 3 月まで公開されているオンライン データでトレーニングされ、Llama 3 70B モデルは 2023 年 12 月まで公開されているオンライン データでトレーニングされます。

ラマ3にアクセスする方法は?

Llama 3モデルにアクセスするには、 Meta AIの公式Webサイトにアクセスし、[開始]ボタンをクリックして、手順に従います。ただし、Llama 3 モデルは世界中でアクセスできるわけではないため、他の LLM とは異なり、可用性スコアは低くなります。ただし、世界中でラマ3モデルを体験する方法があります。

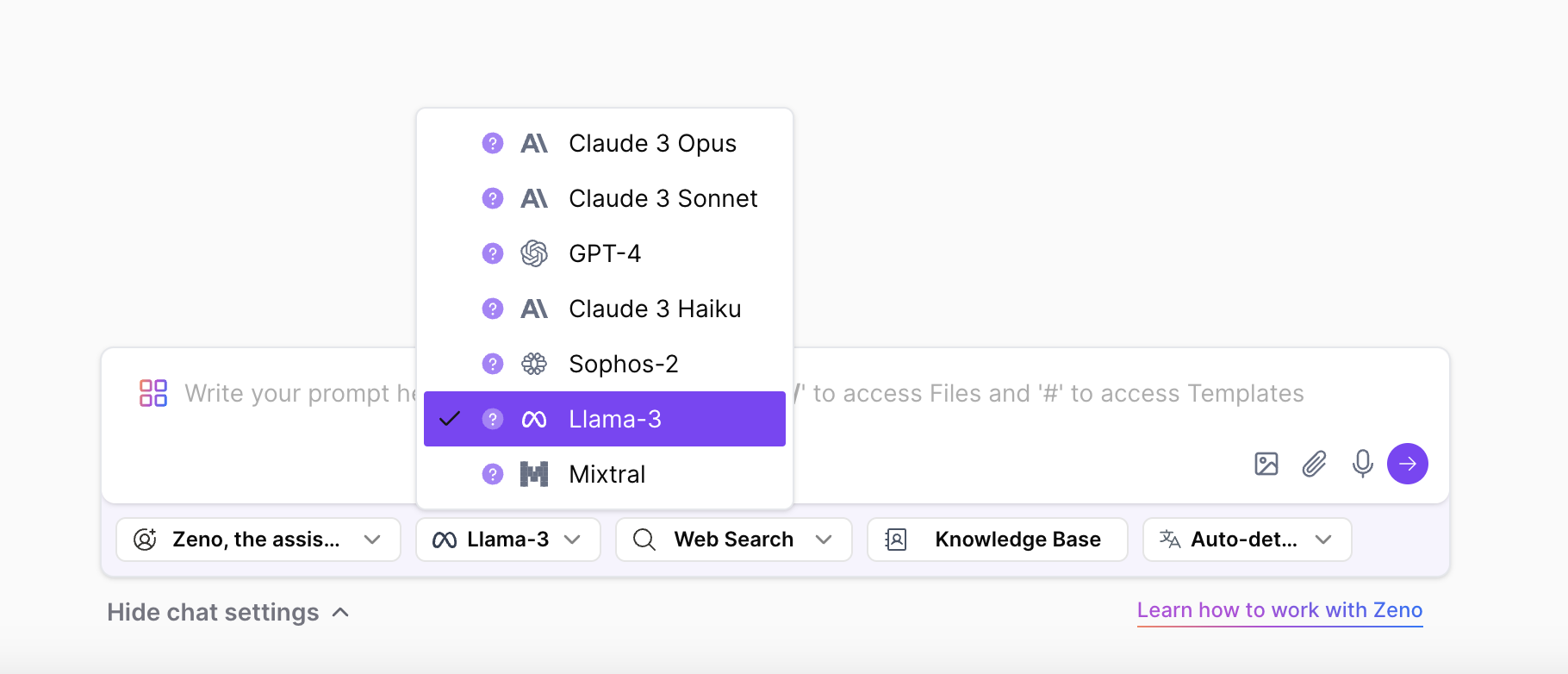

ZenoChatで TextCortexでは、Llama 3モデルの両方のサイズに制限なくアクセスして体験できます。ZenoChatは、GPT-4、Sophos 2、Mixtral、Claude 3 Opus、Sonnet LLMに加えて、Llama 3 8Bおよび70B LLMをサポートします。とはいえ、ラマ3モデルはMeta AIの国別制限なしで自由に体験できます。

Meta AIのLlama 3のコア機能

Meta AIの最新かつ最先端のモデルであるLlama 3は、前モデルよりも高いパフォーマンスと新機能を備えています。Llama 3モデルは、GPT-4やGemini UltraなどのハイエンドLLMではなく、GPT-3.5やGemini Proなどのより頻繁に使用されるモデルの競合として導入されました。Llama 3のコア機能を詳しく見てみましょう。

モデルのパフォーマンス

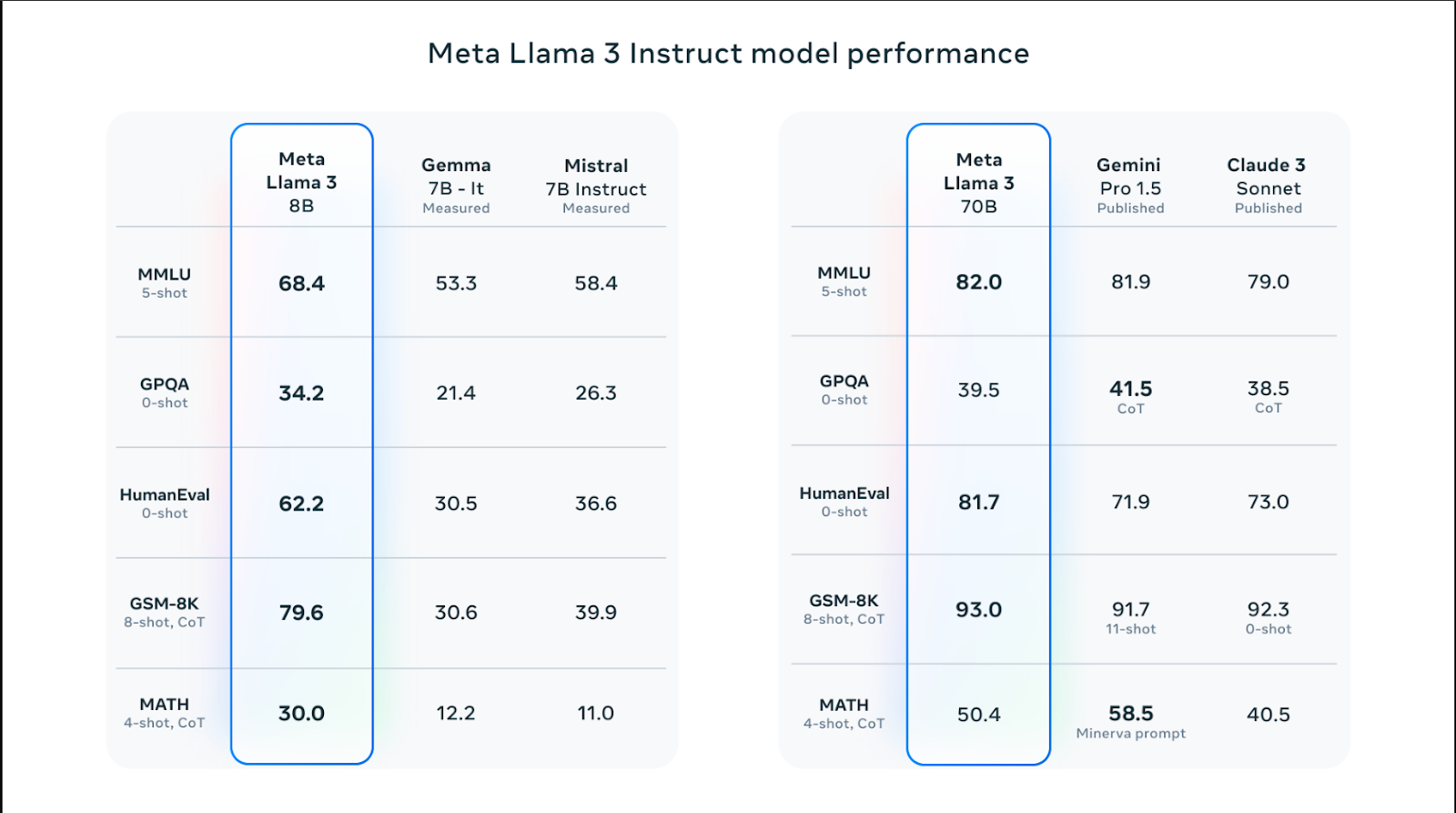

Llama 3 モデルにはさまざまなサイズがあり、推論、コード生成、数学、命令フォローなどのスキルにおいて Llama 2 モデルよりも優れたパフォーマンスを発揮します。Llama 3モデルの中で、70BモデルはMMLUベンチマークで82.0を獲得し、Claude 3 SonnetやGemini Pro 1.5などの人気モデルを上回りました。しかし、Llama 3 モデルは、数学のスキルを測定する MATH ベンチマークと、大学院レベルの Q&A スコアを測定する GPQA を除くすべてのベンチマークで、Claude 3 Sonnet および Gemini Pro 1.5 モデルよりも優れたパフォーマンスを発揮します。

Llama 3 8Bモデルは、Humaneval、MMLU、GPQA、GSM-8K、MATHのベンチマークで、ライバルのGemma 7BおよびMistral 7Bモデルを上回りました。言い換えれば、ラマ3のモデルサイズは、ライバルモデルよりも高いパフォーマンスを備えています。

トレーニング データ

Llama 3 モデルは、高性能な大規模言語モデルの構築に不可欠な大量のデータでトレーニングされています。具体的には、公開されているソースからの15Tトークンでトレーニングされており、これはLlama 2モデルのトレーニングに使用されたデータ量の7倍です。

さらに、Llama 3 モデルは、英語以外の 30 の異なる言語で構成される高品質のデータセットでトレーニングされました。これにより、モデルの言語理解、創造性、迅速な追従スキルが大幅に向上しました。

Meta AIチームは、高品質で信頼性の高いデータを使用してLlama 3モデルをトレーニングするための一連のデータ フィルタリング パイプラインを開発しました。これらのフィルターには、NSFW フィルター、ヒューリスティック フィルター、セマンティック重複排除アプローチ、テキスト分類子などのパラメーターが含まれます。また、ラマ2モデルは高品質なデータの識別に優れているため、ラマ3モデルの学習済みデータのフィルタリングに使用しました。

最適化

Llama 3モデルは、頻繁に使用されるGPUおよびCPUモデルおよびブランド向けに特別に最適化されています。特定のハードウェア用に最適化されたソフトウェアが多いほど、パフォーマンスが高くなり、実行速度が速くなります。Llama 3モデルは、Intel、AMD、およびNvidiaハードウェア用に最適化されています。さらに、IntelはLlama 3モデルのパフォーマンスに関する詳細なガイドを公開しています。

安全性

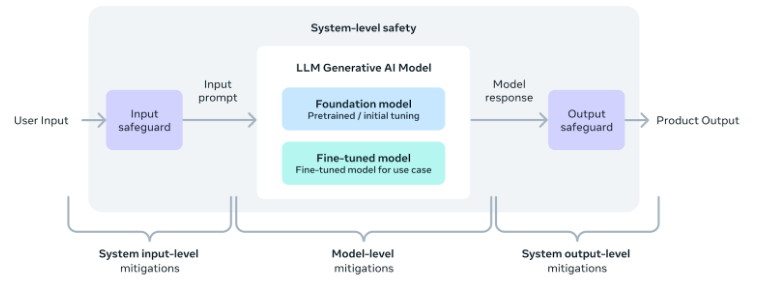

Meta AIチームは、Llama 3モデルを含むAIツールとソフトウェアを安全に使用することの重要性を認識しています。したがって、モデルの開発中に安全パラメータが追加され、その出力が安全で無害で倫理的であることを確認しました。

さらに、チームは、Llama 3モデルを使用してアプリケーションを開発したい人のために、システムレベルの安全実装 ガイド も提供しました。これらの対策を講じることで、ユーザーはAIツールの利便性とメリットを享受しながら、安全かつ責任ある方法で使用することができます。

より良い代替手段:ZenoChat TextCortex

Llama 3 モデルを含むさまざまな LLM にアクセスできるカスタマイズ可能な AI アシスタントをお探しの場合は、ZenoChat を TextCortex あなたのために設計されています。ZenoChatは、ユーザーにさまざまなLLMの利点を提供し、単一のLLMに制限しないAIツールです。ZenoChatは、テキストの生成、言い換え、調査などの専門的および日常的なタスクでユーザーを支援することを目的としています。ZenoChatを使用すると、あらゆるタスクを12倍高速化し、作業負荷を軽減し、生産性を飛躍的に向上させることができます。

ZenoChatは、Webアプリケーションおよびブラウザとして利用できますextension.ZenoChat ブラウザ extension 30,000 +のウェブサイトやアプリと統合されています。そのため、いつでもどこでもサポートし続けることができます。

独自の知識とデータで作業する

ZenoChatは、「ナレッジベース」と「個別ペルソナ」機能により、完全にカスタマイズ可能なAI体験を提供します。「個別ペルソナ」機能では、ZenoChatの出力スタイル、文章の長さ、文章中の支配的な感情、性格を自由に調整できます。つまり、この機能を使用して、ZenoChatをパーソナルアシスタントまたはデジタルツインに変えることができます。

ZenoChatの「ナレッジベース」機能では、ZenoChatが出力の生成に使用する データソース をアップロードまたは接続できます。この機能を利用することで、独自のデータでZenoChatをトレーニングし、特定のユースケースに適したものにすることができます。さらに、この機能のおかげで、1 つのプロンプトで数百ページのドキュメントを要約したり、PDF とチャットしたりできます。「ナレッジベース」機能には、GoogleドライブまたはMicrosoftOneDriveを数秒で統合できるボタンもあります。

%20(8).png)

%20(20).png)