Meta AIは2024年4月18日、同社が開発した大規模言語モデルの最新版「Llama 3」をリリースした。Llama 3は、競合他社に比べて高い性能を持つ大規模言語モデルで、特別なフィルタリング手法で選択されたデータセットで学習される。Llama 3モデルには2種類のサイズがある:8Bと70Bです。どちらのLlama 3モデルも、異なるユースケースに適しています。Llama 3モデルにご興味をお持ちの方、またどのようにアクセスすればよいかお悩みの方は、こちらをご覧ください!

この記事では、ラマ3とはどのようなモデルなのか、そしてどのようにアクセスできるのかを検証する。

準備はいいかい?さあ、飛び込もう!

TL; DR

- Llama 3はMeta AIが開発し、2024年4月18日に発表された大型言語モデルである。

- ラマには、3つの異なる使用例に適応する2つの異なるサイズがある:8Bと70Bです。

- Llama 3は、自然言語処理(NLP)、機械学習、ディープラーニングなどの技術を使用して出力を生成する。

- ラマ3モデルはオープンソースであるため、無料で使用できる。

- ラマ3モデルは、GPT-3.5やクロード3ソネットといったライバルモデルよりも、ほとんどのベンチマークで高い性能を発揮している。

- Llama 3モデルは、30以上の言語の高品質データを使用してトレーニングされました。

- ラマ3モデルにアクセスするには、それが利用可能な国からMeta AIアカウントにログインする必要があります。

ラマ3とは?

Llama 3は、Meta AIが開発したLarge Language Model(LLM)で、前モデルよりも高い性能を持つ。Llama 3を発表した際、Meta AIは微調整されたパラメータで学習させたと述べた。Llama 3モデルは、前モデルと比較して、推論、言語理解、速読、コーディング能力が向上している。Meta AIは、Llama 3モデルによって人工知能におけるイノベーションの次の波を起こすことを目指している。

ラマ3にアクセスする方法は?

ラマ3モデルは、小規模なタスクをこなすための効果的なソリューションだ。その主な利点は、クロード・ソネットやGPT-3.5モデルよりも優れていることと、オープンソースであることだ。Llama 3へのアクセス方法を詳しく見てみよう。

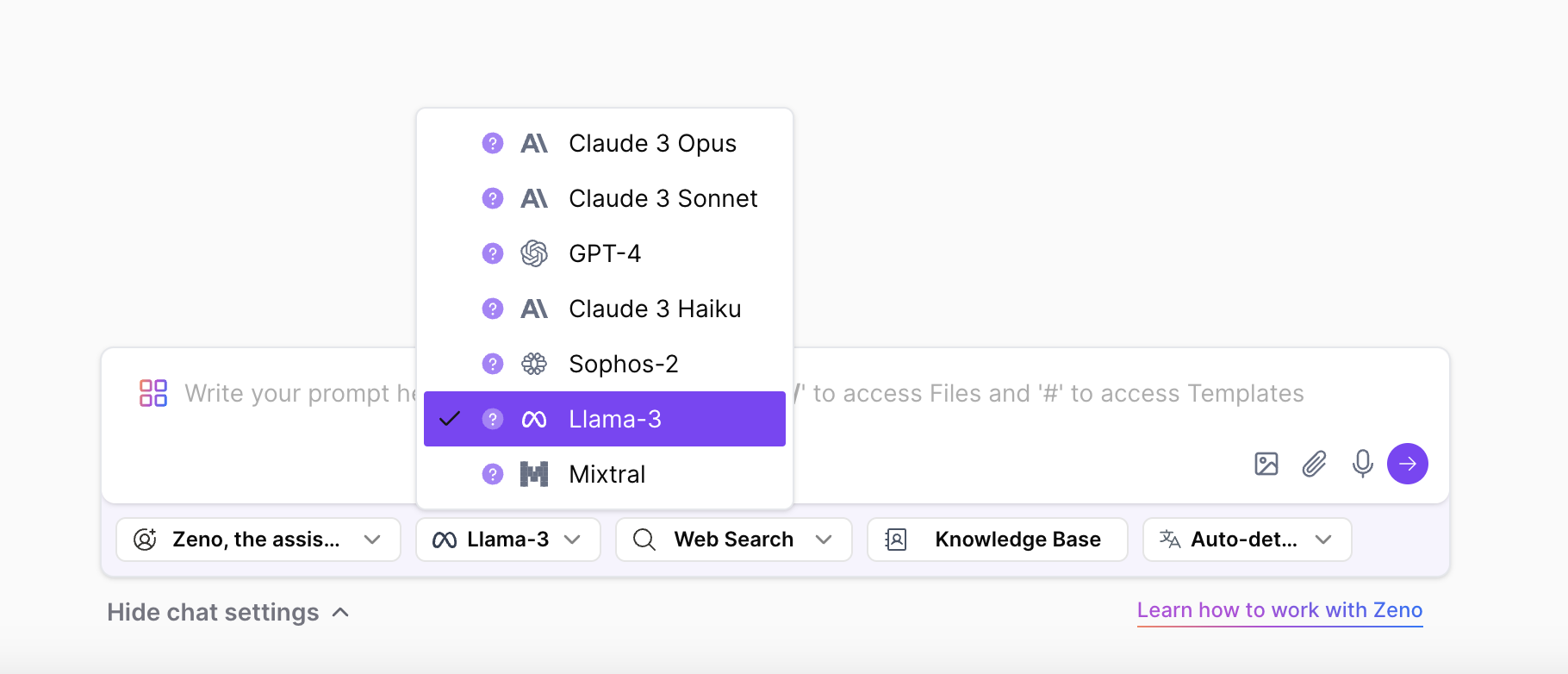

ZenoChatでラマ3にアクセスする

どの国からでもラマ3モデルとそのすべてのサイズを体験したいなら、TextCortex のZenoChatがあなたのために設計されている。ZenoChatは、様々なLLMをユーザーに提供し、ユーザーの作業負担を軽減することを目的としたAIアシスタントです。ZenoChatのチャット設定から、出力を生成するために使用したいLLMを選択するだけです。

ZenoChatを使用すると、テキスト生成、言い換え、翻訳、要約、文の展開、声のトーンの変更、文法とスペルの修正などのテキストベースのタスクを完了することができます。さらに、ZenoChatはDALL-E 3を搭載したAI画像生成機能もユーザーに提供している。ZenoChatはウェブアプリケーションとブラウザextension として利用可能です。ZenoChatブラウザextension は30,000以上のウェブサイトやアプリと統合されている。そのため、いつでもどこでもあなたに寄り添うことができます。

ワクワクする?ここをクリックして、TextCortex アカウントを無料で作成し、究極のAIアシスタントを体験してください。

メタAIでラマ3を体験

Meta AI経由でラマ3モデルにアクセスできる。Meta AIの公式サイトにアクセスしてアカウントを作成し、アクセス許可を申請するだけだ。ただし、ラマ3モデルが入手できるのは、アメリカ国外ではオーストラリア、カナダ、ガーナ、ジャマイカ、マラウイ、ニュージーランド、ナイジェリア、パキスタン、シンガポール、南アフリカ、ウガンダ、ザンビア、ジンバブエのみである。これらの国以外では、"Meta AI isn't available yet in your country "というメッセージが表示される。

ラマ3モデルサイズ

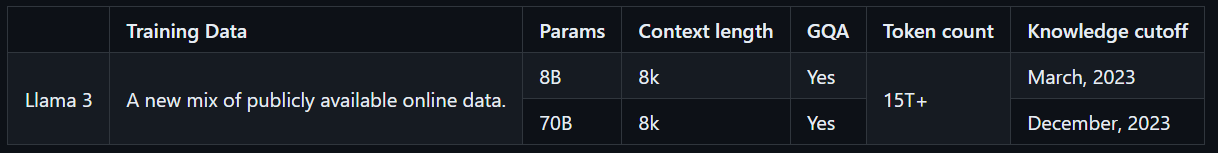

Llama 3モデルには2つのサイズがあり、さまざまな用途に合わせてカスタマイズできます。8Bモデルは単純なタスクを迅速かつ正確に処理するのに適しており、70Bモデルはより大規模で複雑なタスクを高品質な結果で処理するように設計されています。どちらのモデルも、Llama 2モデルのトレーニングに使用されたトークンの7倍にあたる、15T以上のトークンでトレーニングされています。さらに、Llama 3モデルは、高品質の非英語データで訓練されているため、多言語機能を備えています。

ラマ3はどのように機能するのか?

Llama 3モデルは、自然言語処理(NLP)、ディープラーニング、機械学習などのAI技術を用いて出力を生成します。LLama 3モデルは、ユーザーが入力した入力を学習済みのデータとパラメータで分析し、ユーザーの意図を理解し、必要な出力を生成する。

Llama 3モデルは、安全で適切な出力を保証するために、特別なフィルタリングシステムを通過したデータを使用して訓練されている。これには、NFSWフィルター、ヒューリスティック・フィルター、セマンティック重複排除アプローチ、テキスト分類器の使用が含まれる。さらに、Llama 3モデルに先立って開発されたLlama 2モデルは、高品質なデータの識別に成功したため、Llama 3モデルのトレーニングに使用するデータの選択に利用されました。

ラマ3は無料で使えますか?

Meta AIは、Llamaモデルシリーズをオープンソースで自由に使えると宣伝してきたが、Llama 3も例外ではない。現在リリースされているLlama 3 8Bと70Bはオープンソースなので、誰でもこれらのモデルを体験することができる。しかし、Llama 3シリーズの中で最も先進的なLlama 3 400Bはまだトレーニング中であり、無料で使用できるかどうかはまだ明らかではない。

ラマ3の特徴

ラマ3は、競合他社よりも高い性能を持つ2つの異なるモデルを搭載してリリースされた。この2つのモデルが競合他社よりも高い性能を持つ理由は、特殊なフィルタリングによって特定されたデータを使ってトレーニングされているからだ。Llama 3のモデルは、市場に出回っている他のLLMと比べてユニークな特徴を持っている。Llama 3の特徴を詳しく見てみよう。

パフォーマンスとベンチマーク

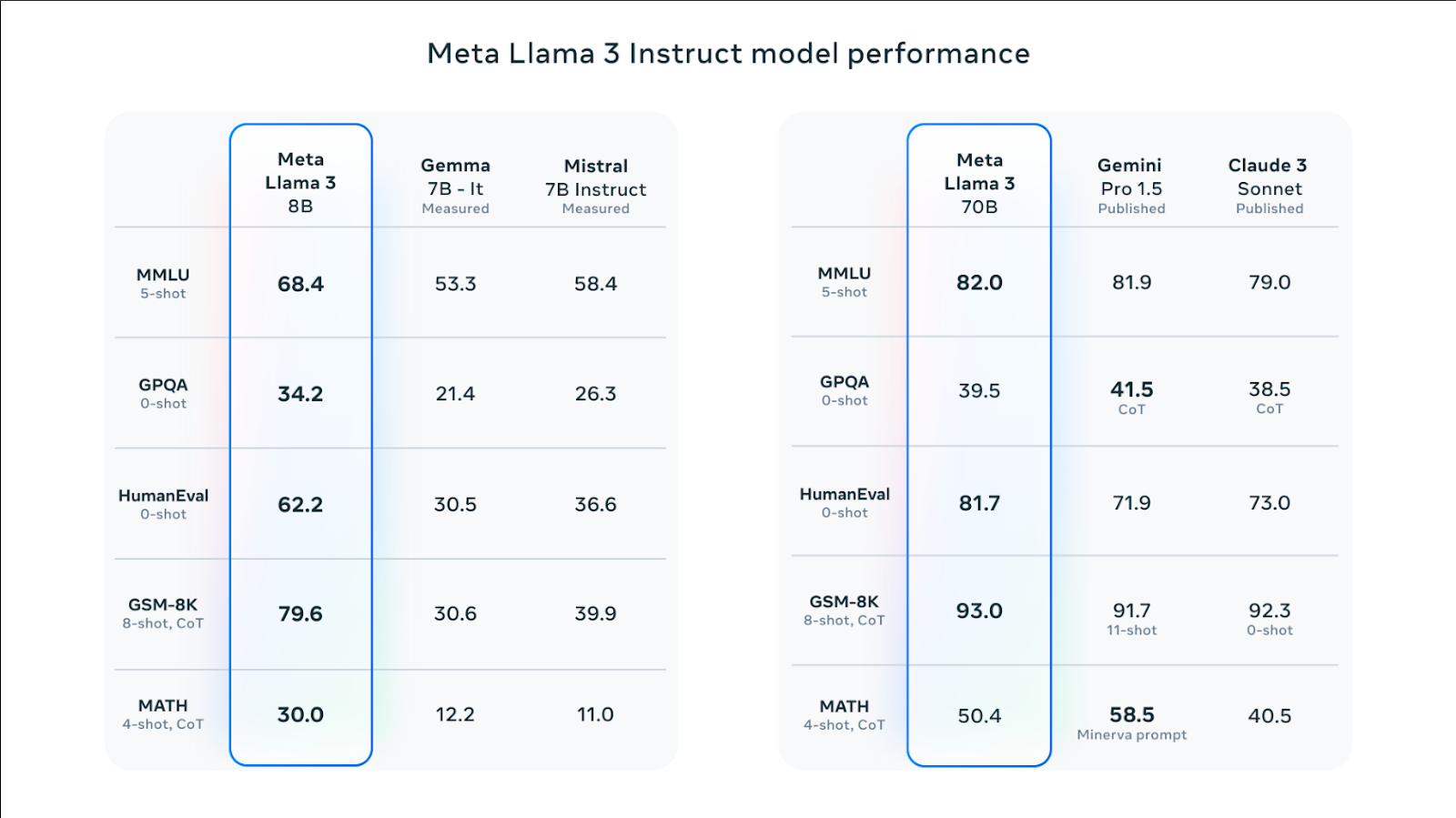

Llama 3 8BとLlama 3 70Bの両モデルは、HumanEval、MMLU、DROPなどのベンチマークで、競合モデルよりも高いスコアを示している。例えば、Llama 3 70Bモデルは、MMLUベンチマークにおいて、同等モデルのGemini Pro 1.5およびClaude 3Sonnetと比較してわずかに高いパフォーマンスを示している。Llama 3 8Bモデルは、競合モデルであるGemma 7BおよびMistral 7Bよりも総合性能が高い。

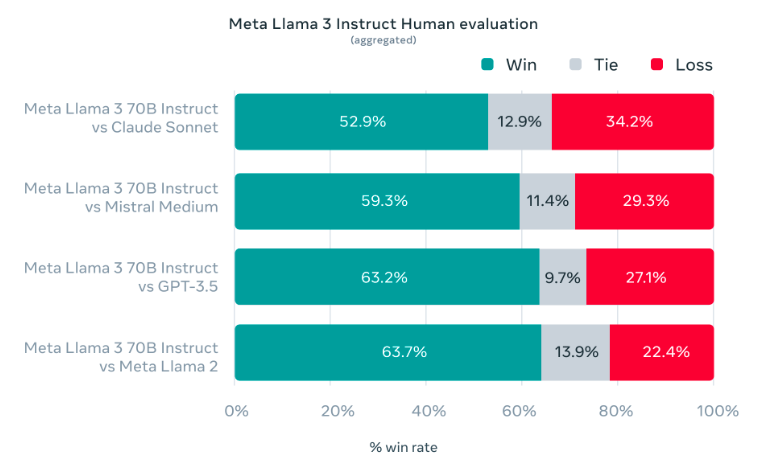

ラマ3モデルの開発では、実験室環境でのテストではなく、実際のユースケースで高いパフォーマンスを実証することを目指した。このため、Meta AIチームは、質の高い人間評価セットを新たに開発した。この評価セットは、12の主要なユースケースをカバーする1800のプロンプトで構成されている。プロンプトには、アドバイスを求める、コーディング、ブレーンストーミング、クリエイティブライティング、Q&A、推論、リライト、要約などのタスクが含まれています。Meta AIのLLama 3モデルは、ライバルのClaude Sonnet、GPT-3.5、Mistral Mediumと比較して、これらのテストで高いパフォーマンスを示しました。

迅速な理解

ラマ3モデルは、教師あり微調整(SFT)と人間フィードバック付き強化学習(RLHF)を用いて訓練されているため、プロンプトフォローにおいて前モデルよりも成功している。ラマ3モデルの訓練では、役に立つ安全な出力を生成することが優先された。

Llama 3モデルの学習済みデータの5%は、30以上の言語の高品質な文法、文章構造、クリエイティブ・ライティングをカバーしています。このため、Llama 3モデルは他言語のユーザーによるプロンプトを分析し、他言語のユーザーのプロンプトを理解することができます。

モデル建築

Llama 3モデルのトレーニングには、デコーダのみのトランスフォーマーアーキテクチャが使用された。Meta AIの記事によると、Llama 3は128Kのトークンの語彙を持つトークナイザーを使用しており、より効率的に言語をエンコードすることで、モデルのパフォーマンスを大幅に向上させている。Llama 3モデルの8Bサイズと70Bサイズの両方が、8,192個のトークンのシーケンスでトレーニングされた。

Meta AIは、Llama 3モデルの学習に、データ並列化、モデル並列化、パイプライン並列化の組み合わせを用いた。そのため、GPU上でのLlama 3モデルの処理速度を上げつつ、作業負荷を軽減することを目的としている。Llama 3モデルが最も効果的に動作するシステムは、GPUあたり400 TFLOPSです。Llama 3モデルは、エラー検出、処理、およびメンテナンスシステムを使用して、実行中のGPU速度を最大化します。

%20(11).png)

%20(20).png)