Claude 3, Anthropic's neuestes und fortschrittlichstes Large Language Model (LLM), konkurriert mit fortschrittlichen und beliebten KI Modelle auf dem Markt in Bezug auf Leistung und Fähigkeiten und Llama 2 ist keine Ausnahme. Das Modell Claude 3 von Anthropic hat es geschafft, das Modell Llama 2 sowie andere beliebte und fortschrittliche LLMs zu übertreffen.

In diesem Artikel werden wir uns mit den Modellen Claude 3 und Llama 2 und den Unterschieden zwischen ihnen befassen.

Sind Sie bereit? Lasst uns eintauchen!

TL; DR

- Claude 3 ist das neueste und fortschrittlichste große Sprachmodell, das von Anthropic entwickelt und am 4. März 2024 eingeführt wurde.

- Claude wird in 3 verschiedenen Größen geliefert, die für 3 verschiedene Aufgaben konzipiert sind: Haiku, Sonnet und Opus.

- Für den Zugriff auf die Claude 3-Modelle können Sie die offizielle Website von Anthropic nutzen oder die Website TextCortex aufrufen, die diese mit erweiterten Funktionen kombiniert.

- Llama 2 ist ein großes Sprachmodell, das von Meta AI entwickelt wurde und in drei verschiedenen Modellgrößen erhältlich ist: 7B, 13B und 70B.

- Obwohl das Modell Claude 3 dem Modell Llama 2 in Bezug auf Leistung und Kontextfenster überlegen ist, ist Llama 2 für Forschung und kommerzielle Nutzung kostenlos.

- Wenn Sie auf der Suche nach einer besseren Konversations-KI als Claude 3 und Llama 2 sind, ist ZenoChat von TextCortex genau das Richtige für Sie.

Claude 3 Rückblick

Claude 3 ist ein von Anthropic entwickeltes Modell, das die fortschrittlichsten großen Sprachmodelle übertreffen kann. Mit Claude 3 können Sie neue und einzigartige text- oder codebasierte Ausgaben generieren, eine menschenähnliche Konversation erleben oder Ihre sich wiederholenden alltäglichen Aufgaben automatisieren.

Claude 3 Modellgrößen

Claude 3 Large Language Model wird mit drei verschiedenen Modellgrößen geliefert, die für unterschiedliche Aufgaben und Anwendungsfälle konzipiert sind:

- Haiku: Haiku, das kleinste Mitglied der Claude-3-Familie, ist für die Automatisierung grundlegender Aufgaben konzipiert.

- Sonnet: Das Sonnet-Modell, das mittlere Modell der Claude-3-Familie, ist für die Erledigung mittlerer Aufgaben konzipiert und hat eine höhere Leistung als das GPT-3.5-Modell.

- Opus: Das Modell Opus, das größte Mitglied der Claude-3-Familie, ist für hochkomplexe Aufgaben konzipiert und leistungsfähiger als GPT-4.

Claude 3 Preise

Während Sie für die Verwendung des Claude 3 Sonnet-Modells keine Gebühr zahlen müssen, benötigen Sie ein Claude Pro-Abonnement im Wert von 20 $, um das Claude 3 Opus-Modell als KI-Chatbot zu verwenden. Wenn Sie Claude 3-Modelle als API verwenden möchten, ist Preise wie folgt:

- Claude 3 Haiku: $0,25 pro Million Token Input, $1,25 pro Million Token Output

- Claude 3 Sonnet: $3 pro Million Token Input, $15 pro Million Token Output

- Claude 3 Opus: $15 pro Million Token Input, $75 pro Million Token Output

Wie kann ich Claude 3 erreichen?

Um auf das Claude 3-Modell zuzugreifen, müssen Sie lediglich ein Anthropic-Konto anlegen. Danach können Sie die Claude-3-Modelle über die Webschnittstelle claude.ai ausprobieren.

Eine weitere Möglichkeit, die Claude 3 Modelle zu erleben, ist ZenoChat von TextCortex. Mit ZenoChat können Sie mit allen Claude 3-Modellen experimentieren, einschließlich Opus, Sonnet und Haiku.

Was ist Llama 2?

Llama 2 ist eines der beliebten großen Sprachmodelle, die von Meta AI entwickelt und eingeführt wurden. Das Llama 2-Modell ist so konzipiert, dass es auf harmlose und hilfreiche Ausgaben reagiert, indem es die Eingaben der Benutzer analysiert. Darüber hinaus ist das Llama 2-Modell auch ein nützliches LLM für Codegenerierungsaufgaben. Außerdem ist Llama 2 für Forschung und kommerzielle Nutzung kostenlos.

Llama 2 Modellgrößen

Das Modell Llama 2 wird mit drei Modellen mit verschiedenen Parametergrößen geliefert: 7B, 13B, und 70B. Diese Modelle wurden mit Techniken wie der Verarbeitung natürlicher Sprache, Verstärkungslernen aus menschlichem Feedback, Belohnungsmodellen und maschinellem Lernen trainiert. Obwohl diese Modelle mit dem GPT-3.5-Modell konkurrieren können, haben die Claude-3-Modelle eine höhere Leistung.

Was kann Llama 2 generieren?

Mit dem Modell Llama 2 können Sie textbasierte Ausgaben wie Geschichten, Gedichte, Artikel, blog Beiträge, Essays und E-Mails erstellen. Außerdem können Sie damit Ihre vorhandenen Texte neu schreiben oder in eine andere Sprache übersetzen.

Darüber hinaus bietet das Modell Llama 2 seinen Nutzern die Möglichkeit, Ausgaben in Programmiersprachen zu erzeugen. Mit Llama 2 können Sie Ausgaben für jede beliebige Programmiersprache erzeugen oder Ihre prompten technischen Aufgaben erledigen.

Wie erhalte ich Zugang zu Llama 2?

Sie können das Modell Llama 2 und seine 3 verschiedenen Größen über die offizielle Website von Meta AI abrufen. Außerdem können Sie diese Modelle herunterladen und für Ihre Forschung oder kommerzielle Zwecke verwenden.

Anthropic's Claude 3 vs. Meta AI's Llama 2 Vergleich

Wir haben nun grundlegende Informationen über das Modell Claude 3 von Anthropic und das Modell Llama 2 von Meta AI. Als Nächstes können wir diese beiden großen Sprachmodelle unter verschiedenen Gesichtspunkten vergleichen und herausfinden, welches Modell für Sie ideal ist!

Leistungsunterschied

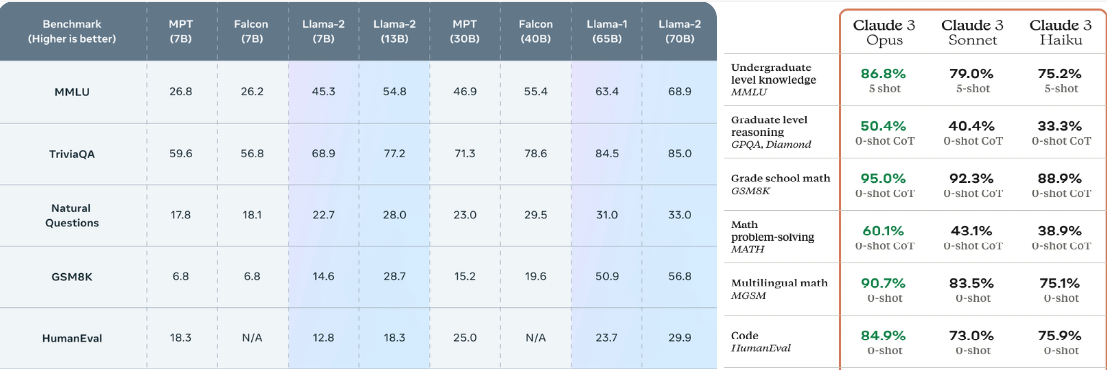

Alle Größen des Modells Claude 3 erzielen bei den Benchmarks höhere Werte als das Modell Llama 2. Während beispielsweise das Modell 70B, die fortschrittlichste Größe des Modells Llama 2, im MMLU-Benchmark eine Punktzahl von 68,9 % erreicht, kommt Haiku, die kleinste Größe des Modells Claude 3, im selben Benchmark auf 75,2 %. Der gleiche Unterschied in der Punktzahl ist auch bei anderen Leistungsbenchmarks wie GSM8K und HumanEval zu beobachten. Mit anderen Worten: Das Modell Claude 3 übertrifft das Modell Llama 2 in Bezug auf seine Leistung.

Kontext-Fenster

Während die Llama-2-Modelle den Benutzern ein Kontextfenster von 4096 Token bieten, bieten die Claude-3-Modelle ein Kontextfenster von 200K Token. In diesem Vergleich bietet Anthropic ein größeres Kontextfenster als die Llama-2-Modelle, sogar mit dem Claude-2-Modell. Mit dem Modell Claude 3 vergrößert sich dieser Unterschied jedoch erheblich. Mit anderen Worten: Wenn Sie Aufgaben haben, die die Arbeit mit großen Datenmengen erfordern, ist Claude 3 die bessere Wahl.

Preise

Während Sie für die Nutzung des Modells Claude 3 als API eine Gebühr entrichten müssen, können Sie das Modell Llama 2 kostenlos nutzen und integrieren. Andererseits können Sie über claude.ai kostenlos mit dem Modell Claude 3 Sonnet chatten, das eine höhere Leistung als alle Größen des Modells Llama 2 bietet. Wenn Sie jedoch mit einem KI-Chatbot mit dem Modell Claude 3 Opus chatten möchten, benötigen Sie ein Claude Pro-Abonnement im Wert von 20 $.

Eine bessere Alternative für beide: ZenoChat

Wenn Sie auf der Suche nach einem konversationellen KI-Assistenten sind, der mehr Funktionen und erweiterte Möglichkeiten als Claude 3 und Llama 2 bietet, ist ZenoChat genau das Richtige für Sie. ZenoChat ist eine konversationelle KI, die Benutzer bei der Erledigung ihrer täglichen und beruflichen Aufgaben unterstützt, ihre Arbeitsbelastung reduziert und die Produktivität steigert. ZenoChat ist als Webanwendung und im Browser extension verfügbar. Der ZenoChat-Browser extension ist in mehr als 30.000 Websites und Apps integriert, so dass er Sie überall und jederzeit unterstützen kann.

ZenoChat bietet eine vollständig anpassbare KI-Erfahrung durch unsere Funktionen "Individuelle Personas" und "Wissensdatenbanken". Mit der Funktion "Individuelle Personas" können Sie den Ausgabestil, den Tonfall, die Persönlichkeit, die Einstellung und die vorherrschende Emotion in den Antworten von ZenoChat nach Ihren Wünschen anpassen. Mit anderen Worten: Mit dieser Funktion können Sie ZenoChat so gestalten, wie Sie es wünschen.

Unsere Funktion "Wissensdatenbanken" ermöglicht es Ihnen, die Datensätze hochzuladen oder zu verbinden, die ZenoChat bei der Ausgabe verwenden wird. Mit dieser Funktion können Sie ZenoChat für Ihre spezifischen Taxis trainieren, mit Ihren PDFs chatten oder große Datenmengen mit einer einzigen Eingabeaufforderung zusammenfassen.

%20(1).png)

%20(15).png)

%20(14).png)