Während sich die KI mit voller Geschwindigkeit weiterentwickelt, ist Apple in diesen Sektor eingestiegen und hat verschiedene und neue Ansätze für das Training eines MLLM (Multimodal Large Language Model) entdeckt. Beim Training des MM1-Modells bot Apple eine effektivere Methode an, indem es den traditionellen Trainingsprozess des Multimodal Large Language Model anpasste. Bei dieser Methode werden große Mengen an Datensätzen mit geeigneten Parametern und Hyperparametern effektiv genutzt. Wenn Sie sich fragen, wie das MM1-Modell funktioniert, sind Sie hier genau richtig!

In diesem Artikel werden wir untersuchen, was das MM1-Modell ist und wie es funktioniert.

Sind Sie bereit? Lasst uns eintauchen!

TL; DR

- Das MM1 von Apple ist ein multimodales, umfangreiches Sprachmodell, das mit einem einzigartigen Ansatz zum Vortraining und zur Feinabstimmung entwickelt wurde.

- Das Apple MM1-Modell wurde mit drei verschiedenen Parametergrößen veröffentlicht: 3B, 7B und 30B.

- Während das Apple MM1 Modell in einigen Benchmarks die Modelle GPT-4 und Gemini Ultra übertrifft, bleibt es in anderen mit geringem Abstand zurück.

- Während des Trainings des Apple MM1-Modells wurden Bild-Encoder, Bild-Sprache-Verbindungen und Trainingsphasen für Daten neu gestaltet.

- Wenn Sie einen KI-Assistenten brauchen, der Sie im Alltag und im Berufsleben unterstützt, ist TextCortex genau das Richtige für Sie.

- TextCortex zielt darauf ab, Ihre Arbeitslast zu automatisieren und Ihre Produktivität mit seinen einzigartigen Funktionen und fortschrittlichen KI-Funktionen zu steigern.

Was ist Apple MM1?

Das MM1-Modell von Apple ist ein Multimodal Large Language Model (MLLM), das für die Bewältigung visuell basierter Aufgaben mit hoher Leistung und minimalen Systemanforderungen entwickelt wurde. Dieses Modell wurde mit einem einzigartigen und neuen Ansatz für den MLLM-Trainingsvorgang entwickelt. Dieser Ansatz zielt auf maximale Effizienz bei minimalen Parametern ab.

Apples MM1-Modellgrößen

Das multimodale Großsprachenmodell Apple MM1 wurde auf drei verschiedene Größen skaliert, jeweils mit einer unterschiedlichen Anzahl von Parametern: 3B, 7B, und 30B. Außerdem wurden diese Modelle mit einem Mixture-of-Experts (MoE)-Ansatz skaliert. Diese Skalierung ist der entscheidende Faktor für die unvergleichliche Leistung von MM1 sowohl in der Pre-Trainingsphase als auch in der Feinabstimmung.

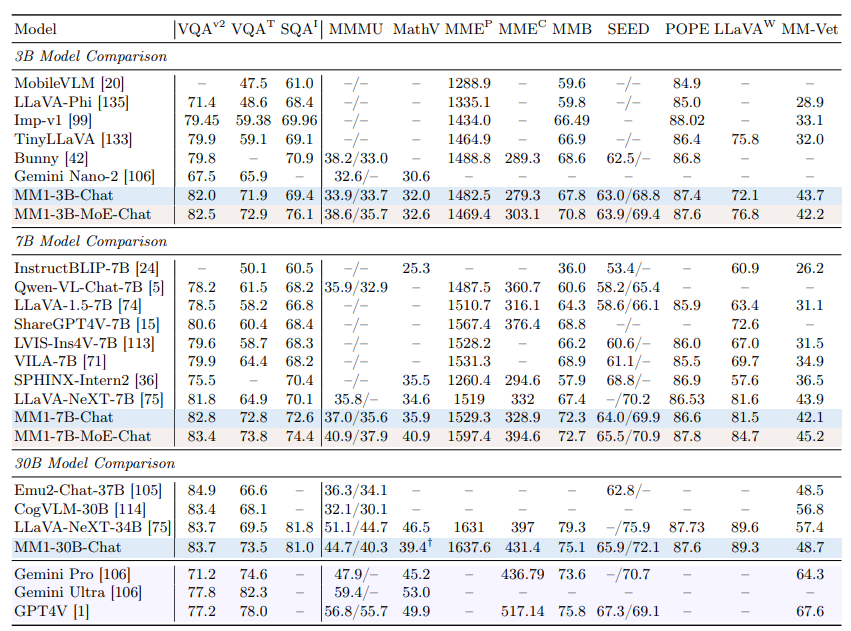

Ist MM1 besser als ChatGPT?

Dank seiner hohen Leistung in der Pre-Training- und Feinabstimmungsphase kann das Apple MM1 Modell mit Modellen wie GPT-4V und Gemini Ultra konkurrieren und sie in einigen Benchmarks sogar übertreffen. So konnte das MM1 30B Modell beispielsweise sowohl das GPT-4 Vision Modell als auch das Gemini Ultra Modell im VQAv2 Benchmark übertreffen. Bei anderen Benchmarks ist zu erkennen, dass das MM1-Modell etwas schlechter abschneidet als die Modelle Gemini Ultra und GPT-4.

Wie kann ich auf MM1 zugreifen?

Da Apple das MM1-Modell noch nicht öffentlich zugänglich gemacht hat, ist es uns nicht möglich, es in irgendeiner Weise zu erleben. Das Apple-Forschungslabor hat jedoch erklärt, dass alle MM1-Größen bald verfügbar sein werden.

Wie funktioniert das MM1 von Apple?

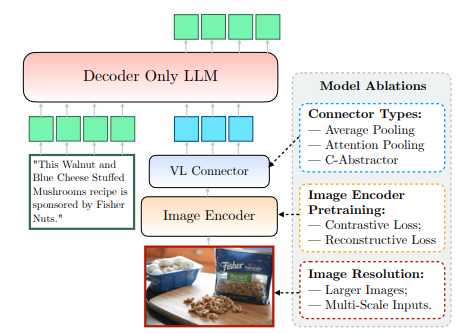

Das MM1-Modell von Apple, das noch nicht öffentlich zugänglich ist, wurde auf eine neue und einzigartige Weise trainiert, die über die herkömmlichen Methoden hinausgeht. Nach Angaben des Apple-Forschungslabors ist es für das Training eines Modells mit maximaler Effizienz notwendig, die komplexe Beziehung zwischen dem architektonischen Design von MLLM und der Integration verschiedener Datensätze zu untersuchen. Diese Methode zielt darauf ab, mit minimalen Parametern maximale Effizienz zu erreichen. Diese Informationen können wir dem von Apple veröffentlichten Papier entnehmen. Schauen wir uns genauer an, wie Apples MM1 funktioniert.

Bild-Encoder

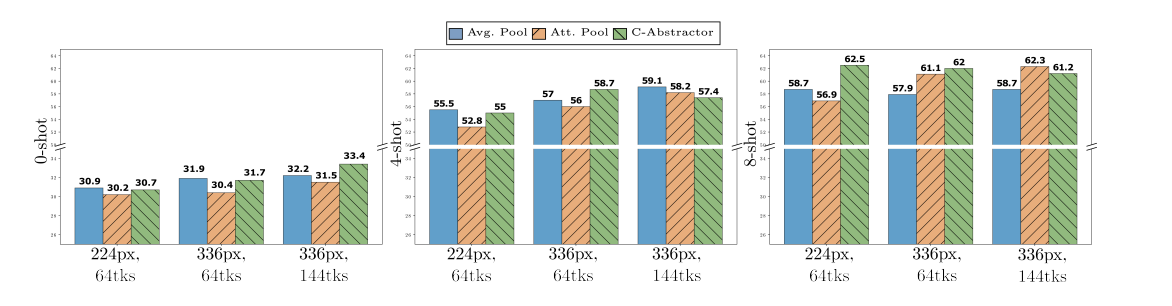

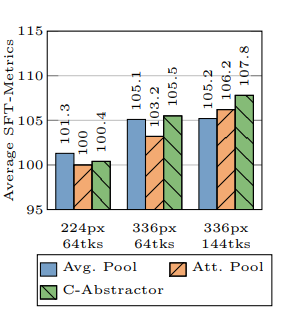

Beim Training des MM1-Modells stellte das Apple Research Lab fest, dass die Bildauflösung den größten Einfluss auf den Trainingsprozess hat. Das MM1-Modell wurde mit Bildern mit einer Auflösung von 378x378 Pixeln trainiert. Dieser Trainingsprozess wurde mit den Deep-Learning-Modellen ViT-H (Vision Transformer - Huge) und CLIP (Contrastive Language-Image Pretraining) durchgeführt. Während das ViT-H-Modell von Google für die Bildklassifizierung entwickelt wurde, ist CLIP für die Einbettung von Bildern nützlich, die von OpenAI entwickelt wurden.

Vision-Sprache-Verbindung

Laut dem Apple-Forschungslabor sind bei der Entwicklung eines MLLM die Auflösung eines Bildes und die Anzahl der visuellen Token von entscheidender Bedeutung, um den Trainingsprozess auf die nächste Stufe zu heben, wenn man eine hohe Leistung bei visuell basierten Aufgaben erreichen will. Das Apple-Forschungslabor hat bei der Entwicklung des MM1-Modells einen VL-Anschluss mit 144 Token verwendet.

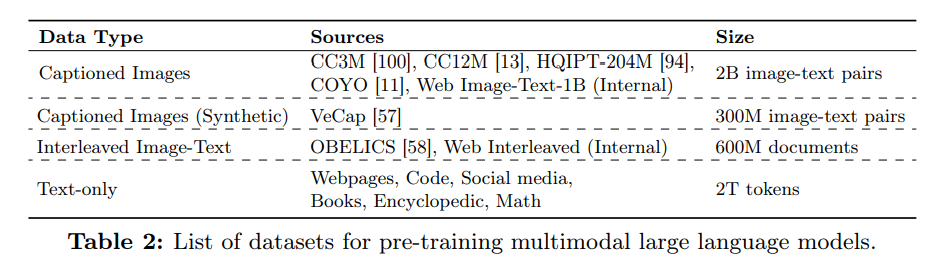

Mit welchen Daten wurde Apple MM1 trainiert?

Die trainierten Daten eines Multimodal Large Language Model (MLLM) dienen sowohl als Gedächtnis als auch als Wissen, das es zur Generierung von Ausgaben verwendet. Je vielfältiger und umfangreicher die trainierten Daten eines MLLM sind, desto prägnantere Ergebnisse kann es daher produzieren.

Das Apple-Forschungslabor nutzte eine große Menge an Daten, die aus Text und Bildern bestanden, um die Leistung des MM1-Modells bei Null- und wenigen Aufnahmen zu verbessern. Laut Apples Artikel wird das MM1-Modell mit einer Datenmenge trainiert, die zu 45 % aus verschachtelten Bild-Text-Dokumenten, zu 45 % aus Bild-Text-Paardokumenten und zu 10 % aus reinen Textdokumenten besteht.

%20(6).png)

%20(15).png)

%20(14).png)