Während alle großen Unternehmen wie Google, Microsoft und Meta begonnen haben, auf dem Gebiet der künstlichen Intelligenz zu arbeiten und eine fortschrittliche KI Modelle nach der anderen produzieren, hat Apple, das Unternehmen, das übrig geblieben ist, an diesem KI-Rennen mit seinem multimodalen großen Sprachmodell namens MM1 teilgenommen. Dieses Modell wurde sowohl mit Textdaten als auch mit visuellen Daten trainiert. Das multimodale große Sprachmodell MM1 wurde mit einer Mischung aus beschrifteten Bildern (45 %), verschachtelten Bild-Text-Dokumenten (45 %) und reinen Textdaten (10 %) trainiert.

In diesem Artikel werden wir herausfinden, was das multimodale große Sprachmodell MM1 von Apple ist.

Wenn Sie bereit sind, lassen Sie uns beginnen!

TL; DR

- MM1 ist eine multimodale große Sprachmodellfamilie, die von Apple entwickelt und angekündigt wurde.

- Das MM1-Modell wurde im Gegensatz zu den traditionellen MLLMs mit einer anderen Trainings- und Aufbaumethode entwickelt.

- Beim Aufbau des MM1-Modells wurden die Architektur, die trainierten Daten, der Bildkodierer, die Parameter, die Hyperparameter und das Trainingsverfahren neu erstellt, um effektiv zu sein.

- Das Modell MM1 hat eine geringere Anzahl von Parametern und eine geringere Größe als seine Konkurrenten, so dass es problemlos auf mobilen Geräten eingesetzt werden kann.

- Wenn Sie auf der Suche nach einem KI-Assistenten sind, der immer bei Ihnen ist, z. B. auf mobilen Geräten, ist TextCortex mit seiner Integration von mehr als 30.000 Websites und Apps der richtige Weg.

- TextCortex bietet eine Vielzahl von anpassbaren und interaktiven KI-Lösungen, vom Schreiben bis hin zu Ihren beruflichen Aufgaben.

Was ist Apple MM1?

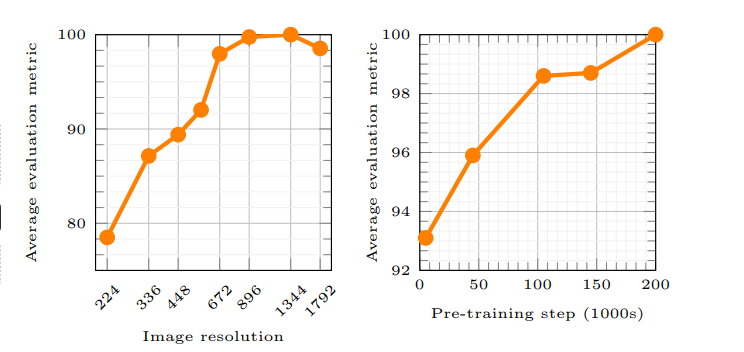

Apples MM1 ist ein Multimodal Large Language Model (MLLM), das sowohl Text- als auch visuelle Prozesse verarbeiten und generieren kann. Dem Apple-Artikel zufolge ermöglicht das Arbeitsprinzip des MM1-Modells der KI ein besseres Verständnis von Benutzereingaben und die Erzeugung der gewünschten Ausgabe. Beim Training des MM1-Modells kamen neue Methoden zum Einsatz, die besagen, dass die Bildauflösung und die Kapazität des visuellen Encoders den größten Einfluss auf die Modellleistung haben.

Fällt Apple im Rennen um die KI zurück?

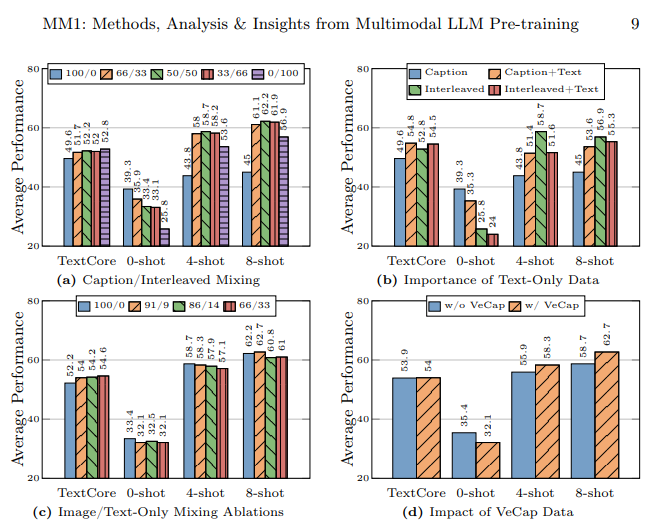

Das Apple-Forschungslabor wollte ein leistungsstarkes multimodales großes Sprachmodell (MLLM) entwickeln, indem es zahlreiche KI-Trainings- und -Erstellungsmethoden sorgfältig untersuchte. Laut Apples Artikel wird durch die Verwendung verschiedener Datentypen beim Training eines KI-Modells, durch die Verwendung von Bild-Text-Dokumenten beim Lernen mit wenigen Aufnahmen, durch die Verwendung von Bildunterschriften zur Steigerung der Zero-Shot-Leistung und durch die Verwendung von reinen Textdaten unterstrichen, dass ein starkes Sprachverständnis für die Verbesserung der Leistung wichtig ist.

Wie wurde das Modell MM1 gebaut?

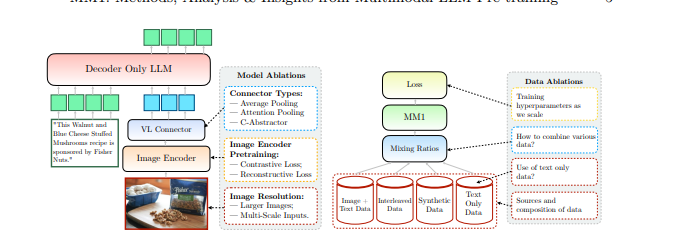

Apple erwähnte, dass es bei der Erstellung des MM1-Modells über traditionelle Methoden hinausging und dass diese Methoden notwendig waren, um ein leistungsstarkes Multimodal Large Language Model (MLLM) zu erstellen. Apple berücksichtigt bei der Erstellung des MM1-Modells drei grundlegende Schritte:

- Architektur: Das Team des Apple-Forschungslabors untersuchte Methoden zur Verbindung verschiedener vortrainierter Bildkodierer und LLMs mit diesen Kodierern, um eine einzigartige Architektur aufzubauen.

- Trainierte Daten: Das MM1-Modell wird mit Datensätzen trainiert, die verschiedene Arten von Daten enthalten, z. B. Bild- und Textdaten sowie Kombinationen dieser Daten.

- Trainingsverfahren: Anstatt mit einer großen Anzahl von Parametern zu trainieren, wurde das MM1-Modell trainiert, indem man sich auf die Hyperparameter konzentrierte und darauf, in welchem Stadium sie verwendet werden.

Apples MM1-Funktionen

Das MM1 Multimodal Large Language Model (MLLM) von Apple verfügt im Vergleich zu herkömmlichen MLLMs über andere Trainingsmethoden, weniger Parameter und andere Ansätze für den Trainingsprozess. Apple gibt an, dass das MM1-Modell durch die Entdeckung der effizientesten Methoden und das Ausprobieren von Innovationen für das Training eines MLLM entwickelt wurde. Werfen wir einen genaueren Blick auf die Fähigkeiten und Trainingsunterschiede des MM1-Modells.

Architektur

Das MM1-Modell hat eine andere Architektur als andere MLLMs (Multimodal Large Language Models). Diese Architektur umfasst Kodierer mit höherer Bildauflösung, einen anderen Ansatz für den Pre-Trainingsprozess und das Mischen gelabelter Daten, um die Gesamtleistung eines einzelnen Prompts zu steigern. Das Forschungslabor von Apple konzentriert sich auf die Bedeutung verschiedener Datenauswahlen für das Training des MM1-Modells. Mit anderen Worten: Das MM1-Modell hat eine Architektur, die darauf abzielt, mit weniger Ressourcen eine höhere Leistung zu erzielen als herkömmliche MLLMs.

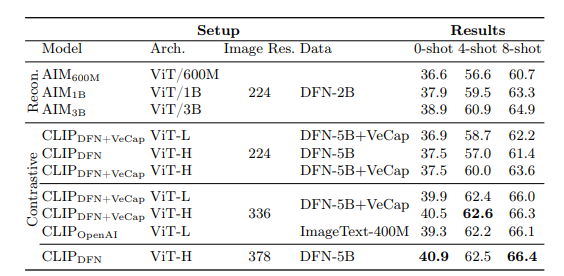

Bild-Encoder

Die meisten multimodalen großen Sprachmodelle verwenden vortrainierte CLIP (Contrastive Language-Image Pretraining) Bildkodierer zur Verarbeitung visueller Daten. Jüngste Studien zeigen außerdem, dass selbstüberwachte Modelle, die nur auf das Sehen ausgerichtet sind, effektiver arbeiten. Durch die Analyse dieser Kodierer hat das Apple-Forschungsteam herausgefunden, dass die effektivste Methode, ein MLLM mit visuellen Daten zu trainieren, in den für die Kodierer ausgewählten Bildern besteht. Dem Apple-Forschungslabor zufolge wirken sich die Daten, die bei der Verarbeitung eines Bild-Encoders verwendet werden, direkt auf die Leistung des Encoders aus. Das Ergebnis all dieser Untersuchungen ist folgendes: Die Bildauflösung hat den größten Einfluss, gefolgt von der Modellgröße und der Zusammensetzung der Trainingsdaten.

MM1 Parameter

Wichtiger als die Größe der Parameter in einem Multimodal Large Language Model (MLLM) sind laut dem Apple Forschungslabor die Feinabstimmung, Skalierung und Hyperparameter dieser Parameter.

Die Parameter des MM1-Modells wurden mit maximaler Effizienz für die Analyse und Verarbeitung verschiedener Dateneingaben verwendet. Das MM1-Modell ist eine Familie von KI Modelle , die aus drei verschiedenen Parametergrößen besteht: 3B, 7B und 30B. Je kleiner die Parametergröße eines MLLMs ist, desto effizienter arbeitet es auf mobilen Geräten.

Wenn Sie auf der Suche nach einem KI-Assistenten sind, der Sie sowohl auf Mobilgeräten als auch auf Desktops unterstützt, um Ihnen bei der Erledigung Ihrer täglichen oder beruflichen Aufgaben zu helfen, sollten Sie TextCortex auf Ihrem Radar behalten.

%20(5).png)

%20(15).png)

%20(14).png)