GPT-4VはOpenAIによって設計されたマルチモーダルモデルで、視覚入力を分析し、それを使って出力を生成します。GPT-4Vは、ユーザーが視覚的な入力を入力し、その入力に関する質問に対する応答を生成することができます。言い換えれば、GPT-4Vモデルを使えば、どのような種類の画像でも分析し、その画像に関する情報を得ることができます。

この記事では、GPT-4Vの特徴と、それがあなたのために何ができるかを検証する。

TL;DR

- GPT-4Vは、視覚入力で与えられたクエリに対する出力を生成するように設計された大規模なマルチモーダルモデルである。

- GPT-4Vは、与えられた画像を使って分析し、あなたの質問に答え、画像内の数学的問題を解くことができます。

- GPT-4Vに入力する画像にビジュアルポインタを追加することで、より効率的な出力を得ることができます。

- GPT-4Vは、提供されたビデオフレームを使用して、高い精度でビデオ分析タスクを完了することができます。

- もしあなたが、あなた独自の知識とスタイルで完全にカスタマイズ可能なAIインタラクションを体験できる代替AIアシスタントを探しているなら、TextCortex 。

GPT-4Vの特徴

GPT-4Vは、仕事でも日常生活でも、さまざまな場面でユーザーをサポートする機能を搭載したモデルだ。その機能を詳しく見ていこう。

安全性とプライバシー

マイクロソフトはGPT-4Vに関する報告書の中で、モデルを開発する際、開発チームはオンラインや2023年4月以降にアクセスできない画像を使用したと述べている。また、この方法により、GPT-4Vの入力をよりよく分析し、正しく安全な出力を生成する能力が向上した。このように、GPT-4Vモデルは出力を生成する際にオンラインデータを使用せず、実際の人間レベルの分析と対応スキルを使用している。

マルチリンガリズム

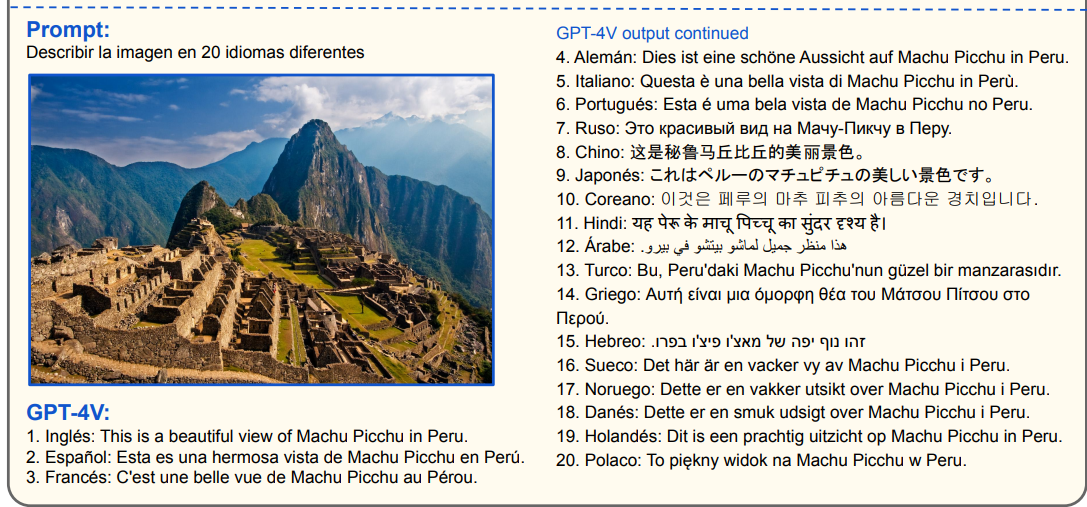

マイクロソフトの文書によると、GPT-4Vモデルは中国語、フランス語、チェコ語など20言語の入力を分析し、出力を生成できる。さらに、GPT-4Vモデルは、これらの20言語の視覚的入力のテキストを読んで応答を生成することができます。さらに、これらの入力を異なる言語に翻訳したり要約したりすることもできます。この機能は、知らない言語の標識を読む必要がある場合に役立つだろう。

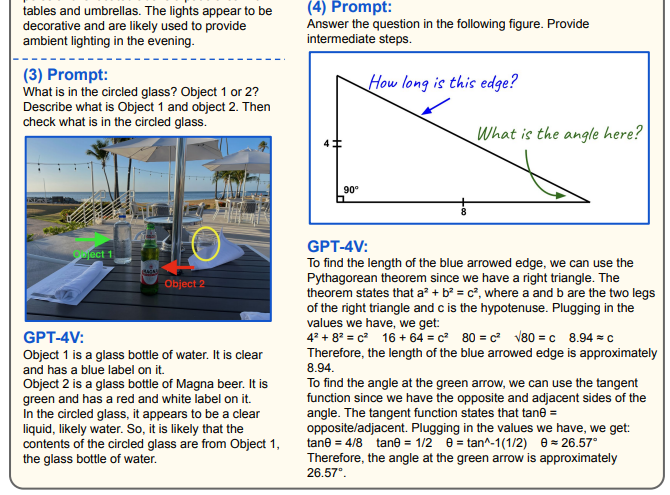

視覚的な促し

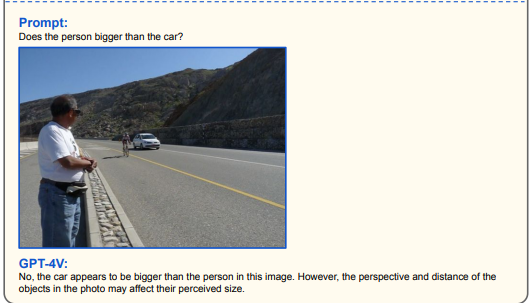

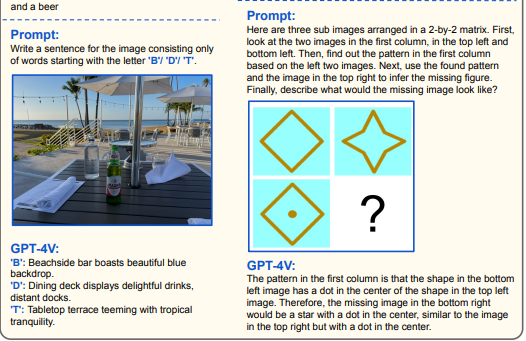

GPT-4Vを効果的に使うには、マイクロソフトがビジュアル・リファリング・プロンプティングと呼んでいる全く新しいプロンプト方式を使う必要がある。このプロンプト方式では、入力として使用する画像に関連するクエリを入力する必要があります。

また、GPT-4Vモデルは、「画像について説明してください」といった簡単なプロンプトでも使用できます。しかし、その限界に挑戦したいのであれば、複雑な数学の問題やコーディングのタスクを求めることもできます。

ビジュアル・ポインター

GPT-4Vは、与えられたビジュアルに関連するプロンプトを分析することによって、ユーザーに最も有用な答えを与えることを目的としています。マイクロソフトのドキュメントによると、GPT-4Vは画像に描かれたビジュアルポインタを使用して、より効果的な出力を生成します。画像内の特定の領域の情報を分析したい場合、ビジュアルポインタを使用してプロンプトを入力することで、より一貫性のある出力を得ることができます。

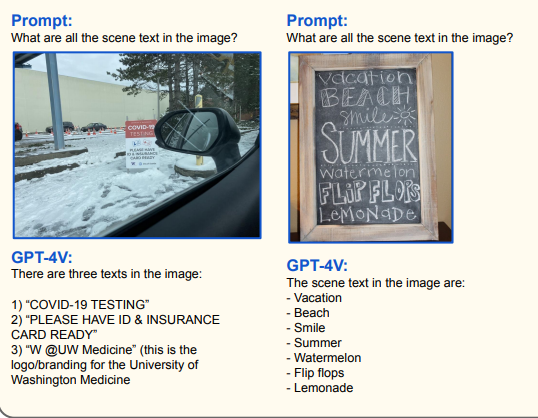

シーンテキストとチャート推論

GPT-4Vは、各画像に含まれる文字、数字、データを認識し、その情報をもとに出力を生成することに成功している。GPT-4Vのモデルは、与えられた入力を視覚とリンクさせて分析し、プロンプト上のコマンドや質問に応答します。GPT-4Vは以下のような作業を高い精度で行うことができます:

- ビジュアル・マス

- チャートの理解と推論

- テーブル認識

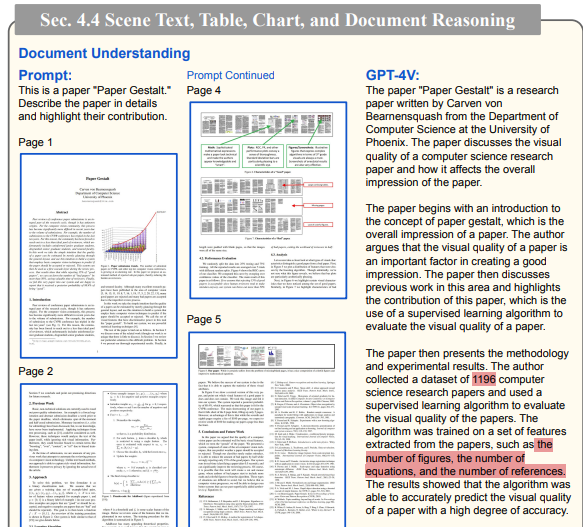

- ドキュメント理解

研究者たちはGPT-4Vに「ペーパー・ゲシュタルト」のモデルページを入力として与え、すべてのデータを分析するよう依頼した。GPT-4Vは、ほとんど正しく紙面を分析することができた。

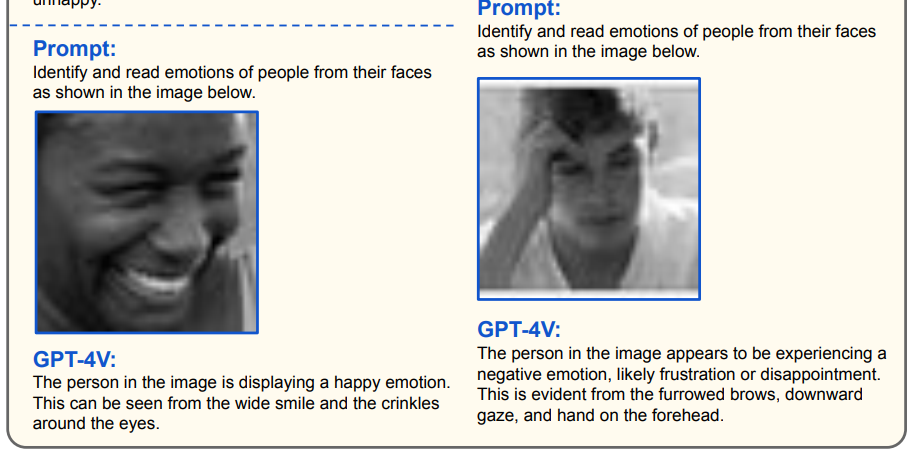

感情検出

GPT-4Vのモデルは、与えられたポートレートや顔の入力から人の顔を分析し、感情に関する判断を生成することができる。もしあなたがポーカーフェイスでなければ、AIはあなたの感情を理解することで、あなたを分析することができると言えます。GPT-4Vモデルは特に、幸福、驚き、軽蔑、悲しみ、恐怖、嫌悪、怒りの7つの普遍的な表情を理解することに成功している。

GPT-4Vで何ができるのか?

GPT-4Vモデルには、ユーザーにさまざまなメリットを提供する印象的な改良と機能が搭載されている。GPT-4Vで何ができるのか、一緒に考えてみよう。

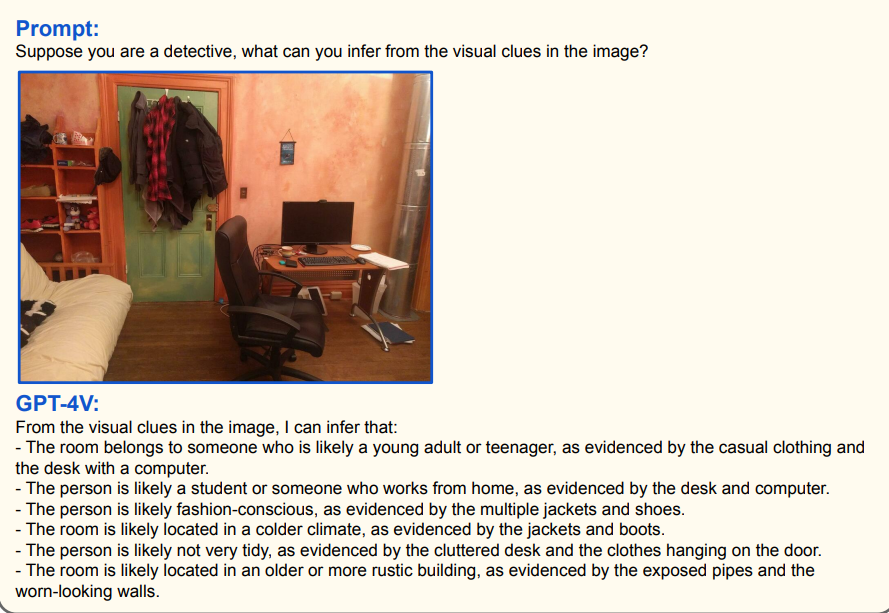

画像の分析

GPT-4Vモデルは、与えられたビジュアルを分析し、ユーザーのプロンプトに従って出力を生成する成功したAIです。このため、GPT-4Vモデルを使用して、数学の問題や本の翻訳を完成させたり、さまざまなシナリオのビジュアルを分析したりすることができます。例えば、部屋の画像をGPT-4Vに提供することで、その画像に関する探偵分析を出力することができます。

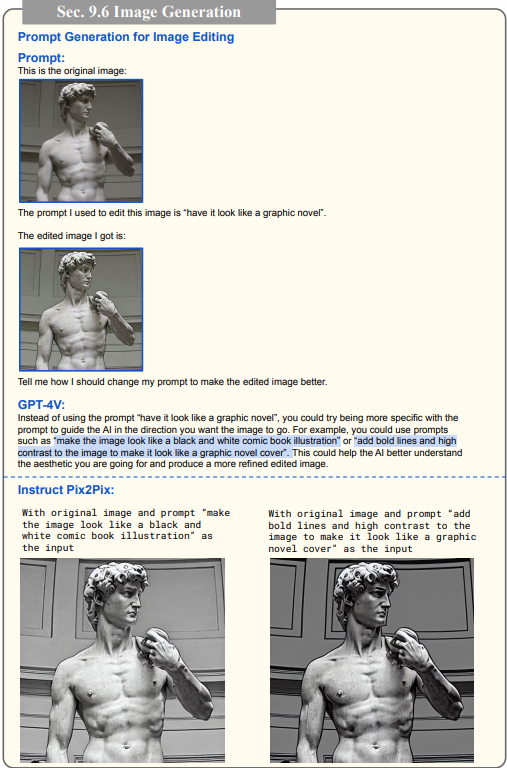

画像プロンプト生成/編集

GPT-4Vモデルに画像とテキスト要件を提供することで、画像を自由に編集できるプロンプトを得ることができます。GPT-4Vは、あなたのプロンプト・エンジニアリング・スキルを次のレベルに引き上げ、プロンプト・ライティングの手助けを得たいとお考えの方のために設計されたモデルです。

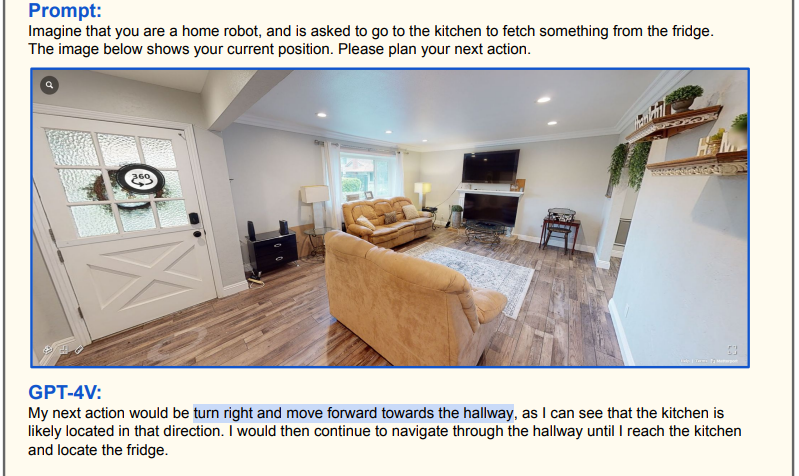

ナビゲーション

GPT-4Vに部屋や道路、高速道路などの画像を与えることで、ナビゲーションを出力することができます。例えば、GPT-4Vに部屋の画像を与え、その画像の任意の地点に行くように指示することで、経路を描画し、テキスト形式で出力することができます。

ロボットを開発し、技術コンテストやフェスティバルに参加する場合、GPT-4Vを使用することでロボットをよりスマートにすることができます。

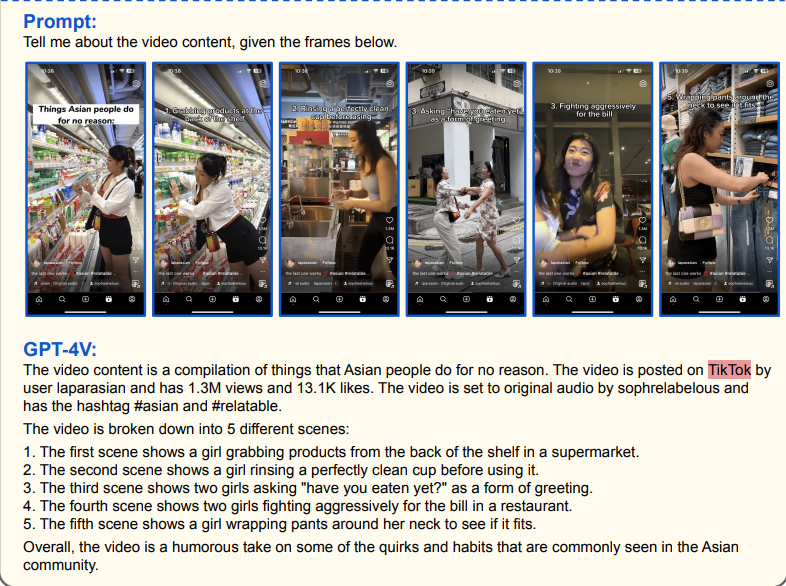

ビデオ分析

現代社会では、新しいテーマを学んだり、あるテーマに関する情報を得たりする最も効果的な方法の1つは、情報ビデオを見ることです。しかし、情報を得るために何時間もビデオを見たくない場合は、GPT-4Vモデルを使用してビデオを分析することができます。GPT-4Vは、与えられたフレームを分析し、詳細で一貫性のある説明を生成することができます。

TextCortex AI - あなたの対話型AIアシスタント

TextCortexは、テキスト生成、音声によるテキスト書き換え、ウェブ検索など、さまざまな機能を提供するAIアシスタントだ。ウェブアプリケーションやブラウザextension として利用可能です。TextCortex ブラウザextension は20.000以上のウェブサイトやアプリと統合されているため、インターネット上でいつでもどこでもあなたをサポートし続けることができます。

ライティング機能に加え、TextCortex 、欧州ChatGPTの代替であるZenoChatも提供しています。さらに、私たちのチームは、TextCortex に新しい AI テクノロジーを追加し、大規模なマルチモーダルモデル(LMM)の機能をユーザーに提供するために取り組んでいます。ここをクリックして、フリーミアムTextCortex アカウントを作成し、最新のAI機能を体験してください!

%20(11).png)

%20(24).png)

%20(21).png)