AIが全速力で発展し続ける中、アップルはこの分野に参入し、MLLM(Multimodal Large Language Model)をトレーニングするための異なる新しいアプローチを発見した。MM1モデルをトレーニングする際、アップルは従来のMultimodal Large Language Modelのトレーニングプロセスをカスタマイズすることで、より効果的な方法を提供した。この方法では、適切なパラメータとハイパーパラメータを持つ大量のデータセットを効果的に使用する。MM1モデルがどのように機能するのか不思議に思っているなら、あなたは正しい場所にいます!

この記事では、MM1モデルとは何か、どのように機能するのかを探っていく。

準備はいいかい?さあ、飛び込もう!

TL; DR

- アップルのMM1は、独自の事前学習と微調整のアプローチで開発されたマルチモーダル大規模言語モデルである。

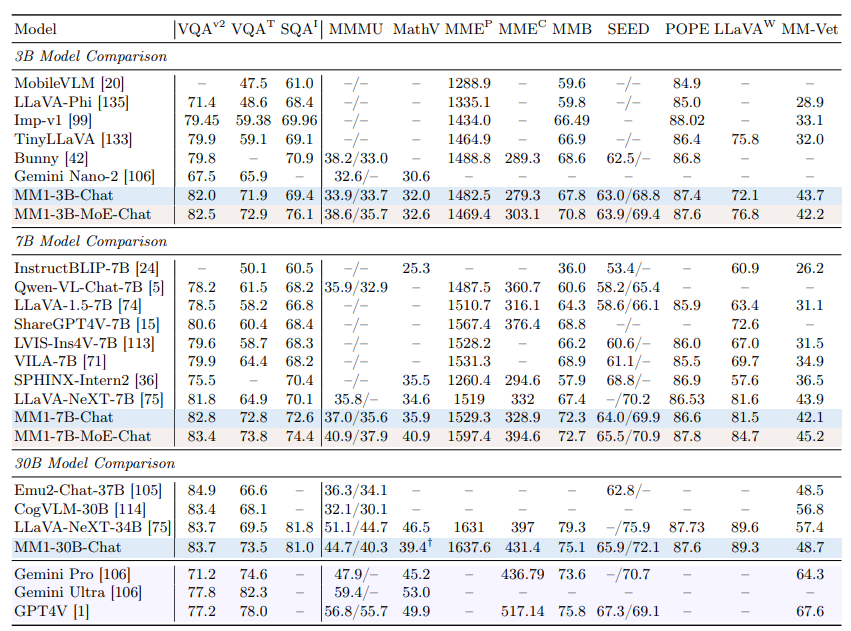

- アップルMM1モデルは、3つの異なるパラメータサイズでリリースされた:3B、7B、30Bである。

- アップルMM1モデルは、いくつかのベンチマークではGPT-4とジェミニ・ウルトラモデルを上回っているが、他のベンチマークではわずかな差で遅れをとっている。

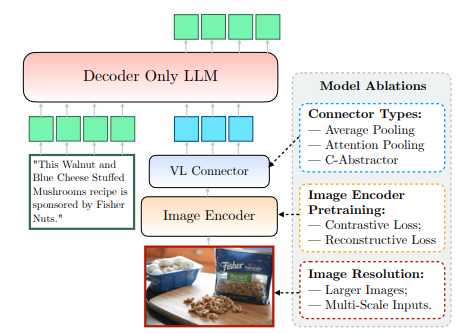

- アップルMM1モデルのトレーニング中、画像エンコーダー、視覚言語コネクター、学習データフェーズが再設計された。

- 日常生活と仕事の両方であなたをサポートするAIアシスタントが必要なら、TextCortex 。

- TextCortex は、そのユニークな機能と高度なAI機能により、作業負荷を自動化し、生産性を高めることを目的としている。

アップルMM1とは?

アップルのMM1モデルは、視覚ベースのタスクを高いパフォーマンスと最小限のシステム要件で完了するように設計されたマルチモーダル大規模言語モデル(MLLM)です。このモデルは、MLLMのトレーニングプロセスに対するユニークで新しいアプローチで開発されました。このアプローチは、最小のパラメータで最大の効率を目指すものです。

アップルのMM1モデルのサイズ

アップルMM1マルチモーダル大規模言語モデルは、3つの異なるサイズにスケールアップされ、それぞれパラメータの量が異なる:3B、7B、30Bである。さらに、これらのモデルはMoE(mixture-of-experts)アプローチを用いてスケーリングされている。このスケーリングが、事前学習と微調整の両段階におけるMM1の圧倒的なパフォーマンスを支える重要な要因となっている。

MM1はChatGPTより優れていますか?

プリトレーニングとファインチューニングの段階での高い性能のおかげで、アップルMM1モデルはGPT-4VやGemini Ultraなどのモデルと競合することができ、いくつかのベンチマークではそれらを上回ることさえあります。例えば、MM1 30Bモデルは、VQAv2ベンチマークにおいてGPT-4 VisionモデルとGemini Ultraモデルの両方を上回ることができました。他のベンチマークに関しては、MM1モデルの性能がGemini UltraモデルやGPT-4モデルよりもわずかに低いことがわかる。

MM1にアクセスするには?

アップルはまだMM1モデルを公開していないため、私たちがそれを体験することはできない。しかし、アップルの研究所は、MM1の全サイズが間もなく利用可能になると述べている。

アップルのMM1はどのように機能するのか?

まだ一般公開されていないアップルのMM1モデルは、従来の方法を超えた、新しくユニークな方法で訓練されている。アップルの研究所によると、最大効率でモデルを訓練するためには、MLLMのアーキテクチャ設計と多様なデータセットの統合との複雑な関係を調べる必要があるという。この方法は、最小のパラメータで最大の効率を得ることを目的としている。アップル社の論文から、この情報に明確にアクセスすることができる。アップルのMM1がどのように機能するかを詳しく見てみよう。

画像エンコーダー

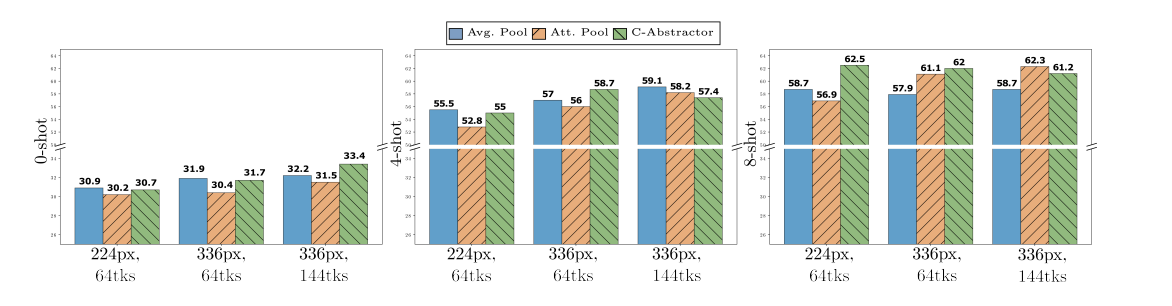

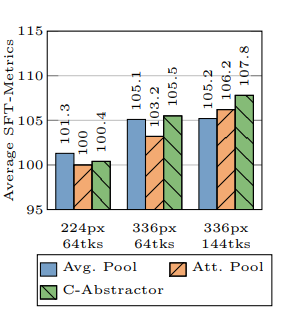

アップル研究所は、MM1モデルのトレーニング中に、画像の解像度がトレーニングプロセスに最も大きな影響を与えることを発見した。MM1モデルは、378x378ピクセルの解像度を持つ画像でトレーニングされた。このトレーニング・プロセスは、ViT-H(Vision Transformer - Huge)とCLIP(Contrastive Language-Image Pretraining)というディープ・ラーニング・モデルを使って行われた。ViT-HモデルはGoogleが画像分類用に設計したものだが、CLIPはOpenAIが設計した画像を埋め込むのに有効だ。

視覚言語コネクタ

アップル・リサーチ・ラボによると、MLLMを開発する際、視覚ベースのタスクで高い性能を発揮させたいのであれば、画像の解像度と視覚トークンの数が、学習プロセスを次のレベルに引き上げるために不可欠だという。アップル・リサーチ・ラボはMM1モデルを開発する際、144個のトークンを持つVLコネクタを使用しました。

アップルMM1はどのデータでトレーニングされたのか?

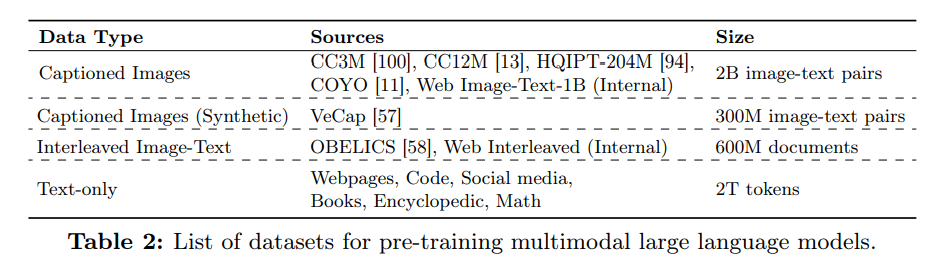

マルチモーダル大規模言語モデル(MLLM)の学習データは、その記憶と出力生成に使用する知識の両方の役割を果たす。したがって、MLLMの学習データが多様で広範であればあるほど、より簡潔な出力を生成することができる。

アップル社の研究所では、MM1モデルのゼロショットと少数ショットの性能を高めるために、テキストと画像からなる大量のデータを利用した。アップル社の記事によると、MM1モデルは、45%のインターリーブされた画像とテキストの文書、45%の画像とテキストのペアの文書、10%のテキストのみの文書を含む様々なデータを使用して学習される。

%20(6).png)

%20(20).png)