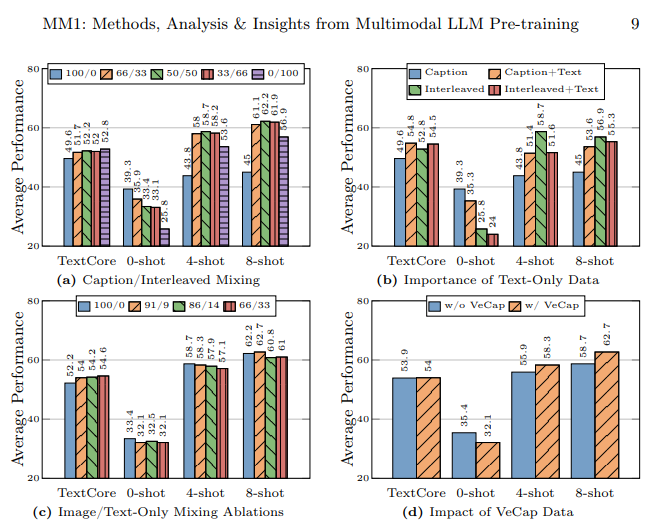

グーグル、マイクロソフト、メタなど大手企業がこぞってAI分野に着手し、先進的なAIモデルを次々と生み出している中、残るアップルはMM1と呼ばれるマルチモーダル大規模言語モデルでこのAI競争に参戦した。このモデルは、テキストデータとビジュアルデータの両方でトレーニングされた。MM1マルチモーダル大規模言語モデルは、キャプション付き画像(45%)、インターリーブされた画像-テキスト文書(45%)、テキストのみ(10%)のデータを混ぜて学習させた。

この記事では、アップルのMM1マルチモーダル大規模言語モデルとは何かを明らかにする。

準備ができたら始めよう!

TL; DR

- MM1は、アップルが開発・発表したマルチモーダル大規模言語モデルファミリー。

- MM1モデルは、従来のMLLMとは異なる学習・構築方法で開発された。

- MM1モデルを構築する際、アーキテクチャ、学習データ、画像エンコーダ、パラメータ、ハイパーパラメータ、学習手順を効果的なものに作り直した。

- MM1モデルは、競合他社に比べパラメータ数やサイズが少ないため、モバイル機器でもスムーズに操作できる。

- モバイル機器など、常にあなたのそばにいるAIアシスタントをお探しなら、3万以上のウェブサイトやアプリを統合したTextCortex 。

- TextCortex ライティングから専門的なタスクまで、カスタマイズ可能でインタラクティブなさまざまなAIソリューションを提供しています。

アップルMM1とは?

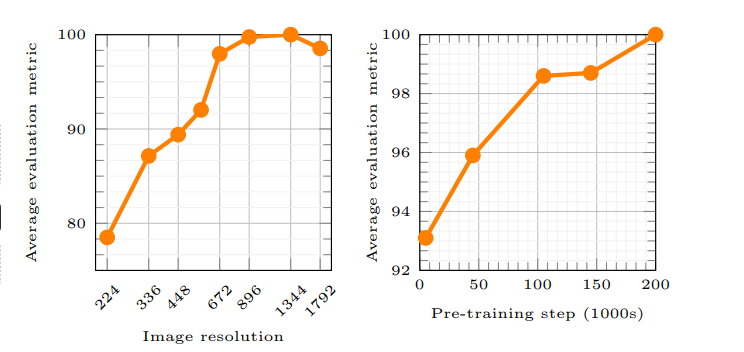

アップルのMM1は、マルチモーダル大規模言語モデル(MLLM)ファミリーであり、テキストと視覚的処理の両方を処理し、生成することができる。アップル社の記事によると、MM1モデルの動作原理は、AIがユーザーのプロンプトをよりよく理解し、望ましい出力を生成することを可能にする。MM1モデルのトレーニングには新しい方法が使用され、これらの方法は、画像の解像度と視覚エンコーダーの容量がモデルのパフォーマンスに最も大きな影響を与えたとしている。

アップルはAI競争に遅れをとっているのか?

アップル社の研究所は、膨大な数のAIの学習・構築方法を慎重に検討することで、高性能なマルチモーダル大規模言語モデル(MLLM)の構築を目指した。アップル社の記事によると、AIモデルをトレーニングする際に異なるタイプのデータを使用すること、数ショット学習で画像とテキストのドキュメントを使用すること、ゼロショット性能を高めるためにキャプション付き画像を使用すること、テキストのみのデータを使用することは、性能を向上させるためには強力な言語理解が重要であることを強調している。

MM1モデルはどのように作られたのか?

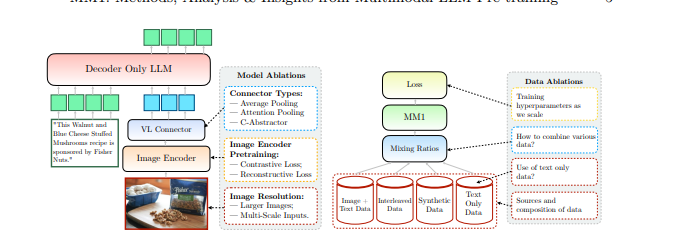

アップル社は、MM1モデルを構築するために従来の方法を超えており、これらの方法は高性能なマルチモーダル大規模言語モデル(MLLM)を構築するために必要であったと述べている。アップルはMM1モデルを構築する際、3つの基本的なステップを考慮している:

- アーキテクチャアップルの研究所チームは、独自のアーキテクチャを構築するために、さまざまな事前訓練済み画像エンコーダーとLLMを接続する方法を検討した。

- 学習済みデータ:MM1モデルは、ビジュアルやテキストなどさまざまな種類のデータ、およびこれらのデータの組み合わせを含むデータセットで学習される。

- トレーニングの手順:MM1モデルは、多数のパラメータで訓練する代わりに、ハイパーパラメータと、それらがどの段階で使用されるかに焦点を当てて訓練された。

アップルのMM1機能

アップルのMM1 Multimodal Large Language Model(MLLM)は、従来のMLLMとは異なるトレーニング方法、少ないパラメータ、トレーニングプロセスへの異なるアプローチを持っている。アップルによれば、MM1モデルは、MLLMをトレーニングするための最も効率的な方法を発見し、イノベーションを試みることによって構築されたとのことだ。MM1モデルの能力とトレーニングの違いを詳しく見てみよう。

建築

MM1モデルは、他のMLLM(Multimodal Large Language Models)とは異なるアーキテクチャを持つ。このアーキテクチャには、より高い画像解像度のエンコーダー、事前学習プロセスへの異なるアプローチ、単一のプロンプトの全体的なパフォーマンスを高めるためのラベル付きデータの混合などが含まれる。アップル社の研究所では、MM1モデルを訓練するためのさまざまなデータ選択の重要性に注目している。つまり、MM1モデルは、従来のMLLMよりも少ないリソースでより高いパフォーマンスを提供することを目指したアーキテクチャを採用している。

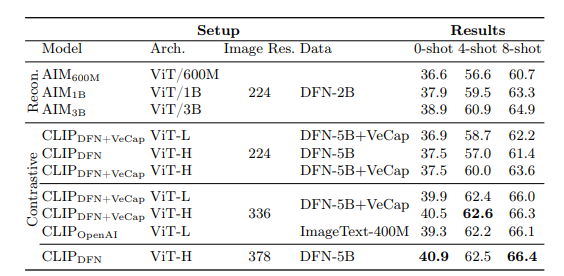

画像エンコーダー

ほとんどのマルチモーダル大規模言語モデルは、視覚データを処理するためにCLIP(Contrastive Language-Image Pre-training)事前学習済み画像エンコーダを使用している。さらに最近の研究では、視覚のみの自己教師ありモデルがより効果的に機能することが示されている。アップル社の研究チームは、これらのエンコーダーを分析することで、MLLMを視覚データでトレーニングする最も効果的な方法は、エンコーダーに選択された画像であることを発見した。アップルの研究所によると、画像エンコーダーの処理プロセスで使用されるデータは、エンコーダーの性能に直接影響するという。画像の解像度が最も影響が大きく、次いでモデルのサイズとトレーニングデータの構成が続く。

MM1パラメータ

アップル社の研究所によると、MLLM(Multimodal Large Language Model)のパラメータの大きさよりも重要なのは、それらのパラメータの微調整、スケーリング、ハイパーパラメータだという。

MM1モデルのパラメータは、様々なデータ入力を分析・処理するために最大限の効率で使用された。MM1モデルは、3つの異なるパラメータサイズからなるAIモデルのファミリーである:3B、7B、30Bである。さらに、MLLMのパラメータ・サイズが小さいほど、モバイル・デバイス上でより効率的に動作する。

モバイルデバイスとデスクトップの両方で常にあなたをサポートし、日常業務や仕事上のタスクを完了する手助けをしてくれるAIアシスタントを探しているなら、TextCortex 。

%20(5).png)

%20(20).png)