Meta AI ha rilasciato Llama 3, la versione più avanzata del modello linguistico di grandi dimensioni che ha sviluppato, il 18 aprile 2024. Llama 3 è un modello linguistico di grandi dimensioni che offre prestazioni elevate rispetto ai suoi concorrenti ed è addestrato con un set di dati selezionati con speciali metodi di filtraggio. Il modello Llama 3 è disponibile in due diverse dimensioni: 8B e 70B. Entrambi i modelli Llama 3 sono adatti a diversi casi d'uso. Se sei curioso di conoscere il modello Llama 3 e ti stai chiedendo come puoi accedervi, ci pensiamo noi!

In questo articolo esamineremo cos'è il modello Llama 3 e come puoi accedervi.

Sei pronto? Tuffiamoci!

TL; DR

- Il Llama 3 è un modello linguistico di grandi dimensioni sviluppato da Meta AI e annunciato il 18 aprile 2024.

- Llama è disponibile in due diverse dimensioni adatte a tre diversi casi d'uso: 8B e 70B.

- Llama 3 utilizza tecnologie come l'elaborazione del linguaggio naturale (NLP), l'apprendimento automatico e l'apprendimento profondo per generare l'output.

- Poiché il modello Llama 3 è open-source, il suo utilizzo è gratuito.

- Il modello Llama 3 ha prestazioni superiori nella maggior parte dei benchmark rispetto ai modelli rivali come GPT-3.5 e Claude 3 Sonnet.

- Il modello di Llama 3 è stato addestrato utilizzando dati di alta qualità provenienti da oltre 30 lingue.

- Per accedere al modello Llama 3, devi accedere al tuo account Meta AI dal paese in cui è disponibile.

Che cos'è Llama 3?

Llama 3 è un Large Language Model (LLM) sviluppato da Meta AI con prestazioni superiori rispetto al suo predecessore. Nell'annunciare Llama 3, Meta AI ha dichiarato che è stato addestrato con parametri ottimizzati. Il modello Llama 3 ha migliorato le capacità di ragionamento, comprensione del linguaggio, lettura immediata e codifica rispetto al suo predecessore. Con il modello Llama 3, Meta AI intende dare il via alla prossima ondata di innovazione nel campo dell'intelligenza artificiale.

Come accedere a Llama 3?

Il modello Llama 3 è una soluzione efficace per portare a termine compiti di piccola entità. I suoi principali vantaggi sono che supera i modelli Claude Sonnet e GPT-3.5 e che è open-source. Vediamo più da vicino come accedere a Llama 3.

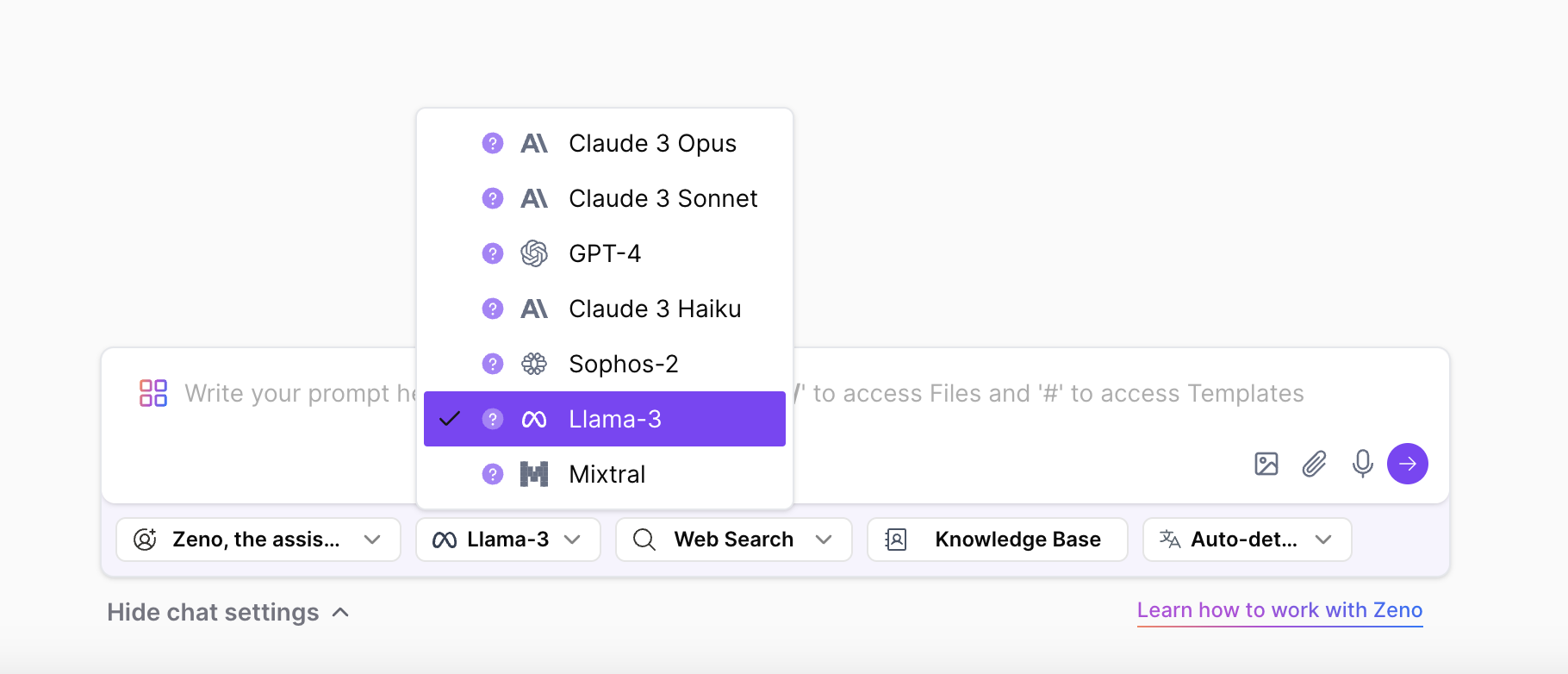

Accedi a Llama 3 su ZenoChat

Se vuoi provare il modello Llama 3 e tutte le sue dimensioni da qualsiasi paese, ZenoChat di TextCortex è pensato per te. ZenoChat è un assistente AI che offre diversi LLM ai suoi utenti e mira a ridurre il carico di lavoro dei suoi utenti. Basta selezionare l'LLM che si desidera utilizzare per generare l'output dalle impostazioni della chat di ZenoChat.

Utilizzando ZenoChat, puoi completare le tue attività basate sul testo, come la generazione di testi, la parafrasi, la traduzione, il riassunto, l'espansione delle frasi, la modifica del tono di voce, la correzione della grammatica e dell'ortografia, oppure puoi utilizzare l'intero internet come fonte di dati grazie alla sua funzione di ricerca sul web. Inoltre, ZenoChat offre ai suoi utenti anche la generazione di immagini AI con DALL-E 3. ZenoChat è disponibile come applicazione web e come browser extension. Il browser di ZenoChat extension è integrato con oltre 30.000 siti web e app. Quindi, può accompagnarti ovunque e in qualsiasi momento.

Ti sembra eccitante? Clicca qui per creare il tuo account gratuito su TextCortex e sperimentare l'assistente AI per eccellenza.

Prova Llama 3 su Meta AI

Puoi accedere al modello Llama 3 tramite Meta AI. Tutto quello che devi fare è andare sul sito ufficiale di Meta AI, creare un account e richiedere l'autorizzazione all'accesso. Tuttavia, il modello Llama 3 è disponibile fuori dagli Stati Uniti solo in Australia, Canada, Ghana, Giamaica, Malawi, Nuova Zelanda, Nigeria, Pakistan, Singapore, Sudafrica, Uganda, Zambia e Zimbabwe. Se non fai parte dei paesi citati, vedrai il messaggio "Meta AI non è ancora disponibile nel tuo paese".

Llama 3 Dimensioni del modello

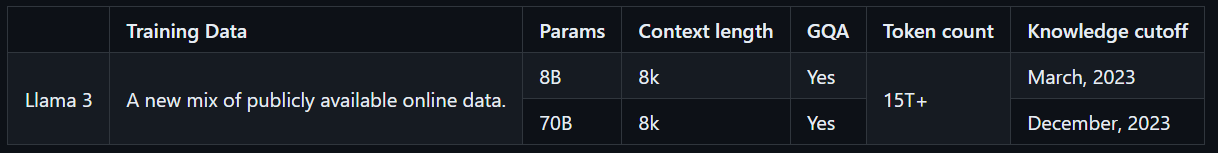

Il modello Llama 3 è disponibile in due dimensioni, adatte a diversi casi d'uso. Il modello 8B è ideale per completare compiti semplici in modo rapido e accurato, mentre il modello 70B è progettato per gestire compiti più grandi e complessi con risultati di alta qualità. Entrambi i modelli sono stati addestrati con oltre 15T di token, un numero 7 volte superiore a quello dei token utilizzati per addestrare il modello Llama 2. Inoltre, i modelli Llama 3 hanno capacità multilingue, grazie all'addestramento con dati non inglesi di alta qualità.

Come funziona Llama 3?

Il modello Llama 3 genera output utilizzando tecnologie AI come l'elaborazione del linguaggio naturale (NLP), l'apprendimento profondo e l'apprendimento automatico. Il modello LLama 3 analizza gli input inseriti dall'utente con i suoi dati e parametri addestrati, capisce l'intento dell'utente e genera gli output necessari.

Il modello Llama 3 è stato addestrato utilizzando dati che sono passati attraverso speciali sistemi di filtraggio per garantire un output sicuro e appropriato. Questi includono l'uso di un filtro NFSW, un filtro euristico, un approccio deduplicato semantico e un classificatore di testo. Inoltre, il modello Llama 2, che ha preceduto il modello Llama 3, è stato utilizzato per selezionare i dati utilizzati nell'addestramento del modello Llama 3 grazie al suo successo nell'identificare dati di alta qualità.

Llama 3 è gratuito?

Meta AI ha sempre pubblicizzato la sua serie di modelli Llama come open-source e libera da usare, e Llama 3 non fa eccezione. Poiché i modelli Llama 3 8B e 70B attualmente in commercio sono open-source, chiunque può sperimentarli. Tuttavia, non è ancora chiaro se il modello Llama 3 400B, che è ancora in fase di formazione ed è il più avanzato della serie Llama 3, sia libero di essere utilizzato.

Caratteristiche di Llama 3

Llama 3 è stato rilasciato con due diversi modelli che hanno prestazioni più elevate rispetto alla concorrenza. Il motivo per cui questi due modelli hanno prestazioni più elevate rispetto alla concorrenza è che sono stati addestrati con dati identificati attraverso un filtraggio speciale. Il modello Llama 3 ha caratteristiche uniche rispetto agli altri LLM presenti sul mercato. Diamo un'occhiata più da vicino alle caratteristiche di Llama 3.

Prestazioni e parametri di riferimento

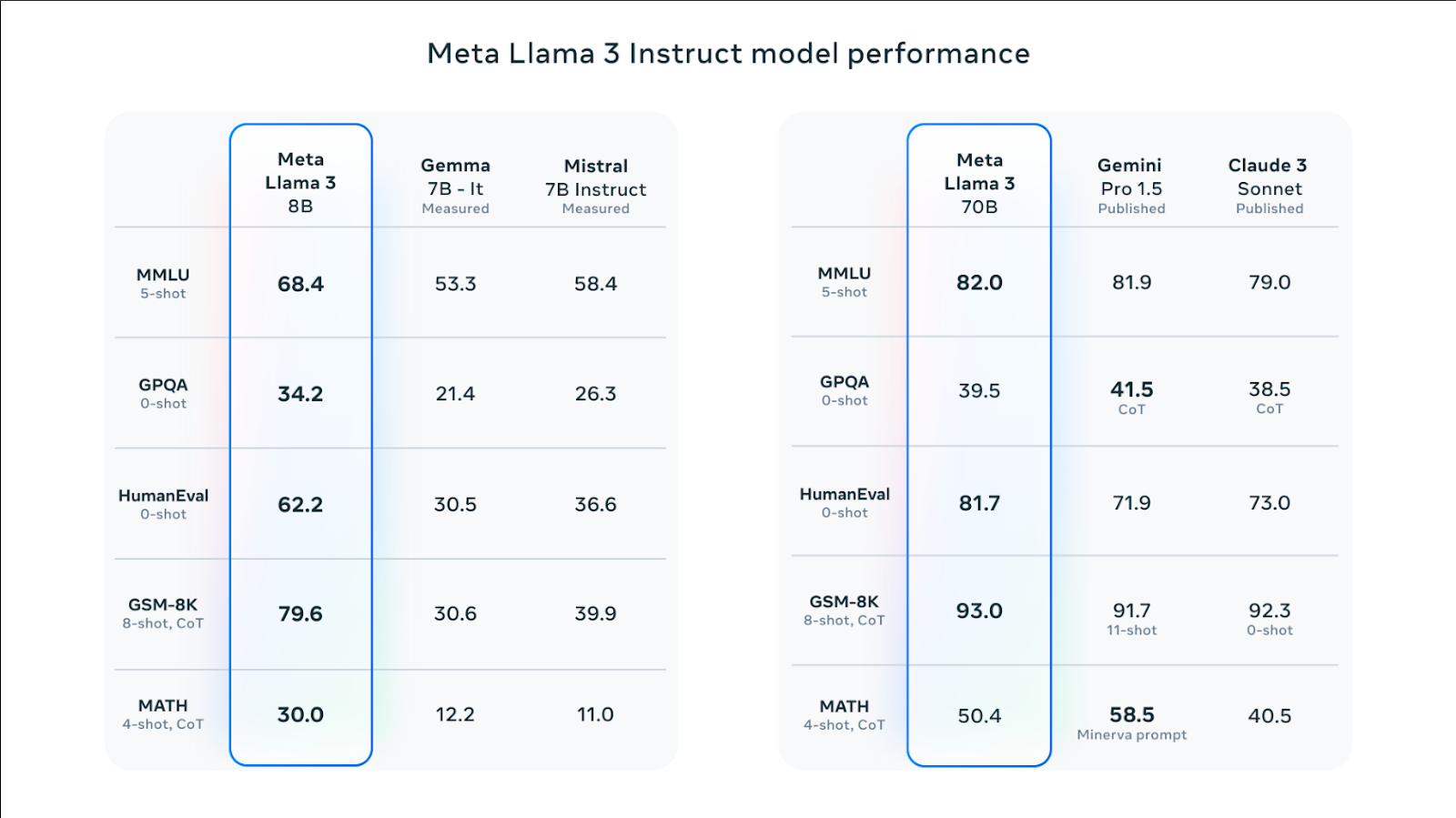

Entrambi i modelli Llama 3 8B e Llama 3 70B hanno ottenuto punteggi più alti in benchmark come HumanEval, MMLU e DROP rispetto ai loro concorrenti. Ad esempio, il modello Llama 3 70B ha prestazioni leggermente superiori nel benchmark MMLU rispetto ai modelli equivalenti Gemini Pro 1.5 e Claude 3 Sonnet. Il modello Llama 3 8B ha prestazioni complessive superiori rispetto ai suoi concorrenti, i modelli Gemma 7B e Mistral 7B.

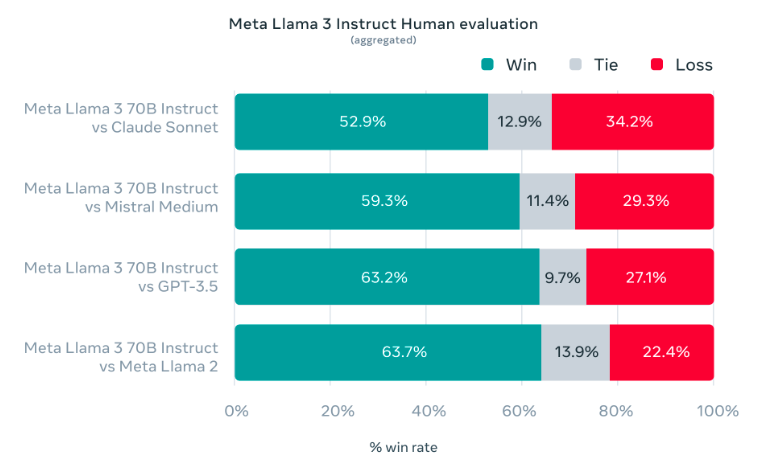

Durante lo sviluppo del modello Llama 3, l'obiettivo era quello di dimostrare prestazioni elevate in casi d'uso reali piuttosto che in test di laboratorio. Per questo motivo, il team di Meta AI ha sviluppato un nuovo set di valutazione umana di alta qualità. Questo set di valutazione è composto da 1800 domande che coprono 12 casi d'uso chiave. Le richieste includono compiti come la richiesta di consigli, il coding, il brainstorming, la scrittura creativa, le domande e le risposte, il ragionamento, la riscrittura e il riassunto. Il modello LLama 3 di Meta AI ha mostrato prestazioni superiori in questi test rispetto ai suoi rivali Claude Sonnet, GPT-3.5 e Mistral Medium.

Promuovere la comprensione

Poiché il modello Llama 3 è stato addestrato utilizzando la messa a punto supervisionata (SFT) e l'apprendimento per rinforzo con feedback umano (RLHF), è un modello di maggior successo nel seguire i suggerimenti rispetto al suo predecessore. Durante l'addestramento del modello Llama 3, la priorità è stata quella di generare risultati utili e sicuri.

Il 5% dei dati addestrati dal modello Llama 3 riguarda la grammatica di alta qualità, la struttura delle frasi e la scrittura creativa in oltre 30 lingue. Per questo motivo, il modello Llama 3 è in grado di analizzare le richieste dell'utente in altre lingue e di comprendere le richieste degli utenti in altre lingue.

Modello di architettura

Per l'addestramento del modello di Llama 3 è stata utilizzata un'architettura di trasformatori di soli decodificatori. Secondo l'articolo di Meta AI, Llama 3 utilizza un tokenizer con un vocabolario di 128K tokens che codifica il linguaggio in modo molto più efficiente, migliorando notevolmente le prestazioni del modello. Entrambe le dimensioni 8B e 70B del modello Llama 3 sono state addestrate con sequenze di 8.192 token.

Meta AI ha utilizzato una combinazione di parallelizzazione dei dati, parallelizzazione del modello e parallelizzazione delle pipeline per addestrare il modello Llama 3. Pertanto, mira a ridurre il carico di lavoro e ad aumentare la velocità di elaborazione del modello Llama 3 sulle GPU. Il sistema su cui il modello Llama 3 funziona meglio è di 400 TFLOPS per GPU. Il modello Llama 3 utilizza sistemi di rilevamento, gestione e manutenzione degli errori per massimizzare la velocità della GPU durante l'esecuzione.

%20(11).png)

%20(20).png)