Mentre l'intelligenza artificiale continua a svilupparsi a pieno ritmo, Apple è entrata in questo settore e ha scoperto approcci diversi e nuovi all'addestramento di un MLLM (Multimodal Large Language Model). Durante l'addestramento del modello MM1, Apple ha offerto un metodo più efficace personalizzando il tradizionale processo di addestramento del Multimodal Large Language Model. Questo metodo prevede l'uso efficace di grandi quantità di dati con parametri e iperparametri appropriati. Se ti stai chiedendo come funziona il modello MM1, sei nel posto giusto!

In questo articolo analizzeremo cos'è e come funziona il modello MM1.

Sei pronto? Tuffiamoci!

TL; DR

- MM1 di Apple è un modello linguistico multimodale di grandi dimensioni sviluppato con un approccio unico di pre-addestramento e messa a punto.

- Il modello Apple MM1 è stato rilasciato con tre diverse dimensioni di parametri: 3B, 7B e 30B.

- Mentre il modello Apple MM1 supera i modelli GPT-4 e Gemini Ultra in alcuni benchmark, in altri rimane indietro di poco.

- Durante l'addestramento del modello Apple MM1, sono stati riprogettati i codificatori di immagini, i connettori visione-linguaggio e le fasi di addestramento dei dati.

- Se hai bisogno di un assistente AI che ti supporti nella vita quotidiana e professionale, non cercare oltre TextCortex.

- TextCortex mira ad automatizzare il tuo carico di lavoro e a incrementare la tua produttività grazie alle sue caratteristiche uniche e alle avanzate capacità di intelligenza artificiale.

Che cos'è l'Apple MM1?

Il modello MM1 di Apple è un modello linguistico multimodale di grandi dimensioni (MLLM) progettato per completare compiti basati sulla vista con prestazioni elevate e requisiti di sistema minimi. Questo modello è stato sviluppato con un approccio unico e nuovo al processo di formazione del MLLM. Questo approccio mira alla massima efficienza con parametri minimi.

Dimensioni del modello MM1 di Apple

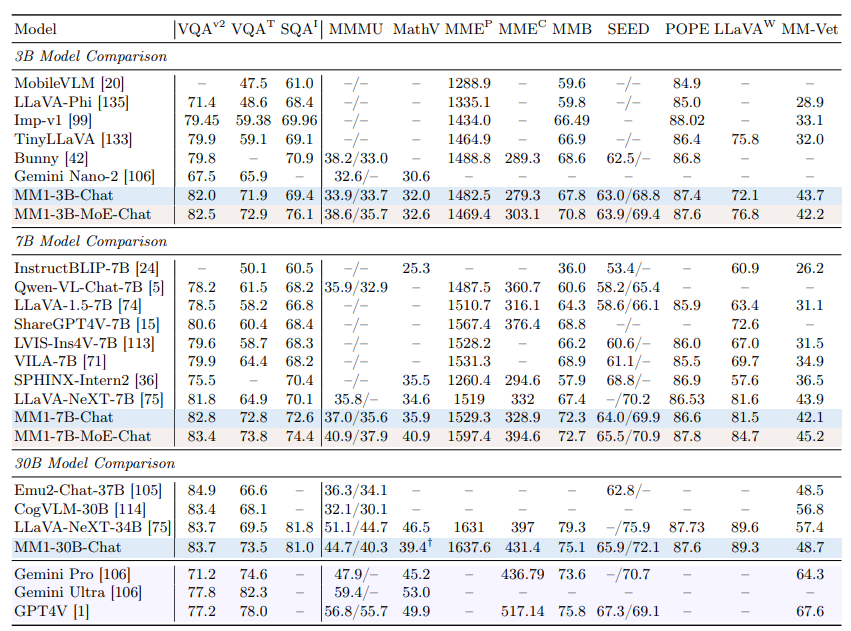

Il modello linguistico multimodale Apple MM1 è stato scalato a tre diverse dimensioni, ognuna con una quantità variabile di parametri: 3B, 7B e 30B. Inoltre, questi modelli sono stati scalati utilizzando un approccio misto di esperti (MoE). Questa scalatura è il fattore cruciale alla base delle prestazioni impareggiabili di MM1 sia nella fase di pre-addestramento che in quella di messa a punto.

MM1 è migliore di ChatGPT?

Grazie alle sue elevate prestazioni nelle fasi di pre-addestramento e di messa a punto, il modello Apple MM1 può competere con modelli come GPT-4V e Gemini Ultra e addirittura superarli in alcuni benchmark. Ad esempio, il modello MM1 30B è riuscito a superare sia il modello GPT-4 Vision che il modello Gemini Ultra nel benchmark VQAv2. Per quanto riguarda gli altri benchmark, è possibile notare che il modello MM1 ha prestazioni leggermente inferiori rispetto ai modelli Gemini Ultra e GPT-4.

Come posso accedere a MM1?

Poiché Apple non ha ancora reso disponibile pubblicamente il modello MM1, non è possibile provarlo in alcun modo. Tuttavia, il laboratorio di ricerca Apple ha dichiarato che tutte le dimensioni del modello MM1 saranno presto disponibili.

Come funziona l'MM1 di Apple?

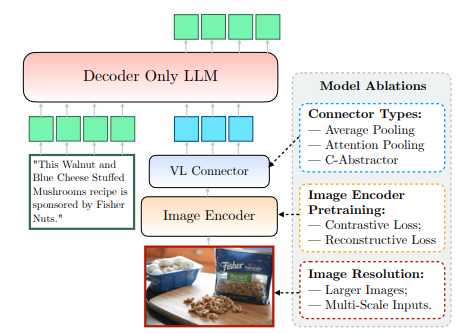

Il modello MM1 di Apple, che non è ancora disponibile al pubblico, è stato addestrato in modo nuovo e unico, andando oltre i metodi tradizionali. Secondo il laboratorio di ricerca di Apple, per addestrare un modello con la massima efficienza, è necessario esaminare la complessa relazione tra il design architettonico di MLLM e l'integrazione di diversi set di dati. Questo metodo mira a ottenere la massima efficienza con parametri minimi. Possiamo accedere chiaramente a queste informazioni dal documento condiviso da Apple. Diamo un'occhiata più da vicino a come funziona l'MM1 di Apple.

Codificatore di immagini

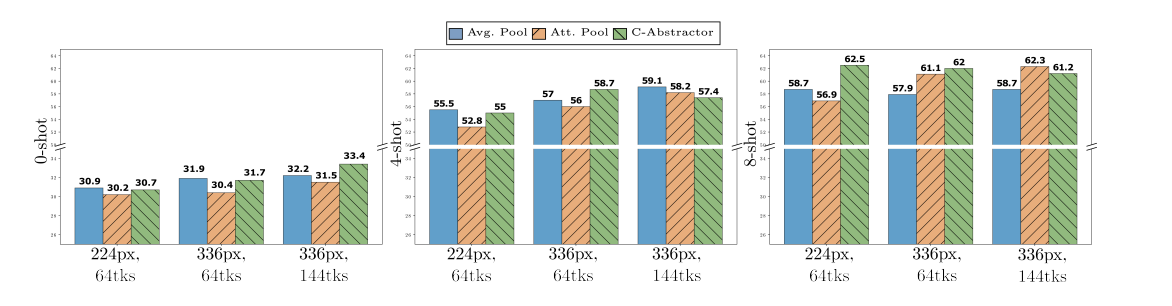

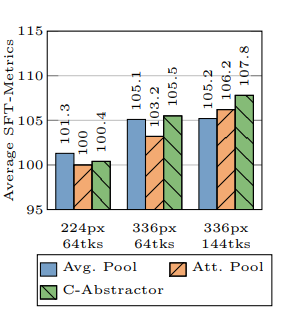

Durante l'addestramento del modello MM1, l'Apple Research Lab ha scoperto che la risoluzione dell'immagine ha il maggiore impatto sul processo di addestramento. Il modello MM1 è stato addestrato con immagini con una risoluzione di 378x378 pixel. Questo processo di addestramento è stato completato utilizzando i modelli di deep learning ViT-H (Vision Transformer - Huge) e CLIP (Contrastive Language-Image Pretraining). Mentre il modello ViT-H è stato progettato da Google per la classificazione delle immagini, CLIP è utile per incorporare le immagini progettate da OpenAI.

Connettore visione-lingua

Secondo il laboratorio di ricerca Apple, quando si sviluppa un MLLM, se si vuole che fornisca prestazioni elevate in compiti basati sulla vista, la risoluzione di un'immagine e il numero di token visivi sono essenziali per portare il processo di formazione a un livello superiore. Per lo sviluppo del modello MM1, il laboratorio di ricerca Apple ha utilizzato un connettore VL con 144 token.

Su quali dati è stato addestrato Apple MM1?

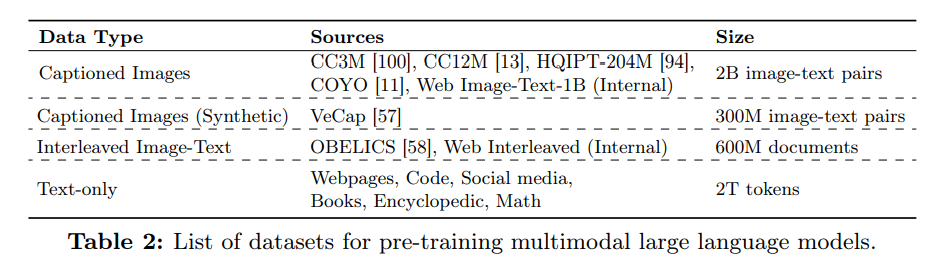

I dati addestrati di un modello linguistico multimodale di grandi dimensioni (MLLM) servono sia come memoria che come conoscenza per generare l'output. Pertanto, quanto più vari e ampi sono i dati addestrati di un MLLM, tanto più conciso sarà l'output che potrà produrre.

Il laboratorio di ricerca di Apple ha utilizzato una quantità significativa di dati costituiti da testo e immagini per migliorare le prestazioni a zero e a pochi scatti del modello MM1. Come si legge nell'articolo di Apple, il modello MM1 viene addestrato utilizzando una varietà di dati che comprende il 45% di documenti interlacciati immagine-testo, il 45% di documenti a coppia immagine-testo e il 10% di documenti di solo testo.

%20(6).png)

%20(20).png)