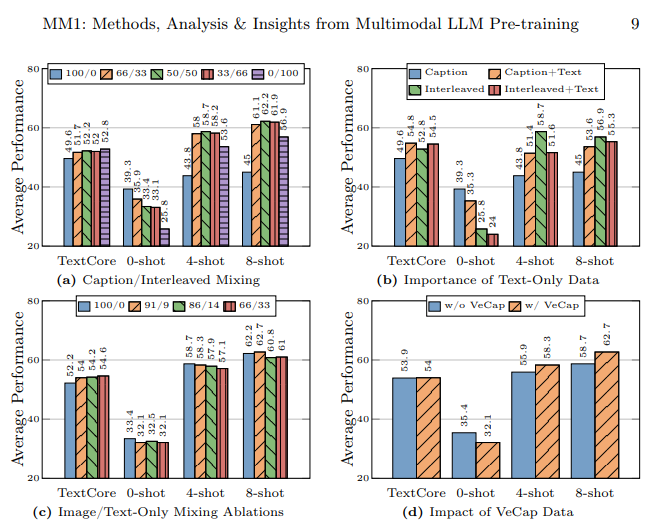

Mentre tutte le principali aziende come Google, Microsoft e Meta hanno iniziato a lavorare nel campo dell'IA e stanno producendo modelli di IA avanzati uno dopo l'altro, Apple, che è l'azienda rimasta, ha partecipato a questa gara di IA con il suo modello linguistico multimodale di grandi dimensioni chiamato MM1. Questo modello è stato addestrato sia con dati testuali che con dati visivi. Il modello linguistico multimodale MM1 è stato addestrato con un mix di immagini con didascalia (45%), documenti interlacciati immagine-testo (45%) e dati di solo testo (10%).

In questo articolo scopriremo cos'è il modello linguistico multimodale MM1 di Apple.

Se sei pronto, iniziamo!

TL; DR

- MM1 è una famiglia di modelli linguistici multimodali di grandi dimensioni sviluppata e annunciata da Apple.

- Il modello MM1 è stato sviluppato con un metodo di formazione e costruzione diverso, a differenza dei MLLM tradizionali.

- Durante la costruzione del modello MM1, l'architettura, i dati addestrati, il codificatore di immagini, i parametri, gli iperparametri e la procedura di addestramento sono stati ricreati per essere efficaci.

- Il modello MM1 ha un numero di parametri e dimensioni inferiori rispetto ai suoi concorrenti, il che gli permette di funzionare senza problemi sui dispositivi mobili.

- Se stai cercando un assistente AI che sia sempre con te, ad esempio sui dispositivi mobili, TextCortex è la strada da percorrere, grazie all'integrazione di oltre 30.000 siti web e app.

- TextCortex offre una serie di soluzioni di intelligenza artificiale personalizzabili e interattive, dalla scrittura ai tuoi compiti professionali.

Che cos'è l'Apple MM1?

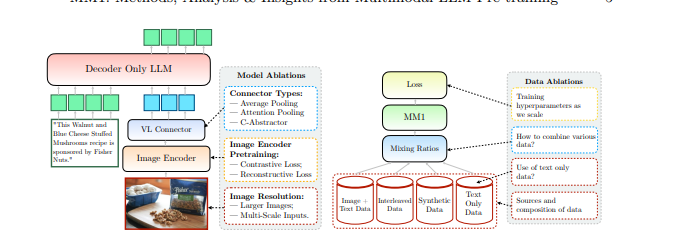

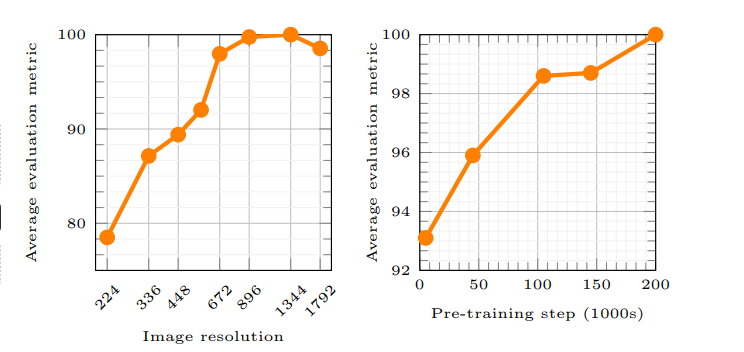

MM1 di Apple è una famiglia di Multimodal Large Language Model (MLLM) in grado di gestire e generare processi sia testuali che visivi. Secondo l'articolo di Apple, il principio di funzionamento del modello MM1 consente all'intelligenza artificiale di comprendere meglio le richieste degli utenti e di generare l'output desiderato. Per l'addestramento del modello MM1 sono stati utilizzati nuovi metodi, secondo i quali la risoluzione dell'immagine e la capacità del codificatore visivo hanno avuto il massimo impatto sulle prestazioni del modello.

Apple è in ritardo nella corsa all'intelligenza artificiale?

Il laboratorio di ricerca di Apple ha cercato di costruire un modello linguistico multimodale di grandi dimensioni (MLLM) ad alte prestazioni esaminando attentamente tonnellate di metodi di formazione e costruzione di AI. Secondo l'articolo di Apple, l'utilizzo di diversi tipi di dati per l'addestramento di un modello di intelligenza artificiale, l'uso di documenti immagine-testo nell'apprendimento a pochi scatti, l'uso di immagini con didascalie per aumentare le prestazioni a zero scatti e i dati di solo testo sottolineano l'importanza di una forte comprensione del linguaggio per migliorare le prestazioni.

Come è stato costruito il modello MM1?

Apple ha dichiarato di essere andata oltre i metodi tradizionali per costruire il modello MM1 e che questi metodi erano necessari per costruire un modello linguistico multimodale di grandi dimensioni (MLLM) ad alte prestazioni. Apple ha considerato tre fasi fondamentali nella costruzione del modello MM1:

- Architettura: Il team del laboratorio di ricerca di Apple ha esaminato metodi per collegare diversi codificatori di immagini pre-addestrati e LLM con questi codificatori per costruire un'architettura unica.

- Dati addestrati: Il modello MM1 viene addestrato con set di dati contenenti diversi tipi di dati, come quelli visivi e testuali, e combinazioni di questi dati.

- Procedura di addestramento: Invece di essere addestrato con un gran numero di parametri, il modello MM1 è stato addestrato concentrandosi sugli iperparametri e sulla fase in cui verranno utilizzati.

Le capacità di Apple MM1

Il modello MM1 Multimodal Large Language Model (MLLM) di Apple ha metodi di addestramento diversi, meno parametri e approcci diversi al processo di addestramento rispetto agli MLLM tradizionali. Apple afferma che il modello MM1 è stato costruito scoprendo i metodi più efficienti e provando innovazioni per addestrare un MLLM. Diamo un'occhiata più da vicino alle funzionalità e alle differenze di addestramento del modello MM1.

Architettura

Il modello MM1 ha un'architettura diversa rispetto agli altri MLLM (Multimodal Large Language Models). Questa architettura comprende codificatori con una maggiore risoluzione delle immagini, un approccio diverso al processo di pre-addestramento e la combinazione di dati etichettati per aumentare le prestazioni complessive di un singolo prompt. Il laboratorio di ricerca di Apple si concentra sull'importanza delle varie scelte di dati per addestrare il modello MM1. In altre parole, il modello MM1 ha un'architettura che mira a fornire prestazioni più elevate utilizzando meno risorse rispetto ai tradizionali MLLM.

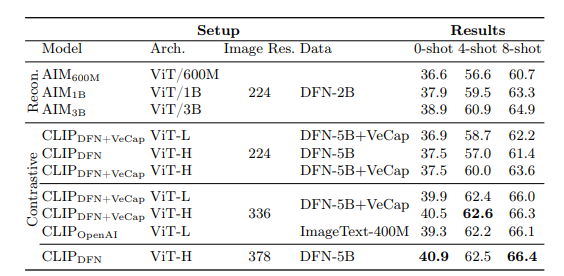

Codificatore di immagini

La maggior parte dei modelli linguistici multimodali utilizza il CLIP (Contrastive Language-Image Pretraining), un codificatore di immagini pre-addestrato per elaborare i dati visivi. Inoltre, studi recenti dimostrano che i modelli auto-supervisionati di sola visione funzionano in modo più efficace. Analizzando questi codificatori, il team di ricerca di Apple ha scoperto che il metodo più efficace per addestrare un MLLM con i dati visivi è quello delle immagini selezionate per i codificatori. Secondo il laboratorio di ricerca di Apple , i dati utilizzati nel processo di elaborazione di un codificatore di immagini influiscono direttamente sulle prestazioni del codificatore. Il risultato di tutte queste ricerche è il seguente: la risoluzione dell'immagine ha l'impatto maggiore, seguita dalle dimensioni del modello e dalla composizione dei dati di addestramento.

Parametri MM1

Secondo il laboratorio di ricerca di Apple, ciò che è più importante della dimensione dei parametri in un modello linguistico multimodale di grandi dimensioni (MLLM) è la messa a punto, la scalatura e gli iperparametri di tali parametri.

I parametri del modello MM1 sono stati utilizzati con la massima efficienza per analizzare ed elaborare diversi input di dati. Il modello MM1 è una famiglia di modelli AI composta da tre diverse dimensioni di parametri: 3B, 7B e 30B. Inoltre, più piccola è la dimensione dei parametri di un MLLM, più efficiente sarà il suo funzionamento sui dispositivi mobili.

Se stai cercando un assistente AI che ti supporti sempre, sia su dispositivi mobili che su desktop, per aiutarti a portare a termine le tue attività quotidiane o professionali, dovresti tenere presente TextCortex .

%20(5).png)

%20(20).png)