Contenu créatif API du web

Que vous soyez un éditeur de logiciels désireux d'adopter une véritable valeur ajoutée pour ses utilisateurs finaux, ou que vous ayez besoin de classer et de générer des textes à grande échelle.

Êtes-vous prêt à multiplier par quatre la productivité de votre flux de travail grâce à la puissance des grands modèles linguistiques ? Sans les inconvénients de l'infrastructure ?

Rendez votre flux de travail intelligent grâce au traitement du langage naturel, à la génération et à la créativité des machines.

Pas de problèmes d'environnement, pas de pénurie de GPU, pas de problèmes d'invite, pas de serveurs surchargés, pas d'optimisation des paramètres.

Uniquement la puissance pure de NLP pour vos flux de travail et vos produits. Vous pouvez ainsi vous concentrer sur le produit que vous souhaitez diffuser.

Chaque solution est une simple intégration d'un point de terminaison API dans votre base de code.

Nous t'aidons à trouver le modèle de tarification qui convient le mieux à ta tâche

CHOISISSEZ VOTRE MODÈLE

Il y a tellement de modèles et on a l'impression qu'ils ont tous leur propre caractère. Nous vous aidons à choisir les meilleurs modèles de travail pour votre flux de travail. Dans le système NeoCortex, il existe 4 catégories.

Les modèles Velox sont les plus rapides et les modèles Alta sont les plus puissants. Les modèles Sophos sont nos modèles experts NeoCortex finement ajustés pour des flux de travail hautement spécialisés.

Ces modèles peuvent être utilisés à des fins diverses, notamment la classification, l'extraction d'entités, le résumé, la génération de contenu, la génération de codes, la paraphrase, et bien plus encore.

Velox

Aecus

Alta

Sophos

Brève description

le rapide

l'équilibre

le fort

l'expert

Prix pour 1K Tokens

$0.01

$0.02

$0.04

$0.12

Supplément multilingue

(prix pour 1 000 jetons)

+$0.12

+$0.12

+$0.12

+$0.12

Réglage fin

sur demande

sur demande

sur demande

sur demande

GPU dédiés

sur demande

sur demande

sur demande

sur demande

Paramètre Taille

Jusqu'à 5 milliards

Jusqu'à 19 milliards

Plus de 20 milliards

-

Got data? Let’s bring your models to the next level

FINE-TUNING - IMPROVE PERFORMANCE AND EFFICIENCY

Out of the box models are not made for your specific pain points?

That’s why we help you nail them down to what you need. With fine-tuned models on your data and workflow we can achieve better results while reducing overall costs in a number of tasks.

A small set of 100 examples can:

- improve task performance by 10x

- lead to 28% cost reduction

.png)

Apportez votre propre modèle

Tu es au bout du rouleau avec ton optimisation ?

Tu ne parviens pas à mettre un modèle plus important sur ton infrastructure. Nous t'aidons à héberger ton propre modèle et à gérer l'optimisation en cours.

- Supprime 70% du travail de création de texte

- Personnalisez la génération de texte en fonction de vos utilisateurs, de votre secteur d'activité et de votre niche.

- Ajoutez un gain de temps imbattable à votre proposition de valeur.

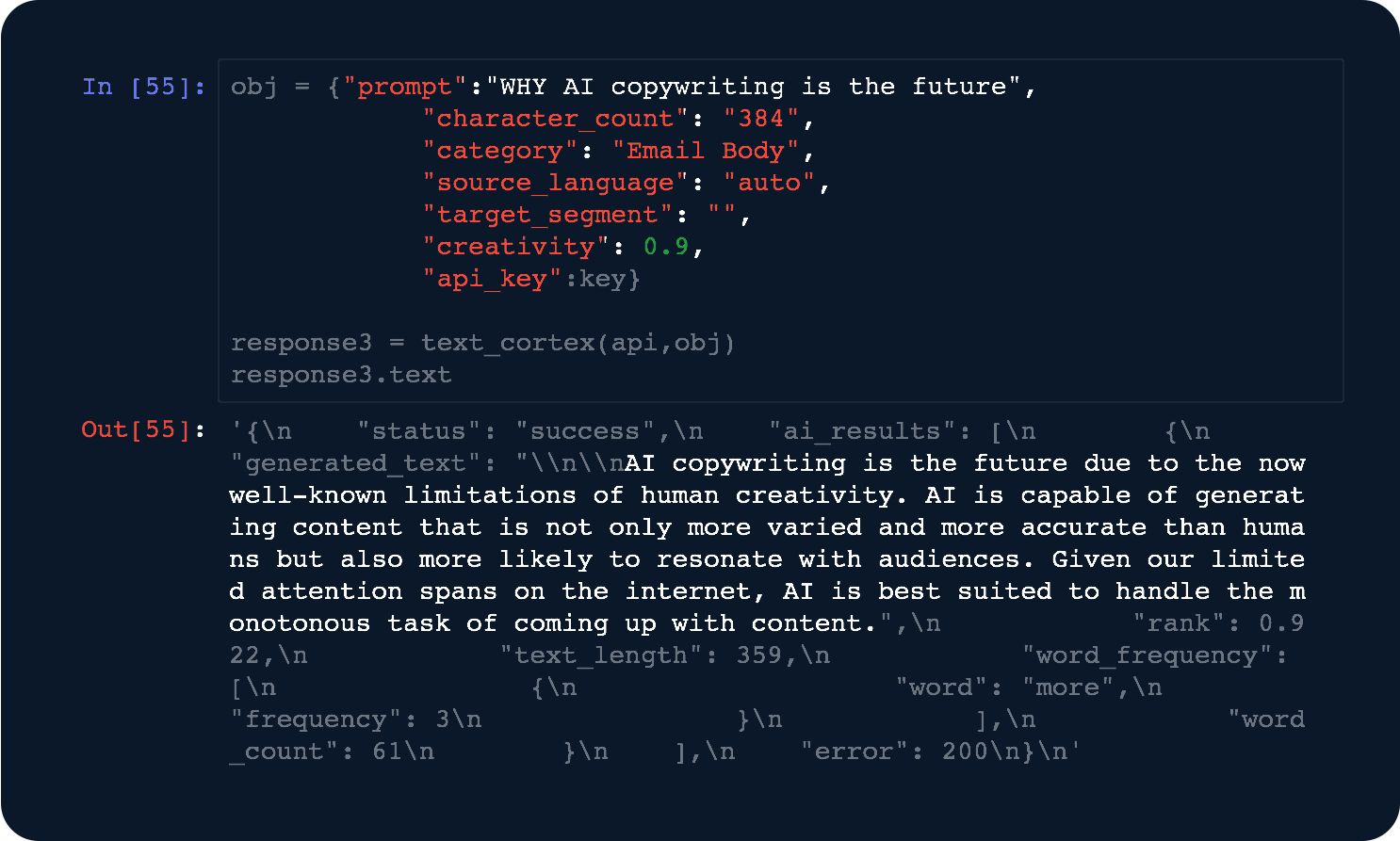

Des API puissantes et faciles à utiliser

DÉVELOPPEURS AU COEUR

Des développeurs pour des développeurs. Intègre-toi à notre site API en moins de 3 lignes de code.

- Optimisations avancées - Nous modifions constamment les modèles pour obtenir les meilleures vitesses de réponse.

- Calculs dédiés - Débloquez des performances supérieures grâce à une puissance de calcul dédiée.

Rendez votre flux de travail intelligent

Tu cherches un service pour héberger ton grand modèle linguistique sur API? Tu as du mal à faire un grand modèle sur ton infrastructure ?

Nous t'aidons à héberger ton propre modèle et à t'occuper de l'optimisation continue.

Réécriture de textes API

Donnez à votre flux de travail ou à vos utilisateurs le pouvoir de réécrire n'importe quoi.

Synthèse de texte API

Résumez tout ce qui se trouve dans votre flux de travail pour en faciliter la digestion.

Génération de texte API

Créez du contenu pour des articles longs, des courriels, des messages sur les médias sociaux.

Génération visuelle API

Utilisez la diffusion stable pour créer des brouillons visuels dans votre flux de travail.

Quelques-unes des questions les plus fréquemment posées

Un jeton est le terme utilisé dans le secteur pour désigner le volume de travail de nos modèles. De l'entrée que vous leur donnez à travailler à la sortie qu'ils génèrent pour vous.

Considérez-les comme le paiement des litres d'eau que vous consommez dans le réseau de votre ville et que vous y réinjectez.

Les jetons sont une forme de mesure qui peut être exprimée en différentes unités, par exemple 1 litre d'eau équivaut à 1000 millilitres d'eau. De même, un jeton est composé de 4 caractères.

Saviez-vous qu'un mot comporte en moyenne 4,5 caractères ? Un jeton est donc presque un mot !

Pour remettre tout cela en perspective. Le texte jusqu'ici comporte environ 670 caractères, 124 mots et fait environ 169 jetons.

Si Alta avait créé ce bloc, il aurait coûté :

[nombre total de jetons] x [prix par jeton d'Alta] = coût

169 x 0,00002 = 0,0038 USD

Nous travaillons la plupart du temps avec nos propres modèles propriétaires NeoCortex.

D'autres modèles que nous pouvons héberger, optimiser et exploiter pour vous incluent :

- GPT Neo 2.7 bn.

- GPT-J 6 milliards.

- GPT NeoX 20 milliards.

- OPT : Open Pre-trained Transformer Language Models (125M à 66 bn)

- FairSeq (13 bn.)

- CodeGen (16 bn.)

- Bloom 560m

- Bloom 1.1 bn.

- Bloom 1,7 milliard.

- Bloom 3 milliards.

- Bloom 7,1 milliards.

- Bloom 176 mrd. (bientôt disponible)

- t5 Small

- t5 Base

- t5 Large

- t5 3b

- t5 11b

- Stable Diffusion hosted API

Si vous avez d'autres questions, contactez notre équipe d'intégration.

Nous calculons vos frais en fonction du nombre de tokens d'entrée et de sortie avec lesquels vous travaillez.

Une tâche de génération avec notre modèle "Aecus" pour LongForm est la plupart du temps très lourde en sortie.

Pensez à l'invite d'entrée suivante :

"La génération de texte NeoCortex API vous aide dans votre flux de travail" (60 caractères = 15 tokens)

Voici la sortie réelle :

"Qu'est-ce que NeoCortex ?

NeoCortex est une génération de texte par apprentissage profond API, qui utilise uniquement le langage naturel pour générer des textes. Le texte généré est conçu pour être lisible et compréhensible par l'homme, ce qui vous aide dans votre travail. Le site API est facile à apprendre, avec une interface simple. Cela en fait un outil parfait pour les développeurs qui souhaitent créer leurs propres applications." (360 caractères = 90 jetons)

Fait un total de jetons de 15 + 90 = 105 jetons.

0.02$ divisé par 1000 fois 105 = 0.0021 $ serait facturé pour votre demande.

Oui.

Lorsque vous vous inscrivez à notre plateforme et générez une clé API , vous disposez automatiquement de 5 $ pour tester nos API pendant 30 jours.

Pour obtenir de l'aide concernant votre intégration, contactez notre équipe d'intégration.

Lorsque nous affinons vos modèles, nous prenons vos données et apprenons à un modèle comment se comporter avec elles et ce qui est attendu.

Comme un beau costume, nous vous confectionnons un modèle de génération, de classification et d'extraction de texte adapté à vos besoins.

Tout ce dont nous avons besoin, c'est d'un ensemble de données de haute qualité provenant de votre flux de travail.

Nous constatons les premières améliorations à partir d'ensembles de données aussi petits que 500 observations.

Si vous avez d'autres questions, n'hésitez pas à contacter notre équipe d'intégration.

Oui. Les fonctionnalités de

Base nécessitent moins de 3 lignes de code. Pour cela, nous disposons également de plusieurs paquets OSS pour une intégration facile(PyPi, NPM-JS).

De plus, nous vous offrons un support d'intégration dédié pour votre temps d'intégration.

Les nouveaux arrivants ont besoin d'environ 4 à 6 semaines pour voir les premiers résultats. Une personne qui passe à notre infrastructure s'y retrouve en moins de 2 semaines.

Bien que nous essayions de gérer nos points de terminaison API de la manière la plus explicite possible. Nous sommes toujours heureux de vous aider à trouver le meilleur modèle.

Si vous recherchez des conseils directs, contactez notre équipe d'intégration.

L'exécution de grands modèles de langage (LLM) nécessite de puissantes machines de calcul sous la forme de GPU.

La construction de l'infrastructure, sa maintenance et son optimisation ont un coût élevé. Nous sommes experts en la matière, ayant réduit la taille de nos modèles pour nos produits destinés aux utilisateurs, où les temps de réponse en "ms" sont importants et où l'optimisation des coûts est notre moteur de marge.

Avec TextCortex , vous avez l'avantage de bénéficier de notre système NeoCortex de deux façons :

1) Pay-per-token

Idéal pour les opérations à petite échelle. Par exemple, moins de 100 000 demandes par mois ou des modèles plus petits avec moins de 10 milliards de paramètres.

Vous travaillez dans un environnement partagé avec d'autres clients.

2) Pay-per-GPU-hour

Idéal pour les opérations à grande échelle. Par exemple, des millions de demandes ou des modèles avec plus de 20 milliards de paramètres.

Vous nous payez pour la gestion et l'hébergement des modèles en fonction du taux horaire forfaitaire de GPU actif utilisé par vos modèles.

Il s'agit d'une option prioritaire dans laquelle vous utilisez des ressources dédiées uniquement pour votre cas.

Si vous avez besoin de conseils supplémentaires, contactez notre équipe d'intégration.

Copilote IA pour tes connaissances.

Connecte tes connaissances et travaille avec tes propres données.