Kreative Inhalte API des Webs

Egal, ob Sie ein Softwareunternehmen sind, das einen echten Mehrwert für seine Endnutzer schaffen möchte, oder ob Sie Textklassifizierung und -generierung in großem Maßstab benötigen.

Sind Sie bereit, Ihre Workflow-Produktivität mit der Leistung großer Sprachmodelle zu vervierfachen? Ohne den ganzen Aufwand für die Infrastruktur?

Machen Sie Ihren Arbeitsablauf intelligent mit natürlicher Sprachverarbeitung, Generierung und maschineller Kreativität.

Keine Umgebungsprobleme, keine GPU-Knappheit, keine Probleme mit der Eingabeaufforderung, keine überlasteten Server, keine Parameteroptimierung.

Nur reine NLP Leistung für Ihre Workflows und Produkte. So können Sie sich auf das Produkt konzentrieren, das Sie herausbringen wollen.

Jede Lösung ist eine einfache Integration eines API Endpunkts in Ihre Codebasis.

Anpassen

Umschreiben und Zusammenfassen von Texten beliebiger Länge in Ihrem Arbeitsablauf.

Wir helfen Ihnen, das richtige Preise Modell für Ihre Aufgabe zu finden

WÄHLEN SIE IHR MODELL

Es gibt so viele Modelle und alle haben ihren eigenen Charakter. Wir helfen Ihnen bei der Auswahl der besten Arbeitsmodelle für Ihren Arbeitsablauf. Innerhalb des NeoCortex-Systems gibt es 4 Kategorien.

Wobei Velox die schnellsten und Alta die leistungsstärksten Modelle sind. Sophos-Modelle sind unsere fein abgestimmten NeoCortex-Expertenmodelle für hochspezialisierte Arbeitsabläufe.

Diese Modelle können für eine Vielzahl von Zwecken verwendet werden, einschließlich Klassifizierung, Entitätsextraktion, Zusammenfassung, Inhaltsgenerierung, Codegenerierung, Paraphrasierung und vieles mehr.

Velox

Aecus

Alta

Sophos

Kurzbeschreibung

das Fasten

die ausgewogene

die Starken

der Experte

Preis pro 1K Token

$0.01

$0.02

$0.04

$0.12

Mehrsprachiger Aufpreis

(Preis pro 1K Token)

+$0.12

+$0.12

+$0.12

+$0.12

Feinabstimmung

auf Anfrage

auf Anfrage

auf Anfrage

auf Anfrage

Dedizierte GPUs

auf Anfrage

auf Anfrage

auf Anfrage

auf Anfrage

Parameter Größe

Bis zu 5 Milliarden

Bis zu 19 Milliarden

Über 20 Milliarden

-

Got data? Let’s bring your models to the next level

FINE-TUNING - IMPROVE PERFORMANCE AND EFFICIENCY

Out of the box models are not made for your specific pain points?

That’s why we help you nail them down to what you need. With fine-tuned models on your data and workflow we can achieve better results while reducing overall costs in a number of tasks.

A small set of 100 examples can:

- improve task performance by 10x

- lead to 28% cost reduction

.png)

Bringen Sie Ihr eigenes Modell mit

Sie sind mit Ihrer Optimierung am Ende?

Sie schaffen es nicht, ein größeres Modell auf Ihre Infrastruktur zu stellen. Wir helfen Ihnen, Ihr eigenes Modell zu hosten und sich um die laufende Optimierung zu kümmern.

- Nimmt 70% der Arbeit bei der Texterstellung ab

- Anpassen der Texterstellung an Ihre Nutzer, Branche und Nische

- Erweitern Sie Ihr Wertangebot um einen unschlagbaren Zeitvorteil

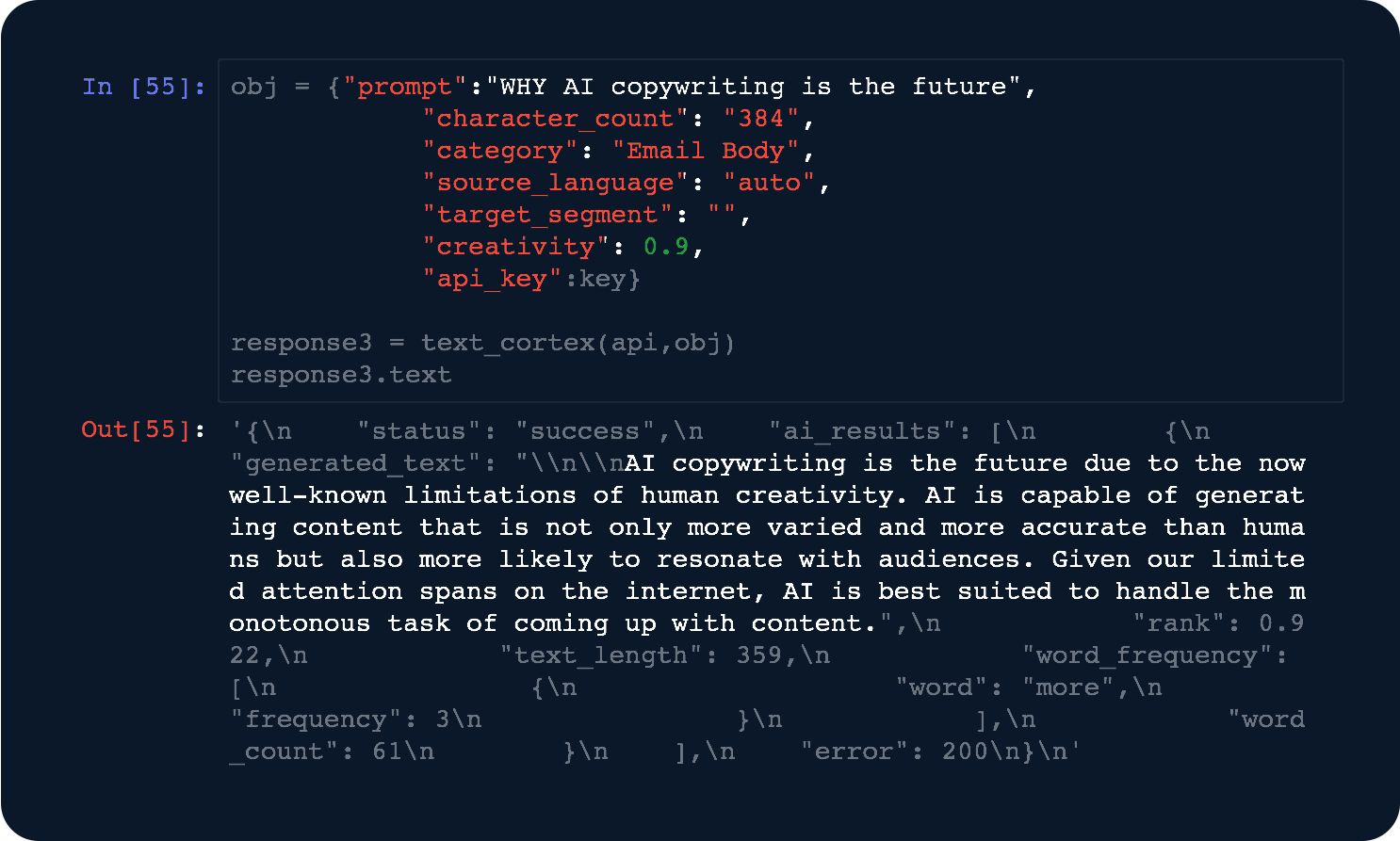

Leistungsstarke und einfach zu verwendende APIs

DEVELOPERS AT HEART

Von Entwicklern für Entwickler. Integrieren Sie unser API in weniger als 3 Zeilen Code.

- Fortgeschrittene Optimierungen - Wir optimieren ständig unsere Modelle, um die beste Reaktionsgeschwindigkeit zu erreichen.

- Dedizierte Berechnungen - Erzielen Sie höhere Leistung mit dedizierter Rechenleistung.

Machen Sie Ihren Arbeitsablauf intelligent

Sie suchen einen Service, um Ihr großes Sprachmodell als API zu hosten? Sie haben Schwierigkeiten, ein größeres Modell auf Ihrer Infrastruktur zu erstellen?

Wir helfen Ihnen, Ihr eigenes Modell zu hosten und kümmern uns um die laufende Optimierung.

Umschreiben von Texten API

Geben Sie Ihrem Arbeitsablauf oder Ihren Benutzern die Macht, alles umzuschreiben.

Text-Zusammenfassung API

Fassen Sie alles in Ihrem Arbeitsablauf zur leichteren Verdauung zusammen.

Textgenerierung API

Erstellen Sie Inhalte für lange Artikel, E-Mails und Beiträge für soziale Medien.

Visuelle Erzeugung API

Verwenden Sie Stable Diffusion, um visuelle Entwürfe in Ihrem Workflow zu erstellen.

Einige der am häufigsten gestellten Fragen

Ein Token ist der Fachbegriff für den Umfang, in dem unsere Modelle arbeiten. Von dem Input, den Sie ihnen geben, bis zu dem Output, den sie für Sie erzeugen.

Stellen Sie sich das so vor, als würden Sie für die Liter Wasser bezahlen, die Sie aus Ihrem städtischen System verbrauchen und in dieses zurückfließen lassen.

Token sind eine Form der Messung, die in verschiedenen Einheiten ausgedrückt werden kann, so wie 1 Liter Wasser dasselbe ist wie 1000 Milliliter Wasser. In ähnlicher Weise besteht 1 Token aus 4 Zeichen.

Wussten Sie übrigens, dass ein durchschnittliches Wort aus 4,5 Zeichen besteht? 1 Token ist also fast ein Wort!

Um das Ganze noch einmal ins rechte Licht zu rücken. Der Text bis hierher hat etwa 670 Zeichen, 124 Wörter und ergibt etwa 169 Token.

Wenn Alta diesen Block erstellt hätte, hätte das folgende Kosten verursacht:

[Anzahl der Token insgesamt] x [Preis pro Token von Alta] = Kosten

169 x 0,00002 = 0,0038 USD

Wir arbeiten die meiste Zeit mit unseren eigenen NeoCortex-Modellen.

Andere Modelle, die wir für Sie hosten, optimieren und betreiben können, sind:

- GPT Neo 2,7 Mrd.

- GPT-J 6 Mrd.

- GPT NeoX 20 Mrd.

- OPT: Open Pre-trained Transformer Language Models (125M bis 66 bn.)

- FairSeq (13 bn.)

- CodeGen (16 bn.)

- Bloom 560m

- Bloom 1.1 bn.

- Bloom 1.7 bn.

- Bloom 3 bn.

- Bloom 7.1 bn.

- Bloom 176 bn. (bald verfügbar)

- t5 Small

- t5 Base

- t5 Large

- t5 3b

- t5 11b

- Stable Diffusion hosted API

Falls Sie weitere Fragen haben, wenden Sie sich an unser Integrationsteam.

Wir berechnen Ihre Kosten auf der Grundlage der Anzahl der Eingabe- und Ausgabe-Token, mit denen Sie arbeiten.

Eine Generierungsaufgabe mit unserem "Aecus"-Modell für LongForm ist meistens sehr ausgabeintensiv.

Denken Sie an die folgende Eingabeaufforderung:

"Die NeoCortex-Textgenerierung API hilft Ihnen bei Ihrem Arbeitsablauf" (60 Zeichen = 15 Token)

Hier ist die eigentliche Ausgabe:

"Was ist NeoCortex?

NeoCortex ist eine Deep-Learning-Textgenerierung API, die nur natürliche Sprache zur Generierung von Texten verwendet. Der generierte Text ist so gestaltet, dass er für Menschen lesbar und verständlich ist, was Ihnen bei Ihrem Arbeitsablauf hilft. API ist leicht zu erlernen und verfügt über eine einfache Schnittstelle. Das macht es perfekt für Entwickler, die ihre eigenen Anwendungen erstellen wollen." (360 Zeichen = 90 Token)

Ergibt eine Gesamtzahl von 15 + 90 = 105 Token.

0,02 $ geteilt durch 1000 mal 105 = 0,0021 $ würden für Ihre Anfrage berechnet.

Ja.

Wenn Sie Registrieren auf unserer Plattform anmelden und einen API Schlüssel generieren, erhalten Sie automatisch $5, um unsere APIs 30 Tage lang zu testen.

Für Hilfe rund um Ihre Integration wenden Sie sich an unser Integrationsteam.

Bei der Feinabstimmung Ihrer Modelle nehmen wir Ihre Daten und bringen einem Modell bei, wie es sich auf diesen Daten verhalten soll und was erwartet wird.

Wie ein guter Anzug schneidern wir Ihnen ein Modell zur Texterzeugung, -klassifizierung und -extraktion auf Ihre Bedürfnisse zu.

Alles, was wir von Ihnen benötigen, ist ein Datensatz mit qualitativ hochwertigen Daten aus Ihrem Arbeitsablauf.

Wir sehen erste Verbesserungen bei Datensätzen mit nur 500 Beobachtungen.

Falls Sie weitere Fragen haben, wenden Sie sich an unser Integrationsteam.

Ja.

Die Basisfunktionalitäten erfordern weniger als 3 Zeilen Code. Aus diesem Grund haben wir auch mehrere OSS-Pakete für eine einfache Integration(PyPi, NPM-JS).

Darüber hinaus bieten wir Ihnen einen speziellen Integrationssupport für Ihre Einarbeitungszeit.

Während Neueinsteiger etwa 4 bis 6 Wochen benötigen, um erste Ergebnisse zu sehen. Jemand, der zu unserer Infrastruktur wechselt, findet sich in weniger als 2 Wochen zurecht.

Wir versuchen, unsere API Endpunkte so selbsterklärend wie möglich zu gestalten. Wir helfen Ihnen gerne, das beste Modell zu finden.

Falls Sie eine direkte Anleitung benötigen, wenden Sie sich an unser Integrationsteam.

Die Ausführung großer Sprachmodelle (LLM) erfordert leistungsstarke Rechenmaschinen in Form von GPUs.

Der Aufbau der Infrastruktur, ihre Wartung und Optimierung ist mit hohen Kosten verbunden. Wir sind Experten darin, da wir unsere Modelle für unsere benutzerseitigen Produkte verkleinert haben, bei denen es auf Antwortzeiten in "ms" ankommt und Kostenoptimierung unser Margentreiber ist.

Mit TextCortex haben Sie den Vorteil, von unserem NeoCortex-System auf zwei kostensparende Arten zu profitieren:

1) Pay-per-Token

Ideal für kleinere Betriebe. Zum Beispiel weniger als 100.000 Anfragen pro Monat oder kleinere Modelle mit weniger als 10 Mrd. Parametern.

Sie arbeiten in einer gemeinsamen Umgebung mit anderen Kunden.

2) Pay-per-GPU-hour

Ideal für den Betrieb großer Prozesse. Zum Beispiel, Millionen von Anfragen oder Modelle mit mehr als 20 Mrd. Parametern.

Sie bezahlen uns für die Verwaltung und das Hosting der Modelle in Abhängigkeit von der pauschalen aktiven GPU-Stundenrate, die Ihre Modelle ausführen.

Dies ist eine vorrangige Option, bei der Sie dedizierte Ressourcen nur für Ihren Fall verwenden.

Falls Sie weitere Beratung benötigen, wenden Sie sich an unser Integrationsteam.

KI-Kopilot für Ihr Wissen.

Verbinden Sie Ihr Wissen und arbeiten Sie mit Ihren eigenen Daten.