A Meta AI lançou o Llama 3, a versão mais avançada do modelo de linguagem de grande dimensão que desenvolveu, em 18 de abril de 2024. O Llama 3 é um modelo linguístico de grande dimensão que tem um desempenho elevado em comparação com os seus concorrentes e é treinado com um conjunto de dados selecionado com métodos de filtragem especiais. O modelo Llama 3 está disponível em dois tamanhos diferentes: 8B e 70B. Ambos os modelos Llama 3 são adequados para diferentes casos de utilização. Se tens curiosidade em conhecer o modelo Llama 3 e queres saber como podes aceder-lhe, nós ajudamos-te!

Neste artigo, vamos analisar o que é o modelo Llama 3 e como podes ter acesso a ele.

Estás pronto? Vamos mergulhar!

TL; DR

- O Llama 3 é um modelo de linguagem de grande dimensão desenvolvido pela Meta AI e anunciado a 18 de abril de 2024.

- A Llama está disponível em dois tamanhos diferentes, adaptados a três casos de utilização diferentes: 8B e 70B.

- O Llama 3 utiliza tecnologias como o processamento de linguagem natural (NLP), a aprendizagem automática e a aprendizagem profunda para gerar resultados.

- Uma vez que o modelo Llama 3 é de código aberto, a sua utilização é gratuita.

- O modelo Llama 3 tem um desempenho superior na maioria dos benchmarks do que os seus modelos rivais, como o GPT-3.5 e o Claude 3 Sonnet.

- O modelo Llama 3 foi treinado com dados de alta qualidade de mais de 30 idiomas.

- Para aceder ao modelo Llama 3, tens de iniciar sessão na tua conta Meta AI a partir do país onde está disponível.

O que é o Llama 3?

O Llama 3 é um Modelo de Linguagem Grande (LLM) desenvolvido pela Meta AI com um desempenho superior ao do seu antecessor. Ao anunciar o Llama 3, a Meta AI afirmou que este foi treinado com parâmetros ajustados. O modelo Llama 3 melhorou o raciocínio, a compreensão da linguagem, a leitura rápida e as capacidades de codificação em comparação com o seu antecessor. Com o modelo Llama 3, a Meta AI pretende dar o pontapé de saída para a próxima vaga de inovação no domínio da inteligência artificial.

Como acessar o Lhama 3?

O modelo Llama 3 é uma solução eficaz para a realização de tarefas de pequena dimensão. As suas principais vantagens são o facto de ter um desempenho superior aos modelos Claude Sonnet e GPT-3.5 e de ser de código aberto. Vamos ver mais de perto como aceder ao Llama 3.

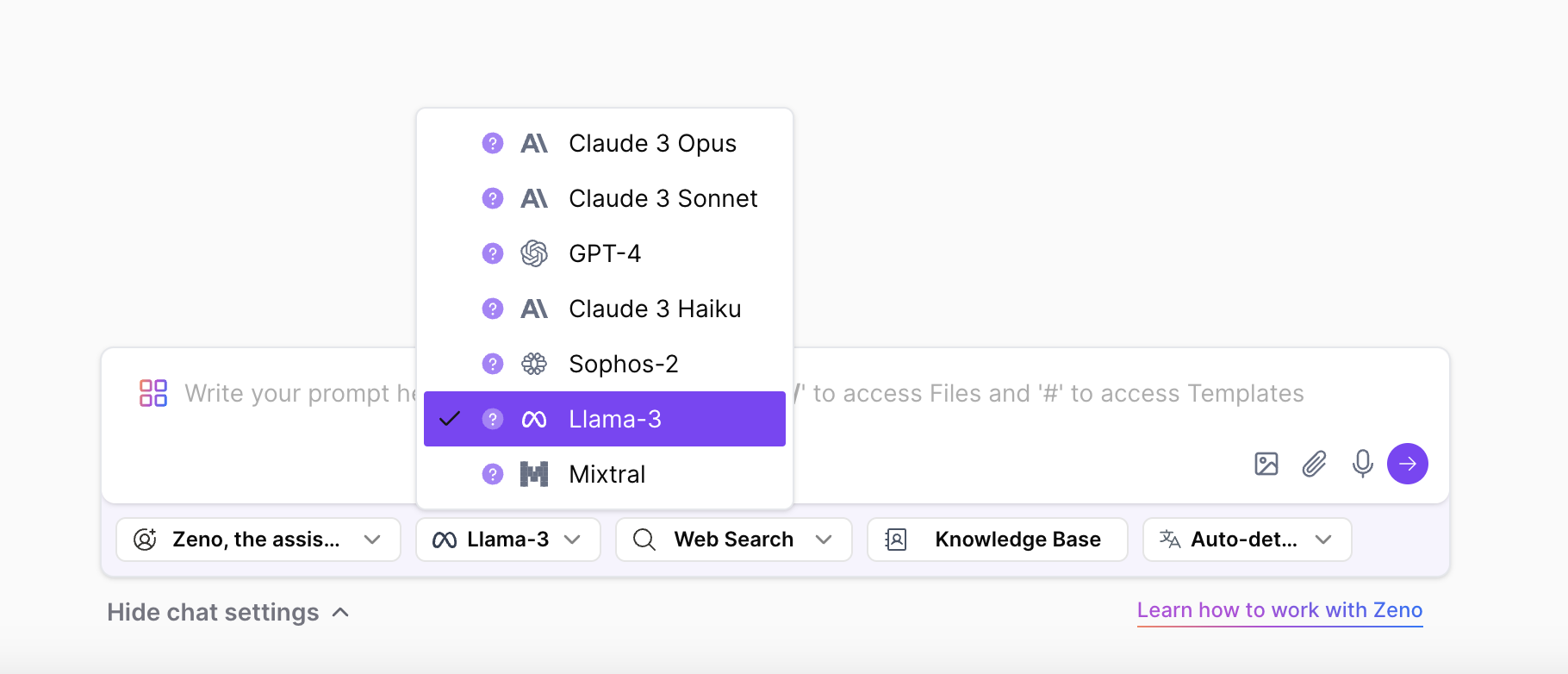

Acede ao Llama 3 no ZenoChat

Se quiseres experimentar o modelo Llama 3 e todos os seus tamanhos a partir de qualquer país, o ZenoChat da TextCortex foi concebido para ti. O ZenoChat é um assistente de IA que oferece vários LLMs aos seus utilizadores e tem como objetivo reduzir a carga de trabalho dos seus utilizadores. Basta selecionar o LLM que queres usar para gerar resultados a partir das definições de chat do ZenoChat.

Usando o ZenoChat, podes completar as tuas tarefas baseadas em texto, tais como geração de texto, paráfrase, tradução, resumo, expansão de frases, alteração do tom de voz, correcções gramaticais e ortográficas, ou podes usar toda a Internet como fonte de dados usando a sua funcionalidade de pesquisa na Web. Além disso, o ZenoChat também oferece aos seus utilizadores a geração de imagens com IA com tecnologia DALL-E 3. O ZenoChat está disponível como aplicação Web e como browser extension. O navegador ZenoChat extension está integrado em mais de 30.000 sítios Web e aplicações. Por isso, pode acompanhar-te em qualquer lugar e a qualquer momento.

Parece-te emocionante? Clica aqui para criares a tua conta TextCortex gratuita e experimentares o melhor assistente de IA.

Experimenta a Llama 3 no Meta AI

Podes aceder ao modelo Llama 3 através da Meta AI. Tudo o que tens de fazer é ir ao site oficial da Meta AI, criar uma conta e pedir autorização de acesso. No entanto, o modelo Llama 3 só está disponível fora dos EUA, na Austrália, Canadá, Gana, Jamaica, Malawi, Nova Zelândia, Nigéria, Paquistão, Singapura, África do Sul, Uganda, Zâmbia e Zimbabué. Se não fores um dos países mencionados, verás a mensagem "Meta AI ainda não está disponível no teu país".

Tamanhos de modelo de lhama 3

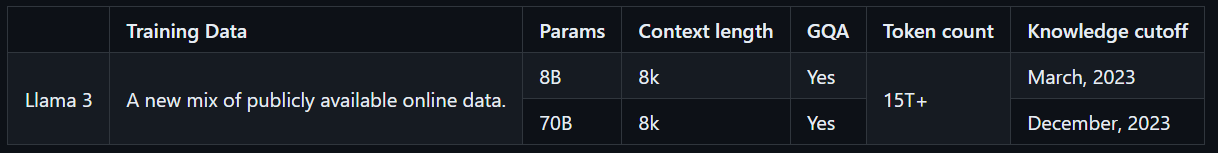

O modelo Llama 3 está disponível em dois tamanhos, personalizados para diferentes casos de utilização. O modelo 8B é ideal para completar tarefas simples com rapidez e precisão, enquanto o modelo 70B foi concebido para lidar com tarefas maiores e mais complexas com resultados de alta qualidade. Ambos os modelos foram treinados com mais de 15T tokens, o que é 7 vezes mais do que os tokens utilizados para treinar o modelo Llama 2. Além disso, os modelos Llama 3 têm capacidades multilingues, graças ao facto de terem sido treinados com dados de alta qualidade não ingleses.

Como é que o Llama 3 funciona?

O modelo Llama 3 gera resultados utilizando tecnologias de IA como o processamento de linguagem natural (NLP), a aprendizagem profunda e a aprendizagem automática. O modelo Llama 3 analisa as entradas introduzidas pelo utilizador com os seus dados e parâmetros treinados, compreende a intenção do utilizador e gera os resultados de que necessita.

O modelo Llama 3 foi treinado utilizando dados que passaram por sistemas de filtragem especiais para garantir resultados seguros e adequados. Isto inclui a utilização de um filtro NFSW, um filtro heurístico, uma abordagem semântica deduplicada e um classificador de texto. Além disso, o modelo Llama 2, que precedeu o modelo Llama 3, foi utilizado na seleção dos dados utilizados no treino do modelo Llama 3 devido ao seu sucesso na identificação de dados de alta qualidade.

A utilização do Llama 3 é gratuita?

A Meta AI sempre anunciou a sua série de modelos Llama como sendo de código aberto e de utilização gratuita, e a Llama 3 não é exceção. Uma vez que os modelos Llama 3 8B e 70B atualmente lançados são de código aberto, qualquer pessoa pode experimentar estes modelos. No entanto, ainda não é claro se o Llama 3 400B, que ainda está em processo de formação e é o membro mais avançado da série Llama 3, é de utilização gratuita.

Llama 3 Características

O Llama 3 foi lançado com dois modelos diferentes que têm um desempenho superior ao dos seus concorrentes. A razão pela qual estes dois modelos têm um desempenho superior ao dos seus concorrentes é o facto de terem sido treinados com dados identificados através de uma filtragem especial. O modelo Llama 3 tem características únicas em comparação com outros LLMs no mercado. Vamos analisar mais detalhadamente as características do Llama 3.

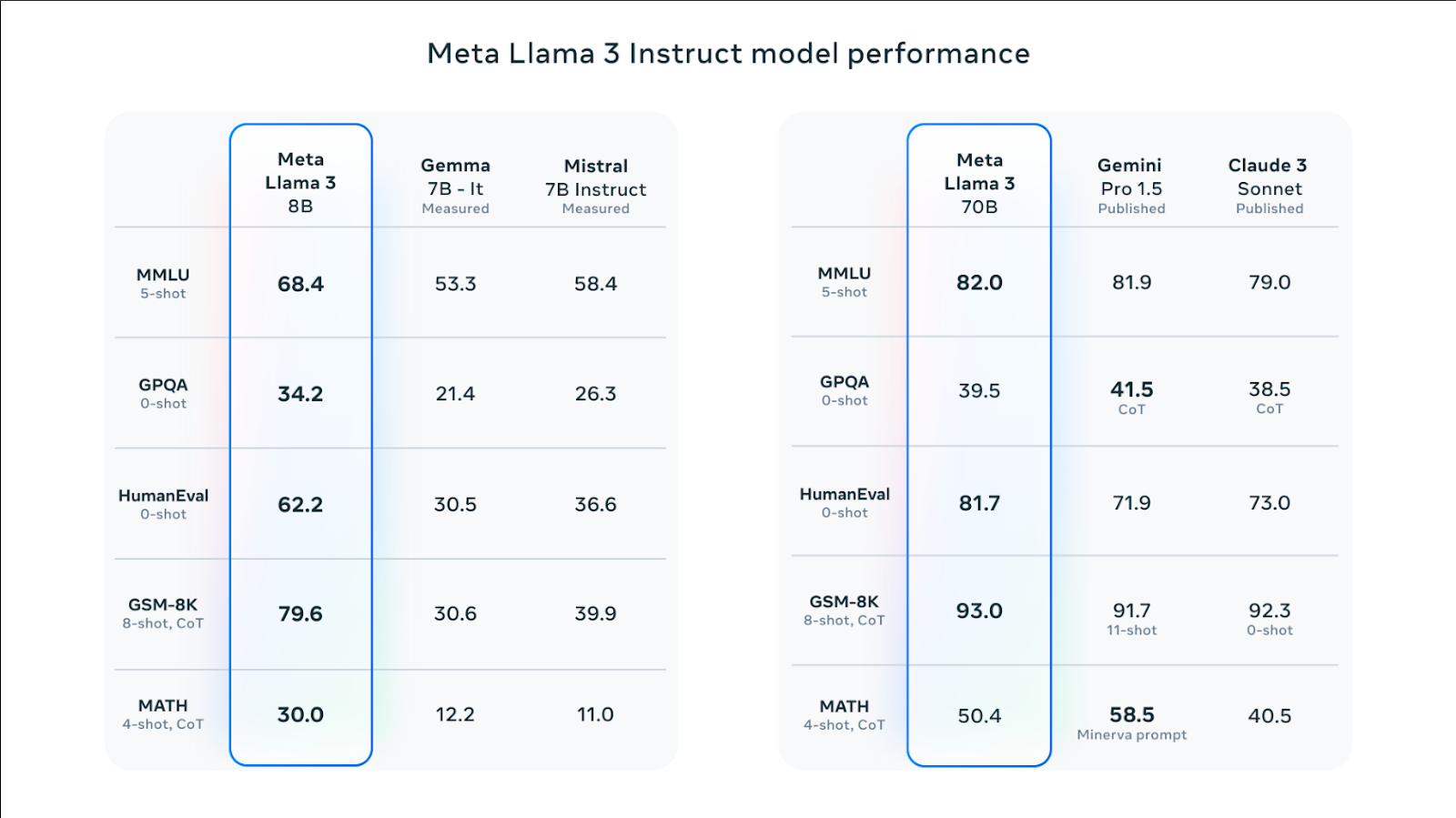

Desempenho e parâmetros de referência

Tanto o modelo Llama 3 8B como o Llama 3 70B têm pontuações mais elevadas em testes de referência como o HumanEval, MMLU e DROP em comparação com os seus concorrentes. Por exemplo, o modelo Llama 3 70B tem um desempenho ligeiramente superior no benchmark MMLU em comparação com os seus modelos equivalentes Gemini Pro 1.5 e Claude 3 Sonnet. O modelo Llama 3 8B tem um desempenho global superior ao dos seus concorrentes, os modelos Gemma 7B e Mistral 7B.

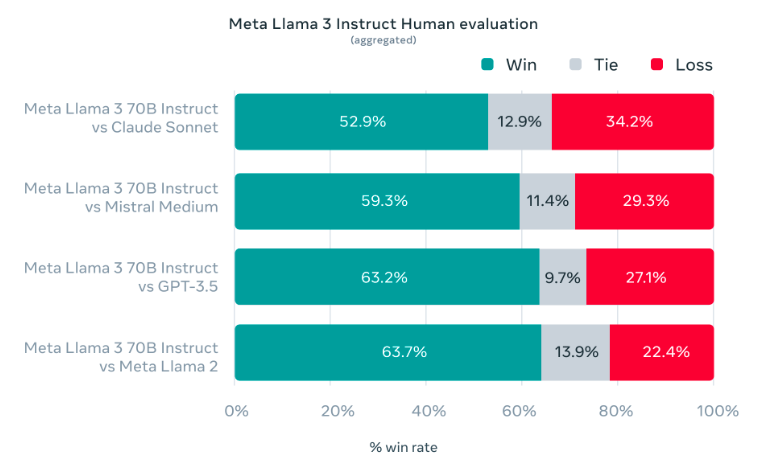

Durante o desenvolvimento do modelo Llama 3, o objetivo era demonstrar um elevado desempenho em casos de utilização real e não em testes em ambiente laboratorial. Por esta razão, a equipa do Meta AI desenvolveu um novo conjunto de avaliação humana de alta qualidade. Este conjunto de avaliação é composto por 1800 pedidos que abrangem 12 casos de utilização chave. As solicitações incluem tarefas como pedir conselhos, codificação, brainstorming, escrita criativa, perguntas e respostas, raciocínio, reescrita e resumo. O modelo LLama 3 da Meta AI mostrou um desempenho superior nestes testes em comparação com os seus rivais Claude Sonnet, GPT-3.5 e Mistral Medium.

Promove a compreensão

Uma vez que o modelo Llama 3 é treinado com recurso a afinação supervisionada (SFT) e aprendizagem por reforço com feedback humano (RLHF), é um modelo mais bem sucedido no seguimento de instruções do que o seu antecessor. Durante o treino do modelo Llama 3, foi dada prioridade à produção de resultados úteis e seguros.

5% dos dados treinados do modelo Llama 3 abrangem gramática de alta qualidade, estrutura de frases e escrita criativa em mais de 30 línguas. Por esta razão, o modelo Llama 3 pode analisar os prompts dados pelo utilizador noutras línguas e compreender os prompts dos utilizadores noutras línguas.

Arquitetura do modelo

A arquitetura de transformador apenas com descodificador foi utilizada no treino do modelo Llama 3. De acordo com o artigo da Meta AI, o Llama 3 usa um tokenizador com um vocabulário de 128K tokens que codifica a linguagem de forma muito mais eficiente, o que leva a um desempenho substancialmente melhor do modelo. Ambos os tamanhos 8B e 70B do modelo Llama 3 foram treinados em seqüências de 8.192 tokens.

A Meta AI usou uma combinação de paralelização de dados, paralelização de modelos e paralelização de pipeline para treinar o modelo Llama 3. Portanto, visa reduzir a carga de trabalho enquanto aumenta a velocidade de processamento do modelo Llama 3 em GPUs. O sistema em que o modelo Llama 3 funciona mais eficazmente é de 400 TFLOPS por GPU. O modelo Llama 3 utiliza sistemas de deteção, tratamento e manutenção de erros para maximizar a velocidade da GPU durante a execução.

%20(11).png)

%20(20).png)