Claude 3, o mais recente e mais avançado Modelo de Linguagem Grande (LLM) da Anthropic, rivaliza com modelos de IA avançados e populares no mercado, tanto em termos de desempenho como de capacidades, e o Llama 2 não é exceção. O modelo Claude 3 da Anthropic conseguiu superar o modelo Llama 2, bem como outros LLMs populares e avançados.

Neste artigo, vamos explorar os modelos Claude 3 e Llama 2 e as diferenças entre eles.

Estás pronto? Vamos mergulhar!

TL; DR

- O Claude 3 é o mais recente e mais avançado modelo de língua grande desenvolvido pela Anthropic e apresentado a 4 de março de 2024.

- O Claude vem com 3 tamanhos diferentes concebidos para 3 tarefas diferentes: Haiku, Sonnet e Opus.

- Para aceder aos modelos Claude 3, podes utilizar o sítio Web oficial do Anthropic ou ir a TextCortex, que o combina com funcionalidades avançadas.

- O Llama 2 é um modelo de linguagem de grande dimensão desenvolvido pela Meta AI que está disponível em três tamanhos de modelo diferentes: 7B, 13B e 70B.

- Embora o modelo Claude 3 seja superior ao modelo Llama 2 em termos de desempenho e janela de contexto, o Llama 2 é gratuito para investigação e utilização comercial.

- Se procuras uma experiência de IA de conversação melhor do que Claude 3 e Llama 2, o ZenoChat da TextCortex é o caminho a seguir.

Crítica do Claude 3

O Claude 3 é um modelo desenvolvido pela Anthropic que consegue ultrapassar os mais avançados modelos de linguagem de grande dimensão. Com o Claude 3, podes gerar um texto novo e único ou uma saída baseada em código, experimentar uma conversação semelhante à humana ou automatizar as tuas tarefas mundanas repetitivas.

Tamanhos do modelo Claude 3

O modelo Claude 3 Large Language é fornecido com três tamanhos diferentes de modelos concebidos para diferentes tarefas e casos de utilização:

- Haiku: O Haiku, o membro mais pequeno da família Claude 3, foi concebido para automatizar tarefas de nível básico.

- Sonnet: O modelo Sonnet, o meio da família Claude 3, foi concebido para realizar tarefas de nível médio e tem um desempenho superior ao do modelo GPT-3.5.

- Opus: O modelo Opus, o maior membro da família Claude 3, foi concebido para realizar tarefas altamente complexas e é mais eficaz do que o GPT-4.

Claude 3 Preços

Embora não precises de pagar qualquer taxa para utilizar o modelo Claude 3 Sonnet, tens de ter uma subscrição Claude Pro de 20 dólares para utilizar o modelo Claude 3 Opus como chatbot de IA. Se quiseres utilizar os modelos do Claude 3 como um API, os preços são os seguintes:

- Claude 3 Haiku: $0,25 por milhão de fichas de entrada, $1,25 por milhão de fichas de saída

- Claude 3 Sonnet: $3 por milhão de fichas de entrada, $15 por milhão de fichas de saída

- Claude 3 Opus: $15 por milhão de fichas de entrada, $75 por milhão de fichas de saída

Como posso aceder ao Claude 3?

Para aceder ao modelo Claude 3, basta criar uma conta Anthropic. Em seguida, podes começar a experimentar os modelos Claude 3 indo à interface web claude.ai.

Outra forma de experimentares os modelos do Claude 3 é o ZenoChat de TextCortex. Com o ZenoChat, podes experimentar todos os modelos de Claude 3, incluindo Opus, Sonnet e Haiku.

O que é o Llama 2?

O Llama 2 é um dos populares modelos de linguagem de grande dimensão desenvolvidos e introduzidos pela Meta AI. O modelo Llama 2 foi concebido para responder a resultados inofensivos e úteis através da análise das entradas dos utilizadores. Além disso, o modelo Llama 2 é também um LLM útil para tarefas de geração de código. Além disso, o Llama 2 é gratuito para investigação e utilização comercial.

Tamanhos do modelo Llama 2

O modelo Llama 2 é composto por três modelos com diferentes tamanhos de parâmetros: 7B, 13B e 70B. Estes modelos foram treinados utilizando técnicas como o processamento de linguagem natural, a aprendizagem por reforço a partir de feedback humano, modelos de recompensa e aprendizagem automática. Embora estes modelos possam competir com o modelo GPT-3.5, os modelos Claude 3 têm um desempenho superior.

O que é que a Llama 2 pode gerar?

Com o modelo Llama 2, podes gerar resultados baseados em texto, tais como histórias, poemas, artigos, publicações em blog , ensaios e e-mails. Além disso, podes utilizá-lo para reescrever os teus textos existentes ou traduzi-los para outra língua.

Além disso, o modelo Llama 2 oferece aos seus utilizadores a oportunidade de gerar resultados em linguagens de codificação. Com a Llama 2, podes gerar resultados para qualquer linguagem de programação ou realizar as tuas tarefas de engenharia rápida.

Como acederes ao Llama 2?

Podes aceder ao modelo Llama 2 e aos seus 3 tamanhos diferentes através do site oficial da Meta AI. Além disso, podes descarregar estes modelos e utilizá-los para a tua investigação ou para fins comerciais.

Comparação entre o Anthropic's Claude 3 e o Meta AI's Llama 2

Agora já tens informações básicas sobre o modelo Claude 3 da Anthropic e o modelo Llama 2 da Meta AI. A seguir, podemos comparar estes dois grandes modelos de linguagem sob diferentes aspectos e descobrir qual deles é o ideal para ti!

Diferença de desempenho

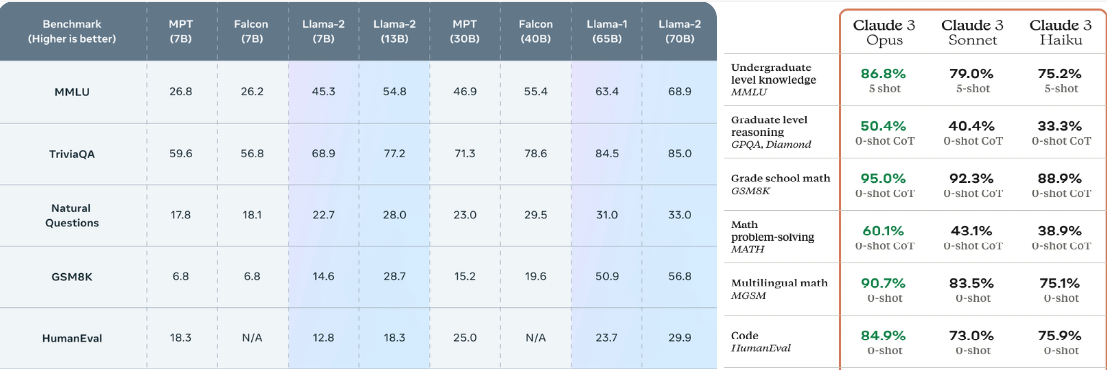

Todos os tamanhos do modelo Claude 3 têm pontuações mais elevadas nos testes de referência do que o modelo Llama 2. Por exemplo, enquanto o 70B, que é o tamanho mais avançado do modelo Llama 2, tem uma pontuação de 68,9% no benchmark MMLU, o Haiku, o tamanho mais pequeno do modelo Claude 3, tem uma pontuação de 75,2% no mesmo benchmark. Podemos ver a mesma diferença de pontuação noutros testes de desempenho, como o GSM8K e o HumanEval. Por outras palavras, o modelo Claude 3 supera o modelo Llama 2 em termos de desempenho.

Janela de contexto

Enquanto os modelos Llama 2 oferecem aos utilizadores uma janela de contexto de 4096 tokens, os modelos Claude 3 oferecem uma janela de contexto de 200K tokens. Nesta comparação, o Anthropic oferece uma janela de contexto maior do que os modelos Llama 2, mesmo com o modelo Claude 2. No entanto, aumenta consideravelmente esta diferença com o modelo Claude 3. Por outras palavras, se tiveres tarefas que exijam que trabalhes com grandes quantidades de dados, o Claude 3 é uma melhor escolha.

Fixação de preços

Embora tenhas de pagar uma taxa para utilizar o modelo Claude 3 como um API, podes utilizar e integrar o modelo Llama 2 gratuitamente. Por outro lado, podes conversar gratuitamente através do claude.ai com o modelo Claude 3 Sonnet, que oferece um desempenho superior a todos os tamanhos do modelo Llama 2. No entanto, se quiseres conversar com um chatbot de IA utilizando o modelo Claude 3 Opus, tens de ter uma subscrição Claude Pro de 20 dólares.

Uma alternativa melhor para ambos: ZenoChat

Se estás à procura de um assistente de IA de conversação que ofereça mais funcionalidades e capacidades avançadas do que o Claude 3 e o Llama 2, o ZenoChat foi concebido para ti. O ZenoChat é uma IA de conversação concebida para ajudar os utilizadores a realizar as suas tarefas diárias e profissionais, reduzindo a sua carga de trabalho e aumentando a produtividade. O ZenoChat está disponível como uma aplicação web e um browser extension. O navegador ZenoChat extension está integrado em mais de 30.000 sites e aplicações, para que te possa apoiar em qualquer lugar e a qualquer momento.

O ZenoChat oferece uma experiência de IA totalmente personalizável através dos nossos recursos "Personas Individuais" e "Bases de Conhecimento". A nossa caraterística "Personas Individuais" permite-te ajustar o estilo de saída do ZenoChat, o tom de voz, a personalidade, a atitude e a emoção dominante nas suas respostas como quiseres. Por outras palavras, com esta caraterística, podes construir o ZenoChat como quiseres.

O nosso recurso "Bases de Conhecimento" permite-te carregar ou conectar os conjuntos de dados que o ZenoChat usará ao produzir a saída. Usando este recurso, podes treinar o ZenoChat para os teus táxis específicos, conversar com os teus PDFs, ou resumir grandes quantidades de dados com um único prompt.

%20(1).png)

%20(20).png)