Enquanto a IA continua a desenvolver-se a toda a velocidade, a Apple entrou neste sector e descobriu abordagens diferentes e novas para a formação de um MLLM (Multimodal Large Language Model). Durante o treino do modelo MM1, a Apple ofereceu um método mais eficaz, personalizando o processo tradicional de treino do Modelo Multimodal de Grande Linguagem. Este método envolve a utilização eficaz de grandes quantidades de conjuntos de dados com parâmetros e hiperparâmetros adequados. Se estás a pensar como funciona o modelo MM1, estás no sítio certo!

Neste artigo, vamos explorar o que é o modelo MM1 e como funciona.

Estás pronto? Vamos mergulhar!

TL; DR

- O MM1 da Apple é um modelo de linguagem multimodal de grande dimensão desenvolvido com uma abordagem única de pré-treino e afinação.

- O modelo Apple MM1 foi lançado com três tamanhos de parâmetros diferentes: 3B, 7B e 30B.

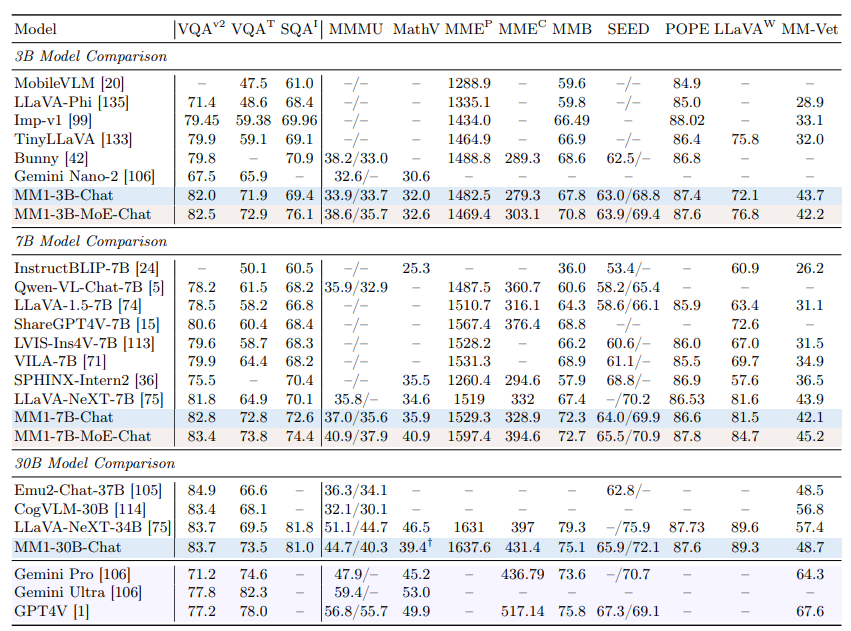

- Enquanto o modelo MM1 da Apple supera os modelos GPT-4 e Gemini Ultra em alguns benchmarks, fica atrás por uma pequena margem em outros.

- Durante o treino do modelo Apple MM1, os codificadores de imagem, os conectores de linguagem de visão e as fases de dados treinados foram redesenhados.

- Se precisas de um assistente de IA para te apoiar na vida quotidiana e profissional, não procures mais, TextCortex.

- TextCortex visa automatizar o teu volume de trabalho e aumentar a tua produtividade com as suas funcionalidades únicas e capacidades avançadas de IA.

O que é o Apple MM1?

O modelo MM1 da Apple é um Modelo Multimodal de Linguagem Ampla (MLLM) concebido para realizar tarefas de base visual com elevado desempenho e requisitos mínimos de sistema. Este modelo foi desenvolvido com uma abordagem única e nova ao processo de formação do MLLM. Esta abordagem visa a máxima eficiência com parâmetros mínimos.

Tamanhos do modelo MM1 da Apple

O modelo de linguagem multimodal de grande porte MM1 da Apple foi ampliado para três tamanhos diferentes, cada um com quantidades variáveis de parâmetros: 3B, 7B e 30B. Além disso, estes modelos foram escalados utilizando uma abordagem de mistura de especialistas (MoE). Este escalonamento é o fator crucial por detrás do desempenho sem paralelo do MM1 durante as fases de pré-treino e de afinação.

A MM1 é melhor do que a ChatGPT?

Graças ao seu elevado desempenho nas fases de pré-treinamento e afinação, o modelo Apple MM1 pode competir com modelos como o GPT-4V e o Gemini Ultra e até superá-los em alguns parâmetros de referência. Por exemplo, o modelo MM1 30B conseguiu superar o modelo GPT-4 Vision e o modelo Gemini Ultra no parâmetro de comparação VQAv2. No que respeita a outros parâmetros de referência, é possível verificar que o modelo MM1 tem um desempenho ligeiramente inferior ao dos modelos Gemini Ultra e GPT-4.

Como posso aceder ao MM1?

Uma vez que a Apple ainda não disponibilizou publicamente o modelo MM1, não nos é possível experimentá-lo de forma alguma. No entanto, o laboratório de investigação da Apple afirmou que todos os tamanhos MM1 estarão disponíveis em breve.

Como funciona o MM1 da Apple?

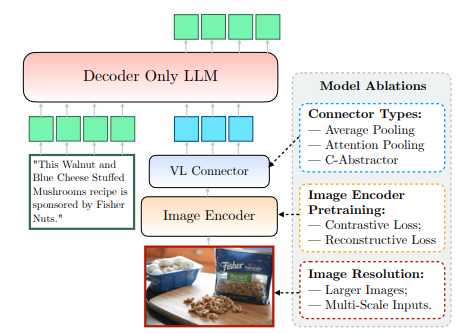

O modelo MM1 da Apple, que ainda não está disponível publicamente, foi treinado de uma forma nova e única, indo além dos métodos tradicionais. De acordo com o laboratório de investigação da Apple, para treinar um modelo com a máxima eficiência, é necessário examinar a relação complexa entre o design arquitetónico do MLLM e a integração de diversos conjuntos de dados. Este método tem como objetivo obter a máxima eficiência com o mínimo de parâmetros. Podemos aceder claramente a esta informação no documento partilhado pela Apple. Vamos ver de perto como funciona o MM1 da Apple.

Codificador de imagem

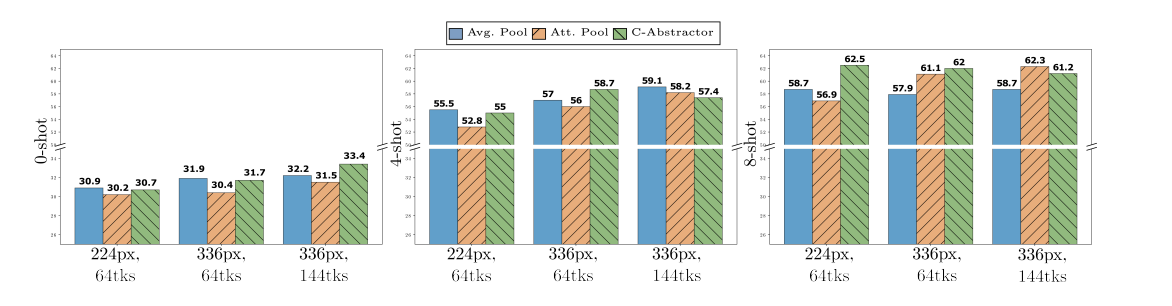

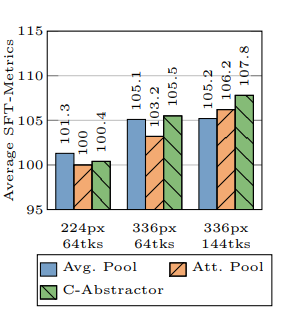

Durante o treino do modelo MM1, o Apple Research Lab descobriu que a resolução da imagem tem o maior impacto no processo de treino. O modelo MM1 foi treinado com imagens com uma resolução de 378x378 pixéis. Este processo de treino foi concluído utilizando os modelos de aprendizagem profunda ViT-H (Vision Transformer - Huge) e CLIP (Contrastive Language-Image Pretraining). Enquanto o modelo ViT-H foi concebido pela Google para a classificação de imagens, o CLIP é útil para a incorporação de imagens concebidas pela OpenAI.

Conector visão-linguagem

De acordo com o Laboratório de Investigação da Apple, quando se desenvolve um MLLM, se quiseres que este apresente um elevado desempenho em tarefas de base visual, a resolução de uma imagem e o número de símbolos visuais são essenciais para levar o processo de formação para o nível seguinte. O laboratório de pesquisa da Apple usou um conetor VL com 144 tokens ao desenvolver o modelo MM1.

Em que dados o Apple MM1 foi treinado?

Os dados treinados de um Modelo Multimodal de Linguagem Ampla (MLLM) funcionam como a sua memória e o conhecimento que utiliza para gerar resultados. Por conseguinte, quanto mais diversificados e extensos forem os dados treinados de um MLLM, mais concisos serão os resultados que pode produzir.

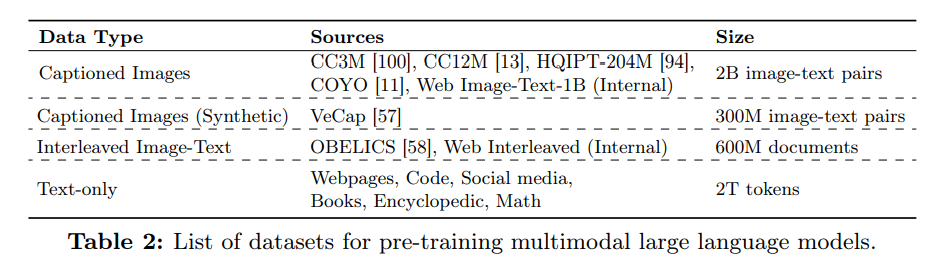

O laboratório de investigação da Apple utilizou uma quantidade significativa de dados que consistem em texto e imagens para melhorar o desempenho do modelo MM1 em termos de zero e poucos disparos. De acordo com o artigo da Apple, o modelo MM1 é treinado utilizando uma variedade de dados que inclui 45% de documentos de texto-imagem intercalados, 45% de documentos de pares de texto-imagem e 10% de documentos apenas de texto.

%20(6).png)

%20(20).png)