Embora todas as grandes empresas, como a Google, a Microsoft e a Meta, tenham começado a trabalhar no domínio da IA e estejam a produzir modelos avançados de IA, um após o outro, a Apple, que é a empresa que resta, participou nesta corrida da IA com o seu modelo multimodal de linguagem de grande dimensão chamado MM1. Este modelo foi treinado com dados textuais e dados visuais. O modelo de linguagem multimodal de grande dimensão MM1 foi treinado com uma mistura de imagens com legendas (45%), documentos intercalados de imagem-texto (45%) e dados apenas de texto (10%).

Neste artigo, vamos descobrir o que é o modelo de linguagem multimodal de grande dimensão MM1 da Apple.

Se estás pronto, vamos começar!

TL; DR

- MM1 é uma família de modelos de linguagem multimodal de grande dimensão desenvolvida e anunciada pela Apple.

- O modelo MM1 foi desenvolvido com um método de treino e construção diferente, ao contrário dos MLLMs tradicionais.

- Ao construir o modelo MM1, a arquitetura, os dados treinados, o codificador de imagem, os parâmetros, os hiperparâmetros e o procedimento de treino foram recriados para serem eficazes.

- O modelo MM1 tem um número de parâmetros e um tamanho inferior ao dos seus concorrentes, o que lhe permite funcionar sem problemas em dispositivos móveis.

- Se procuras um assistente de IA que esteja sempre contigo, como é o caso dos dispositivos móveis, TextCortex é o caminho a seguir, com a sua integração de mais de 30.000 sites e aplicações.

- TextCortex oferece uma variedade de soluções de IA personalizáveis e interactivas, desde a escrita até às tuas tarefas profissionais.

O que é o Apple MM1?

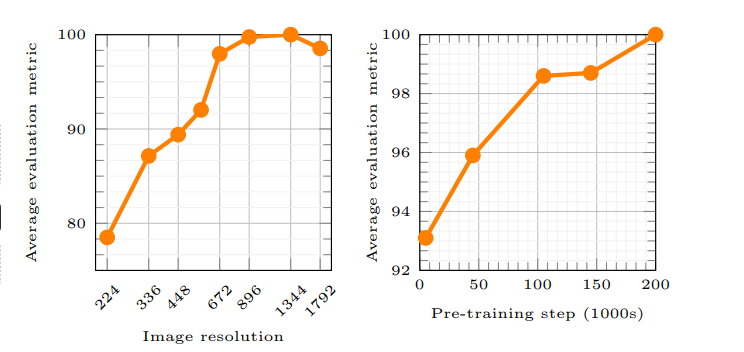

O MM1 da Apple é uma família de MLLM (Multimodal Large Language Model) que pode tratar e gerar processos visuais e de texto. De acordo com o artigo da Apple, o princípio de funcionamento do modelo MM1 permite que a IA compreenda melhor as instruções do utilizador e gere o resultado desejado. Foram utilizados novos métodos para treinar o modelo MM1 e estes métodos afirmam que a resolução da imagem e a capacidade do codificador visual tiveram o maior impacto no desempenho do modelo.

A Apple está a ficar para trás na corrida à IA?

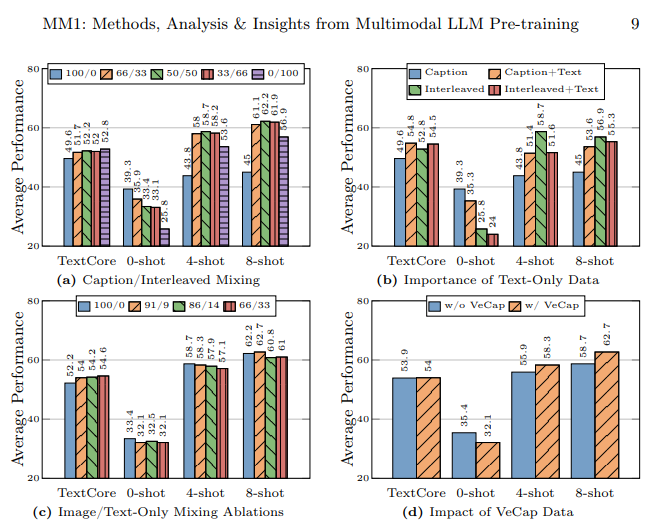

O laboratório de investigação da Apple tinha como objetivo criar um modelo de linguagem multimodal de grande dimensão (MLLM) de elevado desempenho, examinando cuidadosamente toneladas de métodos de formação e construção de IA. De acordo com o artigo da Apple, a utilização de diferentes tipos de dados no treino de um modelo de IA, a utilização de documentos de imagem-texto na aprendizagem de poucas imagens, a utilização de imagens com legendas para aumentar o desempenho de zero imagens e dados apenas de texto realçam a importância de uma forte compreensão da linguagem para melhorar o desempenho.

Como é que o modelo MM1 foi construído?

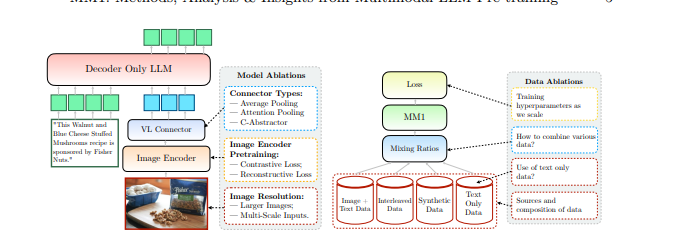

A Apple mencionou que foi além dos métodos tradicionais para construir o modelo MM1 e que esses métodos eram necessários para construir um Modelo Multimodal de Linguagem Ampla (MLLM) de alto desempenho. A Apple considera três passos básicos na construção do modelo MM1:

- Arquitetura: A equipa do laboratório de investigação da Apple analisou métodos de ligação de diferentes codificadores de imagem pré-treinados e LLMs com estes codificadores para construir uma arquitetura única.

- Dados treinados: O modelo MM1 é treinado com conjuntos de dados que contêm diferentes tipos de dados, como visuais e de texto, e combinações desses dados.

- Procedimento de treino: Em vez de ser treinado com um grande número de parâmetros, o modelo MM1 foi treinado concentrando-se nos hiperparâmetros e na fase em que serão utilizados.

Capacidades MM1 da Apple

O MM1 Multimodal Large Language Model (MLLM) da Apple tem métodos de treino diferentes, menos parâmetros e abordagens diferentes ao processo de treino em comparação com os MLLMs tradicionais. A Apple afirma que o modelo MM1 foi criado através da descoberta dos métodos mais eficientes e da experimentação de inovações para treinar um MLLM. Vamos analisar mais detalhadamente as capacidades e as diferenças de formação do modelo MM1.

Arquitetura

O modelo MM1 tem uma arquitetura diferente da de outros MLLM (Multimodal Large Language Models). Esta arquitetura inclui codificadores com uma resolução de imagem mais elevada, uma abordagem diferente ao processo de pré-treino e a mistura de dados rotulados para aumentar o desempenho global de uma única mensagem. O laboratório de investigação da Apple centra-se na importância das várias escolhas de dados para treinar o modelo MM1. Por outras palavras, o modelo MM1 tem uma arquitetura que visa proporcionar um desempenho superior utilizando menos recursos do que os MLLMs tradicionais.

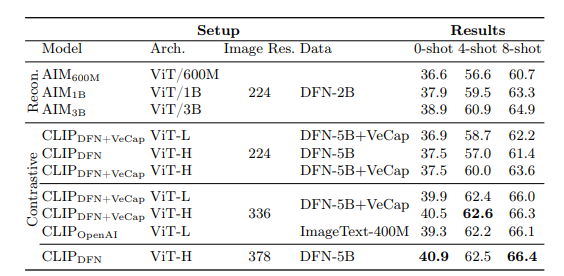

Codificador de imagem

A maioria dos modelos de linguagem multimodal de grande dimensão utiliza o codificador de imagem pré-treinado CLIP (Contrastive Language-Image Pretraining) para processar dados visuais. Além disso, estudos recentes demonstram que os modelos auto-supervisionados apenas de visão funcionam de forma mais eficaz. Ao analisar estes codificadores, a equipa de investigação da Apple descobriu que o método mais eficaz de treinar um MLLM com dados visuais é através das imagens seleccionadas para os codificadores. De acordo com o laboratório de investigação da Apple , os dados utilizados no processo de processamento de um codificador de imagem afectam diretamente o desempenho do codificador. O resultado de toda esta investigação é o seguinte: a resolução da imagem tem o maior impacto, seguida do tamanho do modelo e da composição dos dados de treino.

Parâmetros MM1

De acordo com o laboratório de investigação da Apple, o que é mais importante do que o tamanho dos parâmetros num Modelo Multimodal de Linguagem Ampla (MLLM) é o ajuste fino, a escala e os hiperparâmetros desses parâmetros.

Os parâmetros do modelo MM1 foram utilizados com a máxima eficiência para analisar e processar várias entradas de dados. O modelo MM1 é uma família de modelos de IA que consiste em três tamanhos de parâmetros diferentes: 3B, 7B e 30B. Além disso, quanto mais pequeno for o tamanho dos parâmetros de um MLLM, mais eficazmente funcionará em dispositivos móveis.

Se estás à procura de um assistente de IA que te apoie sempre, tanto em dispositivos móveis como em computadores de secretária, para te ajudar a concluir as tuas tarefas diárias ou profissionais, deves manter o TextCortex no teu radar.

%20(5).png)

%20(20).png)