クリエイティブコンテンツAPI of the web

大規模な言語モデルの力で、ワークフローの生産性を4倍にする準備はできていますか。インフラストラクチャーに悩まされることなく?

自然言語処理、生成、機械創造でワークフローをスマートに。

環境の問題、GPUの不足、プロンプトの問題、サーバーの過負荷、パラメータの最適化もありません。

ワークフローと製品のために、純粋なNLP のパワーだけが必要です。

各ソリューションは、API のエンドポイントをお客様のコードベースにシンプルに統合するものです。

お客様のタスクに適した価格モデルを見つけるお手伝いをします

CHOOSE YOUR MODEL

たくさんのモデルがあり、どれも個性があるように感じられます。私たちは、あなたのワークフローに最適なワーキングモデルを選ぶお手伝いをします。

Veloxは最も高速なモデルで、Altaは最もパワフルなモデルです。ソフォスのモデルは、高度に専門化されたワークフローのために微調整されたNeoCortexエキスパートモデルです。

これらのモデルは、分類、エンティティ抽出、要約、コンテンツ生成、コード生成、言い換えなど、さまざまな目的で使用することが可能です。

ヴェロックス

エイクス

アルタ

ソフォス

短い説明

はやおき

バランス型

強者

本職の方

1Kトークンあたりの価格

$0.01

$0.02

$0.04

$0.12

多言語サーチャージ

(1Kトークンあたりの価格)

+$0.12

+$0.12

+$0.12

+$0.12

ファインチューニング

オン・リクエスト

オン・リクエスト

オン・リクエスト

オン・リクエスト

専用GPU

オン・リクエスト

オン・リクエスト

オン・リクエスト

オン・リクエスト

パラメータサイズ

最大で50億円

最大で190億円

200億円以上

-

Got data? Let’s bring your models to the next level

FINE-TUNING - IMPROVE PERFORMANCE AND EFFICIENCY

Out of the box models are not made for your specific pain points?

That’s why we help you nail them down to what you need. With fine-tuned models on your data and workflow we can achieve better results while reducing overall costs in a number of tasks.

A small set of 100 examples can:

- improve task performance by 10x

- lead to 28% cost reduction

.png)

モデル持参

最適化で行き詰まった?

より大きなモデルをインフラに載せるのは無理があるのでは?私たちは、お客様が独自のモデルをホストし、継続的な最適化に対処するのを支援します。

- テキスト作成の作業の70%を奪う

- ユーザー、業界、ニッチに合わせてテキスト生成をカスタマイズできる

- 無敵のタイムセーバーを価値提案に加える

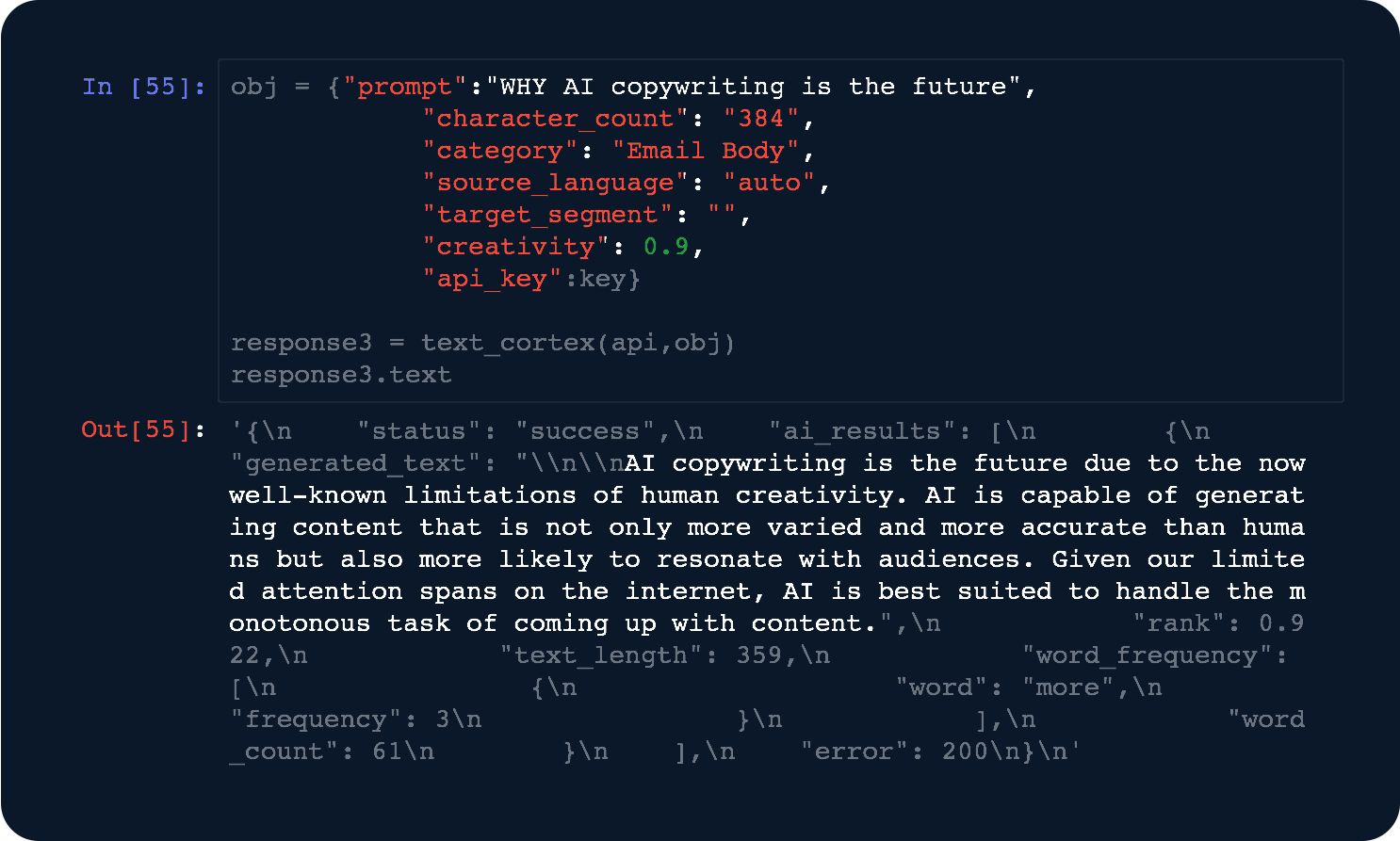

パワフルで使いやすいAPI

DEVELOPERS AT HEART

↪CF_200D↩

開発者のための開発者より、開発者のための開発者。3行以下のコードで、私たちのAPI に統合されます。

- 高度な最適化 - 最高の応答速度を実現するために、常にモデルの微調整を続けています。

- 専用コンピューティング - 専用コンピューティングパワーで、より高いパフォーマンスを引き出すことができます。

ワークフローをスマートにする

大規模な言語モデルをAPI としてホストするサービスをお探しですか?

お客様のインフラで大規模なモデルを作るのに苦労していますか? お客様自身のモデルをホストし、継続的な最適化に対処することを支援します。

よくあるご質問の一部をご紹介します。

トークンとは、私たちのモデルが動作する量を表す業界用語です。トークンは、私たちのモデルが動作する量を表す業界用語で、あなたがモデルに与える入力から、モデルがあなたのために生成する出力までを表します。

トークンは、あなたが都市システムから消費し、そこに戻す水のリットル数を支払うようなものだと考えてください。

トークンは、水の1リットルは水の1000ミリリットルと同じように、異なる単位で表すことができる測定形式です。同様に、1トークンは4文字で構成されています。

ところで、平均的な単語は4.5文字で構成されていることをご存じでしょうか?つまり、1トークンはほぼ1単語なのです!

これをもう一度整理してみますと。ここまでのテキストは、約670文字、124単語で、およそ169個のトークンを作っています。

もしAltaがこのブロックを作ったとしたら、次のようなコストがかかるでしょう:

[全トークンの数] x [Altaの1トークンあたりの価格] = コスト

169 x 0.00002 = 0.0038 USD

その他、弊社でホスト、最適化、運用が可能なモデルとしては、

- GPT Neo 2.7 bn.

- GPT-J 6 bn.

- GPT NeoX 20 bn.

- OPT:Open Pre-trained Transformer Language Models (125M to 66bn)

- FairSeq (13bn.)

- CodeGen (16bn.)

- Bloom 560m

- Bloom 1.1 bn.

- Bloom 1.7 bn.

- Bloom 3 bn.

- Bloom 7.1 bn.

- Bloom 176 bn.(

- t5 Small

- t5 Base

- t5 Large

- t5 3b

- t5 11b

- Stable Diffusion hostedAPI

ご不明な点は、インテグレーションチームまでご連絡ください。

LongForm用の「Aecus」モデルによる生成タスクは 、ほとんどの場合、非常に出力が重いです。

次の入力プロンプトについて考えてみましょう:

"The NeoCortex text generationAPI helps you in your workflow" (60 character = 15 tokens)

これが実際の出力です:

"What is the NeoCortex?

NeoCortexは深層学習によるテキスト生成API 、自然言語のみを使用してテキストを生成します。生成されたテキストは、人間が読んで理解できるように設計されており、ワークフローに役立てることができます。API は、シンプルなインターフェイスで学習が容易です。そのため、独自のアプリケーションを作りたい開発者が使うのに最適です。"(360 characters = 90 Tokens)

合計トークン数は15 + 90 = 105 Tokensとなります。

0.02$ ÷ 1000 times 105 = 0.0021 $ がリクエストに対して課金されることになります。

モデルのファインチューニングを行う場合、お客様のデータをお預かりして、そのデータに対してどのように振る舞うか、何が期待されているかをモデルに教えることになります。

必要なのは、お客様のワークフローから得られた高品質のデータを含むデータセットです。 500件程度のデータセットから最初の改善が見られます

。

API エンドポイントをできるだけわかりやすく管理するよう心がけています。

直接のガイダンスをお探しの場合は、当社の統合チームにお問い合わせください。

大規模な言語モデル(LLM)を実行するには、GPUのような強力な計算機が必要です。

インフラの構築、メンテナンス、最適化には高いコストがかかるものです。

TextCortex では、NeoCortexのシステムを2つのコスト削減方法で利用することができます。例えば、月に10万件以下のリクエストや、100億以下のパラメータを持つ小規模なモデル。 他のお客様と共有環境で実行します。 2

)GPU時間単位の支払い

大規模なプロセス運用に最適です。例えば、数百万件のリクエストや200億以上のパラメータを持つモデルなど。 Ȁ

このオプションは、お客様のケース専用のリソースを使用する優先オプションです。

より詳しいガイダンスが必要な場合は、当社のインテグレーションチームにお問い合わせください。