Meta AI presentó un LLM que se acerca a la tecnología de IA actual al anunciar el modelo Llama 3 el 18 de abril de 2024. Aunque el modelo LLama 3 es más avanzado que su predecesor, el modelo LLama 2, en general es un competidor de los modelos de lenguaje grande de nivel medio como GPT-3.5 y Claude 3 Sonnet. El modelo LLama 3 de Meta AI promete un mejor razonamiento, datos más entrenados y comprensión del lenguaje en comparación con su predecesor. Si te estás preguntando por el modelo Llama 3, ¡estás en el lugar correcto!

En este artículo, exploraremos juntos el modelo Llama 3 y sus características.

Si estás preparado, ¡empecemos!

TL; DR

- El modelo Llama 3 es un modelo de lenguaje grande desarrollado por Meta AI y anunciado el 18 de abril de 2024.

- Llama 3 viene en dos tamaños de modelo adecuados para diferentes casos de uso: 8B y 70B.

- Puedes visitar el sitio web oficial de Meta AI para acceder al modelo Llama 3, pero Llama 3 no está disponible actualmente en todos los países.

- Si quieres acceder al modelo Llama 3 en todo el mundo, ZenoChat by TextCortex es tu salvador.

- El modelo Llama 3 logró superar a sus rivales, los modelos Gemini Pro 1.5 y Claude 3 Sonnet, en los puntos de referencia.

- El modelo Llama 3 se entrena con datos especialmente filtrados y de alta calidad disponibles públicamente.

- Si está buscando una IA conversacional mejor que Llama 3, ZenoChat de TextCortex está diseñado para usted con sus opciones de personalización y capacidades de salida de texto e imagen.

Análisis de Llama 3 de Meta AI

El modelo Llama 3 es un modelo de lenguaje grande presentado por Meta AI el 18 de abril de 2024. El modelo Llama 3 ofrece características mejoradas y capacidades de generación de salida en comparación con su predecesor. El modelo Llama 3 tiene como objetivo ofrecer un rendimiento de vanguardia en una amplia gama de industrias con su razonamiento mejorado, comprensión del lenguaje afinada y nuevas capacidades.

Otro de los objetivos de Meta AI a la hora de desarrollar el modelo Llama 3 es mejorar su utilidad. Meta AI tenía como objetivo aumentar la eficiencia del modelo Llama 3 publicitándolo a la comunidad y a los desarrolladores de IA mientras estaba en desarrollo. Los planes futuros de Meta AI para el modelo Llama 3 incluyen hacerlo multilingüe y multimodal, aumentar la ventana de contexto y mejorar su rendimiento.

Tamaños de modelo de Llama 3

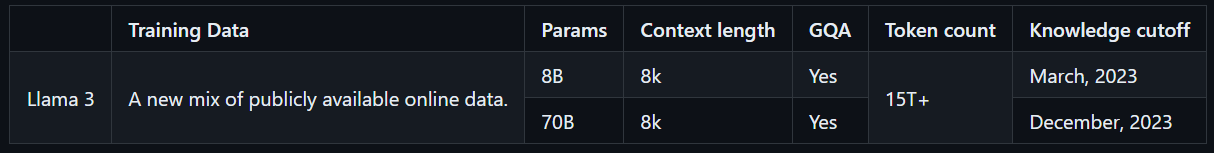

Llama 3 viene en dos tamaños de modelo que son adecuados para diferentes casos de uso: 8B y 70B. El modelo Llama 3 8B es más compacto, con un total de 8 mil millones de parámetros, y puede generar resultados más rápido. Por otro lado, el modelo Llama 3 70B tiene un total de 70 mil millones de parámetros y es adecuado para tareas complejas. Además, el modelo Llama 3 8B se entrena con datos en línea disponibles públicamente hasta marzo de 2023, mientras que el modelo Llama 3 70B se entrena con datos en línea disponibles públicamente hasta diciembre de 2023.

¿Cómo acceder a Llama 3?

Para acceder al modelo Llama 3, puede visitar el sitio web oficial de Meta AI, hacer clic en el botón "Comenzar" y seguir los pasos. Sin embargo, dado que el modelo Llama 3 no es accesible en todo el mundo, tiene una puntuación de disponibilidad baja, a diferencia de otros LLM. Sin embargo, hay formas de experimentar el modelo Llama 3 en todo el mundo.

Con ZenoChat por TextCortex, puedes acceder y experimentar ambos tamaños del modelo Llama 3 sin límites. ZenoChat será compatible con los LLM Llama 3, 8B y 70B, además de los LLM GPT-4, Sophos 2, Mixtral, Claude 3 Opus y Sonnet. Dicho esto, puedes experimentar libremente el modelo Llama 3 sin las restricciones de país de Meta AI.

Características principales de Llama 3 de Meta AI

Llama 3, el modelo más nuevo y avanzado de Meta AI, tiene un mayor rendimiento y nuevas características que su predecesor. El modelo Llama 3 se introdujo como competidor no de los LLM de gama alta como GPT-4 y Gemini Ultra, sino de modelos de uso más frecuente como GPT-3.5 y Gemini Pro. Echemos un vistazo más de cerca a las características principales de Llama 3.

Rendimiento del modelo

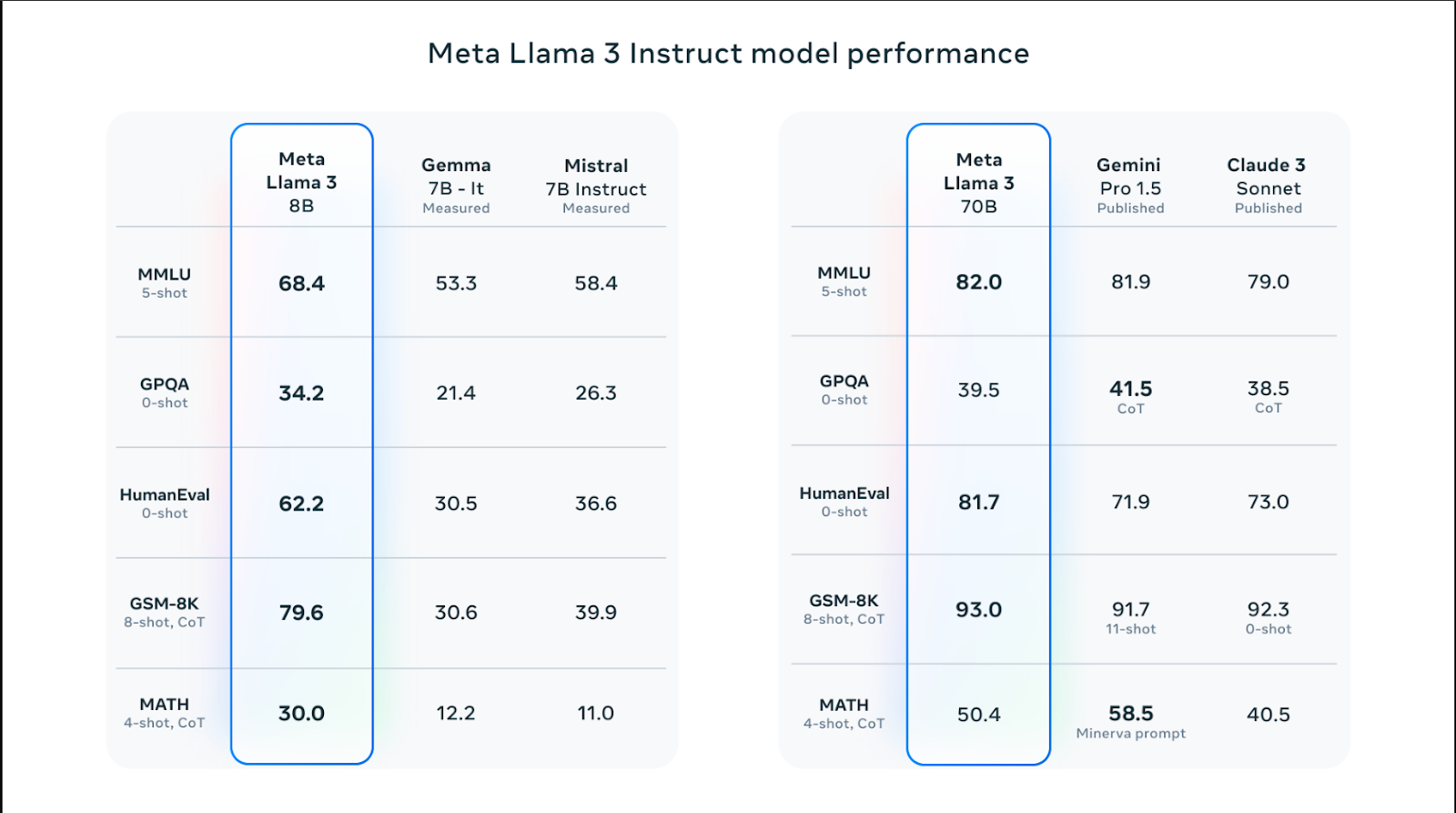

Los modelos Llama 3 vienen en diferentes tamaños y tienen un mejor rendimiento que los modelos Llama 2 en habilidades como el razonamiento, la generación de códigos, las matemáticas y el seguimiento de instrucciones. Entre los modelos Llama 3, el modelo 70B superó a modelos populares como Claude 3 Sonnet y Gemini Pro 1.5 al obtener una puntuación de 82.0 en el punto de referencia MMLU. Sin embargo, los modelos Llama 3 funcionan mejor que los modelos Claude 3 Sonnet y Gemini Pro 1.5 en todos los puntos de referencia, excepto en el punto de referencia MATH, que mide las habilidades matemáticas, y el GPQA, que mide las puntuaciones de preguntas y respuestas a nivel de posgrado.

El modelo Llama 3 8B logró superar a sus modelos rivales Gemma 7B y Mistral 7B en los puntos de referencia Humaneval, MMLU, GPQA, GSM-8K y MATH. En otras palabras, los tamaños de los modelos Llama 3 tienen un mayor rendimiento que sus modelos rivales.

Datos de entrenamiento

El modelo de Llama 3 se entrenó con una gran cantidad de datos, lo cual es fundamental para crear un modelo de lenguaje grande de alto rendimiento. Específicamente, se entrenó con tokens 15T de fuentes disponibles públicamente, 7 veces más que la cantidad de datos utilizados para entrenar el modelo Llama 2.

Además, el modelo Llama 3 se entrenó con un conjunto de datos de alta calidad que consta de 30 idiomas diferentes además del inglés. Esto ha dado como resultado un aumento significativo en la comprensión del lenguaje, la creatividad y las habilidades de seguimiento de indicaciones del modelo.

El equipo de IA de Meta ha desarrollado una serie de canalizaciones de filtrado de datos para entrenar el modelo Llama 3 con datos fiables y de alta calidad. Estos filtros incluyen parámetros como el filtro NSFW, el filtro heurístico, el enfoque de deduplicación semántica y el clasificador de texto. Además, dado que el modelo Llama 2 es bueno para identificar datos de alta calidad, se utilizó para filtrar los datos entrenados del modelo Llama 3.

Optimización

Los modelos Llama 3 están especialmente optimizados para modelos y marcas de GPU y CPU de uso frecuente. Cuanto más se optimice el software para un hardware específico, mayor será el rendimiento y más rápido se ejecutará. El modelo Llama 3 está optimizado para hardware Intel, AMD y Nvidia. Además, Intel ha publicado una guía detallada sobre el rendimiento del modelo Llama 3.

Seguridad

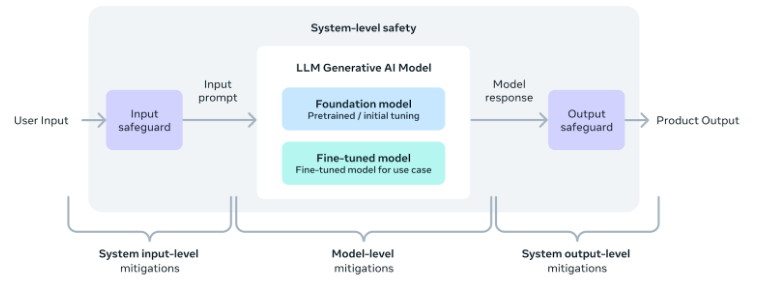

El equipo de IA de Meta reconoce la importancia del uso seguro de las herramientas y el software de IA, incluido el modelo Llama 3. En consecuencia, se agregaron parámetros de seguridad durante el desarrollo del modelo para garantizar que su salida sea segura, inofensiva y ética.

Además, el equipo también ha proporcionado una guía de implementación de seguridad a nivel de sistema para aquellos que deseen desarrollar aplicaciones utilizando el modelo Llama 3. Con estas medidas, los usuarios pueden disfrutar de la comodidad y los beneficios de las herramientas de IA mientras las utilizan de manera segura y responsable.

Una mejor alternativa: ZenoChat de TextCortex

Si está buscando un asistente de IA personalizable con acceso a varios LLM, incluido el modelo Llama 3, ZenoChat by TextCortex está diseñado para ti. ZenoChat es una herramienta de IA que ofrece a sus usuarios las ventajas de diferentes LLM y no los limita a un solo LLM. ZenoChat tiene como objetivo ayudar a sus usuarios en tareas profesionales y diarias, como la generación de textos, la paráfrasis y la investigación. Con ZenoChat, puedes acelerar cualquier tarea 12 veces, reducir tu carga de trabajo y disparar tu productividad.

ZenoChat está disponible como aplicación web y navegadorextension. El navegador ZenoChat extension está integrado con 30,000+ sitios web y aplicaciones. Por lo tanto, puede continuar apoyándolo en cualquier lugar y en cualquier momento.

Trabaje con su propio conocimiento y datos

ZenoChat ofrece una experiencia de IA totalmente personalizable gracias a nuestras funciones "Bases de conocimiento" y "Personas individuales". Nuestra función "Personas individuales" le permite ajustar el estilo de salida de ZenoChat, la longitud de las oraciones, la emoción dominante en las oraciones y la personalidad como desee. En otras palabras, puedes utilizar esta función para convertir ZenoChat en tu asistente personal o en tu gemelo digital.

Nuestra función "Bases de conocimiento" le permite cargar o conectar fuentes de datos que ZenoChat utilizará para generar resultados. Al usar esta función, puede entrenar ZenoChat con sus propios datos y hacerlo adecuado para casos de uso específicos. Además, gracias a esta función, puedes resumir cientos de páginas de documentos con un solo mensaje o chatear con tus archivos PDF. Nuestra función "Bases de conocimiento" también tiene un botón que le permite integrar su Google Drive o Microsoft OneDrive en segundos.

%20(8).png)

%20(15).png)

%20(14).png)