Mientras la IA sigue desarrollándose a toda velocidad, Apple ha entrado en este sector y ha descubierto enfoques diferentes y nuevos para entrenar un MLLM (Multimodal Large Language Model). Al entrenar el modelo MM1, Apple ofreció un método más eficaz personalizando el proceso tradicional de entrenamiento del Modelo Multimodal de Grandes Lenguajes. Este método implica el uso eficaz de grandes cantidades de conjuntos de datos con los parámetros e hiperparámetros adecuados. Si te preguntas cómo funciona el modelo MM1, ¡estás en el lugar adecuado!

En este artículo exploraremos qué es y cómo funciona el modelo MM1.

¿Preparados? ¡Vamos a sumergirnos!

TL; DR

- El MM1 de Apple es un gran modelo lingüístico multimodal desarrollado con un enfoque único de preentrenamiento y ajuste.

- El modelo MM1 de Apple se lanzó con tres tamaños de parámetros diferentes: 3B, 7B y 30B.

- Aunque el modelo MM1 de Apple supera a los modelos GPT-4 y Gemini Ultra en algunas pruebas comparativas, en otras se queda atrás por un pequeño margen.

- Durante el entrenamiento del modelo Apple MM1, se rediseñaron los codificadores de imágenes, los conectores visión-lenguaje y las fases de datos entrenados.

- Si necesitas un asistente de IA que te ayude tanto en la vida cotidiana como en la profesional, no busques más: TextCortex.

- TextCortex pretende automatizar tu carga de trabajo y aumentar tu productividad con sus funciones únicas y sus avanzadas capacidades de IA.

¿Qué es Apple MM1?

El modelo MM1 de Apple es un Modelo Multimodal de Gran Lenguaje (MLLM) diseñado para realizar tareas basadas en la visión con un alto rendimiento y unos requisitos mínimos del sistema. Este modelo se desarrolló con un enfoque único y nuevo del proceso de entrenamiento del MLLM. Este enfoque persigue la máxima eficacia con los mínimos parámetros.

Tamaños del modelo MM1 de Apple

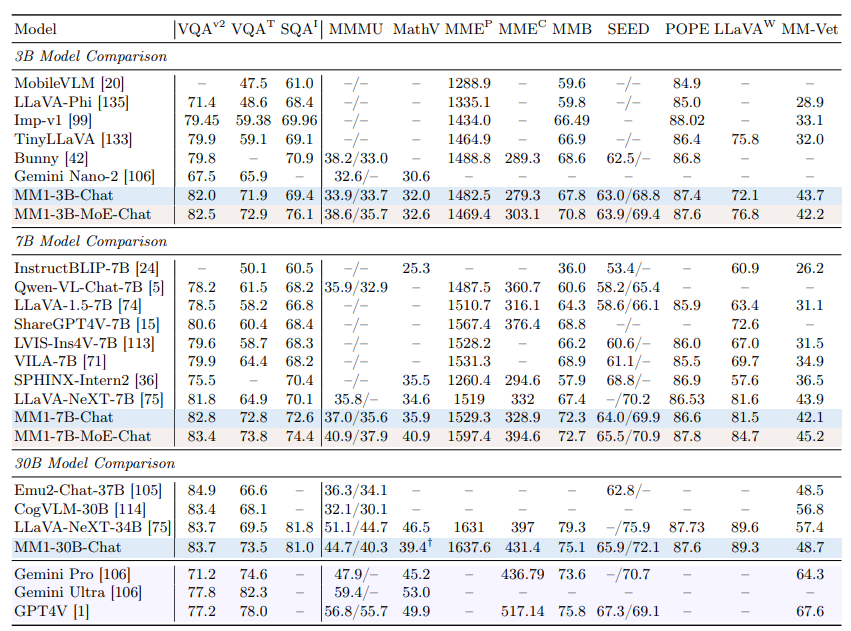

El modelo multimodal de gran lenguaje MM1 de Apple se ha ampliado a tres tamaños diferentes, cada uno con una cantidad variable de parámetros: 3B, 7B y 30B. Además, estos modelos se han escalado utilizando un enfoque de mezcla de expertos (MoE). Este escalado es el factor crucial que subyace al rendimiento sin parangón del MM1 tanto en la fase de preentrenamiento como en la de ajuste fino.

¿Es MM1 mejor que ChatGPT?

Gracias a su alto rendimiento en las fases de preentrenamiento y ajuste fino, el modelo MM1 de Apple puede competir con modelos como GPT-4V y Gemini Ultra e incluso superarlos en algunas pruebas comparativas. Por ejemplo, el modelo MM1 30B consiguió superar tanto al modelo GPT-4 Vision como al modelo Gemini Ultra en la prueba VQAv2. En cuanto a otros puntos de referencia, se puede ver que el modelo MM1 tiene un rendimiento ligeramente inferior al de los modelos Gemini Ultra y GPT-4.

¿Cómo puedo acceder a MM1?

Como Apple aún no ha puesto a disposición del público el modelo MM1, no nos es posible experimentarlo de ninguna manera. Sin embargo, el laboratorio de investigación de Apple ha declarado que pronto estarán disponibles todos los tamaños del MM1.

¿Cómo funciona el MM1 de Apple?

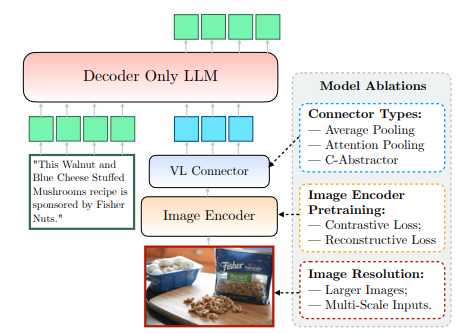

El modelo MM1 de Apple, que aún no está disponible públicamente, se ha entrenado de una forma nueva y única, que va más allá de los métodos tradicionales. Según el laboratorio de investigación de Apple, para entrenar un modelo con la máxima eficacia, es necesario examinar la compleja relación entre el diseño arquitectónico de MLLM y la integración de diversos conjuntos de datos. Este método pretende obtener la máxima eficacia con los mínimos parámetros. Podemos acceder claramente a esta información en el documento compartido por Apple. Veamos más de cerca cómo funciona el MM1 de Apple.

Codificador de imágenes

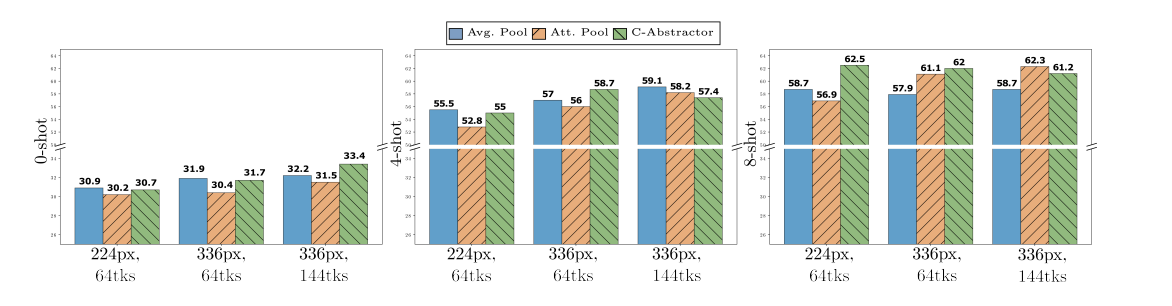

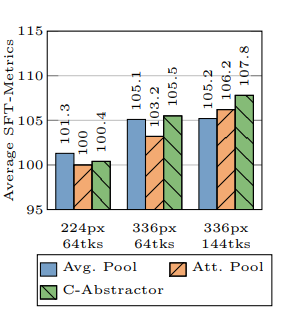

Al entrenar el modelo MM1, el Laboratorio de Investigación de Apple descubrió que la resolución de la imagen es lo que más influye en el proceso de entrenamiento. El modelo MM1 se entrenó con imágenes que tenían una resolución de 378x378 píxeles. Este proceso de entrenamiento se completó utilizando los modelos de aprendizaje profundo ViT-H (Vision Transformer - Huge) y CLIP (Contrastive Language-Image Pretraining). Mientras que el modelo ViT-H está diseñado por Google para la clasificación de imágenes, CLIP es útil para la incrustación de imágenes diseñadas por OpenAI.

Conector Visión-Lenguaje

Según el Laboratorio de Investigación de Apple, al desarrollar un MLLM, si quieres que ofrezca un alto rendimiento en tareas basadas en la visión, la resolución de una imagen y el número de fichas visuales son esenciales para llevar el proceso de entrenamiento al siguiente nivel. El laboratorio de investigación de Apple utilizó un conector VL con 144 tokens al desarrollar el modelo MM1.

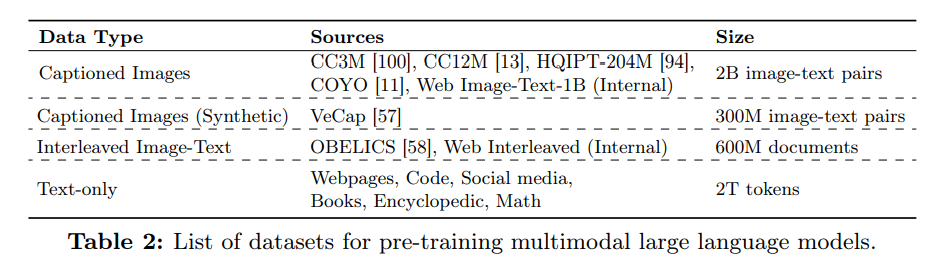

¿Con qué datos se entrenó el MM1 de Apple?

Los datos entrenados de un Modelo Multimodal de Gran Lenguaje (MLLM) le sirven tanto de memoria como de conocimiento para generar resultados. Por tanto, cuanto más diversos y amplios sean los datos entrenados de un MLLM, más concisos serán los resultados que pueda producir.

El laboratorio de investigación de Apple utilizó una cantidad significativa de datos compuestos por texto e imágenes para mejorar el rendimiento de cero disparos y pocos disparos del modelo MM1. Según el artículo de Apple, el modelo MM1 se entrena utilizando una variedad de datos que incluye un 45% de documentos imagen-texto intercalados, un 45% de documentos de pares imagen-texto y un 10% de documentos de sólo texto.

%20(6).png)

%20(15).png)

%20(14).png)