Mientras que todas las grandes empresas como Google, Microsoft y Meta han empezado a trabajar en el campo de la IA y están produciendo modelos avanzados de IA uno tras otro, Apple, que es la empresa que queda, participó en esta carrera de la IA con su modelo multimodal de gran lenguaje llamado MM1. Este modelo se entrenó tanto con datos textuales como con datos visuales. El modelo multimodal de gran lenguaje MM1 se entrenó con una mezcla de imágenes subtituladas (45%), documentos intercalados de imagen-texto (45%) y datos de sólo texto (10%).

En este artículo, descubriremos qué es el modelo de gran lenguaje multimodal MM1 de Apple.

Si estás preparado, ¡empecemos!

TL; DR

- MM1 es una gran familia de modelos de lenguaje multimodal desarrollada y anunciada por Apple.

- El modelo MM1 se desarrolló con un método de entrenamiento y construcción diferente, a diferencia de los MLLM tradicionales.

- Al construir el modelo MM1, se recrearon la arquitectura, los datos entrenados, el codificador de imágenes, los parámetros, los hiperparámetros y el procedimiento de entrenamiento para que fueran eficaces.

- El modelo MM1 tiene un número de parámetros y un tamaño inferiores a los de sus competidores, lo que le permite funcionar sin problemas en dispositivos móviles.

- Si buscas un asistente de IA que esté siempre contigo, como los dispositivos móviles, TextCortex es el camino a seguir, con su integración de más de 30.000 sitios web y aplicaciones.

- TextCortex ofrece una gran variedad de soluciones de IA personalizables e interactivas, desde la escritura hasta tus tareas profesionales.

¿Qué es Apple MM1?

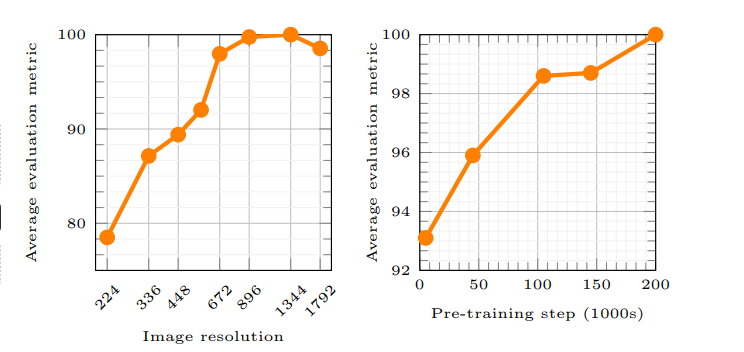

El MM1 de Apple es un Modelo Multimodal de Gran Lenguaje (MLLM) que puede manejar y generar procesos tanto textuales como visuales. Según el artículo de Apple, el principio de funcionamiento del modelo MM1 permite a la IA comprender mejor las indicaciones del usuario y generar el resultado deseado. Se utilizaron nuevos métodos durante el entrenamiento del modelo MM1, y estos métodos afirman que la resolución de la imagen y la capacidad del codificador visual tuvieron el mayor impacto en el rendimiento del modelo.

¿Se está quedando Apple atrás en la carrera de la IA?

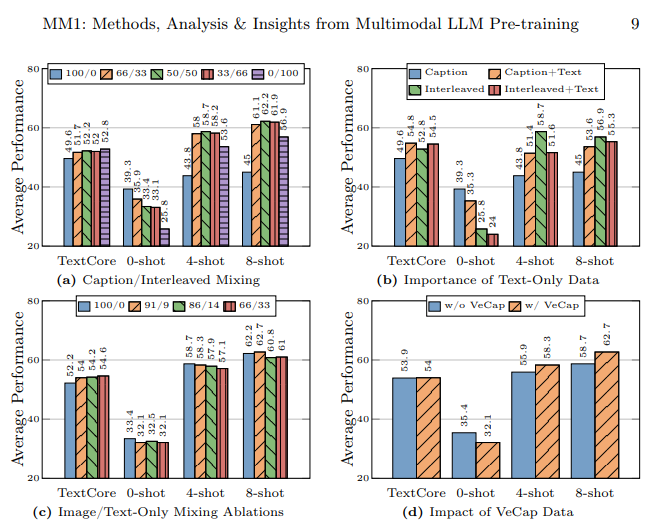

El laboratorio de investigación de Apple se propuso construir un gran modelo lingüístico multimodal (MLLM) de alto rendimiento examinando cuidadosamente montones de métodos de entrenamiento y construcción de IA. Según el artículo de Apple, el uso de distintos tipos de datos al entrenar un modelo de IA, el uso de documentos de imagen-texto en el aprendizaje de pocos disparos, el uso de imágenes con subtítulos para aumentar el rendimiento de cero disparos y los datos de sólo texto ponen de relieve que una sólida comprensión del lenguaje es importante para mejorar el rendimiento.

¿Cómo se construyó el modelo MM1?

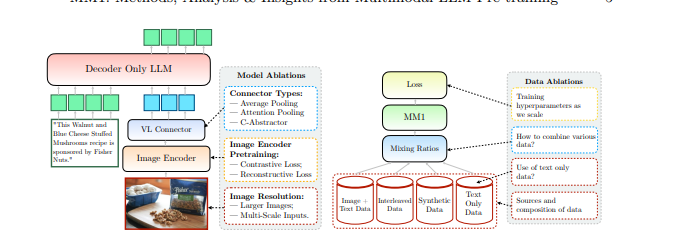

Apple mencionó que fue más allá de los métodos tradicionales para construir el modelo MM1 y que estos métodos eran necesarios para construir un Modelo Multimodal de Gran Lenguaje (MLLM) de alto rendimiento. Apple considera tres pasos básicos a la hora de construir el modelo MM1:

- Arquitectura: El equipo del laboratorio de investigación de Apple examinó métodos para conectar diferentes codificadores de imagen preentrenados y LLM con estos codificadores para construir una arquitectura única.

- Datos entrenados: El modelo MM1 se entrena con conjuntos de datos que contienen distintos tipos de datos, como visuales y de texto, y combinaciones de estos datos.

- Procedimiento de entrenamiento: En lugar de entrenarse con un gran número de parámetros, el modelo MM1 se entrenó centrándose en los hiperparámetros y en qué fase se utilizarán.

Capacidades del MM1 de Apple

El Modelo Multimodal de Lenguaje Grande (MLLM) MM1 de Apple tiene métodos de entrenamiento diferentes, menos parámetros y enfoques distintos del proceso de entrenamiento en comparación con los MLLM tradicionales. Apple afirma que el modelo MM1 se construyó descubriendo los métodos más eficaces y probando innovaciones para entrenar un MLLM. Echemos un vistazo más de cerca a las capacidades y diferencias de entrenamiento del modelo MM1.

Arquitectura

El modelo MM1 tiene una arquitectura diferente a la de otros MLLM (Multimodal Large Language Models). Esta arquitectura incluye codificadores de mayor resolución de imagen, un enfoque diferente del proceso de preentrenamiento y la mezcla de datos etiquetados para aumentar el rendimiento global de una sola indicación. El laboratorio de investigación de Apple se centra en la importancia de las distintas opciones de datos para entrenar el modelo MM1. En otras palabras, el modelo MM1 tiene una arquitectura que pretende ofrecer un mayor rendimiento utilizando menos recursos que los MLLM tradicionales.

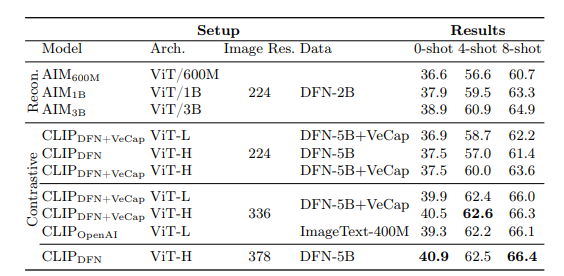

Codificador de imágenes

La mayoría de los Modelos Multimodales de Gran Lenguaje utilizan el codificador de imágenes preentrenado CLIP (Contrastive Language-Image Pretraining) para procesar los datos visuales. Además, estudios recientes demuestran que los modelos autosupervisados sólo de visión funcionan con mayor eficacia. Al analizar estos codificadores, el equipo de investigación de Apple descubrió que el método más eficaz de entrenar un MLLM con datos visuales es a través de las imágenes seleccionadas para los codificadores. Según el laboratorio de investigación de Apple, los datos utilizados en el proceso de procesamiento de un codificador de imágenes afectarán directamente al rendimiento del codificador. El resultado de toda esta investigación es el siguiente: la resolución de la imagen tiene el mayor impacto, seguida del tamaño del modelo y la composición de los datos de entrenamiento.

Parámetros MM1

Según el laboratorio de investigación de Apple, lo que es más importante que el tamaño de los parámetros en un Modelo Multimodal de Gran Lenguaje (MLLM) es el ajuste fino, la escala y los hiperparámetros de esos parámetros.

Los parámetros del modelo MM1 se utilizaron con la máxima eficacia para analizar y procesar diversas entradas de datos. El modelo MM1 es una familia de modelos de IA que consta de tres tamaños de parámetros diferentes: 3B, 7B y 30B. Además, cuanto menor sea el tamaño de los parámetros de un MLLM, más eficazmente funcionará en los dispositivos móviles.

Si buscas un asistente de IA que te apoye siempre tanto en dispositivos móviles como en ordenadores de sobremesa para ayudarte a completar tus tareas diarias o profesionales, deberías tener TextCortex en tu radar.

%20(5).png)

%20(15).png)

%20(14).png)